Documenti di Didattica

Documenti di Professioni

Documenti di Cultura

10 Novembre 2020.en - It

Caricato da

Stefania Memoli0 valutazioniIl 0% ha trovato utile questo documento (0 voti)

3 visualizzazioni7 pagineTitolo originale

10 Novembre 2020.en.it

Copyright

© © All Rights Reserved

Formati disponibili

DOCX, PDF, TXT o leggi online da Scribd

Condividi questo documento

Condividi o incorpora il documento

Hai trovato utile questo documento?

Questo contenuto è inappropriato?

Segnala questo documentoCopyright:

© All Rights Reserved

Formati disponibili

Scarica in formato DOCX, PDF, TXT o leggi online su Scribd

0 valutazioniIl 0% ha trovato utile questo documento (0 voti)

3 visualizzazioni7 pagine10 Novembre 2020.en - It

Caricato da

Stefania MemoliCopyright:

© All Rights Reserved

Formati disponibili

Scarica in formato DOCX, PDF, TXT o leggi online su Scribd

Sei sulla pagina 1di 7

Numero approssimativo re disturbatore. Sì, ok, non l'ho capito. OK.

Quindi siamo rimasti bloccati con queste

macchine super vettoriali che sono le macchine super vettoriali di supporto. Conosci questi algoritmi usati per la

classificazione. OK, quindi qual è l'idea dietro l'ecfmg? Quindi questa è l'idea di base. Quindi come al solito

abbiamo. È che abbiamo queste 2 semplici funzionalità nel nostro spazio dati e poi abbiamo queste due classi di

campioni. Quindi abbiamo campioni positivi e negativi. OK questo più può essere vero meno 10 bifold o più può

essere più uno e meno può essere meno uno. Sai che non abbiamo alcun problema in questo senso perché

possiamo sempre mappare l'etichetta del campione. To Il valore corrispondente nel caso in cui sia necessario,

abbiamo bisogno di un valore specifico. Nel nostro caso. OK, quindi l'idea è che in questo semplice caso abbiamo

solo due classi e il pozzo, quindi abbiamo solo campioni positivi e negativi. OK, quindi l'idea come al solito è quella

di trovare l'equazione dell'iperpiano sostanzialmente in grado di separare anche questo. Um gruppi di punti.

Queste due classi di campioni. OK, ora il punto è. Bene, in linea di principio ci sono molti iperpiani che fanno

questo lavoro, ma quello che vogliamo fare è trovare l'iperpiano ottimale. Quindi prima di tutto dobbiamo capire di

cosa si tratta. Qual è questa nozione di ottimalità per il nostro iperpiano? E poi vedremo come possiamo. Calcola

questo iperpiano usando un po' di matematica e un po' di calcolo. Quindi iniziamo con questo. Con questa

intuizione. OK, quindi l'insegnamento è che questa nozione di ottimalità è qualcosa del genere, il che significa che

abbiamo questo iperpiano supponiamo che questo iperpiano sia proprio nel mezzo di una strada. OK, quindi

vogliamo identificare questo iperpiano in modo che questo. Questa è la strada più ampia possibile. OK, quindi

l'idea. Ehm, sai, è che fondamentalmente stiamo lavorando per strada. Ok, stiamo lavorando sulla larghezza della

strada. OK considerando che questo iperpiano è proprio nel mezzo di questo albero. OK, e ovviamente questo

albero deve essere tale che tu sappia dietro lo sai diciamo in questo modo sul lato sinistro di questa strada. Ho

tutti i miei campioni negativi. Sul lato destro della mia strada ho tutti i miei campioni positivi. OK, anche questo

caso ammetterà che ci sono molti possibili iperpiani e quindi in linea di principio principalmente strade possibili.

OK, qual è l'iperpiano ottimale? Qual è l'ottimale? Il classificatore che vogliamo trovare, beh, il classificatore

ottimale è un classificatore tale che abbiamo la larghezza massima di questo. Conosci quella che chiamiamo la

strada. Lo sai prima. OK, quindi per esempio, in questo caso vediamo che questo iperpiano in linea di principio è

migliore di quest'altro iperpiano, perché in questo caso abbiamo un'altra dimensione della parola. Aggiornamento

della via rispetto alla precedente. Quindi cominciamo con questo. Partendo da questa idea, ci muoviamo verso. Le

specifiche di Forward si trovano nella Decision Room. OK, quindi abbiamo l'equazione dell'iperpiano qui. Qui

l'iperpiano è rappresentato da questa linea tratteggiata blu. E quello che sappiamo è che se l'equazione del mio

iperpiano è maggiore o uguale a 0, allora ho il mio campione positivo. Quindi tutti i campioni positivi sono diciamo

sul lato destro OK di questo. Di questo iperpiano, va bene, sappiamo anche che Impostiamo l'equazione

dell'iperpiano. Se impostiamo questa equazione a 0, otteniamo tutti i punti che giacciono sull'iperpiano OK. Quindi,

quindi in questo caso dato questo. Due, queste due affermazioni in cui sappiamo che se siamo uguali a zero

siamo proprio qui sull'iperpiano, quindi siamo proprio qui sulla linea tratteggiata blu. Se sei maggiore di zero,

siamo su questo lato dell'iperpiano, quindi sul lato destro dell'iperpiano, perché se siamo inferiori a zero siamo su

questo lato sinistro dell'iperpiano. OK, quindi questi sono alcuni vincoli. Puoi iniziare a modellare e utilizzare per

trovare questo iperpiano ottimale. Quindi, quello che abbiamo appena detto è che Supponiamo ora che dato che

questo questo iperpiano che abbiamo che il confine, diciamo, della nostra strada, è tale che l'equazione

dell'iperpiano è uguale a 1. OK, quindi in questo caso quello che stiamo facendo è impostare il. L'etichetta dei miei

valori positivi a più uno nel valore dei miei campioni negativi a meno uno, e in questo caso stiamo dicendo OK.

Quindi se sono in questa parte della mia strada, quindi se scrivo questo bordo su questo bordo sinistro della mia

strada, allora ho che l'equazione è uguale a meno uno. OK, d'altra parte. Se mi trovo dall'altro lato destro della mia

strada, l'equazione è uguale a 1. Cosa succede in questo caso? Bene, quello che succede è che tutti i campioni

positivi sono sul lato destro di questo confine. Il lato destro di questo bordo, mentre tutti i campioni negativi sono

sul lato sinistro di questo bordo. OK, quindi in linea di principio possiamo dire che tutti i campioni positivi sono tali

che l'equazione del mio iperpiano è maggiore o uguale a 1, mentre tutti i miei campioni negativi sono tali che

l'equazione del mio iper. Sono inferiori o uguali a meno uno? OK, quindi dato il valore che abbiamo solo un set per

le nostre etichette, possiamo anche dire che perchè io? Volte che l'equazione del mio iperpiano è maggiore o

uguale di uno o per la parte negativa abbiamo che Yi moltiplica l'equazione del mio. Del mio Hyperplane è inferiore

a uno. OK, quindi se vogliamo scrivere questa equazione in una sola semplice equazione, allora abbiamo che

questa è l'equazione finale che unisce queste due equazioni qui e in qualche modo mette insieme questi due

vincoli. OK. Quindi se vogliamo scrivere con una sola equazione, la situazione che abbiamo per entrambe è

positiva. E campioni negativi, questa è l'equazione completa. OK, dove ricordiamo che in questo caso Y può avere

un valore uguale a più uno o 2 -- 1. Quindi cosa faremo ora per sapere che in uno scenario reale questo iperpiano

ottimale non è noto. OK, quindi quello che vogliamo per quello che vogliamo calcolare ora è. È questo un valore

per Omega e questo valore per B tale che sappiamo che questo iperpiano è il più ampio possibile? Qual è il

significato? Sai? Come possiamo rappresentare matematicamente questo il più ampio possibile? Quindi questa è

l'idea, quindi sappiamo che dato un iperpiano, la distanza di un punto da un iperpiano è uguale al valore assoluto

dell'equazione. OK, calcolato calcolato per quel punto specifico diviso per la norma di Omega. OK, ma in questo

caso lo sappiamo se siamo qui. O qui. Quindi, se siamo sulle linee arancioni, sappiamo che la nostra equazione è

uguale a 1. OK, quindi ti ricordi qui. Quindi in questo caso la mia equazione è uguale a 1 e in questo caso la mia

equazione è uguale a meno uno. Quindi tutto sommato il valore assoluto è uguale a 1. Ma questo significa che la

distanza della linea arancione, quindi di tutti i punti che giacciono su questa linea arancione. La distanza di questi

punti dall'iperpiano è uguale a 1 divisa la norma di Omega e uguale per tutti i punti che giacciono su quest'altra

linea arancione. OK, allora qual è la larghezza della mia strada? Continuiamo a chiamarla Street per capirci

meglio. Allora qual è la larghezza della mia strada? Bene, la larghezza è uguale a 2 diviso per la norma. Dell'artica

è chiaro finora? Sì, va bene, va bene. Allora qual è il? Qual è il problema qui? Il problema è che vogliamo

massimizzare questa quantità, quindi vogliamo massimizzare la larghezza della strada. OK, quindi quello che

vogliamo massimizzare è questo 2 diviso diviso per la norma di Omega. Ma massimizzare questa quantità è

equivalente a massimizzare uno sul. Oltre il né di Omega, ma massimizzare questa quantità equivale a

minimizzare. Il nord di Omega. OK, quindi dal momento che amavamo lavorare con le norme al quadrato della

norma al quadrato o qualcosa del genere, questo equivale a ridurre al minimo 1 / 2 volte la norma al quadrato di

Omega. OK, allora vedremo che è conveniente usare questa formulazione del problema che vogliamo

minimizzare a causa di un certo punto. Immagino che immagini che stiamo per calcolare alcune derivate parziali.

In questo caso, le derivate parziali di questo Omega al quadrato è una derivata di convenienza per i passaggi

matematici che andremo a fare. Quindi ora proviamo a capire come risolvere il problema e come risolvere questo

problema di minimizzazione. Quindi, ehm. Nel, per farlo, dobbiamo ricordare un po' questo. Questo modo di

risolvere un problema di ottimizzazione vincolata. OK, questo è solo per ricordarti qualcosa al riguardo. Questo

problema nel modo in cui possiamo risolvere questi problemi, quindi in questo caso usiamo la cosiddetta dualità di

LaGrange. Userei un ampiamente usato per risolvere questo tipo di problemi, e in questo caso il nostro problema

è definito in questo modo, quindi è definito in modo tale da voler minimizzare la funzione in modo tale da avere un

vincolo uguale a 0 per questo funzione. Penso che inizi a capire qual è il vincolo che vogliamo. OK, nel caso in cui

non aspetti solo qualche minuto, pochi secondi che lo vedremo. Quindi, nel caso avessimo un problema come

questo. Sappiamo dove OK entrambi gli atti e HX sono funzione convessa. Possiamo introdurre la cosiddetta

funzione lagrangiana, che è uguale alla funzione che vogliamo minimizzare. Alfa definire. OK, e in questo caso

abbiamo chiamato questo Alpha. Sappiamo che questi alfa sono chiamati moltiplicatori lagrangiani. Quindi qual è il

nostro FX per il nostro problema e qual è il nostro HX per il nostro problema? Oh no, prima di dirlo, una volta che

abbiamo questa funzione lagrangiana. Quindi quello che abbiamo da dire è che, dato questo problema, è stato

dimostrato che esiste un valore che è un minimo globale per la funzione complessiva. Per la scusa per il. Per la

funzione, vogliamo minimizzare subordinatamente alla seguente condizione, quindi sappiamo che esiste un valore

per Alpha tale che la derivata parziale della funzione lagrangiana rispetto a X sia uguale a 0 e l'ordine delle

derivate parziali della funzione lagrangiana rispetto ai moltiplicatori è uguale a zero. OK, quindi quello che stiamo

dicendo è questo. Se vogliamo trovare un minimo globale per la nostra funzione, soggetto al vincolo, dobbiamo

calcolare queste derivate parziali e impostarle a 0. OK, quindi questo è il risultato matematico matematico che

usiamo per il nostro SBM. Quindi nel nostro caso, cos'è? Qual è la nostra Lagrangiana? Bene, è la funzione che

vogliamo minimizzare OK, ricorda che questa è la nostra funzione F. Se questo è il nostro vincolo, OK, ricorda che

il vincolo nel nostro caso era. Questo. OK, quindi questo è il nostro vincolo. OK, quindi il vincolo è che vogliamo

che i campioni positivi siano sopra questa linea arancione e i campioni negativi siano sotto questa linea arancione.

Quindi questa è la funzione con cui lavoreremo OK e bene. Nel nostro caso abbiamo bisogno che i moltiplicatori

siano maggiori o uguali a 0. Risolviamo quindi il cosiddetto problema primale e ricominciamo a calcolare la

derivata parziale rispetto a rispetto a uno, e vediamo che se calcoliamo la derivata parziale della nostra funzione

lagrangiana di LaGrange rispetto a Omega e la mettiamo a 0. Allora abbiamo questo risultato molto interessante.

Ok, bene, la derivata parziale rispetto a per renderla molto facile da calcolare, perché in questo modo sai di

vedere che è per questo che abbiamo questo quadrato. Adesso ti ricordi. Quindi in questo caso abbiamo Omega

meno questo. Per quanto riguarda Omega di questa parte qui. OK, quindi la derivata rispetto a Omega è Alpha

Omega XI perché se deriviamo rispetto a scusa Omega YISI, perché se deriviamo rispetto a mega allora

rimuoviamo questo proprio qui. Questi altri elementi sono costanti quindi sono uguali a 0. Quindi in questo caso lo

otteniamo per trovare la nostra soluzione Omega. Deve essere uguale a questa quantità qui. OK, quindi questo è.

Questo è un risultato piuttosto interessante perché iniziamo a vedere che Omega può essere calcolato come

lineare. Alcuni dei campioni che abbiamo. OK, questo è interessante anche perché vedremo che prima di

calcolare Omega dobbiamo calcolare tutti gli Alpha I. E di solito abbiamo che molti di questi Alpha I sono uguali a

zero. OK, quindi l'idea vedremo che calcoleremo l'Alpha I in base all'Alpha I. Fatto l'Omega e poi perché vedremo

che in base a questo, Omega finirà e l'Alfa I calcoleremo anche il valore per B OK, ma ancora una volta la buona

notizia è che Omega può essere facilmente calcolato. Sommando linearmente. Campioni, sai, scalati per quantità

e l'altra ottima notizia, è che molto spesso questo questo valore questo valore Alpha qui è uguale a 0. Quindi ora

deriviamo rispetto a rispetto a B e quando deriviamo rispetto a B , quello che succede è che in questo caso

abbiamo che meno la somma di Alpha I * y è uguale a zero? OK, e questo è un altro molto interessante. Un altro

risultato molto interessante. Perchè questo? Inoltre, vediamo questo altro risultato qui affermando che se

deriviamo la nostra funzione lagrangiana rispetto ad Alpha, ciò che otteniamo è ciò che otteniamo è questa

equazione qui. Ma vedi che questa equazione qui rappresenta tutti i punti sul confine delle mie strade. Ok, allora

tieni questo Allora i campioni che contribuiscono alle soluzioni sono solo i campioni che giacciono sui bordi della

mia strada. OK, chiamiamo questi campioni vettori di supporto OK, quindi i vettori di supporto sono tutte le linee di

esempio sul bordo della mia strada. Così sono tutti i campioni. Sdraiato sulle linee arancioni. Quindi ora dalla

versione primaria del problema, passiamo al problema duale. OK, il problema duale dice che invece di

minimizzare su B e Omega soggetti a vincoli. Laddove questo vincolo implica un coinvolgimento a, sappiamo che

esiste a. C'è un teorema qui, l'OK, non ricordo il nome, ma qui c'è un teorema che dice che possiamo

massimizzare su Alpha in base alle relazioni che abbiamo appena calcolato. OK, quindi quello che stiamo dicendo

è che abbiamo appena derivato la nostra funzione lagrangiana rispetto a B e rispetto a Omega. E grazie a questa

operazione abbiamo trovato relazioni molto interessanti. OK, quindi abbiamo scoperto che, ad esempio, Omega è

uguale a questa quantità. E abbiamo anche scoperto che questa quantità è uguale a 0. Allora possiamo sfruttare

queste due relazioni che abbiamo trovato per massimizzare la funzione lagrangiana rispetto ad Alfa. Quindi come

farlo? Beh, è solo un po' di matematica perché sostituiamo Omega con la quantità che abbiamo calcolato prima e

che invece di scrivere Omega qui, scriviamo questa quantità e invece di. Ma io penso. Fermare. Quindi cosa

succede in questo caso, scusa Che abbiamo che in questo caso abbiamo che la funzione lagrangiana è uguale a

1/2 volte Omega. Times Omega di nuovo. Ehm meno? Abbiamo la somma di. AI volte volte perché io volte XI.

Tempi Omega. OK questo è il nostro Omega. OK, e poi finalmente abbiamo questo. Abbiamo il termine che

coinvolge B, quindi abbiamo la somma di AIY I * B e poi abbiamo questo termine finale qui. Quindi abbiamo YR --

-- 1 * I OK È meno, ma poi abbiamo questo più un Alpha I. OK, questo passaggio è chiaro? OK, OK, capisco che

sembra un po' strano, ma sai, alla fine, se guardiamo a questo, sai qualcosa di abbastanza facile da seguire e da

capire. OK, quindi se continuiamo con i nostri passaggi matematici, quindi quello che abbiamo è che ricordiamo

che la somma di Alpha I * y è uguale a 0. Quindi questo termine qui è uguale a 0. Questo è qualcosa che

sappiamo e poi vediamo che Tutto sommato abbiamo che questo primo termine è in questo secondo Quindi

abbiamo 1/2 di questo termine meno lo stesso termine. Quindi questo significa che qui abbiamo meno 1/2 di

questo termine. OK. Um più la somma di tutti gli Only Alpha I Quindi questo è Um the Per trovare il mio Alpha I.

OK, quindi ora quello che devo risolvere è solo al problema di massimizzazione di questa funzione rispetto ad

alphi. OK, questa è una funzione quadratica in Alpha. Come potete vedere. OK, quindi dovrebbe essere

abbastanza facile da risolvere. Possiamo usare per esempio, qualunque cosa. Algoritmo di discesa del gradiente

per trovare i migliori valori per Alpha. Ho dato questa funzione. OK. È chiaro? No, ok, allora torniamo indietro. OK,

torniamo al doppio problema. OK, quindi il problema duale lagrangiano duale lagrangiano? Dillo. Invece di

minimizzare. La mia funzione lagrangiana? Con rispetto. 2B e Omega. OK, soggetto ad alcuni vincoli che

coinvolgono. Massimizziamo continuamente L. Rispetto a rispetto ad Alpha. Dato che sappiamo già qualcosa sulla

relazione di Omega e sulla relazione di Omega e Alpha e qualche altra relazione tra l'Alpha I che abbiamo

calcolato prima. OK, questo è qualcosa che devi dare per scontato, lo sai. C'è molta matematica dietro questo

risultato, e mi dispiace molto, ma non ricordo il nome del teorema, ma. Nel complesso, quello che dobbiamo

capire è che invece di ridurre al minimo l'ape e la funzione di aggressione del maschio alfa, sto massimizzando

l'alfa soggetto a queste relazioni. OK, quindi quello che faccio è sostituire questi elementi qui. All'interno della mia

funzione lagrangiana. OK, e alla fine quello che ho è questa grande funzione qui. Di seguito e se osserviamo la

funzione, vediamo che questo termine mi permette. OK. Questo termine. Ehi questo. Sono esattamente gli stessi.

Questo è Alpha IYI, che è uguale a 0. OK. Così. Cosa rimane alle estremità? O ancora, questo è uguale a 0.

Questi due sono equivalenti, esattamente uguali. Quindi ho meno. Si trova qualcosa. Più 1/2 volte qualcosa. OK,

questo è uguale a meno 1/2 qualcosa. OK, va bene questo. Questa rappresentazione che vedete qui è giusta. Sai,

se guardiamo a questa moltiplicazione, vediamo che questa moltiplicazione si può scrivere analogamente in

questo modo. OK, quindi prima di tutto, è chiaro? Il motivo per cui abbiamo 1 -- 1 / 2 qui. Quindi ok, perfetto. Ora

quello che dobbiamo fare è moltiplicare questo termine per questo termine OK. Nel e poi abbiamo, sai che

dobbiamo sommare tutti questi elementi. OK, quindi sommare tutto questo moltiplicando la somma di tutti questi

elementi per la somma di tutti questi elementi significa che stiamo sommando su I e su J OK perché qui abbiamo

un samurai e qui abbiamo un riassunto di tutti gli Alpha I per Alpha J. Volte perché I volte YG volte XI. Volte XXJ

OK. È chiaro? Controlla sì, ok ora sì. OK OK. Questo è un po' qui. Adesso va bene. Sarà abbastanza strano.

Fammi provare così è qualcosa di simile. Supponiamo che sia il primo. AI. Inoltre essere. I. Tempi. Bambino. J.

Inoltre essere. Jim. OK, quindi questo è uguale. A. Ehi ciao. Multe. AAJ Perdita ehi io. Non sto usando il mio iPad

AI volte. BJ più bla bla bla. OK, quindi questo significa che ho un figlio qui. Questo è un po'. Qui c'è solo qualcosa

più qualcosa più qualcosa più qualcosa bla bla bla. Questo è un po'. Ecco qualcosa più qualcosa bla bla bla. Ma

quello che vediamo è che quando moltiplichiamo questo piè di pagina è uguale alla somma della moltiplicazione di

tutti gli elementi. OK, quindi è la somma della moltiplicazione di tutti gli elementi qui con tutti gli elementi qui. OK.

Spero che ora sia più chiaro. Spiacente. Mangia una G. Capisco solo mianji. chiese E. Angie. eh. Oggi il punto è

che stai solo moltiplicando OK, stai moltiplicando. eh. 2 suona bene. E quando moltiplichi 2 somme, è uguale alla

somma. Della moltiplicazione dei singoli elementi. no no. A Sì. Ciao. ENJEA uh no, perchè devi moltiplicare ogni

singola Della norma con tutti gli altri elementi. Che sono diversi. ok piccola ok. OK. Qualche altra domanda?

Nessuna domanda va bene? Quindi una volta che abbiamo questo. Questo rappresentava questa doppia

rappresentazione della mia funzione lagrangiana. Quello che faccio è massimizzare la mia funzione lagrangiana

rispetto ai miei Alpha I e Alpha J. OK. Così. Una volta che ho Ora sappiamo come calcolare. Almega perché

Omega dipende solo da Alpha e YINXJ. E una volta che abbiamo, una volta che abbiamo calcolato anche Omega,

allora possiamo calcolare B usando questo vincolo. Questa formula qui. OK. Ok, dammi un minuto così posso

prendere il mio iPod e poi torno tra un minuto, ok? Quindi questo mi permetta di cercare di essere più chiaro.

Andreotti, Romanda 2 messaggi alle squadre Super Controller. Serrature in tendo. Ci vediamo quando noi. OK,

allora proviamo a farlo. Per capire meglio questo. Cos'è la lavagna? OK. OK condividi lo schermo. OK, quindi

abbiamo la nostra funzione lagrangiana L. Che è uguale a 1. Meno. io perché? Volte. Inoltre OK. Sappiamo che

dobbiamo minimizzare questa funzione. Dobbiamo trovare il minimo di questa funzione. Quindi calcoliamo la

derivata parziale di questa funzione rispetto a Omega. Riguardo a. Rispetto a BN rispetto ad Alpha. OK. Quindi

dato questo. Mila menzione otteniamo. Che Omega è uguale a. Il figlio di Alpha I. Poiché l'obiettivo finale del

problema è quello dell'informatica. Il. I valori ottimali. Quindi vogliamo calcolare l'ottimale. Omega e l'essere

ottimale. OK. Partendo dal nostro problema lagrangiano, vediamo che se siamo in grado di calcolare. L'Alfa

ottimale. Quindi possiamo calcolare Omega. OK. Da questa condizione qui. Vediamo che una volta che abbiamo

l'ottimale e questa è l'ottimale, ok? Da questa condizione verde lo vediamo. Una volta che abbiamo l'Omega

ottimale. OK, quindi teniamoli OK. Fermare. Una volta che abbiamo questa stella Omega. Allora possiamo

calcolare. La Vista ottimale. OK. È chiaro? Vedi OK. Sei solo o? È chiaro? ok ok bene. OK, quindi il punto è. Lo

sappiamo. Mettiamo tutto questo a zero. Ok, questo 2 zero e questo 2 zero. E impostando queste derivate parziali

a zero otteniamo queste equazioni qui. Guardando queste equazioni, capiamo che se abbiamo guardando la

prima equazione, capiamo che se siamo in grado di calcolare l'Alpha I ottimale, allora per mezzo di questa prima

equazione. OK, possiamo calcolare anche l'Omega ottimo tramite la terza equazione. Vediamo che se possiamo

calcolare l'Omega ottimale, allora possiamo anche calcolare l'offerta ottimale. OK, quindi passiamo al problema

del calcolo dell'Alpha ottimale Nel calcolo dell'Alpha ottimale, Vado attraverso la soluzione del doppio problema.

Allora invece di. Permettetemi di condividere di nuovo le diapositive. OK. Quindi il doppio problema dice che

invece di minimizzare. Minimizzare la mia funzione L. Per quanto riguarda B e Omega, posso massimizzare. La

mia funzione L rispetto ad Alpha. OK. Così. Una volta che lo so, quello che faccio è OK, fammi vedere cosa

succede se sostituisco i risultati che ho ottenuto dalle equazioni precedenti nella mia funzione lagrangiana. E

quello che ho ottenuto è questa versione delle mie funzioni lagrangiane in cui ho solo Alpha. Non ho Omega e non

ce l'ho. Non ho B. Allora quello che faccio è massimizzare questa funzione lagrangiana rispetto ad Alpha. OK,

quindi massimizzando una funzione rispetto ad alcuni parametri. È qualcosa che possiamo già ottenere che

sappiamo già come fare? OK. Quindi sappiamo come minimizzare o massimizzare la funzione rispetto ad alcuni

parametri, giusto? In modo computazionale. Hai un'idea? Si, capisco. OK, solo per essere estremamente chiari.

Ora la funzione, la funzione che vogliamo massimizzare. Quindi vogliamo massimizzare rispetto ad Alpha. La mia

mia funzione che è somma su I di Alpha I -- 1. Va bene, allora Paula G. JYIG è attivo. Grazie. OK, quindi questa è

la funzione che voglio massimizzare. Hai in mente un algoritmo per massimizzare questa funzione per trovare i

valori ottimali? Di Alpha il valore ottimale di Alpha tale che questa funzione sia massimizzata. Qualcuno di voi

conosce un algoritmo per massimizzare una funzione? Per trovare i valori di. Con parametri tali da poter

massimizzare la funzione. E la discesa del gradiente? È fantastico in centro. Buon modo per. Risolvere questo

problema. Mai iniziato niente prima. Ti amo eccellente. Voglio massimizzare questa funzione che potrei

minimizzare. Questa funzione. OK. Ha senso? Sì. OK. Ora è chiaro per tutti voi? Si si. Gran divertimento. OK così

posso risolvere questo problema e posso decidere di minimizzare ad esempio questa funzione. OK, e poi per

esempio uso lo stocastico. Qualunque sia la discesa del gradiente per ridurre al minimo questa funzione, trovo

quindi i valori ottimali per Alpha e quindi blah blah blah blah blah. OK. Ok bene. Buona. OK comunque l'acqua

perché questo succede sempre con questa VM così. Sono abituato a queste situazioni. OK, quindi basta. Solo un

libro interessante, servito qui. Quindi l'osservazione interessante è che il nostro problema di massimizzazione.

Dipende dalle coppie di campioni. Ok, guarda, quindi consideriamo le coppie di campioni. Quando risolviamo il

problema. OK, quindi calcoliamo il prodotto interno tra XI. Conosci il campione I e il campione J. OK, quindi.

Questo è qualcosa che dobbiamo ricordare perché sulla base di questa osservazione possiamo fare qualcosa di

molto più intelligente di questo che può essere utilizzato indipendentemente da SBM. OK. OK, quindi di nuovo

salta questo altrimenti morirai. OK. ehm? Quindi quello che abbiamo fatto finora va bene. Abbiamo trovato un

modo per. Trova l'iperpiano. Per classificare. Per classificare i dati. OK, quindi l'ipotesi alla base di questo. Questo

approccio in questo momento è che i nostri campioni sono separabili linearmente, ma cosa succede? Se non ho.

Nessun dato separabile. OK, quindi cosa succede se ho una situazione come questa? O come quello dove è

abbastanza chiaro che c'è qualche errore di classificazione errata? Quindi l'intuizione è quella. Possiamo in

qualche modo consentire e possiamo accettare che alcuni vincoli vengano violati. OK, nel senso che, per

esempio, possiamo accettare che alcuni punti che dovrebbero essere sul lato sinistro di questo di questo confine

siano effettivamente qui, e analogamente alcuni punti che dovrebbero essere sul lato destro di questo confine. In

realtà sono sul lato sinistro, quindi possiamo permetterlo, quindi diciamo OK, sto bene. Quindi sto bene con

questa possibile possibile violazione del vincolo. Come modellarlo così lo modelliamo aggiungendo ciò che

chiamiamo una variabile slack. Per ogni vincolo, quindi, dovremmo avere una variabile di scarto per ogni elemento

che consideriamo nella nostra equazione. Quindi questo è un parametro GNU quell'insieme di parametri che in

realtà stiamo aggiungendo al problema. Inoltre, stiamo anche aggiungendo. Una sorta di parametro di

regolarizzazione. Quindi il tipo di iperparametro che ce lo dice. OK, permetto gli errori, ma non voglio così tanti

errori. OK, quindi quello che faccio è aggiungere questa classificazione errata. Un termine qui all'interno della mia

funzione per ridurre al minimo. OK. In questo caso proviamo a impostare C in modo che sia il più grande possibile,

perché se vedi è molto grande. Ciò significa che gli errori di classificazione errata devono essere molto bassi. OK.

Quindi di nuovo in questo. In questi due termini qui, se voglio minimizzare questo sole complessivo. Se C è molto

grande, questo significa che per minimizzare tutto, questi errori devono essere molto piccoli in modo che qualcosa

di molto grande, qualcosa di molto grande moltiplicato per qualcosa di molto piccolo sia di nuovo qualcosa di

molto piccolo. OK, va nella direzione nella direzione nella mia direzione di minimizzazione. OK. Allora in questo

caso il mio my. Il mio problema ora è questo. OK, quindi voglio ridurre al minimo questa disfunzione. Dati questi

due vincoli ora. OK. Quindi, come ti ho detto prima, C è un parametro di regolarizzazione e un grande valore per C

dà una penalizzazione più forte. Due errori Quindi in questo caso il mio problema duale diventa qualcosa del

genere, quindi voglio massimizzare di nuovo questo problema in modo tale che Alpha sia tra zero e C e tale che di

nuovo la somma di Alpha I * y sia uguale a zero. OK, quindi quello che abbiamo è che la variabile duale è ora.

vincolato ciao ciao. OK. Va bene? Presidente Putin, meglio contrasto con il prurito e meno come il sì. Vedere. OK,

quindi il punto è che voglio ridurre al minimo la mia, sai di nuovo la larghezza della strada. OK, ma voglio ridurre al

minimo questa funzione perché voglio massimizzare il mi dispiace senza la strada, ma allo stesso punto. Il mio

problema deve ridurre al minimo l'errore di classificazione errata. OK, allora passiamo alla alla lavagna. OK Quindi

la mia funzione è di nuovo una. OK, questa è la funzione che voglio minimizzare. Minimizzatore in ordine. Fresco.

Massimizza. Il. Insieme a. OK. Sai, Immagino che sia chiaro finora. Ora, dal momento che stiamo minimizzando.

Questa funzione. Siamo in due. La mia funzione per minimizzare anche un termine che. Riduce al minimo l'errore

di classificazione errata. OK. Allora perché aggiungendo questo termine con C? Grande valore. Perchè questo? Ci

autorizza. Minimizzare. Questo va bene, quindi. Se voglio minimizzare questa funzione complessiva, supponiamo

che C. È uguale a, diciamo 100. OK, quindi se C è uguale a 100, questo significa che in questo caso. avrò

qualcosa di simile. Qualcosa come OK, la mia funzione più. 100 volte questa somma di valori di somma. OK.

Allora cosa succede in questo caso che se voglio ridurre al minimo la mia funzione complessiva? Beh, devo

lavorare su Omega. Ma allo stesso tempo devo lavorare su questi valori qui. OK. Ora, se voglio minimizzare

questa funzione complessiva, devo lavorare sul contributo di questo termine. Se devo lavorare al contributo di

quest'altro termine. Come rendere questo contributo il più piccolo possibile avendo valori piccoli per queste

variabili di scarto? OK, perché se. Se la somma delle mie variabili di scarto è uguale, se questa somma qui? È

uguale a diciamo 0.00. 12 3 * 100. OK, questo è uguale a 1 due quindi è uguale a 0 * 0. 12 OK, quindi questo è il

contributo alla funzione complessiva. Quindi maggiore è il valore di C, minore deve essere il contributo delle

variabili di scarto. È chiaro adesso? Questa è una domanda OK? alla fine lo calcoliamo sempre. Il tipo di

iperpiano. OK, stiamo anche permettendo al modello di avere alcuni errori di classificazione errata, e stiamo anche

cercando di ridurre questi errori di classificazione errata OK introducendo le variabili slack e il parametro di

regolarizzazione. Ma alla fine. Se i miei dati non sono separabili linearmente, dato anche qualche errore, allora

questo questo approccio non funziona molto bene. Ok, perché sai che possiamo vederlo qui. Un iperpiano può

rappresentare solo al Kotomi nello spazio dei modelli Zen orientali. Quindi, se non abbiamo questo chiaro dickota,

allora un iperpiano non è un buon modello. Quindi, come far fronte a questo? Bene, per far fronte a questo

dobbiamo considerare il teorema di questa copertura. E il teorema delle copertine parla della Super capacità dei

modelli. Quindi questo questo teorema, sai, è qualcosa del genere. Sai che dice che un problema di

classificazione del modello complesso. Problema di classificazione del fondo. Cast in uno spazio ad alta

dimensione non solo non linearmente è più probabile che sia linearmente separabile che in uno spazio a bassa

dimensione. Allora cos'è questo? Cosa dice questo teorema? Quindi questo teorema lo dice. Se considero il mio

spazio di input. mappa NI. Il mio spazio di input in uno spazio dimensionale superiore. Allora è più probabile che

all'interno di questo spazio dimensionale superiore io possa trovare un iperpiano per classificare i miei campioni.

Quindi questo abbastanza dove il teorema e la strana definizione sono, immagino, più chiari se consideriamo

questo esempio. Quindi consideriamo il mio set di dati proprio come questo che ho a sinistra all'interno. Quindi è

chiaro che non riusciremo mai a trovare un iperpiano in grado di classificare punti rossi e croci blu. OK, queste due

classi di punti sono chiaramente non linearmente non linearmente separabili. OK, ma quello che faccio in questo

caso dico OK, sposto i miei punti dati. OK, da questo spazio con 2 dimensioni a un altro spazio con un numero

maggiore di dimensioni, quindi sto proiettando i miei punti dati da uno spazio dati a bassa dimensione a uno

spazio dati a dimensione superiore. OK, e questa proiezione viene effettuata mediante, ad esempio, funzioni non

lineari. OK, quindi quello che considero è che in questo mio nuovo spazio dati tridimensionale, ho che la prima

dimensione è uguale a X1 al quadrato. Questa è uguale a sqrt 2 * X Una volta X2 e la terza dimensione è uguale a

X 2 ^2. OK. Quindi, se proietto il mio spazio dati in questo spazio dati tridimensionale, vedo che posso trovare un

iperpiano in questo spazio dati tridimensionale, in grado di classificare i due diversi insiemi di punti. OK. Quindi, se

torniamo indietro, questo esempio è chiaro? Vedi la prova. OK, ora se torniamo al teorema ora, potremmo capire

meglio cosa sta dicendo la sensazione. OK, quindi lo dice in uno spazio ad alta dimensione. No linearmente.

Quindi, se lancio il mio spazio dati in uno spazio ad alta dimensione in modo non lineare e questo è esattamente

quello che abbiamo fatto qui. Quindi in modo non lineare, questo non è lineare. Questo non è lineare. Questo non

è lineare. Abbiamo costato lo spazio dati originale da uno spazio dati bidimensionale con uno spazio dati

tridimensionale. Quindi, data la situazione, è più probabile che il mio set di dati sia separabile linearmente in

questo nuovo spazio dati. Ok, questa è l'idea. Mostra per esempio. Noi possiamo. Possiamo avere questo chiaro

esempio non linearmente separabile che abbiamo visto. Per le reti neurali, ad esempio le reti neurali. Cosa

possiamo trovare che nessuna trasformazione lineare dei miei campioni di dati in modo tale che diventino

linearmente separabili in modo lineare? Ad esempio, OK. In questo caso, il nuovo spazio dati ha esattamente le

stesse dimensioni, ma questo è solo, sai, solo per mostrarti che ci stiamo spostando in un altro spazio. OK, quindi

ci stiamo spostando dallo spazio di X. Allo spazio di PSI di X. Outlook è questo posto. io non Non ricordo come si

chiama questo. Fireside questo va bene, giusto? Sì, dovrebbe andare bene. Questo è il fuoco X. OK. No. Potresti

ricordare. Quello quando abbiamo venduto il problema del gioiello. Questo OK dove abbiamo venduto il doppio

problema. Quello che abbiamo avuto è stata questa situazione molto interessante. OK. Quindi abbiamo che il

doppio problema. Dipende dalle coppie di campioni. OK, quindi nel caso in cui risolviamo il doppio problema in a in

uno spazio dati diverso, quindi invece di moltiplicare XI per XJ allora devo moltiplicare I file XI per 5X J. OK. OK.

Ma l'intuizione qui è questa. Quindi OK, so già che devo trasformare XYXI. Scusate e poi devo trasformare XJ

tramite la stessa funzione di trasformazione non lineare. E poi devo moltiplicare questi due termini. OK, ma alla

fine questa è una funzione di Zi e di XJ. Quindi l'intuizione, che è anche chiamata il trucco del kernel, è questa. Va

bene invece di. ehm? Calcolando la funzione Phi su XI e su XJ e poi qualunque segno sia OK, quindi posso

essere qualunque funzione K magic. Quindi, invece di identificare questa funzione, calcolare questa funzione su

XY e quindi calcolare la stessa funzione su XJ e quindi moltiplicare il risultato di queste due trasformazioni, e se?

Dico OK, ho una funzione. In questa funzione chiamo questa funzione una funzione del kernel. Tanto che è già il

risultato di questo. Tutta questa elaborazione qui. Quindi questa moltiplicazione qui. OK, quindi l'idea è quella

invece di concentrarsi su qualunque strana funzione. Lavoro solo su una funzione del kernel lavorando

direttamente sulle coppie di XI e XJ. OK, quindi la mia funzione del kernel calcola direttamente il prodotto interno.

Fuori le due proiezioni. OK. Quindi il punto è. Posso lavorare direttamente sulla mia funzione del kernel senza

nemmeno conoscere l'origonale. La funzione 5 originale. Quindi, se torniamo al doppio problema per il nostro

SBM. Quindi, invece di te, potresti ricordare che dovevamo massimizzare OK, torno alla lavagna. OK, quindi

originariamente quello che avevamo era. Massimizza su Alpha. Accidenti. Già, ING. Alpha IJ YIYJ e poi abbiamo

avuto l'XI. 10X J. OK, questo era il problema di massimizzazione originale, ma poi abbiamo appena detto che in

linea di principio potevo farlo. Potrei proiettare il mio XI e XJ in un altro spazio tramite una funzione. Quindi invece

di scrivere questo posso lavorare su questo. Ok, lo sai dopo che mi sono identificato. Dopo aver identificato

questo file funziona bene, ma quello che stiamo dicendo è che invece di scrivere questo, posso scrivere

direttamente qualcosa del genere. OK, quindi posso sostituire direttamente il prodotto di queste due proiezioni.

OK, perché ho questa proiezione qui in questa proiezione qui e poi io' m moltiplicando queste due proiezioni.

Quindi, invece di calcolare la proiezione e quindi moltiplicare la proiezione, considero direttamente una funzione

del kernel che è una rappresentazione implicita della moltiplicazione di. Proiezioni. OK. Allora perché questo è

interessante? Bene, questo è interessante perché invece di. 4. Ciascuno. Per ogni punto dati, invece di calcolare

la proiezione e quindi moltiplicare la proiezione per la proiezione dell'altro punto dati, posso lavorare direttamente

sulle coppie di coppie di punti. Quindi l'idea è che se uso un kernel, un kernel è qualunque funzione che

rappresenti implicitamente la moltiplicazione della proiezione dei due dei due. Punti dati. Quindi giusto per darti

un'idea. Quindi supponiamo che la mia funzione del kernel di. XJ in XI. XI. non lo so. ehm? Il logaritmo. Bene.

Grazie, ho volte XG plus. Il logaritmo di XI. Al quadrato più X al quadrato. OK, quindi supponiamo che la mia

funzione del kernel sia questa. OK. No. Data la mia funzione del kernel. Riesci a vedere la funzione 5

corrispondente? L'intervista è in grado di vedere la funzione 5 corrispondente? OK, questa è sicuramente la prima

volta che mi piace questa funzione senza risposta perché alla fine mi interessa solo la moltiplicazione finale della

proiezione. Non sono interessato alla proiezione in sé. Ecco. Quando sto calcolando la mia funzione per

massimizzare in questo caso, e quando sto proiettando questo punto dati su questo spazio dati in un altro spazio

dati alla fine, sono interessato solo alla moltiplicazione finale della proiezione. Non sono interessato alla proiezione

in sé, quindi posso lavorare su qualsiasi tipo di moltiplicazione delle proiezioni. Invece di concentrarsi sulla

proiezione stessa. Quindi calcolo e applico la mia funzione del kernel senza avere alcuna idea della funzione di

proiezione originale. E questo ha senso. Questo ha molto senso perché alla fine mi interessa solo il prodotto finale

della proiezione. Non sono interessato alla proiezione stessa per il mio SBM, la proiezione è necessaria solo per

passare a un altro spazio dati, ma alla fine quello che mi serve nel mio nel mio nella mia funzione. È questo

questo elemento qui è questo? Questa moltiplicazione è qui? Ecco perché. Un interessato a K, ma non mi

interessa affatto della mia funzione. La mia funzione di ricerca della proiezione. OK. È chiaro? Sì sì serbatoi OK.

Wow, grazie mille. Ok, allora? Anche in questo caso, la proiezione non deve essere calcolata esplicitamente. OK,

beh, forse ci sono casi in cui vogliamo calcolare il file e possono dartene un po'. Anche qualche esempio con

kernel basati su grafici o qualcosa del genere, ma non è sempre così. Mi interessa solo questo K ecco tutto.

Quindi questi sono possibili kernel che puoi usare. Ad esempio, puoi avere un kernel lineare, che è solo il prodotto

interno tra due vettori. Puoi usare un kernel polinomiale o puoi usare un perceptron multistrato perceptron,

tangente iperbolica di età, in questo caso, che è qualcosa del genere in cui hai tutto. Anche questi due parametri

per impostare OK, quindi di nuovo. Se usi questo kernel, o anche se fai uno sconto, non hai idea della funzione di

proiezione. Ma ancora una volta, non ti interessa. Questo c'è anche questo molto interessante nei kernel

inutilizzati che abbiamo. Non riesco a sentire E abbiamo anche questo kernel Goshen gaussiano solo per darti

un'idea, questo è. Questo è il modo in cui possiamo. Possiamo usare SBM e questo è il modo in cui possiamo

classificare diverse classi differenti dati i diversi kernel che abbiamo. Quindi guarda il risultato della classificazione.

Se usiamo un kernel lineare così. Se usiamo solo il, usi i prodotti interni tra i punti dati e guarda cosa succede se

uso il kernel RBF qui. Quindi, se uso il kernel RBF qui, sono in grado di classificare correttamente quasi tutto. OK.

OK, questo è un grado polinomiale qui e vediamo che funziona molto meglio del semplice kernel lineare, ma

vediamo anche che se usiamo un kernel sigmoide qui non classifichiamo nulla. Quindi a seconda del kernel,

quindi a seconda della moltiplicazione di questa proiezione possiamo avere. Un miglioramento nella

classificazione o meno, perché ricorda che il teorema lo dice. È più probabile che vada bene. Questo è ciò che

dice il teorema. È più probabile. Ma in questo caso. Non siamo così fortunati. OK, questo è solo un esempio

dell'applicazione di un kernel Goshen. Giusto per darvi un'idea sul modo in cui può essere applicato al lavoro OK.

Quindi, cercando di riassumere ciò che abbiamo appena detto per SBM. Ogni volta che abbiamo usato un SDM,

dobbiamo definire la funzione del kernel. Perché abbiamo parametri per la funzione del kernel. Quindi per esempio

qui per il per il nucleo polinomiale o per il. L'Air BF Campbell o per la Candela Goshen dobbiamo definire l'insieme

di valori per questa funzione del kernel e inoltre dobbiamo impostare il valore per il parametro di regolarizzazione

C OK. In linea di principio non abbiamo un uso generale per trovare il meglio. Per trovare i valori migliori per

questo per questi iperparametri, quello che di solito facciamo è tentativi ed errori o procedure o usiamo una ricerca

a griglia o qualcosa di ancora più complicato. OK, quindi i vantaggi di SBM sono che non ci sono minimi locali.

Quindi in questo caso abbiamo un problema quadratico. Il che non è il caso del tempo polinomiale neurale.

Abbiamo pochi parametri da impostare e la soluzione è abbastanza stabile, quindi non abbiamo problemi, ad

esempio legati all'inizializzazione dei pesi. Come abbiamo nelle reti neurali che sai come noi come abbiamo detto

possiamo. Può essere all'origine di alcuni problemi. Ok, allora lasciami. OK, abbiamo 5 minuti e questo 5 minuti.

Spero che tu abbia qualche domanda. Ok, sei ancora vivo? Si si. Grazie per aver risposto. OK, quindi chiudiamo

questo. Concludiamo questa lezione dando un'occhiata a questi modelli lineari generalizzati. Quindi quello che

abbiamo quello che abbiamo qui. Ehm così. Quando abbiamo quando abbiamo un modello lineare, possiamo

generalizzare questo modello lineare proiettando. Il anche seguendo il teatro delle copertine proiettando il mio

spazio dati in un diverso non lineare o superiore con una morte alta con una dimensione superiore con un numero

di dimensioni maggiore. Spazio dati OK. E solo per darti un'idea, questi sono, sai, alcuni. Alcune funzioni, alcune

funzioni di proiezione a cui sono abituato in qualche modo. Vai oltre un puro modello lineare. OK. Quindi per oggi

è tutto. Non so se hai qualche domanda. OK, quindi se non hai domande, ci rivedremo giovedì al mattino. OK. OK.

Ciao ciao. Passa un buon pomeriggio. Il anche seguendo il teatro delle copertine proiettando il mio spazio dati in

un diverso non lineare o superiore con una morte alta con una dimensione superiore con un numero di dimensioni

maggiore. Spazio dati OK. E solo per darti un'idea, questi sono, sai, alcuni. Alcune funzioni, alcune funzioni di

proiezione a cui sono abituato in qualche modo. Vai oltre un puro modello lineare. OK. Quindi per oggi è tutto. Non

so se hai qualche domanda. OK, quindi se non hai domande, ci rivedremo giovedì al mattino. OK. OK. Ciao ciao.

Passa un buon pomeriggio. Il anche seguendo il teatro delle copertine proiettando il mio spazio dati in un diverso

non lineare o superiore con una morte alta con una dimensione superiore con un numero di dimensioni maggiore.

Spazio dati OK. E solo per darti un'idea, questi sono, sai, alcuni. Alcune funzioni, alcune funzioni di proiezione a

cui sono abituato in qualche modo. Vai oltre un puro modello lineare. OK. Quindi per oggi è tutto. Non so se hai

qualche domanda. OK, quindi se non hai domande, ci rivedremo giovedì al mattino. OK. OK. Ciao ciao. Passa un

buon pomeriggio. Non so se hai qualche domanda. OK, quindi se non hai domande, ci rivedremo giovedì al

mattino. OK. OK. Ciao ciao. Passa un buon pomeriggio. Non so se hai qualche domanda. OK, quindi se non hai

domande, ci rivedremo giovedì al mattino. OK. OK. Ciao ciao. Passa un buon pomeriggio.

Potrebbero piacerti anche

- 8 Ottobre 2020.en - ItDocumento6 pagine8 Ottobre 2020.en - ItStefania MemoliNessuna valutazione finora

- 8 Ottobre Parte 2Documento5 pagine8 Ottobre Parte 2Stefania MemoliNessuna valutazione finora

- 5 Novembre 2020.en - ItDocumento8 pagine5 Novembre 2020.en - ItStefania MemoliNessuna valutazione finora

- 1 Dicembre 2020.en - ItDocumento8 pagine1 Dicembre 2020.en - ItStefania MemoliNessuna valutazione finora

- Quantum4 mp3Documento10 pagineQuantum4 mp3Emanuele SgarbiNessuna valutazione finora

- Qualsiasi Numero Elevato Alla 0 Dà 1Documento9 pagineQualsiasi Numero Elevato Alla 0 Dà 1Nick BellossiNessuna valutazione finora

- Dominio Di Una Funzione Da R A RDocumento7 pagineDominio Di Una Funzione Da R A RVeronica PlacidoNessuna valutazione finora

- Riassunto Metodi NumericiDocumento31 pagineRiassunto Metodi Numericiilaria venturiniNessuna valutazione finora

- Statistica ChiarimentiDocumento6 pagineStatistica ChiarimentiCaterina LeoNessuna valutazione finora

- Quantum3 mp3Documento9 pagineQuantum3 mp3Emanuele SgarbiNessuna valutazione finora

- Algebra Astratta Strutture Algebriche Proprietà Fondamentali PDFDocumento10 pagineAlgebra Astratta Strutture Algebriche Proprietà Fondamentali PDFmarcoNessuna valutazione finora

- Definizione Di LimiteDocumento35 pagineDefinizione Di LimiteFilippa Luana SquatritoNessuna valutazione finora

- The LifeDocumento13 pagineThe LifeGiorgia ToselloNessuna valutazione finora

- Esercizi Introduttivi Di Algebra AstrattaDocumento10 pagineEsercizi Introduttivi Di Algebra AstrattaRiccardo Vincenzo VincelliNessuna valutazione finora

- Metodo FridrichDocumento14 pagineMetodo FridrichSalvatore Vellecco0% (1)

- Lezione 4Documento3 pagineLezione 4Benedetto GrilloNessuna valutazione finora

- Geometria - 29 Ottobre 2014Documento2 pagineGeometria - 29 Ottobre 2014Federico Teodoro FigheraNessuna valutazione finora

- Come Risolvere Le Espressioni AritmeticheDocumento4 pagineCome Risolvere Le Espressioni AritmeticheManticore1962Nessuna valutazione finora

- Teorema Del Rango o Delle DimensioniDocumento1 paginaTeorema Del Rango o Delle DimensioniMaria Vittoria GiordaniNessuna valutazione finora

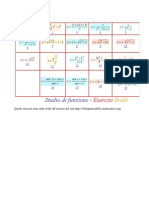

- Studio Del Grafico Di Una FunzioneDocumento8 pagineStudio Del Grafico Di Una Funzioneapi-220203882Nessuna valutazione finora

- Come eseguire il trasporto della melodia o degli accordiDa EverandCome eseguire il trasporto della melodia o degli accordiNessuna valutazione finora

- Studio Di Funzione: Matematica Funzione Grafico Della FunzioneDocumento7 pagineStudio Di Funzione: Matematica Funzione Grafico Della Funzioneapi-251901021Nessuna valutazione finora

- Tarocchi gli abbinamenti degli arcani maggiori - cartomanzia praticaDa EverandTarocchi gli abbinamenti degli arcani maggiori - cartomanzia praticaValutazione: 5 su 5 stelle5/5 (1)

- Formulario Serie NumericheDocumento3 pagineFormulario Serie NumericheVittorio De PaolisNessuna valutazione finora

- Problemi Max MinDocumento3 pagineProblemi Max MinMatteo OrlandoNessuna valutazione finora

- Matematica: funzioni logaritmiche, esponenziali e iperbolicheDa EverandMatematica: funzioni logaritmiche, esponenziali e iperbolicheNessuna valutazione finora

- Abbinamenti dei tarocchi. La guida completa.Cartomanzia praticaDa EverandAbbinamenti dei tarocchi. La guida completa.Cartomanzia praticaNessuna valutazione finora

- Gli abbinamenti dei Tarocchi. La guida completaDa EverandGli abbinamenti dei Tarocchi. La guida completaNessuna valutazione finora

- O-Piccolo e Algebra Degli O-PiccoloDocumento8 pagineO-Piccolo e Algebra Degli O-PiccoloJohnNessuna valutazione finora

- Le DISequazioniDocumento10 pagineLe DISequazionimaurizio_primavera_1Nessuna valutazione finora

- EQUAZIONI DI PRIMO GRADOEquazioni Di Primo GradoDocumento6 pagineEQUAZIONI DI PRIMO GRADOEquazioni Di Primo GradopippoNessuna valutazione finora

- Limiti Di FunzioneDocumento36 pagineLimiti Di FunzioneFilippa Luana SquatritoNessuna valutazione finora

- Esercizi Riguardanti Limiti Di Successioni: Davide BoscainiDocumento8 pagineEsercizi Riguardanti Limiti Di Successioni: Davide Boscainiapi-251901021Nessuna valutazione finora

- Teoremi Analisi 2Documento18 pagineTeoremi Analisi 2Fabio FerroniNessuna valutazione finora

- Scomposizione Di Un TrinomioDocumento13 pagineScomposizione Di Un TrinomioPassa maneriaNessuna valutazione finora

- Gli IntervalliDocumento8 pagineGli IntervallifrankNessuna valutazione finora

- Studio Di FunzioneDocumento77 pagineStudio Di FunzioneRita MazzeiNessuna valutazione finora

- Il Principio Di Induzione e I Numeri Naturali.Documento5 pagineIl Principio Di Induzione e I Numeri Naturali.alfonso.salvatore571Nessuna valutazione finora

- 4 - 07-03 Amp ErrorDocumento9 pagine4 - 07-03 Amp Errorortos11Nessuna valutazione finora

- SuccessioniDocumento4 pagineSuccessioniNaomi BellomoNessuna valutazione finora

- Lezione 37 - ContattoDocumento43 pagineLezione 37 - ContattoAlme d'EcclesiisNessuna valutazione finora

- 02 - Overfitting Underfitting and Model Selection - ItDocumento1 pagina02 - Overfitting Underfitting and Model Selection - Itsankhasubhra mandalNessuna valutazione finora

- Mathglish Vocabolario Matematico Italiano-IngleseDocumento1 paginaMathglish Vocabolario Matematico Italiano-IngleseMaria Rita SistoNessuna valutazione finora

- Il Metodo Per Impostare e Risolvere I Problemi Di FisicaDocumento8 pagineIl Metodo Per Impostare e Risolvere I Problemi Di FisicaOscar FilippeschiNessuna valutazione finora

- MATEMATICADocumento5 pagineMATEMATICALudovico IraNessuna valutazione finora

- AnalisiDocumento178 pagineAnalisiAlexNessuna valutazione finora

- Euclide CompletamentoDocumento24 pagineEuclide CompletamentoMichele NardelliNessuna valutazione finora

- Acerbi Buttazzo - Matematica Preuniversitaria Di Base PDFDocumento118 pagineAcerbi Buttazzo - Matematica Preuniversitaria Di Base PDFPaolo Bertolli100% (5)

- Corso Di Armonia Jazz Ottimo PDFDocumento55 pagineCorso Di Armonia Jazz Ottimo PDFmaritozzi80Nessuna valutazione finora

- La Retta Reale Capitulo 1Documento55 pagineLa Retta Reale Capitulo 1Bogdan CozmaNessuna valutazione finora

- Ottica Visuale Parte VLL (Modalità Compatibilità) PDFDocumento60 pagineOttica Visuale Parte VLL (Modalità Compatibilità) PDFIago DifNessuna valutazione finora

- Controlli AutomaticiDocumento65 pagineControlli AutomaticisamueleNessuna valutazione finora

- 6 Ottobre 2020.en - ItDocumento18 pagine6 Ottobre 2020.en - ItStefania MemoliNessuna valutazione finora

- Cartomanzia pratica per tutti. Terza edizione riveduta e ampliataDa EverandCartomanzia pratica per tutti. Terza edizione riveduta e ampliataValutazione: 1 su 5 stelle1/5 (1)

- Studio FunzioneDocumento7 pagineStudio FunzionePierpaolo BerettaNessuna valutazione finora

- Igor Sibaldi Istruzioni Per Gli AngeliDocumento107 pagineIgor Sibaldi Istruzioni Per Gli Angeliponteras89% (9)

- Gli - TC - H 20111 Reader (Ror)Documento161 pagineGli - TC - H 20111 Reader (Ror)Djuli OnaNessuna valutazione finora

- Il Pentateuco Sapienziale. Proverbi, Giobbe, Qohelet, Siracide, Sapienza. Caratteristiche Letterarie e Temi Teologici by Luca MazzinghiDocumento268 pagineIl Pentateuco Sapienziale. Proverbi, Giobbe, Qohelet, Siracide, Sapienza. Caratteristiche Letterarie e Temi Teologici by Luca MazzinghiJustin Monton100% (1)

- Noches Lúgrubes PDFDocumento16 pagineNoches Lúgrubes PDFvicenteNessuna valutazione finora

- Scheda Libro - OLIVA DENARODocumento4 pagineScheda Libro - OLIVA DENAROchanty.petrini06Nessuna valutazione finora

- IndiaDocumento106 pagineIndiaManuela BagalàNessuna valutazione finora