Documenti di Didattica

Documenti di Professioni

Documenti di Cultura

4.5 Extracción de Reglas Comprensibles

Caricato da

Denis Vqz0 valutazioniIl 0% ha trovato utile questo documento (0 voti)

60 visualizzazioni11 pagineTema 4.5 de Minería de datos

Copyright

© © All Rights Reserved

Formati disponibili

PPTX, PDF, TXT o leggi online da Scribd

Condividi questo documento

Condividi o incorpora il documento

Hai trovato utile questo documento?

Questo contenuto è inappropriato?

Segnala questo documentoTema 4.5 de Minería de datos

Copyright:

© All Rights Reserved

Formati disponibili

Scarica in formato PPTX, PDF, TXT o leggi online su Scribd

0 valutazioniIl 0% ha trovato utile questo documento (0 voti)

60 visualizzazioni11 pagine4.5 Extracción de Reglas Comprensibles

Caricato da

Denis VqzTema 4.5 de Minería de datos

Copyright:

© All Rights Reserved

Formati disponibili

Scarica in formato PPTX, PDF, TXT o leggi online su Scribd

Sei sulla pagina 1di 11

Minería de datos

4.5 Extracción de reglas

comprensibles

Profa.: Dra. Carolina Astudillo Hernández

Integrantes de equipo:

Organista Vázquez Verónica Dennise 14321047

Rojas Almontes Oscar Ivan 14321072

Introducción

El desarrollo de la tecnología de minería de datos avanzada continuará siendo

una importante área de estudio, y en consecuencia se espera gastar muchos

recursos en esta área de desarrollo en los próximos años. En éste tema de

extracción de reglas comprensibles podemos entender el concepto de regla, con

lo cual se centralizará ya que la minería de datos extraen los datos más

importante y que tienen un propósito.

Reglas

Una regla es una proposición condicional. Su forma es “SI (condición A)

ENTONCES (resultado B)”siendo, por lo general, tanto A como B, conjunciones de

expresiones de la forma (nom_atributo = valori) en caso de que el atributo sea

cualitativo mientras que si es cuantitativo debe indicar el rango a utilizar ya sea a través

de un intervalo o a través una cota superior o inferior.Las técnicas de extracción de

reglas permiten obtener a partir de la información disponible un conjunto de este tipo

de proposiciones dando así lugar a un modelo que puede tener uno de dos objetivos:

establecer relaciones que describan los ejemplos existentes o clasificar los ejemplos a

través del conjunto de reglas.

Comprensibilidad

Debe proporcionar información que sea entendible por los usuarios. En otras palabras,

la comprensibilidad hace referencia a que la información que se vaya a leer permita a

los usuarios captar adecuadamente lo que se está comunicando. Entonces para

expresarlo de otra manera, el requerimiento del Marco Conceptual es que la

información contenida cumpla con los siguientes objetivos:

• Sea entendible por un usuario quien tiene un conocimiento suficiente de las

actividades y los requerimientos de trabajo.

• Sea preparada para ser estudiada por alguien que realiza un adecuado y firme

esfuerzo en entenderla.

Extracción

Las técnicas de extracción de conocimiento y minería de datos se centran en la

extracción asistida por ordenador de conocimientos útiles desde datos e

informaciones. Ayudan a descubrir y a identificar patrones ocultos (no

evidentes y, en ocasiones, inesperados) en los datos, que sean comprensibles

para las personas y que ofrezcan puntos de vista útiles (lo que resulta

especialmente importante en el caso de los grandes fondos de información,

donde los recursos humanos disponibles pueden ser limitados). El uso de estas

técnicas en las aplicaciones multimedia constituye un mecanismo poderoso para

mejorar la comprensión y para añadir valor a los grandes repositorios de

información multimedia.

Extracción de conocimiento a un problema de

marketing

En este trabajo se aplican herramientas evolutivas de extracción de conocimiento a un

problema de marketing estudiado en el Departamento de Organización y Marketing de

la Universidad de Mondragón: La extracción de información útil sobre certámenes

feriales. Las empresas consideran los certámenes feriales un instrumento que facilita la

consecución de objetivos comerciales tales como el contacto con los clientes actuales,

la captación de nuevos clientes potenciales, la realización de pedidos o la mejora de la

imagen corporativa entre otros. Uno de los principales inconvenientes de este tipo de

certámenes es la elevada inversión que suponen en términos tanto económicos como

de tiempo.

A esta inversión a veces se une una falta de planificación que enfatiza la

sensación de que las ferias no son más que un “gasto” que las compañías han

de afrontar por motivos varios (tradición, exigencia clientes, no dar la sensación

de que las cosas van mal, etc.)

Es conveniente, por tanto, la extracción automática de información sobre las

variables implicadas que permita obtener datos desconocidos determinantes en

parte de la eficacia de los stands de un certamen.

Algoritmos genéticos para la extracción de

reglas

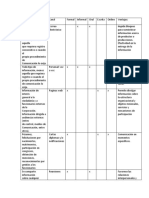

Se han desarrollado múltiples propuestas evolutivas para la extracción de reglas

de distintos tipos, de clasificación, asociación o dependencias funcionales. Para

el problema al que nos enfrentamos, el objetivo es generar reglas en las que en

el consecuente aparezca un único atributo (y establecido a priori), porque en

esta sección haremos referencia a las propuestas evolutivas para la extracción de

reglas de clasificación y asociación.

Cualquier propuesta de AG de extracción de reglas debe determinar el esquema

de representación utilizado para codificar cada una de las soluciones, los

operadores genéticos y la función de adaptación.

El algoritmo permite generar reglas difusas y/o nítidas, para problemas con

variables continuas y/o nominales. Las reglas DNF, difusas o nítidas, son un

tipo de regla que permite representar el conocimiento de forma sencilla y

comprensible. La disyunción de valores para una variable facilita la extracción

de reglas genéricas en problemas con variables nominales, y permite flexibilizar

la discretización en variables en las que se haya realizado este tipo de pre-

procesamiento o cambiar en el caso de variables que se hayan tratado como

variables lingüísticas

El objetivo de este proceso evolutivo es extraer para cada valor de la variable

objetivo un número variable de reglas diferentes que expresen información

sobre la mayoría de los ejemplos del conjunto de partida. Para ello el AG se

incluye en un proceso iterativo que permite la obtención de varias reglas

mientras las reglas generadas alcancen un nivel mínimo de confianza y

describan información sobre zonas del espacio de búsqueda en las que aún

quedan ejemplos no descritos por las reglas generadas en las iteraciones

anteriores.

Conclusión

Como resumen podríamos señalar que el rápido crecimiento del interés en la minería de datos es debido :

1. Al avance de la tecnología de Internet y a la gran participación en aplicaciones multimedia en este dominio.

2. A compartir y distribuir los datos en la red, junto con el aumento de nuevas bases de datos en los

repositorios.

3. Al desarrollo de algoritmos de aprendizaje automático robustos y eficientes para procesar estos datos.

4. Al avance de las arquitecturas de las computadoras y la caída del coste del poder computacional, permitiendo

utilizar métodos computacionalmente intensivos para el análisis de datos.

5. La potencia que este tipo de análisis vienen mostrando como herramientas de soporte a la toma de

decisiones frente a realidades complejas.

Potrebbero piacerti anche

- Fases de Un Proyecto de Mineria de DatosDocumento10 pagineFases de Un Proyecto de Mineria de DatosrickidarkNessuna valutazione finora

- Act Apren2 JMHA - MDDocumento9 pagineAct Apren2 JMHA - MDmayra osorioNessuna valutazione finora

- Clase 5 FCD 24052023Documento36 pagineClase 5 FCD 24052023Jonathan Avila BerriosNessuna valutazione finora

- PC 2Documento7 paginePC 2Gianluca Di MarioNessuna valutazione finora

- Tratamiento de Datos KDDDocumento5 pagineTratamiento de Datos KDDYIVERNessuna valutazione finora

- Articulo de InvestigacionDocumento15 pagineArticulo de InvestigacionMAURICIO LAGUNA MARTINEZ0% (1)

- Minería de DatosDocumento19 pagineMinería de DatosRolando_alone666Nessuna valutazione finora

- Tarea 2.3 y 2.4Documento8 pagineTarea 2.3 y 2.4Moises MartinezNessuna valutazione finora

- KKDDocumento8 pagineKKDAdrian SantanaNessuna valutazione finora

- CDMRBD: Ciencia de Datos, Minería de Datos, Machine Learning y Big DataDocumento9 pagineCDMRBD: Ciencia de Datos, Minería de Datos, Machine Learning y Big DataKevin Joel Zambrano LucasNessuna valutazione finora

- Introducción A La Minería de Datos y Un Ejemplo Ficticio Aplicado Al Sector BancarioDocumento8 pagineIntroducción A La Minería de Datos y Un Ejemplo Ficticio Aplicado Al Sector BancarioLiyune Carolina Cedeño PeñaNessuna valutazione finora

- Análisis de datos y toma de decisionesDocumento57 pagineAnálisis de datos y toma de decisionesGustavoNessuna valutazione finora

- Mineria de DatosDocumento11 pagineMineria de DatosNando PinargoNessuna valutazione finora

- Modelo de Bases de Datos AvanzadosDocumento15 pagineModelo de Bases de Datos AvanzadosRomelia Garcia RiosNessuna valutazione finora

- I7725 - 2022B UN 1 AC 1 Ejemplos de Analisis de InformacionDocumento7 pagineI7725 - 2022B UN 1 AC 1 Ejemplos de Analisis de InformacionJaasiel Alejandro Castellanos GomezNessuna valutazione finora

- Análisis de métodos de minería de datosDocumento11 pagineAnálisis de métodos de minería de datosTellez ArielNessuna valutazione finora

- Tecnologías DatamartDocumento12 pagineTecnologías DatamartRaquel ZabalaNessuna valutazione finora

- Modulo: Big Data Marketing y Aplicación de Minería de DatosDocumento4 pagineModulo: Big Data Marketing y Aplicación de Minería de DatosLisbeth Vargas PNessuna valutazione finora

- Minería de datos y opinionesDocumento8 pagineMinería de datos y opinionesIrene ValenciaNessuna valutazione finora

- Tema I-Introducción A La Minería de DatosDocumento5 pagineTema I-Introducción A La Minería de DatosCristhopher JimenezNessuna valutazione finora

- Proyecto Sistemas Mineria de DatosDocumento16 pagineProyecto Sistemas Mineria de DatosCarlos AvilesNessuna valutazione finora

- Herramientas OLAP para análisis de datosDocumento19 pagineHerramientas OLAP para análisis de datosWenn Cortés0% (1)

- Sistemas de Información en La Empresa 4P PDocumento9 pagineSistemas de Información en La Empresa 4P PFelipe Moreno NfsNessuna valutazione finora

- Minería de DatosDocumento9 pagineMinería de Datoscybor2000Nessuna valutazione finora

- Minería de datos: análisis automático de grandes cantidades de datosDocumento30 pagineMinería de datos: análisis automático de grandes cantidades de datosMontero Montero AriasNessuna valutazione finora

- Cid 2019B Inni T2 2a Lvis.Documento5 pagineCid 2019B Inni T2 2a Lvis.pepenarNessuna valutazione finora

- Entregable 1 - Dseño EstructuradoDocumento7 pagineEntregable 1 - Dseño EstructuradoestefannyNessuna valutazione finora

- KDD Vs Minería de Datos - Pasos KDDDocumento5 pagineKDD Vs Minería de Datos - Pasos KDDjuan quijadaNessuna valutazione finora

- Guía de ActividadesDocumento8 pagineGuía de ActividadesOscar David Duque DiazNessuna valutazione finora

- Separacion de ResponsabilidadesDocumento5 pagineSeparacion de ResponsabilidadesDaniela CeronNessuna valutazione finora

- Big Data Resumen M2Documento3 pagineBig Data Resumen M2CristianNocelliNessuna valutazione finora

- Unitec Sistemas de InformacionDocumento12 pagineUnitec Sistemas de InformacionCesar KaepernickNessuna valutazione finora

- Minería de DatosDocumento5 pagineMinería de DatosCarlos Alberto Yarlequé YarlequéNessuna valutazione finora

- Presentacion Mineria DatosDocumento20 paginePresentacion Mineria Datoskarenleon25Nessuna valutazione finora

- Tema 2Documento14 pagineTema 2Edgar Guerrero0% (2)

- Balotario ResueltoDocumento6 pagineBalotario ResueltoJhonatan Rojas MoreanoNessuna valutazione finora

- Mineria de DatosDocumento7 pagineMineria de DatosJONATHAN MIGUEL AISALLA GUANOLUISANessuna valutazione finora

- I7725 - 2022B UN 1 AC 2 EL Proceso de DescubrimientoDocumento11 pagineI7725 - 2022B UN 1 AC 2 EL Proceso de DescubrimientoJaasiel Alejandro Castellanos GomezNessuna valutazione finora

- CONCEPTOS 2.4. DataMining o Mineria de DatosDocumento6 pagineCONCEPTOS 2.4. DataMining o Mineria de DatosFedrftg PedrftgyNessuna valutazione finora

- Arquitectura de Datos Empresariales - Actividad 2Documento4 pagineArquitectura de Datos Empresariales - Actividad 2Carlos TenelemaNessuna valutazione finora

- Knowledge Discovery y Data MiningDocumento8 pagineKnowledge Discovery y Data MiningNestor FerreiraNessuna valutazione finora

- Qué Es Una BDMDocumento12 pagineQué Es Una BDMJovany ChavezNessuna valutazione finora

- Proyecto Metodologia CrispDocumento30 pagineProyecto Metodologia CrispAlexitoPakMasAlvaradoCastilloNessuna valutazione finora

- Metodología HefestosDocumento7 pagineMetodología HefestosHz MiguelNessuna valutazione finora

- Qué es un Datawarehouse y sus característicasDocumento15 pagineQué es un Datawarehouse y sus característicasMaynor Ottoniel Gutierrez OrozcoNessuna valutazione finora

- Minería de Datos (Data Mining) Resumen Veronica AlejandraDocumento5 pagineMinería de Datos (Data Mining) Resumen Veronica AlejandraVerónica Alejandra Esquivel CarmonaNessuna valutazione finora

- DataSciencie EncuentroconlosSaberesSemana2Documento12 pagineDataSciencie EncuentroconlosSaberesSemana2Jorge Humberto Zamorano PlazaNessuna valutazione finora

- 5 Construccion de Base de Datos en La IsDocumento21 pagine5 Construccion de Base de Datos en La IsAlejandro Guerra0% (1)

- Lectura 1Documento17 pagineLectura 1htodnlNessuna valutazione finora

- 1er Cuestionario PreguntasDocumento7 pagine1er Cuestionario PreguntasRenzo Andres Carrascal FierroNessuna valutazione finora

- Ensayo AdministracionDocumento9 pagineEnsayo AdministracionMPCC 2505Nessuna valutazione finora

- Inteligencia de NegociosDocumento3 pagineInteligencia de Negociosjean carlos dos100% (1)

- Data MiningDocumento7 pagineData MiningEdwin Felipe Chau TorresNessuna valutazione finora

- Mineria de Datos FinalDocumento75 pagineMineria de Datos FinalMax FuentesNessuna valutazione finora

- Pneuma N 6 5cDocumento11 paginePneuma N 6 5cErnesto Ivanovi Arreaga CarvajalNessuna valutazione finora

- CONCEPTOS MINERÍA DE DATOSDocumento22 pagineCONCEPTOS MINERÍA DE DATOSJose Manuel Araujo OrregoNessuna valutazione finora

- Análisis Big Data MLDocumento10 pagineAnálisis Big Data MLEduardo HenryNessuna valutazione finora

- Mineria de DatosDocumento32 pagineMineria de DatospicenloNessuna valutazione finora

- Tratamiento y análisis de la información de mercados. COMM0110Da EverandTratamiento y análisis de la información de mercados. COMM0110Nessuna valutazione finora

- Lenguajes de definición y modificación de datos sql. IFCT0310Da EverandLenguajes de definición y modificación de datos sql. IFCT0310Nessuna valutazione finora

- Procesos IndustrialesDocumento3 pagineProcesos IndustrialesDenis VqzNessuna valutazione finora

- Inferencia ProbabilísticaDocumento3 pagineInferencia ProbabilísticaDenis VqzNessuna valutazione finora

- Teorema de Bayes EjerciciosDocumento3 pagineTeorema de Bayes EjerciciosAlvida DavialNessuna valutazione finora

- 7 Areas y VolumenesDocumento15 pagine7 Areas y VolumenesGerrard HernandezNessuna valutazione finora

- P 2 PDocumento1 paginaP 2 PDenis VqzNessuna valutazione finora

- Resume Procesos de NegocioDocumento3 pagineResume Procesos de NegocioDenis VqzNessuna valutazione finora

- Ejercicios ResueltosDocumento16 pagineEjercicios ResueltosDavid Salinas QuirozNessuna valutazione finora

- Tabla PDFDocumento19 pagineTabla PDFSaul ZeballosNessuna valutazione finora

- Plan Till A Descrip C I On Proceso SDocumento6 paginePlan Till A Descrip C I On Proceso SDenis VqzNessuna valutazione finora

- Defini ConesDocumento3 pagineDefini ConesDenis VqzNessuna valutazione finora

- Instalación Vagrant en Windows + RailsDocumento8 pagineInstalación Vagrant en Windows + RailsDenis VqzNessuna valutazione finora

- Plan de NegociosDocumento5 paginePlan de NegociosROBERTNessuna valutazione finora

- Aplicaciones Int. Art.Documento2 pagineAplicaciones Int. Art.Denis VqzNessuna valutazione finora

- Aplicaciones Int. Art.Documento2 pagineAplicaciones Int. Art.Denis VqzNessuna valutazione finora

- Fundamentos de TelecomunicacionesDocumento24 pagineFundamentos de TelecomunicacionesDenis VqzNessuna valutazione finora

- 100 Usos de Codigos QR PDFDocumento8 pagine100 Usos de Codigos QR PDFUmbertoNessuna valutazione finora

- ArchivonomiaDocumento8 pagineArchivonomiaMartin Tribilin0% (2)

- Las Malas AccionesDocumento8 pagineLas Malas Accionespaula floresNessuna valutazione finora

- Actividad-1 - Evidencia 2 - Uso-Del-Excel-Y-AccesDocumento3 pagineActividad-1 - Evidencia 2 - Uso-Del-Excel-Y-Accesjhon menaNessuna valutazione finora

- Epistolas Selectas de San GeronimoDocumento619 pagineEpistolas Selectas de San GeronimoemiliojanzNessuna valutazione finora

- "Definiendo y Desarrollando Habilidades para Una Comunicación Asertiva y Eficaz".Documento9 pagine"Definiendo y Desarrollando Habilidades para Una Comunicación Asertiva y Eficaz".Diana RuizNessuna valutazione finora

- Qué Es AutorreferenciaDocumento3 pagineQué Es AutorreferenciaMaydelli Echeverria100% (1)

- El Procedimiento de La Comunicación 1Documento2 pagineEl Procedimiento de La Comunicación 1elisa maria ortega guerraNessuna valutazione finora

- ¿Por Qué Chomsky Desconfía de Internet - BBC Mundo - NoticiasDocumento6 pagine¿Por Qué Chomsky Desconfía de Internet - BBC Mundo - NoticiasPedro Flores LNessuna valutazione finora

- Ambrosii Calepini Dictionarium Octo LingDocumento1.477 pagineAmbrosii Calepini Dictionarium Octo LingMarlen ZuritaNessuna valutazione finora

- Los Instrumentos de EvaluaciónDocumento6 pagineLos Instrumentos de EvaluaciónJosmark Alexander Tito CanazaNessuna valutazione finora

- Funciones cognitivas y EAMDocumento7 pagineFunciones cognitivas y EAMAlexglis Garcia100% (1)

- Métodos de Investigación Cuantitativa-Dialectico Ing. CivilDocumento33 pagineMétodos de Investigación Cuantitativa-Dialectico Ing. CivilKathe RpzNessuna valutazione finora

- Percepción, Atención y MemoriaDocumento100 paginePercepción, Atención y MemoriaMaria del Carmen Peinado LópezNessuna valutazione finora

- Informacion de BMWDocumento88 pagineInformacion de BMWLuis Cari100% (3)

- 3 Formulario de La Oferta de Cotizacion Bienes y ServiciosDocumento27 pagine3 Formulario de La Oferta de Cotizacion Bienes y ServiciosMonik PaulisNessuna valutazione finora

- 3 El Tema, La Idea Principal Explícita e Ideas SecundariasDocumento9 pagine3 El Tema, La Idea Principal Explícita e Ideas SecundariasEngel Marcel100% (2)

- Autorización Tratamiento de Datos Personales (3856)Documento2 pagineAutorización Tratamiento de Datos Personales (3856)Ana Gabriela GomezNessuna valutazione finora

- 3 Tercero LecturaDocumento44 pagine3 Tercero LecturafefeyatiNessuna valutazione finora

- Taller 2 Cad-CamDocumento11 pagineTaller 2 Cad-CamFredy Orlando Hernández100% (1)

- COSO - TripticoDocumento2 pagineCOSO - TripticosaoryNessuna valutazione finora

- Planificacion Diaria Lenguaje 4° Basico MayoDocumento16 paginePlanificacion Diaria Lenguaje 4° Basico MayoTatiana Vidal GallardoNessuna valutazione finora

- Definición, Accidentes, ACRDocumento70 pagineDefinición, Accidentes, ACRCesar Ochoa0% (1)

- EstructuralismoDocumento142 pagineEstructuralismodannyseybian86% (21)

- E 15 - 8622 GC - N01I - TA2Consigna - 22C1MDocumento11 pagineE 15 - 8622 GC - N01I - TA2Consigna - 22C1MCarmen MartinezNessuna valutazione finora

- CAPITULO II - PPTX David y Breni - PPTX Todos Co El Mismo ColorDocumento13 pagineCAPITULO II - PPTX David y Breni - PPTX Todos Co El Mismo ColorBrenny Luz Rodriguez LauraNessuna valutazione finora

- Indicadores Siagie 4 AñosDocumento7 pagineIndicadores Siagie 4 AñosElsaMarivelCernaMercado80% (5)

- Participación ciudadana escuela comunidadDocumento6 pagineParticipación ciudadana escuela comunidadGary Sierra HuaracaNessuna valutazione finora

- Reporte Estadistico - Lima Vive RockDocumento10 pagineReporte Estadistico - Lima Vive RockGalilei A. Bautista GuillenNessuna valutazione finora

- Unidad 3 Desc GuianzaDocumento25 pagineUnidad 3 Desc GuianzaKrmen RosaNessuna valutazione finora