Documenti di Didattica

Documenti di Professioni

Documenti di Cultura

PCA

Caricato da

escaparx2Copyright

Formati disponibili

Condividi questo documento

Condividi o incorpora il documento

Hai trovato utile questo documento?

Questo contenuto è inappropriato?

Segnala questo documentoCopyright:

Formati disponibili

PCA

Caricato da

escaparx2Copyright:

Formati disponibili

Matemticas de fondo En esta seccin se intentar dar algunas habilidades de formacin matemtica elemental que seran requeridas para

entender el proceso de Anlisis de Componentes Principales. Los temas se tratan de forma independiente el uno del otro, y dando ejemplos. Es po co importante recordar la mecnica exacta de una tcnica matemtica de lo que es de entender la razn por la cual una tcnica puede se utilizada, y lo que el resultado de la operacin nos dice acerca de nuestros datos. No todas estas tcnicas son utilizadas en PCA, pero las que no se requieren explicitamente para proporcionar los fundamentos en que las tcnicas ms importante s se basan. He incluido una seccin sobre estadsticas que mira las medidas de distribucin, o, cmo los datos se extiende. La otra seccin es el lgebra matricial y se ven valor es y vectores propios, propiedades importantes de las matrices que son fundamental es para PCA 2.1 Estadsticas Todo el tema de estadsticas se basa en la idea de que usted tiene este gran conj unto de datos, y que quiere analizar ese conjunto en trminos de las relaciones entre los puntos individuales en ese conjunto de datos. Voy a mirar a algunas de las medidas que usted puede hacer en un conjunto de los datos, y lo que te dicen de los datos en s. 2.1.1 Desviacin Estndar Para entender la desviacin estndar, es necesario un conjunto de datos. Estadigraf os normalmente estan preocupados con la toma de una muestra de una poblacin. Para utilizar las encues tas electorales a modo de ejemplo, la la poblacin es toda la gente en el pas, mientras que una muestra es un subconjunt o de la poblacin que la medida de los estadsticos. La gran cosa acerca de las estadsticas es que sl o de medicin (en este caso haciendo una encuesta telefnica o similar) de una muestr a de la poblacin, se puede calcular lo que es ms probable que sea la medida si se ha utilizado tod a la poblacin. En este apartado de estadsticas, que voy a asumir que nuestros conjuntos de dato s son ejemplos de algunos de poblacin ms grande. Hay una referencia ms adelante en esta seccin que apunta a ms informacin sobre las muestras y las poblaciones. He aqu un ejemplo establecido: X = [1 2 4 6 12 15 25 45 68 67 65 98] Yo podra simplemente utilizar el smbolo X para referirse a este conjunto de nmeros . Si yo quiero se refieren a un nmero individual en este conjunto de datos, voy a usar subndices en el smbolo X para indicar un nmero especfico. Por ejemplo X3 se refiere al nmero 3 en X, es decir, el nmero 4. Tenga en cuenta que X1 es el primer nmero de la secuencia, no X0 como se puede ver en algunos los libr os de texto. Adems, el smbolo n

se utiliza para referirse a la cantidad de elementos en el conjunto X. Hay una serie de cosas que se puede calcular sobre un conjunto de datos. Por ejemplo, podemos calcular la media de la muestra. Supongo que el lector entienda lo que el media de una muestra es, y slo dar a la frmula: FORMULA Observe que el smbolo X (se dice "X barra") para indicar que la media del conju nto de X. Todo esto, dice la frmula es "Suma todos los nmeros y luego se divide por la cantidad que hay". Desafortunadamente, la media no nos dicen mucho acerca de los datos a excepcin de una especie de punto medio. Por ejemplo, estos dos conjuntos de datos tienen exactamente la misma media (1 0), pero son obviamente muy diferentes: [0 8 12 20] y [8 9 11 12] Entonces, qu es diferente en estos dos grupos? Se trata de la difusin de los datos que es diferente. La desviacin estndar (SD) de un conjunto de datos es una medida de la difusin de l os datos. Cmo se calcula? La definicin de Ingls de la SD es la siguiente: "La distancia prome dio de la media del conjunto de datos a un punto ". La forma de calcular es calcula r la cuadrados de la distancia de cada punto de datos a la media del conjunto, aadir a todos ellos, dividir por n-1, y la tomar la raz cuadrada positiva. Como una frmula: FORMULA Donde / es el smbolo habitual para la desviacin estndar de una muestra. He odo que p reguntar: "Por qu est utilizando (n-1) y no n?". Bueno, la respuesta es un poco complicado, pero, en general, si el conjunto de datos es un conjunto de datos de muestra, es decir. que ha to mado un subconjunto de la del mundo real (como la topografa de 500 personas sobre la eleccin), entonces usted debe utiliza r (n-1) porque resulta que que esto le da una respuesta que est ms cerca de la desviacin estndar que tendra com o resultado si se hubiera usado toda la poblacin, que si haba usado n. Sin embargo, si usted no est calculando la desviacin estndar de una muestra, pero para toda la poblacin, entonc es debe dividir por n en lugar de (n-1). Para leer ms sobre este tema, la pgina web http://mathcentral.uregina.ca/RR/database/RR.09.95/weston2.html describe la desviacin estndar de una manera similar, y tambin proporciona un exper imento ejemplo que muestra la Tabla 2.1: Clculo de la desviacin estndar diferencia entre cada uno de los denominadores. Tambin se explica la diferencia entre las muestras y las poblaciones. Por lo tanto, para los dos conjuntos de datos anteriores, los clculos de la desv iacin estndar se

encuentran en la Tabla 2.1. Y as, como era de esperar, el primer grupo tiene una desviacin estndar mucho mayor debido al hecho de que los datos son mucho ms hacia fuera de la media. As como otro ejemplo, el conjunto de datos: [10 10 10 10] Tambin tiene una media de 10, pero su desviacin estndar es 0, porque todos los nmer os son los mismo. Ninguno de ellos se desvan de la media. 2.1.2 varianza Varianza es otra medida de la difusin de datos en un conjunto de datos. De hecho , es casi idntica a la desviacin estndar. La frmula es la siguiente: FORMULA Usted se dar cuenta que esto es simplemente la desviacin estndar al cuadrado, en t anto el smbolo de (s^2) y la frmula (no hay raz cuadrada en la frmula de la varianza). s^2 es el smbolo habitual de varianza de una muestra. Estas dos medidas son medidas de la dispersin de los datos. La desviacin estndar es la medida ms comn, pero es la varian za tambin se utilizan. La razn por la que han introducido variaciones, adems de la de sviacin estndar es proporcionar una plataforma slida desde la cual la prxima seccin, la covarianza , puede lanzar desde. ejercicios Encontrar la media, de datos. -[12 23 34 44 59 70 -[12 15 25 27 32 88 -[15 35 78 82 90 95 2.1.3 Covarianza Las dos ltimas medidas que hemos visto son puramente una dimensin. Los conjuntos de datos como este podran ser: la altura de todas las personas en la sala, las marcas de los ltimos exmenes, etc COMP101 Sin embargo, muchos conjuntos de datos tiene ms de una dimensin, y el objetivo de la estadstica anlisis de estos conjuntos de datos es por lo general para ver si existe alguna relacin entre el dimensiones. Por ejemplo, podramos tener en nuestra base de datos de la altura d e todos los estudiantes en una clase, y la marca que recibi por ese papel. Nos podra llevar a cabo anlisis estadstico para ver si la altura de un estudiante tiene algn efecto sobre su marca. Desviacin estndar y varianza slo operan en una dimensin, por lo que podra slo calcular la desviacin estndar para cada dimensin del conjunto de datos de forma independiente de las otras dimensiones. Sin embargo, es til contar con una medida similar para averiguar cmo desviacin estndar y varianza para cada uno de estos conjuntos 98] 99] 97]

las dimensiones varan mucho de la media con respecto a la otra. Covarianza es una medida. Covarianza siempre se mide entre dos dimensiones. Si se calcula la covarianza entre una dimensin y s, se obtiene el varianza. As que, si haba una base de datos en 3 dimensiones establecidas (x,y,z) , entonces se podra medir la covarianza entre las dimensiones x y y, las dimensiones x y z, y las d imensiones y y z. Medir la covarianza entre x y x, o y y y, o z y z te daria la varianza de las dimensi ones x, y y z respectivamente. La frmula de la covarianza es muy similar a la frmula de la varianza. la frmula de la variacin tambin se puede escribir as: (Formula) donde Simplemente, he ampliado los terminos cuadrados para mostrar las dos parte s. As que dado que el conocimiento, Esta es la frmula para la covarianza: (Formula) includegraphicscovPlot.ps Figura 2.1: Una grfica de los datos de covarianza que muestra la relacin positiva entre el nmero de horas estudiadas en contra de la marca recibida. Es exactamente lo mismo, salvo que en el segundo conjunto de corchetes, las X's se sustituyen por Y's. esto nos dice, en Ingls, "Por cada elemento de datos, multiplicar la diferencia e ntre el valor de x, y la media de x, por la diferencia entre el valor y la media de y. Aadir a todo e sto, y se divide por (n-1) " Cmo funciona esto? Permite utilizar algunos datos de ejemplo. Imaginemos que han e ntrado en el mundo y recogido algunos datos de 2 dimensiones, por ejemplo, hemos pedido a un grupo d e estudiantes Cuntas horas en total, que pas estudiando COSC241, y la marca que han recibido. As que tenemos dos dimensiones, la primera es la dimension H, las horas de estudio, y el segund o es la dimension M, la marca recibida. Figura 2.2 contiene los datos de mi imaginario, y el clculo de cov(H.M), la covarianza entre las horas de estudio realizado y la Marca recibida. Entonces, qu nos dicen? El valor exacto no es tan importante como lo es signo (es decir, positivo o negativo). Si el valor es positivo, ya que esta aqu, entonces indica que ambas dimensiones aumentan juntas, lo que significa que, en general, como el nmero de horas de est udio aumenta, tambin aumenta la nota final. Si el valor es negativo, entonces como una dimensin aumenta, la otra disminuye. Si hubiramos terminado con una covarianza negativa aqu, entonces, hubiera dicho lo contrario, que a medida que el nmero de horas de estudio aument la nota final disminuye. En este ltimo caso, si la covarianza es cero, indica que las dos dimensiones se independientes entre s. El resultado de que la nota dada aumenta a medida que el nmero de horas estudia das aumentan pueden ser vistos fcilmente para dibujar un grfico de los datos, como en la figura 2.1.3 . Sin embargo, el lujo de ser capaz de visualizar los datos slo est disponible en 2 y 3 dimensiones. Dad

o que el valor de covarianza se puede calcular entre 2 dimensiones en un conjunto de datos, esta tcnica se u tiliza a menudo para encontrar relaciones entre las dimensiones de grandes dimensiones conjuntos de datos donde la visualizacin es difcil. Usted podra preguntar: "es cov(X,Y) igual a cov ( Y,X)?" Bueno, un vistazo rapido a la frmula para la covarianza nos dice que s, que son exactamente los mi smos ya que solo la diferencia entre cov(X,Y) y cov(Y,X) es que (Xi-X~)(Yi-Y~) es remplazado por (Yi-Y~)(Xi-X~ ). Y puesto que la multiplicacin es conmutativa, lo que significa que no importa la forma alrededor de cual yo multiplique dos nmeros, siempre obtengo el mismo nmero, estas dos ecuaciones dan la misma respuesta. 2.1.4 La matriz de covarianza Hay que recordar que siempre se mide la covarianza entre dos dimensiones. Si te nemos un conjunto de datos con ms de 2 dimensiones, hay ms que una medida de covarianza que se puede calcula r. Por ejemplo, a partir de un conjunto de datos en 3 dimensiones (dimensiones x,y,z) tu puedes calcular con(x,y), cov(x,z), y cov(y,z). De hecho, para un conjunto de datos n-dimensionales, se puede calcular =======F ormula======== diferentes valores de covarianza. --------------------------------TABLAS______________________average=promedio Tabla 2.2: conjunto de datos de 2-dimensiones y el clcu lo de la covarianza Una manera til de tener todos los valores de covarianza posible entre todos los d iferentes dimensiones es para calcular todos y ponerlos en una matriz. Supongo que en est e tutorial que est familiarizado con las matrices, y cmo se pueden definir. Por lo tanto, la definicin de la matriz de covarianza de un conjunto de datos con n dimensiones es la siguien te: -----------------------------------Formula-------------------------donde ==========(ExPRESION)============= es una matriz con n filas y n columnas, y Dimx es la x dimension. Todo lo que estas feas frmulas dicen es que si usted tiene un conjunto de datos n -dimencionales, entonces la matriz tiene n filas y columnas (entonces es cuadrada) y cada entrad a en la matriz es el resultado del clculo de la covarianza entre dos dimensiones separadas. Por ejemplo. la entrada en la fila 2, columna 3, es el valor calculado de covarianza entre la 2 dimensin y la 3 dimensin. Un ejemplo. Vamos a hacer la matriz de covarianza para un conjunto de datos ima ginario de 3 dimensiones, utilizando las dimensiones habituales x, y, z. Entonces, la matriz de covarianza tiene 3 f ilas y 3 columnas, y los valores son lo siguiente: ---------------------------------------(Expresion)-----------------------------------------------Algunos puntos a tener en cuenta: la diagonal principal, se ve que el valor de c

ovarianza se encuentra entre una de las dimensiones y la misma. Estas son las variaciones de esa dimensin. El otr o punto es que, dado que cov(a,b)=cov(b,a), la matriz es simtrica con respecto a la diagonal principal. ejercicios Calcule la covarianza entre las dimensiones x y y en los siguientes conjunto de datos de dos dimensiones, y describe lo que el resultado indica sobre los datos. -----------------------------------------(Tabla)---------------------------------Calcula la matriz de covarianza para este conjunto de datos de 3 dimensiones. -----------------------------------------(Tabla)---------------------------------2.2 lgebra de Matrices Esta seccin sirve para proporcionar una base para el lgebra de matrices requerido en PCA. Especficamente voy a estar viendo a valores y vectores propios de una matriz dad a. Una vez ms, Supongo que un conocimiento bsico de las matrices. ---------------------------------------Figura------------------------------Figura 2.2: Ejemplo de un vector no propio y un vector propio --------------------------------------Figura------------------------------Figura 2.3: Ejemplo de cmo un vector propio es an reducido y vectores propios 2.2.1 Vectores propios Como usted sabe, usted puede multiplicar dos matrices, siempre que sean compatib les los tamaos. Vectores propios son un caso especial de esto. Considere las dos mul tiplicaciones entre una matriz y un vector en la Figura 2.2. En el primer ejemplo, el vector resultante no es un mltiplo entero de la origina l vector, mientras que en el segundo ejemplo, el ejemplo es exactamente 4 veces e l vector que comenz con. Por qu es esto? Pues bien, el vector es un vector en dos el espacio tr idimensional. la vector======(Expresion)========= (a partir de la multiplicacin del segundo ejemp lo) representa una flecha que apunta desde el origen,(0,0), hasta el punto (3,2). La otra matriz, un cuadrado, puede ser considerado como una matriz de transformacin. Si multiplicas esta matriz a la izquierda de un vector, la respue sta es otro vector que se transforma desde su posicin original. Es la naturaleza de la transformacin que se derivan de los vectores propios. Ima gina una matriz de transformacin que, cuando se multiplican por la izquierda, refleja vec tores en la lnea y=x. Entonces usted puede ver que si hubo un vector que estaba en la lnea y=x, es la reflexin en s mismo. Este vector (y todos los mltiplos del mismo, porque no importa cun largo del vector fue), sera

un vector propio de esa matriz de transformacin. Qu propiedades tienen estos vectores propios? En primer lugar, debe saber que los vectores propios slo se puede encontrar en las matrices cuadradas. Y, no toda matriz cuadrada tiene vectores propios. Y, dado una matriz nxn matriz que tiene vectores propios, hay n de ellos. Dada una matriz de 3x3, hay tres vectores propios. Otra propiedad de los vectores propios es que incluso si escalo el vector por u na cierta cantidad antes de que se multipliquen, sigo teniendo el mismo mltiplo de la misma, como r esultado, como en la Figura 2.3. este es porque si se cambia la escala de un vector por una cierta cantidad, todo lo que estamos haciendo es hacerlo mas largo, no cambiar su direccin. Por ltimo, todos los vectores propios de una matriz son p erpendiculares, es decir en ngulos rectos unos con otros, no importa cuntas dimensiones tiene. Por cierto, otra pal abra para la perpendicularidar, hablar en matemticas, es ortogonal. Esto es importante porque significa que uste d puede expresar los datos en trminos de estos vectores propios perpendiculares, en lugar de expresarlos en trminos de los ejes x y y. Vamos a hacer esto ms adelante en la seccin de PCA. Otra cosa importante a saber es que cuando los matemticos encontrar vectores pro pios, les gusta encontrar los vectores propios, cuya longitud es exactamente uno. Esto es as por que, como ustedes saben, la longitud de un vector no afecta si es un vector propio o no, mientras que la direccin lo hace. Por lo tanto, con el fin de mantener los vectores propios estndares, ca da vez que nos encontramos con un vector propio por lo general su tamao para hacer que tenga un a longitud de 1, para que todos los vectores tienen la misma longitud. He aqu una demostracin de n uestro ejemplo anterior. -------------------------------------------(Expresion)-----------------------------------------es un vector propio, y la longitud del vector es ------------------------------------------(Expresion)-----------------------------------------por lo que dividimos el vector original por esta cantidad para hacer que tenga u na longitud de 1. ------------------------------------------(Expresion)-----------------------------------------Cmo va uno a encontrar estos misticos vectores propios? Por desgracia, slo es fcil ( o menos) si tiene una matriz ms pequea,como del tamao de aproximadamente 3x3. Despus de eso, de la forma habitual de encontrar los vectores propios es por por una complicado mtodo iterativo que est ms all del alcance de este tutorial (y este autor). Si alguna vez necesitas en

contrar los vectores propios de una matriz en un programa, simplemente encontrar una bi blioteca de matemticas que lo hace todo por usted. Un til paquete de matemticas, llamado NEWMA T, est disponible en http://webnz.com/robert/. Para ms informacin sobre vectores en general, cmo encontrarlos, y ortogonalidad, se pueden encontrar en el libro de texto "5e Primaria lgebra Lineal" de Howard A nton, Editorial John Wiley & Sons Inc, ISBN 0-471-85223-6. 2.2.2 Valores propios Valores propios estn estrechamente relacionados con los vectores propios, de hech o, vemos un valor propio en la figura 2.2. Observe cmo, en ambos ejemplos, la cantidad por la cual se redujo el vector original despus de multiplicar por la matriz cuadrada era la mism o? En ese ejemplo, el valor fue de 4,4 es el valor propio asociado con el vector propio. N o importa cul sea mltiplo del vector propio tomamos antes de que lo multipliquemos por la matri z cuadrada, siempre nos da 4 veces el vector de escala como nuestro resultado (como en la Fi gura 2.3). As se puede ver que valores y vectores propios siempre vienen en pares.Cuando rec ibe una librera de programacin de lujo para calcular tus vectores propios para usted, por lo general tambin obtiene los valores propios. ejercicios Para la siguiente matriz cuadrada: ------------------------------------------(Expresion)-----------------------------------------Decide que, en su caso, de los siguientes vectores son vectores propios de esa m atriz y dar el valor propio correspondiente. ------------------------------------------(Expresion)-----------------------------------------captulo 3 Anlisis de Componentes Principales Finalmente llegamos al Anlisis de Componentes Principales (PCA). Qu es? Es una for ma de identificar patrones en los datos, y expresar los datos de tal modo que se m uestran sus semejanzas y diferencias. Dado que los patrones en los datos pueden ser difc iles de encontrar en los datos de alta dimensin, donde el lujo de representacin grfica no est dispon ible, el PCA es una poderosa herramienta para el anlisis de datos. La otra ventaja princ ipal del PCA es que una vez que han encontrado estos patrones en el datos y comprimir los dato

s, es decir. reduciendo el nmero de dimensiones, sin la prdida de gran parte de la informacin. Esta tcnica utilizada en la compresin de imgenes, como veremos en una seccin posterior. Este c aptulo le guiar por los pasos que usted necesita para llevar a cabo un anlisis de component es principales de un conjunto de datos. Yo no voy a describir exactamente por qu el tcnica funci ona, pero voy a tratar de dar una explicacin de lo que est sucediendo en cada punto para que pued a tomar decisiones informadas cuando intenta utilizar esta tcnica a ti mismo. 3.1 Mtodo Paso 1: Obtenga los datos En mi ejemplo simple, voy a usar mi propio conjunto de datos confeccionados. Qu e slo tiene dos dimensiones, y la razn por la que he elegido esto es para que yo pueda ofrecer g raficas de los datos para mostrar lo que el anlisis de PCA est haciendo en cada paso. Los datos que he utilizado se encuentra en la figura 3.1, junto con una grafica de esos datos. Paso 2: Reste la media Para PCA funcione correctamente, tienes que restar la media los datos de cada u na de las dimensiones. La media resta el promedio de cada dimensin. Por lo tanto, todos los valores de x tienen que restar x] (la media de los valores x de todos los puntos de datos), y todos los valore s y tienen que restar y] de ellos. Esto produce un conjunto de datos cuya media es cero. ------------------------------------------(Expresion)-----------------------------------------Figura 3.1: ejemplo de Datos de PCA, los datos originales de la izquierda, los d atos de las medias restados a la derecha, y una grfica de los datos. Paso 3: Calcular la matriz de covarianza Esto se hace exactamente de la misma manera como se discuti en la seccin 2.1.4. D ado que los datos es de 2 dimensiones, la matriz de covarianza ser de 2x2. No hay sorpresas aqu, as que slo le dar el resultado: ------------------------------------------(Expresion)-----------------------------------------Por lo tanto, ya que los elementos no diagonales de esta matriz de covarianza e s positiva, debemos esperar que aumenten tanto la variables x y y entre s. Paso 4: Calcular los vectores propios y valores propios de la matriz de covarian

za Dado que la matriz de covarianza es cuadrada, podemos calcular los vectores pro pios y valores propios de esta matriz. Estos son bastante importantes, ya que nos dice la info rmacin til sobre nuestros datos. Yo te mostrar pronto. Mientras tanto, aqu estn los vectores propio s y valores propios: ------------------------------------------(Expresion)-----------------------------------------Es importante notar que estos vectores propios son ambos vectores propios unita rios, es decir ambas longitudes son 1.Esto es muy importante para la PCA, pero por suerte, la mayora de los paquetes de las matemticas, cuando se les pregunt por vectores propios, le dar vectores propio s unitarios. Entonces, qu significan? Si nos fijamos en la grfica de los datos en la Figura 3.2 entonces puedes ver como los datos tiene un muy fuerte patrn. Como era de esperar de la matriz de covarianza,dos variables que de hecho aumentan juntas. En la parte superior de los datos he tr azado tanto los vectores propios tambin. Aparecen como lneas diagonales de puntos en la grafica. Como se i ndica en la seccin de vector propio, que son perpendiculares entre s. Pero, ms importante, que nos p roporcione informacin acerca de los patrones de los datos. Ver cmo uno de los vectores propi os pasa por el centro de los puntos, como el dibujo de una lnea de mejor ajuste, vector propio que nos est mostrando cmo estos dos conjuntos de datos estn relacionados a lo largo de esa lnea. El segu ndo vector propio nos da el otro, menos importante, el patrn en los datos, que todos los puntos si guen la lnea principal, pero estn a un lado de la lnea principal por una cierta cantidad. As, por este proceso de tomar los vectores propios de la matriz de covarianza, h emos sido capaces de extraer las lneas que caracterizan a los datos. El resto de los pasos que implican la transformacin de los datos de manera que se expresa en trminos de las lneas. Paso 5: Seleccin de componentes y la formacin de un vector de caractersticas Aqu es donde la nocin de compresin de datos y reduccin de dimensionalidad entra en ella. Si nos fijamos en los valores y vectores propios de la seccin anterior, La media de los datos ajustados con vectores propios superpuestas ------------------------------------------(Grafica)-----------------------------------------Figura 3.2: Un grfico de los datos normalizados (media resta) con los vectores pr opios de la matriz de covarianza superpuestas en la parte superior te dars cuenta de que los valores propios son valores muy diferentes. De hecho, resulta

que el vector propio con el mayor valor propio es el principal componente del c onjunto de datos.En nuestro ejemplo, el vector propio con el valor propio Larges fue el que seal el propio medio de los datos. Es la relacin ms significativa entre las dimensi ones de los datos. En general, los vectores propios una vez que se encuentran en la matriz de cova rianza, el siguiente paso consiste en ordenar por valor propio, de mayor a menor. Esto le da los componentes en orden de importancia. Ahora bien, si lo desea, puede decidir ign orar los componentes de menor importancia. Usted pierde alguna informacin, pero si los va lores propios son pequeos, no se pierde mucho.Si se omite algunos de los componentes, el conjunto de datos final tendr menos dimensiones que el original. Para ser precisos, si or iginalmente tienen n dimensiones en sus datos, y asi calcula n vectores propios y valores p ropios, a continuacin, elija slo los primeros p vectores propios, entonces el conjunto fina l de datos slo tiene p dimensiones. lo que hay que hacer ahora es lo que necesita para formar un vector de caracters ticas, que es slo un nombre elegante para una matriz de vectores. Este se construye mediant e la adopcin de los vectores propios que desea mantener en la lista de vectores propi os, y la formacin de una matriz con estos vectores propios en las columnas. -----------------------------------------(Expresion)-----------------------------------------Teniendo en cuenta nuestro conjunto de datos de ejemplo, y el hecho de que tene mos dos vectores propios, tenemos dos opciones. Podemos formar un vector de caractersticas con am bos vectores propios: -----------------------------------------(Expresion)-----------------------------------------o bien, podemos optar por dejar de lado el ms pequeo, el componente menos importa nte y slo tienen un de una sola columna: -----------------------------------------(Expresion)-----------------------------------------Veremos el resultado de cada uno de estos en la siguiente seccin. Paso 6: Obtencin del nuevo conjunto de datos Este es el paso final en PCA, y tambin es la ms fcil. Una vez que hemos elegido lo s componentes (vectores) que queremos tener en nuestros datos y formar un vector de caractersticas, simplemente tomamos la transpuesta del vector y se multiplica a la izquierda de

l conjunto de datos original, transpuesto. -----------------------------------------(Expresion)-----------------------------------------donde RowFeatureVector es la matriz con los vectores propios en las columnas de transposicin de manera que los vectores propios se encuentran ahora en las filas , con el vector propio ms importante en la parte superior, y RowDataAdjust es el dato medio ajus tado por transposicin, es decir los elementos de datos en cada columna, con cada registro que tiene un a dimensin separada. Lo siento si esta repentina incorporacin de todos los datos que confunde, pero las ecuaciones a partir de ahora es ms fcil si tomamos la transpuesta del vector de caracterstico y el primer dato,ms que tener un poco ms arriba de smbolo T sus nombres a partir de ahora. FinalData es el conj unto de datos final, con elementos de datos en columnas, y las dimensiones a lo largo de las filas. Qu nos dara esto? Nos dar los datos originales nicamente en trminos de los vectores que elegimos. Nuestro conjunto de datos original tena dos ejes, X e Y, por lo que nuestros dat os fue en trminos de ellos. Es posible expresar los datos en trminos de cualquiera de los dos ejes qu e te gusta. Si estos ejes son perpendiculares, entonces la expresin es la ms eficiente. Esta es la razn por la importancia de que los vectores propios son siempre perpendiculares entre s. Hemos cambiado nuestros datos puedan ser en trminos de los ejes X e Y, y ahora estn en trminos de nuestros dos vectores propios. En el caso de que el nuevo conjunto de datos se ha reducido la dimensionalidad, es decir, nos han dejado algunos de los vectores propios a cab o, los nuevos datos estn slo en trminos de los vectores que hemos decidido mantener. Para mostrar esto en nuestros datos, no he hecho la transformacin final de cada uno de los vectores caractersticos posibles. He tomado la transpuesta de los resultados en cada caso para llevar los datos a un buen mesa-como formato. Tambin he trazado los puntos final es para mostrar cmo se relacionan con los componentes. En el caso de mantener ambos vectores pro pios de la transformacin, tenemos los datos y la grafica se encuentra en la Figura 3.3. Est a grafica son, bsicamente, los datos originales, se gira de manera que los vectores propios son los ejes. Esto es comprensible ya que no hemos perdido informacin de esta descomposicin. La otra transformacin que podemos hacer es tomar slo el vector propio con el mayo r valor propio. La tabla de datos resulta se encuentra en la Figura 3.4. Como era de esperar, sl o tiene una sola dimensin. Si comparas este conjunto de datos con la que resulta del uso de ambos vectores propios, te dars cuenta de que este conjunto de datos es exactamente la primera columna de la otra. Por lo tanto, si usted fuera a graficar esta informacin, sera una dimensin,

y se seala en una lnea exactamente en la posicin x de los puntos en el grfico de la Figu ra 3.3. Efectivamente hemos tirar todo el eje dems, que es el otro vector propio. Qu hemos hecho aqu? Bsicamente hemos transformado nuestros datos de manera que se e xpresa en trminos de los patrones entre ellos, donde los patrones son las lneas que ms se de scriben las relaciones entre los datos. Esto es til porque hemos clasificado nuestros puntos de datos como una combinacin de las contribuciones de cada una de esas lneas. En un principio t enamos la de muestra a los ejes x y y. Esto est bien, pero los valores X e Y de cada punto de datos en realidad no nos dicen exactamente cmo ese punto se relaciona con el resto de los datos. Ahora, los valores de los puntos de datos nos dicen exactamente dnde se encuentran las lneas de tendencia del punto de datos (es decir arriba / abajo). En el caso de la transf ormacin utilizando ambos vectores propios, simplemente hemos alterado los datos para que sea en trm inos de estos vectores propios en lugar de los ejes de costumbre. Sin embargo, la descomposic in de un solo vector propio ha eliminado la contribucin debida al vector propio ms pequeo y nos dej con los datos de estan slo en trminos del otro. 3.1.1 Obtencin de los datos antiguos de vuelta Desear obtener los datos originales de vuelta es obviamente de gran inters si es tas utilizando la transformada PCA para la compresin de datos (un ejemplo de que a se ver en la prxi ma seccin). Este contenido se ha tomado de http://www.vision.auc.dk/ SIG / Enseanza / Flerdi m / actual / Hotelling / hotelling.html ------------------------------------------(Grafica)-----------------------------------------Figura 3.3: La tabla de datos mediante la aplicacin del anlisis de PCA usando amb os vectores propios, y un grfico de los nuevos puntos de datos. Los datos transformados (unico vector propio) ------------------------------------------(Grafica)-----------------------------------------Figura 3.4: Los datos despus de la transformacin utilizando slo el vector ms importa nte As que, cmo podemos obtener los datos originales? Antes de hacerlo, recuerde que sl o si tomamos todos los vectores propios de nuestra transformacin vamos a obtener exac tamente los datos originales de nuevo. Si hemos reducido el nmero de vectores propios de la transformacin final, a continuacin, los datos recuperados se ha perdido algo de i nformacin. Recordemos que la ltima transformacin es la siguiente: -----------------------------------------(Expresion)----------------------------

--------------puede dar la vuelta as que, para obtener los datos originales de nuevo, -----------------------------------------(Expresion)-----------------------------------------donde RowFeatureVector^-1 es el inverso de RowFeatureVector. Sin embargo, cuand o tomamos todos los vectores propios de nuestro vector caracterstico, resulta que la inversa de nuestro vector caracterstico en realidad es igual a la transposicin de nuestro vector caractersti co. Esto slo es cierto porque los elementos de la matriz son todos los vectores propios u nitarios de nuestra base de datos. Esto hace que el viaje de regreso a nuestros datos ms fcil , porque la ecuacin se convierte en -----------------------------------------(Expresion)-----------------------------------------Sin embargo, para obtener los datos reales originales de nuevo, tenemos que aadi r la media de los datos originales (recordemos que se resto a la derecha en el inicio). Por l o tanto, la integridad, -----------------------------------------(Expresion)-----------------------------------------Esta frmula tambin se aplica a cuando usted no tiene todos los vectores propios d e vector caracteristico. As que, cuando dejen de lado algunos vectores propios, la ecuac in anterior todava hace la transformacin correcta. No voy a realizar los datos de creacin de n uevo utilizando el vector completo de caractersticas, ya que el resultado es exactame nte los datos que empezamos. Sin embargo, yo lo har con la funcin de reduccin de vector pa ra mostrar cmo la informacin se ha perdido. Figura 3.5 muestra este diagrama. Los datos originales fueron restaurados con un solo vector propio ------------------------------------------(Grafica)-----------------------------------------Figura 3.5: La reconstruccin de los datos que se obtienen a partir de un solo vec tor propio Comparela con la grafica de datos original en la Figura 3.1 y se dar cuenta de cm o, mientras que la variacin a lo largo del principio del vector propio (vase la figura 3.2 pa ra el vector propio superpuestas en la parte superior de la media de los datos ajustados) se ha mantenido, a lo largo de la variacin del componente de otro (el otro vector propio otros qu e hemos dejado fuera) se ha ido. ejercicios - Qu nos dan los vectores propios de la matriz de covarianza?

- En qu punto del proceso de PCA podemos decidir comprimir los datos? Qu efecto tie ne esto? - Para un ejemplo de PCA y una representacin grfica de los vectores propios princ ipales, la investigacin el tema "Eigenfaces", que utiliza PCA para hacer el reconocimi ento facial captulo 4 Aplicacin a la Visin por Computador En este captulo se describir la manera en que PCA se utiliza en la visin por compu tadora, primero mostrando cmo las imgenes suelen estar representados, a continuacin, que m uestra lo que PCA nos puede permiten hacer con esas imgenes. La informacin contenida en esta seccin en relacin con el reconocimiento facial pro viene de "reconocimiento de la cara: Eigenface, a juego elstico, y Redes Neuronales", Jun Zhang et al. Actas de la IEEE, vol. 85, No. 9, septiembre de 1997. La representacin de la informacin, se ha tomado de "Procesamiento Digital de Imgenes" Rafael C. Gonzlez y Pablo Wint z, Addison-Wesley Publishing Company, 1987. Tambin es una excelente referencia para ms informacin sobre el K-L se transforman en general. La informacin es la compresin d e imgenes tomado de http://www.vision.auc.dk/ SIG / Enseanza / Flerdim / actual / Hotellin g / hotelling.html, que tambin proporciona ejemplos de reconstruccin de la imagen utilizando una cant idad variable de vectores propios. 4.1 Representacin Cuando se utiliza este tipo de tcnicas de matriz en la visin por computadora, deb emos tener en cuenta la representacin de imgenes. Un cuadrado, N por N la imagen se pu ede expresar como N^2 4-dimensional vector -----------------------------------------(Expresion)-----------------------------------------donde las filas de pxeles de la imagen se colocan uno tras otro para formar una imagen unidimensional. Por ejemplo Los primeros elementos de N X1-XN ser la primera fil a de la imagen, los siguientes N elementos son la fila siguiente, y as sucesivamente. Lo s valores en el vector son los valores de intensidad de la imagen, posiblemente un nico va lor de escala de grises. 4.2 PCA para encontrar patrones Digamos que tenemos 20 imgenes. Cada imagen es N pxeles de alto por pxeles de ancho N. Para cada imagen se puede crear un vector de imagen como se describe en la secc

in de la representacin. A continuacin, puede poner todas las imgenes juntas en una gran mat riz de imagen como esta manera: -----------------------------------------(Expresion)-----------------------------------------que nos da un punto de partida para nuestro anlisis PCA. Una vez que hemos reali zado PCA, tenemos los datos originales en trminos de los vectores propios que encontramos de la matriz de covarianza. Por qu es til? Digamos que queremos hacer el reconocimiento facial, y para que nuestras imagenes originales son caras de personas. Entonces, el problema e s que, dado una nueva imagen, cuyo rostro del conjunto original verdad? (Tenga en cuenta que la nueva imagen no es uno de los 20 que empezamos.) La forma de hacer esto es la visin por compu tadora es medir la diferencia entre la nueva imagen y las imgenes originales, pero no a lo largo de los ejes originales, a lo largo de los nuevos ejes derivados del anlisis de PCA. Resulta que estos ejes funciona mucho mejor para reconocer caras, ya que el anli sis PCA nos ha dado las imgenes originales en cuanto a las diferencias y similitudes entre ellos. El anlisis PCA ha identificado los patrones estadsticos de los datos . Dado que todos los vectores N ^ 2 dimensiones, obtendremos N ^ 2 vectores propi os. En la prctica, somos capaces de dejar de lado algunos de los vectores propios menos im portantes, y el reconocimiento todava funciona bien. 4.3 PCA para la compresin de imgenes Utilizando PCA para la compresin de la imagen tambin se conoce como la solucin de Hotelling, o Karhunen y Leove (KL), se transforman. Si tenemos 20 imgenes, cada una con N ^ 2 pxeles, nosotros podemos formar N ^ 2 vectores, cada uno con 20 dimens iones. Cada vector se compone de todos los valores de intensidad de los pxeles de cada imagen misma. Esto es diferente del ejemplo anterior, porque antes de que tenga mos un vector de imagen, y cada elemento de este vector fue un pxel diferente, mientras que ahora tenemos un vector para cada pxel, y cada elemento del vector es a partir d e una imagen diferente. Ahora llevamos a cabo PCA en este conjunto de datos. Vamos a obtener los 20 vectores propios porque cada vector es de 20 dimensiones. Para comprimir los datos, podemos optar por transformar los nicos datos usados, por ejemplo 15 de l os vectores propios. Esto nos da un conjunto final de datos con slo el 15 dimension es, que nos ha salvado 1 / 4 de el espacio. Sin embargo, cuando los datos originale s se reproducen, las imgenes han perdido parte de la informacin. esta compresin tcnica se dice que es prdida, porque la imagen descomprimida no es exactamente el mismo

que el original, por lo general peor.

Potrebbero piacerti anche

- Normas SagarpaDocumento51 pagineNormas Sagarpaescaparx2Nessuna valutazione finora

- Solicitud de Empleo (Excel)Documento2 pagineSolicitud de Empleo (Excel)escaparx2Nessuna valutazione finora

- Granja AvicolaDocumento131 pagineGranja Avicolaseergio8709Nessuna valutazione finora

- PRACTICA1Documento9 paginePRACTICA1escaparx2Nessuna valutazione finora

- Producción huevos ecológicosDocumento9 pagineProducción huevos ecológicospuebla201Nessuna valutazione finora

- Pid C3Documento13 paginePid C3escaparx2Nessuna valutazione finora

- Plan de T..Documento9 paginePlan de T..escaparx2Nessuna valutazione finora

- Examen 2Documento9 pagineExamen 2Chesito CheNessuna valutazione finora

- Trabajo TopologiaDocumento11 pagineTrabajo Topologia0201910015 ALAIN PEREZ CASTILLA ESTUDIANTE ACTIVONessuna valutazione finora

- 2 Teoria de ConjuntosDocumento7 pagine2 Teoria de ConjuntosMaritza HilarioNessuna valutazione finora

- Teoria de Conjuntos para Segundo Grado de SecundariaDocumento7 pagineTeoria de Conjuntos para Segundo Grado de SecundariaAngela Ramos AcostaNessuna valutazione finora

- ARITMÉTICA 4to DE SECUNDARIADocumento107 pagineARITMÉTICA 4to DE SECUNDARIAkemquef0% (1)

- Aplicación teoría conjuntosDocumento12 pagineAplicación teoría conjuntosDIEGO MONTOYA RINCONNessuna valutazione finora

- Introducción A La Probabilidad y Valor EsperadoDocumento19 pagineIntroducción A La Probabilidad y Valor EsperadoAMYNNXXXXNessuna valutazione finora

- Algebra Superior UASD: Espacio Vectorial y Teoría de PolinomiosDocumento196 pagineAlgebra Superior UASD: Espacio Vectorial y Teoría de PolinomiosGregory NuñezNessuna valutazione finora

- Tema #05 OperadoresDocumento7 pagineTema #05 OperadoresprofedematematicaNessuna valutazione finora

- Estructuras AlgebráicasDocumento21 pagineEstructuras AlgebráicasantherescNessuna valutazione finora

- Actividad 2 Matematicas 11011102 y 1103Documento6 pagineActividad 2 Matematicas 11011102 y 1103ADRIANA PAOLA ARIAS ORTISNessuna valutazione finora

- ConjuntosDocumento8 pagineConjuntosfernando jimenezNessuna valutazione finora

- Con 0471 0305 - 1363898071 PDFDocumento200 pagineCon 0471 0305 - 1363898071 PDFZxMijailxz CorreaNessuna valutazione finora

- Biblia Matematica 2018Documento69 pagineBiblia Matematica 2018Beatriz godoyNessuna valutazione finora

- Parcial 2 Matematicas Discretas UnalmedDocumento2 pagineParcial 2 Matematicas Discretas Unalmedlionforcenike95100% (1)

- Espacios Vect.Documento14 pagineEspacios Vect.MiriamNessuna valutazione finora

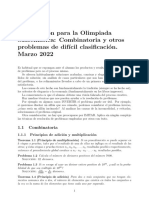

- 2022 Combinatoria EtcDocumento7 pagine2022 Combinatoria EtcjesusgzabrilNessuna valutazione finora

- Guia de Conjuntos - Mate 1Documento7 pagineGuia de Conjuntos - Mate 1Gise SiguenzaNessuna valutazione finora

- Negociación de expectativas: Análisis estadísticoDocumento98 pagineNegociación de expectativas: Análisis estadísticoAbraham PérezNessuna valutazione finora

- Tema 5 y 6 Conjuntos y ProblemasDocumento8 pagineTema 5 y 6 Conjuntos y ProblemasLeo-nardo EinerNessuna valutazione finora

- Teoría conjuntos matemáticasDocumento4 pagineTeoría conjuntos matemáticaseyefrem HDNessuna valutazione finora

- Guia Complementaria ActualizadaDocumento43 pagineGuia Complementaria Actualizadasamuelbastardo3Nessuna valutazione finora

- Diario Matemático Aplicado A La MultimediaDocumento72 pagineDiario Matemático Aplicado A La MultimediaElaine Martínez TejedaNessuna valutazione finora

- Badiou-Universalismo, Diferencia e IgualdadDocumento8 pagineBadiou-Universalismo, Diferencia e IgualdadmnabxtNessuna valutazione finora

- Numeros RealesDocumento9 pagineNumeros RealesXavier Luna100% (1)

- Teoria de ConjuntosDocumento26 pagineTeoria de ConjuntosLuis Miguel Cardozo ArizaNessuna valutazione finora

- Proposiciones Simples y Compuestas - AjustarDocumento26 pagineProposiciones Simples y Compuestas - AjustarGladis G. EstradaNessuna valutazione finora

- Clase 1Documento21 pagineClase 1AMY NARVAEZNessuna valutazione finora

- Correlacion y PrediccionDocumento19 pagineCorrelacion y PrediccionceronenaNessuna valutazione finora

- Simbolizacion de ExpresionesDocumento29 pagineSimbolizacion de ExpresionesAlbe Vic61% (31)