Documenti di Didattica

Documenti di Professioni

Documenti di Cultura

Esquema VII

Caricato da

samuad7109Copyright

Formati disponibili

Condividi questo documento

Condividi o incorpora il documento

Hai trovato utile questo documento?

Questo contenuto è inappropriato?

Segnala questo documentoCopyright:

Formati disponibili

Esquema VII

Caricato da

samuad7109Copyright:

Formati disponibili

Estadstica - Tema VII - Esquema

Samuel B. Alonso Diez

26 de junio de 2011

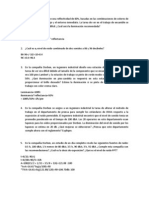

1. Esperanza de una Variable aleatoria bidimensional.

Esperanzas marginales de cada componente: se calculan hallando la distribucion marginal y calculando la

esperanza.

Esperanza de una funcion de las componentes.

Denicion 1.1 Sea X el vector aleatorio (X

1

, . . . , X

n

). Cuando cada coordenada del vector tiene esperanza

nita se dene la esperanza de X como el vector numerico:

E(X) = (E(X

1

), . . . , E(X

n

)).

Denicion 1.2 Sea (X, Y ) una Variable Aleatoria Bidimensional discreta con funcion de masa p

XY

y soporte

D

XY

. Sea g : R

2

R una funcion medible Borel. Si la serie:

(x,y)D

XY

|g(x, y)|p

XY

(x, y)

es convergente, llamaremos esperanza matematica de la variable aleatoria g(X, Y ) a la serie:

E[g(X, Y )] =

(x,y)D

XY

g(x, y)p

XY

(x, y).

Denicion 1.3 Sea (X, Y ) una Variable Aleatoria Bidimensional absolutamente continua con funcion de den-

sidad f

XY

. Sea g : R

2

R una funcion medible Borel. Si la integral:

+

|g(x, y)|f

XY

(x, y)dxdy

es nita, llamaremos esperanza matematica de la variable aleatoria g(X, Y ) a:

E[g(X, Y )] =

+

g(x, y)f

XY

(x, y)dxdy.

1.1. Propiedades de la esperanza.

Si k es una constante, E[k] = k.

E[k] =

kF(dx) = k

F(dx) = k ya que

F(dx) = 1.

Sea (X, Y ) una variable aleatoria, y sea g(X, Y ) una funcion medible Borel. Si g(X, Y ) esta acotada en el

soporte de la VA, es decir, existen valores a, b tal que a g(X, Y ) b para todo (x, y) en el soporte de

(X, Y ), entonces a E[g(X, Y )] b.

Sea (X, Y ) una variable aleatoria, y sean g(X, Y ) y h(X, Y ) dos funciones medibles Borel cuyas esperanza

existan, y sean a y b dos constantes cualesquiera, entonces:

E[a g(X, Y ) + b h(X, Y )] = a E[g(X, Y )] + b E[h(X, Y )]

Sea (X, Y ) una variable aleatoria, y sean g(X, Y ) y h(X, Y ) dos funciones medibles Borel cuyas esperanza

existan. Si g(X, Y ) h(X, Y ), entonces:

E[g(X, Y )] E[h(X, Y )]

E[g(X, Y )] existe y es nita si y solo si E[|g(X, Y )|] < +. Entonces |E[g(X, Y )]| E[|g(X, Y )|].

1

2. Momentos de una Variable Aleatoria bidimensional.

2.1. Momentos respecto al origen.

Denicion 2.1 Se llama momento respecto al origen de ordenes (k, l) de la variable aleatoria (X, Y ), y se

denota por

kl

a la esperanza matematica de la funcion g(X, Y ) = X

k

Y

l

. Es decir,

kl

= E[X

k

Y

l

].

Si k = 1 y l = 0,

10

coincide con la media de la VA X tomando su distribucion marginal.

Si k = 0 y l = 1,

01

coincide con la media de la VA Y tomando su distribucion marginal.

Por tanto a

10

y

01

se les llama media (o esperanza) marginal de las VA X e Y respectivamente.

En general,

k0

=

k

y

0l

=

l

, calculados los segundos miembros a traves de las correspondientes

distribuciones marginales.

2.2. Momentos respecto a la media.

Denicion 2.2 Se llama momento central o respecto a la media de ordenes (k, l) de la variable aleatoria

bidimensional (X, Y ) a la esperanza matematica de la funcion g(X, Y ) = (X

10

)

k

(Y

01

)

l

. Se representa

por

kl

. Por tanto:

kl

= E[(X

10

)

k

(Y

01

)

l

]

Si k = l y l = 0,

20

coincide con la varianza de la VA X tomando su distribucion marginal.

Si k = 0 y l = 2,

02

coincide con la varianza de la VA Y tomando su distribucion marginal.

Por tanto a

20

y

02

se les llama varianza marginal de las VA X e Y respectivamente.

En general,

k0

=

k

y

0l

=

l

, calculados los segundos miembros a traves de las correspondientes

distribuciones marginales.

Al momento

11

se le llama covarianza entre las variables aleatorias X e Y , y a veces se representa por

Cov(X, Y ) o por

XY

.

Denicion 2.3 Sea X el vector aleatorio (X

1

, . . . , X

n

). Si cada coordenada del vector aleatorio tiene segundo

momento nito, entonces la varianza de X se dene como la matriz cuadrada y simetrica:

V ar(X) =

V ar(X

1

) Cov(X

1

, X

2

) Cov(X

1

, X

n

)

Cov(X

2

, X

1

) V ar(X

2

) Cov(X

2

, X

n

)

.

.

.

.

.

.

.

.

.

Cov(X

n

, X

1

) Cov(X

n

, X

2

) V ar(X

n

)

2.3. Propiedades de la varianza y de la covarianza.

2.3.1. Varianza.

Sea (X, Y ) una VA bidimensional. Entonces:

V ar(X Y ) = V ar(X) + V ar(Y ) 2

11

.

Si X e Y son independientes, entonces V ar(X Y ) = V ar(X) + V ar(Y )

Sea X una VA y k una constante. Entonces:

1. V ar(kX) = k

2

V ar(X)

2. V ar(X k) = V ar(X)

2

2.3.2. Covarianza.

Sean X, Y, Z, V variables aleatorias, a, b, c, d constantes:

Cov(X, a) = 0.

Cov(X, X) = V ar(X).

Cov(X, Y ) = Cov(Y, X).

Cov(aX, bY ) = abCov(X, Y ): depende de los cambios de unidad.

Cov(X + a, Y + b) = Cov(X, Y ): Es invariante ante cambios de origen.

Cob(aX + bY, cZ + dV ) = acCov(X, Z) + adCov(X, V ) + bcCov(Y, Z) + bdCov(Y, V ).

Cov(X, Y ) = E(XY ) E(X)E(Y ).

Si (X, Y ) son independientes, Cov(X, Y ) = 0. La contraria no es siempre cierta.

3. Desigualdad de Schwartz.

Teorema 3.1 Sea (X, Y ) una variable aleatoria bidimensional para la que existen

20

y

02

. Entonces:

{E[XY ]}

2

E[X

2

]E[Y

2

]

Consideramos la funcion: p() = E[(X + Y )

2

]. Claramente vemos quie p() 0.

p() =

2

E[X

2

] + 2E[XY ] + E[Y

2

]

Hacemos =

E[XY ]

E[X

2

]

. Por tanto:

E[XY ]

2

E[X

2

]

2

E[X

2

] 2

E[XY ]

E[X

2

]

E[XY ] + E[Y

2

] 0

Operando, llegamos a: {E[XY ]}

2

E[X

2

]E[Y

2

].

Corolario 3.1 Sea (X, Y ) una variable aleatoria bidimensional para la que existen

20

y

02

. Entonces:

Cov

2

(X, Y ) V ar(X)V ar(Y )

Aplicamos la desigualdad de Schwarz a las funciones: g

1

(X) = (X

10

) y g

2

(Y ) = (Y

01

). Por tanto:

E[(X

10

)(Y

01

)]

2

E[(X

10

)

2

]E[(Y

01

)

2

]

4. Coeciente de correlacion.

Denicion 4.1 El coeciente de correlacion entre dos VA se dene:

XY

=

11

Y

Con

X

= +

20

,

Y

= +

02

Proposicion 4.1 El coeciente de correlacion cumple que:

1. Si X e Y son independientes, entonces (X, Y ) = 0.

2. 1 1.

3. |(X, Y )| = 1 si y solo si existen constantes a y b tales que Y = aX +b, con a 0 si (X, Y ) = 1 y a < 0

si (X, Y ) = 1.

1. Si X e Y son independientes,

11

= 0, por tanto (X, Y ) = 0.

2. 1 1:

3

2

=

2

11

20

02

0.

2

1 aplicando la desigualdad de Schwarz.

Por tanto, 0

2

1 y 1 1.

3. Demostramos ambos lados:

Si X = aY + b con a = 0:

(X, Y ) =

Cov(X, aX + b)

V ar(X)V ar(aX + b)

=

aV ar(X)

|a|V ar(X)

=

1 si a > 0

1 si a < 0

Sean (X, Y ) tales que |(X, Y )| = 1.

Sean U = (X

X

)/

X

, V = (Y

Y

)/

Y

. Por tanto, E(U) = E(V ) = 0, V ar(U) = E(U

2

) =

V ar(V ) = E(V

2

) = 1.

(U, V ) = E[UV ]. Es facil probar que (U, V ) = (X, Y ). Por tanto, E(UV ) = 1. Entonces:

V ar(UV ) = E[(UV )

2

][E(UV )]

2

= E[(UV )

2

] = E(U

2

)2E(UV )+E(V

2

) = 2(1E(UV )) = 0

Dado que V ar(UV ) = 0, (UV ) es una VA degenerada e igual a una constante. Como E(UV ) = 0,

(U V ) = 0. Por tanto,

X

X

X

=

Y

Y

Y

y Y =

Y

+ (X

x

)

Y

/

X

, que establece una relacion

lineal entre X e Y .

Si = 1: V ar(U + V ) = 0, y como E(U + V ) = 0, U + V = 0 y

X

X

X

=

Y

Y

Y

.

5. Funcion caracterstica bidimensional.

Denicion 5.1 Sea (X, Y ) una variable aleatoria bidimensional. Llamaremos funcion caracterstica de la VA

(X, Y ) a la esperanza matematica de la funcion:

g(X, Y ) = e

i(tX+uY )

Y se representa as:

XY

(t, u) = E[e

i(tX+uY )

]

5.1. Propiedades de la funcion caracterstica.

Como e

i(tX+uY )

= cos (tX + uY ) + i sin (tX + uY ),

XY

(t, u) siempre sera convergente.

|

XY

(t, u)|

XY

(0, 0) = 1

kl

=

1

i

k+l

k+l

l

(t, u)

t=0,u=0

XY

(t, 0) =

1

(t),

XY

(0, u) =

2

(u), siendo

1

(t),

2

(u) las funciones caractersticas de las distribu-

ciones marginales de X e Y .

Sea la VA bidimensional (X, Y ). Sea la VA Z = X + Y . Entonces,

Z

(t) =

XY

(t, t).

La funcion caracterstica caracteriza totalmente la distribucion de probabilidad.

Teorema 5.1 Sea (X, Y ) una variable aleatoria bidimensional con funcion caracterstica

XY

(t, u).Entonces,

X e Y son VA independientes si y solo si

XY

(t, u) =

X

(t)

Y

(u).

Teorema 5.2 Sean X

1

, X

2

, . . . , X

n

una coleccion de variables aleatorias mutuamente independientes, con fun-

ciones caractersticas

1

(t),

2

(t), . . . ,

n

(t), entonces la funcion caracterstica de la variable aleatoria Z =

n

i=1

X

i

es:

Z

(t) =

n

i=1

i

(t).

4

Potrebbero piacerti anche

- Silabo Energias No Convencionales PDFDocumento5 pagineSilabo Energias No Convencionales PDFLuis CastagnetoNessuna valutazione finora

- 338-1503-1-SM Pino Patula Composicion de La MaderaDocumento15 pagine338-1503-1-SM Pino Patula Composicion de La MaderaCarlos Augusto Alvarez LondoñoNessuna valutazione finora

- Rugosidad AbsolutaDocumento7 pagineRugosidad AbsolutaNataniel ReyesNessuna valutazione finora

- Consideraciones Energéticas en La Trituración de Roca Por Impacto y Compresión.Documento19 pagineConsideraciones Energéticas en La Trituración de Roca Por Impacto y Compresión.Pumba TimonNessuna valutazione finora

- Programacion Del Riego Con Tensiometros PDFDocumento28 pagineProgramacion Del Riego Con Tensiometros PDFjorgerenteriaNessuna valutazione finora

- Fundamentos absorción gasDocumento5 pagineFundamentos absorción gasseralvagaNessuna valutazione finora

- Tabla Resultados Reacciones QuimicasDocumento2 pagineTabla Resultados Reacciones QuimicasCamila Morillo OjedaNessuna valutazione finora

- Tarea2 YoyoDocumento6 pagineTarea2 YoyoPrincesita GascaNessuna valutazione finora

- Modelos de partición modal: Estimación de la demanda de bicicletas entre estudiantes usando MNLDocumento13 pagineModelos de partición modal: Estimación de la demanda de bicicletas entre estudiantes usando MNLMauricio Nova DuranNessuna valutazione finora

- Ejemplo Codificación LatexDocumento4 pagineEjemplo Codificación LatexSantiago Andrés Salinas DelgadoNessuna valutazione finora

- 463.2 Edificio Emir - Mantenimiento SubestaciónDocumento9 pagine463.2 Edificio Emir - Mantenimiento SubestaciónOmar Andres Benitez GonzalezNessuna valutazione finora

- Determinación resistencia sello películas plásticasDocumento9 pagineDeterminación resistencia sello películas plásticasWilmer GonzalezNessuna valutazione finora

- Acoplamiento de AmplificadoresDocumento2 pagineAcoplamiento de AmplificadoresVitore Morleone80% (10)

- Relacion Entre Masa, Fuerza y PesoDocumento4 pagineRelacion Entre Masa, Fuerza y Pesojesusespinoza100% (1)

- Trabajo Física CuánticaDocumento7 pagineTrabajo Física CuánticaayaNessuna valutazione finora

- Tipos de Biomoleculas y Ejemplos de Sus Aplicaciones.Documento9 pagineTipos de Biomoleculas y Ejemplos de Sus Aplicaciones.Dalia100% (1)

- Informe de FisicaDocumento5 pagineInforme de FisicaVinicioBenalcazarNessuna valutazione finora

- Práctica 6Documento6 paginePráctica 6Memo RamosNessuna valutazione finora

- Laboratorio de Fisica 1-Practica Ndeg 10 .Documento6 pagineLaboratorio de Fisica 1-Practica Ndeg 10 .ANDRES ANTONIO PEREIRA COSSIONessuna valutazione finora

- DE LA CRUZ TARDILLO GABRIEL ALONSO - 16. TemperaturaDocumento2 pagineDE LA CRUZ TARDILLO GABRIEL ALONSO - 16. TemperaturaMiranda TardilloNessuna valutazione finora

- Apunte de Clase Engranajes HelicoidalesDocumento11 pagineApunte de Clase Engranajes HelicoidalesFrancisco Xavier Pineda OrtegaNessuna valutazione finora

- FISICADocumento2 pagineFISICALuis Alejandro Chuquipoma MarínNessuna valutazione finora

- Bottaro. ..Documento456 pagineBottaro. ..lisazofernando94% (16)

- Bombas y Motobombas para trasiego de líquidosDocumento36 pagineBombas y Motobombas para trasiego de líquidosCarlos Javier Goez TarraNessuna valutazione finora

- Ato ProblemasDocumento3 pagineAto ProblemasJose SurielNessuna valutazione finora

- Informe Previo 1 y 2 - Electronicos 2Documento8 pagineInforme Previo 1 y 2 - Electronicos 2Natalia PilarNessuna valutazione finora

- Puentes de Königsberg y la introducción de la combinatoriaDocumento10 paginePuentes de Königsberg y la introducción de la combinatoriaMiguelito Alonso PedroNessuna valutazione finora

- Beneficios Energia NuclearDocumento8 pagineBeneficios Energia NuclearNicolás BecerrilNessuna valutazione finora

- TALLERESDocumento4 pagineTALLERESmanuel417726Nessuna valutazione finora

- Publicacion de Sedes BXM 02-2021 0Documento2 paginePublicacion de Sedes BXM 02-2021 0StevenNessuna valutazione finora