Documenti di Didattica

Documenti di Professioni

Documenti di Cultura

Uninettuno - Dispense Di Sistemi Informativi Aziendali

Caricato da

Danilo CataniaTitolo originale

Copyright

Formati disponibili

Condividi questo documento

Condividi o incorpora il documento

Hai trovato utile questo documento?

Questo contenuto è inappropriato?

Segnala questo documentoCopyright:

Formati disponibili

Uninettuno - Dispense Di Sistemi Informativi Aziendali

Caricato da

Danilo CataniaCopyright:

Formati disponibili

Ing.

Michele Ficicchia Sistemi Informativi Aziendali

Università di Palermo

Facoltà di Ingegneria

Corso di Laurea in Ingegneria Gestionale

Dispense di

Sistemi Informativi Aziendali

Ing. Michele Ficicchia

Anno Accademico 2003-2004

Versione 1.0 (3/5/2004) Pagina 1 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

SOMMARIO

1 Introduzione...............................................................................................................4

1.1 Oggetto della materia........................................................................................4

1.2 Contesto in cui si evolve l’informatica..............................................................5

2 L’Hardware................................................................................................................8

2.1 La scheda madre................................................................................................9

2.2 La schede che si inseriscono sulla scheda madre............................................11

2.3 Le memorie di massa.......................................................................................13

2.4 Le periferiche...................................................................................................17

3 Il Software...............................................................................................................20

3.1 Il software di sistema.......................................................................................20

3.2 Il software applicativo.....................................................................................27

4 Le reti.......................................................................................................................28

4.1 Tipologie di reti...............................................................................................28

4.2 Elementi costituenti una rete...........................................................................31

4.3 La rete Internet................................................................................................35

5 Le applicazioni aziendali.........................................................................................42

5.1 Le applicazioni diffuse in tutti i settori............................................................42

5.2 Le applicazioni nel settore industriale.............................................................45

5.3 Le applicazioni nel settore dei servizi.............................................................46

6 L’integrazione delle applicazioni............................................................................61

6.1 L’integrazione orizzontale...............................................................................61

6.2 L’integrazione verticale...................................................................................63

7 Le basi di dati..........................................................................................................68

7.1 File...................................................................................................................68

7.2 Database..........................................................................................................71

8 Pianificazione e realizzazione di un sistema informativo.......................................79

8.1 L’ingegneria del software................................................................................79

8.2 I paradigmi di programmazione......................................................................84

8.3 La misura del software....................................................................................87

8.4 L’utilizzo dei Sistemi Informativi Aziendali...................................................90

Versione 1.0 (3/5/2004) Pagina 2 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

INDICE DELLE FIGURE

Figura 1 – Architettura hardware di un Personal Computer......................................................9

Figura 2 – Struttura di un Hard Disk.....................................................................................14

Figura 3 – Struttura di un codice a barre..............................................................................18

Figura 4 – Classificazione del software.................................................................................20

Figura 5 – Topologie di reti locali (LAN)................................................................................29

Figura 6 – Lo stack ISO/OSI................................................................................................34

Figura 7 – Posizionamento dei canali di accesso rispetto ai vincoli..........................................50

Figura 8 – La macchina Enigma...........................................................................................54

Figura 9 – Schema di funzionamento di un sistema a chiave simmetrica.................................56

Figura 10 – Schema di funzionamento di un sistema a chiave asimmetrica.............................57

Figura 11 – Esempio di chiave pubblica................................................................................58

Figura 12 – Esempi di analisi multidimensionale OLAP...........................................................66

Figura 13 – La struttura di un file.........................................................................................68

Figura 14 – Confronto tra l’organizzazione dei file piatti e dei Database..................................72

Figura 15 – Esempio di Database gerarchico.........................................................................74

Figura 16 – Relazioni 1:1, 1:m ed m:n.................................................................................75

Figura 17 – Esempi di relazioni 1:1, 1:m ed m:n...................................................................75

Figura 18 – Rappresentazione di una relazione 1:m..............................................................76

Figura 19 – Rappresentazione di una relazione m:n..............................................................77

Figura 20 – Confronto tra modello relazionale e modello ad oggetti.......................................78

Figura 21 – Esempio di un diagramma strutturale di un programma.......................................85

Figura 22 – Esempio di classi ed ereditarietà........................................................................87

Figura 23 – Schema di applicazione del metodo dei Function Point.........................................90

Versione 1.0 (3/5/2004) Pagina 3 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

1 Introduzione

1.1 Oggetto della materia

Sistema Informativo Aziendale

Un Sistema Informativo Aziendale può essere definito come l’insieme di persone,

macchine, reti, applicazioni software e processi che permettono all’azienda di disporre

delle informazioni giuste al momento giusto.

Ciclo di vita di un Sistema Informativo Aziendale

Un Sistema Informativo percorre generalmente un ciclo di vita caratterizzato da alcune

fasi ben precise:

Fattibilità tecnico-economica: fase in cui vengono stabiliti gli obiettivi, verificata

la fattibilità tecnica e fatta una prima valutazione dei costi e dei benefici;

Analisi: fase in cui viene effettuata la modellazione dei processi da

informatizzare, la progettazione di dettaglio delle funzionalità e delle banche-dati

del Sistema Informativo;

Progettazione: fase in cui viene effettuata la progettazione di dettaglio dei

componenti software del Sistema Informativo;

Realizzazione: fase in cui il sistema viene realizzato, utilizzando due possibili

strategie, in genere combinate:

o make (realizzare), che consiste nel sviluppare appositamente il software;

o buy (comprare), che consiste nell’acquisire software già pronto ed,

eventualmente, personalizzarlo;

Collaudo: fase durante la quale i singoli componenti software e l’intero sistema

vengono collaudati e, se necessario, modificati;

Manutenzione: fase continua caratterizzata da piccoli interventi sul software

per:

o rimuovere eventuali anomalie;

o adeguare il software alla mutata normativa;

o adeguare il software a tecnologie più avanzate;

o migliorare le prestazioni del software;

o aggiungere nuove funzionalità o migliorare quelle esistenti;

Utilizzo: fase continua che costituisce lo scopo finale della implementazione dei

Sistemi Informativi.

Versione 1.0 (3/5/2004) Pagina 4 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

Alcune categorie ed esempi di Sistemi Informativi Aziendali

Sistemi di supporto alla produzione industriale (CAD, CAM, etc…);

Sistemi di supporto alla gestione aziendale (Personale, Contabilità, Controllo di

Gestione, etc…);

Sistemi bancari (Sportello, C/C, Borsa Titoli, etc…);

Sistemi per la PAC (Pubblica Amministrazione Centrale) (Contabilità di Stato,

Finanza, Pubblica Istruzione, Beni Culturali, etc…);

Sistemi per la PAL (Pubblica Amministrazione Locale) (Anagrafe, Stato Civile,

Tributi, etc…);

Sistemi per la Sanità (ADT, CUP, Pronto Soccorso, Diagnostica per immagini,

etc…);

Sistemi per l’e-Commerce (Catalogo elettronico, carrello della spesa, pagamenti,

etc…);

Sistemi di pianificazione, consuntivazione, controllo (MIS, DSS,

DataWarehouse, cruscotti, etc…).

1.2 Contesto in cui si evolve l’informatica

La Società dell’Informazione (o post-industriale)

L’era industriale, iniziata con l’invenzione delle macchine complesse, è ormai

terminata; siamo nell’era successiva, post-industriale, definita da molti Società

dell’Informazione.

Quale data di transizione (come sempre puramente formale) sono state proposte, tra le

altre:

l’invenzione del computer (a sua volta oggetto di dibattito, oscilla tra il 1930 e il

1945);

la creazione di Arpanet/Internet (anni ’60-‘70);

la caduta del muro di Berlino (novembre 1989);

Ma ne potrebbero esistere molte altre, precedenti e successive: dall’invenzione del

telefono, a quella della radio, dalla messa in orbita del primo satellite per le

telecomunicazioni, alla nascita del World Wide Web.

Caratteristiche della Società Industriale

La Società Industriale era caratterizzata dal seguente profilo:

Produzione di beni utilizzando grandi quantità di materie prime (carbone,

petrolio, acciaio, etc…);

Produzione di massa dei beni grazie alla standardizzazione (ad esempio, nel

settore tessile);

Versione 1.0 (3/5/2004) Pagina 5 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

Sistemi di lavoro alienanti per gli operai, perché basati su piccoli compiti scialbi

ripetitivi (Taylorismo).

Separazione netta tra prodotto e servizio.

Definizione di prodotto e servizio (Karl Marx – Il Capitale)

Il prodotto viene realizzato e consumato in momenti differenti (Es.: tessuto). Il servizio

viene consumato nello stesso momento in cui viene prodotto (Es.: trasporto in treno).

Attenzione: Alcuni testi riportano definizioni errate di prodotto e servizio. Il più

comune errore è che il prodotto sia materiale ed il servizio immateriale. In realtà ci sono

prodotti immateriali (software, film) e servizi con elevata componente materiale

(ristorante).

Caratteristiche della Società dell’Informazione

La Società dell’Informazione è invece caratterizzata dal seguente profilo:

Sviluppo autosostenibile (risparmio di materie prime);

Dematerializzazione del prodotto (es.: software);

Virtualizzazione del servizio (es.: banca on-line);

Virtualizzazione del posto di lavoro (Virtual Workplace, es.: consulenza);

Personalizzazione di massa (grazie a metodologie e tecnologie telematiche);

Lavoro altamente specializzato ma vario e gratificante.

Globalizzazione, comunicazione, connessione.

Evoluzione del ruolo del computer nella Società dell’Informazione

Il computer ha subito nel corso dei decenni un’evoluzione del proprio ruolo nella

Società dell’Informazione. Si possono distinguere almeno tre ruoli principali:

Prima fase (anni ’40-’50): il computer è un calcolatore (da cui il nome inglese);

Es.: Enigma/Colossus, ricerca; previsioni del tempo;

Seconda fase (anni ’60-’80): il computer è un gestore (da cui il nome francese

ordinateur); Es.: sistemi informativi aziendali classici;

Terza fase (anni ’90-2000): il computer è un comunicatore; Es.: Internet, E-mail,

etc…

Col passare del tempo i nuovi ruoli si affiancano a quelli vecchi, che permangono,

anche se tendono a rivestire un ruolo di nicchia (ad esempio, supercalcolatori per la

ricerca scientifica).

L’ICT (Information and Communication Technology)

Come conseguenza del terzo ruolo, l’Informatica (fusione dei termini Informazione e

Automatica) dagli anni ’90 diventa ICT (Information and Communication Technology

Versione 1.0 (3/5/2004) Pagina 6 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

= Tecnologia dell’informazione e della comunicazione), a sottolineare la convergenza e

l’integrazione tra gli aspetti di elaborazione e di comunicazione.

Un esempio tipico di questa convergenza ed integrazione è il confine sempre più labile

tra un anello e l’altro nella catena dei PDA (Personal Digital Assistant = Assistente

digitale personale): telefoni cellulari, Smartphone, PC Phone, Palmari, PC laptop, PC

portatili.

Versione 1.0 (3/5/2004) Pagina 7 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

2 L’Hardware

Hardware e Software

L’hardware (in inglese significa roba dura; è un termine da tempo utilizzato con il

significato di ferramenta) è l’insieme di tutte le componenti tangibili di un elaboratore,

cioè la parte fisica, materiale di un computer (circuiti, magneti, cavi, schede, contenitori,

etc…).

Il software (in inglese significa roba molle; è un neologismo inventato per l’informatica,

in contrapposizione ad hardware) è l’insieme di tutte le componenti intangibili di un

elaboratore, cioè i programmi scritti per farlo funzionare e memorizzati nell’hardware.

Il PC (Personal Computer)

I primi computer (anni ’40) erano basati su valvole termoioniche ed erano grandi come

un appartamento di lusso. Col passare degli anni divennero meno imponenti e poi, con

la diffusione dei transistor prima (anni ’50-’60) e dei circuiti integrati dopo (anni

’70-‘80), via via più piccoli: si parlò di midi-computer (grandi come un armadio), mini-

computer (grandi come una lavatrice), micro-computer (grandi come un cassetto).

Nel 1981 IBM operò una svolta storica introducendo il Personal Computer, un micro-

computer il cui cuore era un micro-processore costituito da un unico circuito integrato,

il quale, oltre ad essere piccolo come una macchina da scrivere, era dotato di

un’interfaccia così semplice (Sistema Operativo DOS) da essere utilizzabile da

chiunque quale computer personale.

Il successo fu enorme e tale da rendere l’architettura hardware PC prevalente su tutte le

altre. Pertanto ci limiteremo a trattare l’hardware di un PC.

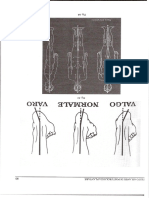

Componenti dell’architettura di un PC

I componenti di un Personal Computer sono:

Scheda madre, su cui sono cablati, tra l’altro, il processore, il bus, il clock, la

ROM, le porte di comunicazione con l’esterno e le interfacce;

Schede di memoria centrale (RAM) e di espansione (video, audio,

comunicazione, etc…);

Dispositivi di memoria di massa (Floppy Disk, Hard Disk, dispositivi ottici,

memorie USB, etc…);

Periferiche di input (Tastiera, mouse, lettore ottico, scanner, etc…);

Periferiche di output (Monitor, stampante, casse, etc…).

Versione 1.0 (3/5/2004) Pagina 8 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

Figura 1 – Architettura hardware di un Personal Computer

2.1 La scheda madre

E’ la scheda più grossa che si trovi dentro il case (contenitore) del PC e ne costituisce il

cuore. E’ affollata di componenti elettronici (transistor, resistenze, condensatori,

bobine) tra cui spiccano alcuni grossi circuiti integrati. Il più grosso è la CPU.

La CPU (Central Processing Unit)

La CPU (Central Processing Unit = Unità di elaborazione centrale) è un

microprocessore ad alta integrazione (contiene milioni di transistor), che effettua le

elaborazioni principali del computer. La CPU elabora le istruzioni del programma in

esecuzione sul computer. Le istruzioni sono di due tipi:

Aritmetiche: consistono in un calcolo (in genere una delle 4 operazioni) che

coinvolge due o più numeri memorizzati in altrettante locazioni di memoria,

producendo un risultato che viene memorizzato in un’altra locazione di memoria;

Logiche: consistono in un confronto tra due più valori memorizzati in altrettante

locazioni di memoria, che produce un risultato vero o falso (es. A > B);

La CPU è composta da due unità:

Control Unit (Unità di controllo): scorre sequenzialmente le istruzioni del

programma in esecuzione, le trasmette all’ALU, che le esegue, e ne acquisisce il

risultato; se l’istruzione è aritmetica, deposita il risultato nella locazione di memoria

specificata dall’istruzione; se l’istruzione è logica, esegue o meno un salto ad

un’altra istruzione specificata a seconda che il risultato sia vero o falso;

ALU (Arithmetic Logic Unit – Unità Logico-Aritmetica): esegue i calcoli ed i

confronti richiesti dalla Control Unit, producendo il risultato numerico (istruzione

aritmetica) o la condizione Vero/Falso (istruzione logica);

In questo modo, la CPU è in grado non solo di eseguire calcoli complessi in tempi

ridottissimi, ma anche di “prendere decisioni” in fase esecutiva sulla base dei valori

delle variabili di programma.

Versione 1.0 (3/5/2004) Pagina 9 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

La CPU è il componente più veloce del computer, in grado di eseguire miliardi di

istruzioni al secondo. La potenza (velocità) di una CPU si misura oggi (aprile 2004) in

GHz (GigaHertz, ossia miliardi di Hertz, cicli al secondo).

Il bus

Il bus (autobus) è l’autostrada di collegamento tra la CPU e le altre componenti del

computer. Consente ai dati di fluire da un componente all’altro con la velocità più adatta

al caso. La velocità del bus è in genere intermedia tra quella della CPU e quella delle

altre componenti.

Il clock

Il clock (orologio) è un oscillatore al quarzo che scandisce i cicli (Hertz) di

funzionamento della CPU e degli altri componenti. Ogni ciclo corrisponde in genere ad

un’istruzione eseguita dalla CPU. Gli altri componenti, più lenti, effettuano

un’operazione ogni n cicli. Le frequenze dei clock odierni si misurano in GHz.

La ROM (Read Only Memory)

La ROM (Read Only Memory = Memoria di sola lettura) è una memoria elettronica di

sola lettura, che viene memorizzata in fabbrica con un software detto di bootstrap

(anello nello stivale, utile per calzarlo). La ROM è una memoria veloce, in grado di

comunicare con efficienza con la CPU, senza costringerla ad attese penalizzanti. Il

software di bootstrap in essa contenuto è in grado di avviare il computer all’accensione

in attesa che si attivi il Sistema Operativo del Computer.

L’esigenza di disporre di una ROM è dovuta al fatto che, come si vedrà, la CPU non

può leggere istruzioni dall’Hard Disk perché questo è troppo lento e, all’accensione, non

può leggere istruzioni dalla RAM perché questa è volatile. In assenza delle istruzioni

non volatili memorizzate sulla veloce ROM (bootstrap) i computer non potrebbero

avviarsi.

Le porte di comunicazione

Sulla scheda madre sono cablate numerose porte di comunicazione con dispositivi

esterni al computer. Le più comuni sono:

Porta tastiera: serve a connettere la tastiera;

Porta mouse: serve a connettere il mouse;

Porte seriali (in genere due): trasmettono i dati serialmente, un bit dopo l’altro;

servono a connettere dispositivi seriali, come lettori di codici a barre, scanner,

modem e molti altri; vanno lentamente in disuso, sostituite dalle porte USB;

Porta parallela: trasmette i dati 8 bit alla volta; serve a connettere la stampante;

Porte USB (Universal Serial Bus = Autobus seriale universale; sui computer

moderni ce ne sono almeno 6, di cui due sul frontale): trasmette i dati serialmente,

ma ad alta velocità; serve a connettere praticamente tutte le periferiche; inoltre, a

differenza delle altre porte, può connettere e sconnettere i dispositivi a caldo (senza

Versione 1.0 (3/5/2004) Pagina 10 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

spegnere il computer), può connettere più dispositivi in serie ed è in grado di fornire

anche l’alimentazione; ideale per dispositivi ad alto trasferimento di dati (come

macchine fotografiche e videocamere) ha ormai di fatto rimpiazzato le porte seriali;

Le interfacce

Sulla scheda madre sono cablate anche le interfacce con dispositivi interni al computer

ma fisicamente staccati dalla scheda stessa. Le più comuni sono:

Interfaccia per il Floppy Disk; sta andando lentamente in disuso;

Interfacce per le altre memorie di massa (Hard Disk, lettori/masterizzatori

CD/DVD); in genere ci sono due canali, ciascuno dei quali supporta due dispositivi,

per un totale di quattro dispositivi.

2.2 La schede che si inseriscono sulla scheda madre

Sulla scheda madre esistono degli slot (fessure) nei quali è possibile inserire delle

schede aggiuntive. Alcuni slot sono dedicati alle schede di memoria centrale (RAM),

altri sono disponibili per schede di espansione, che incrementano le funzionalità del PC.

La RAM (Random Access Memory)

La RAM (Random Access Memory = Memoria ad accesso casuale) è una memoria

elettronica che può essere letta e scritta. Le sue caratteristiche sono:

Elevata velocità; è in genere il componente più veloce dopo la CPU;

Volatilità dei dati; per la persistenza dei dati, occorre l’alimentazione elettrica;

conseguentemente, la RAM perde tutti i dati ad ogni spegnimento del computer;

Alto costo per dato memorizzato; essendo una memoria elettronica, il costo è

elevato rispetto alle memorie magnetiche (come gli Hard Disk) o ottiche (come i

CD/DVD);

Limitata capacità di memorizzazione (qualche centinaio di MB) dovuta all’alto

costo.

Per la sua elevata velocità, la RAM è l’unica memoria (oltre alla ROM, che però non è

scrivibile) che può dialogare direttamente con la CPU senza che quest’ultima trascorra

la gran parte del suo tempo in attesa di leggere o scrivere un dato. Tutti i dati e le

istruzioni del computer che devono essere elaborati dalla CPU vengono pertanto

memorizzati temporaneamente sulla RAM, che assume quindi il ruolo di memoria

centrale dell’elaboratore.

Questo è il motivo per il quale tutti i computer utilizzano una RAM, nonostante l’alto

costo.

La caratteristica principale di una RAM è la capienza che si misura oggi (aprile 2004) in

centinaia di MB (MegaByte, cioè milioni di Byte), con tendenza a portarsi sul GB

(GigaByte, cioè miliardi di Byte). I tagli sono sempre potenze di 2 (128MB, 256MB,

512MB, etc…). La potenza di un computer deriva dalla velocità della CPU e, subito

dopo, dalla quantità di RAM istallata.

Versione 1.0 (3/5/2004) Pagina 11 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

La scheda video

Sulla scheda madre esiste uno slot denominato AGP (Accelerated Graphic Port = Porta

grafica accelerata), predisposto per l’inserimento della scheda video. La scheda video è

un piccolo computer fornito di processore grafico, schede di memoria ed altri

componenti che elaborano il software grafico del programmi creando la grafica da

inviare al monitor. La scheda video è dotata di un’uscita (denominata VGA – Video

Graphics Array = Matrice grafica video) che consente la connessione al video ed oggi,

sempre più spesso, di altre uscite, come la DVI (Digital Video Interface = Interfaccia

video digitale) per la connessione a monitor digitali (LCD, Plasma, etc…) o la S-Video

per televisori, etc…

Alcune schede moderne, orientate ai videogiocatori, montano processori grafici che

rivaleggiano in potenza con la CPU del computer. Altre, orientate alla multimedialità,

ospitano sintonizzatori TV o satellitari o hanno capacità di acquisizione video.

La scheda audio

Gli altri slot di espansione della scheda madre possono ospitare schede per gli usi più

disparati. Tra questi vi è la scheda audio, che elabora il software audio dei programmi

creando i segnali audio per le periferiche destinate (casse). La scheda audio ha almeno

un’uscita di tipo jack che permette il collegamento alle casse stereo amplificate, un

ingresso jack per il microfono ed un ingresso dedicato per il Joystick (bastone da

divertimento, una periferica di gioco che, per ragioni storiche, è pilotata dalla scheda

audio).

Nelle schede moderne esistono altre uscite, tra cui una digitale di tipo S/PDIF

(Sony/Philips Digital InterFace = Interfaccia digitale Sony/Philips) che consente il

collegamento digitale ad un amplificatore decodificatore di segnali Dolby Digital e DTS

(Digital Theather Systems, inc.). Inoltre ormai la gran parte delle schede moderne

supporta un sistema surround a 5.1 canali. Le schede audio più sofisticate sono dei veri

e propri sistemi Home Theater.

La scheda di rete

La scheda di rete è una scheda di espansione che consente il collegamento del PC ad

una rete locale. La scheda trasforma i segnali del bus del computer in segnali coerenti

con la rete locale (oggi quasi esclusivamente di tipo Ethernet). La scheda ha un’uscita di

rete oggi esclusivamente di tipo RJ45.

Si vanno lentamente diffondendo schede di rete wireless (senza fili), che utilizzano una

tecnologia ad onde radio secondo lo standard 802.11b (comunemente citato come Wi-

Fi). Queste “schede”, tuttavia, in genere non si inseriscono nella scheda madre, ma si

collegano ad una porta del PC (in genere USB).

La scheda modem

La scheda modem (MODulatore DEModulatore) è una scheda di espansione che

consente il collegamento del PC alla linea telefonica. La scheda trasforma i segnali del

bus del computer in segnali telefonici analogici da inviare sul doppino telefonico. La

scheda ha un’uscita telefonica oggi esclusivamente di tipo RJ11.

Versione 1.0 (3/5/2004) Pagina 12 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

Esistono alcune varianti della scheda modem dedicate a connessioni telefoniche

particolari. Tra queste le più diffuse sono la scheda ADSL che consente un

collegamento analogico ad alta velocità sul doppino telefonico e la scheda ISDN

predisposta per le linee telefoniche digitali.

2.3 Le memorie di massa

La memoria RAM è una memoria veloce, ma volatile e molto costosa, quindi

disponibile in tagli relativamente piccoli (alcune centinaia di MB). Per memorizzare

permanentemente grandi quantità di dati (decine di GB) a basso costo i computer

dispongono delle memorie di massa. Le loro caratteristiche sono:

Persistenza dei dati; grazie alla tecnologia magnetica o ottica i dati si conservano

anche in assenza di alimentazione;

Basso costo per dato memorizzato;

Elevata capacità (decine o centinaia di GB per gli Hard Disk), dovuta al basso

costo;

Bassa velocità; i dati devono essere spostati temporaneamente sulla RAM per

poter essere elaborati dalla CPU.

Il Floppy Disk

Il Floppy Disk (Disco molle, floscio) è la prima tipologia di memoria di massa ad essere

apparsa sui PC. Consiste in un disco di piccole dimensioni a tecnologia magnetica, che

oggi può contenere 1,4 MB, che viene inserito in un drive presente nel case del PC per

la lettura e scrittura.

Contenuto in una custodia rigida da taschino (il termine floppy ha ragioni storiche), è

studiato per consentire comodi trasferimenti di dati tra PC. Oggi è in disuso per la scarsa

capacità, sostituito dalle più comode, più veloci e molto più capienti memorie USB.

L’Hard Disk

L’Hard Disk (Disco rigido) è anch’esso un disco a tecnologia magnetica, ma è istallato

in maniera fissa sul PC ed ha una struttura molto più complessa.

Il disco è in realtà un cilindro costituito da più dischi piani coassiali, la cui superficie ha

un rivestimento magnetico. Un braccio in grado di muoversi radialmente porta le testine

di lettura/scrittura, in modo che il movimento rotatorio dei dischi combinato con quello

radiale del braccio permetta alle testine di raggiungere qualunque punto della superficie

magnetizzata.

Per rispecchiare questa struttura di funzionamento, la superficie magnetizzata di ogni

disco è suddivisa in tracce concentriche, la cui sovrapposizione sui dischi forma un

cilindro, raggiungibile con il posizionamento radiale del braccio portatestine. Ciascuna

traccia è ulteriormente suddivisa in settori.

L’Hard Disk è la principale memoria di massa di un PC. La sua caratteristica più

importante è la capienza, che si misura in decine o, tendenzialmente, centinaia di GB

(GigaByte, miliardi di Byte).

Versione 1.0 (3/5/2004) Pagina 13 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

Figura 2 – Struttura di un Hard Disk

Le memorie di massa ottiche (CD e DVD)

Le memorie di massa ottiche sono dischi che, come i Floppy Disk, vengono inseriti in

un drive in grado di leggerli (Lettore) o di leggerli e scriverli (Masterizzatore), ma a

differenza dei Floppy Disk e degli Hard Disk utilizzano una tecnologia ottica.

I dischi ottici sono costituiti da uno strato di policarbonato di 12 cm di diametro, sul

quale viene deposto uno strato fotoriflettente che contiene una traccia a forma di spirale

dall’interno del disco verso l’esterno. La spirale è costituita da una serie di pit (fossi),

scarsamente riflettenti e quindi opachi, e di land (terreno piano), altamente riflettenti e

quindi luminosi. Un raggio laser prodotto dal drive ottico esplora la spirale, viene

riflesso da pit e land in modo diverso e viene letto da un fotorilevatore, distinguendo le

zone ad alta e bassa riflettività. In questo modo sul disco ottico può essere memorizzata

l’informazione.

Esistono fondamentalmente tre tipi di dischi ottici: di sola lettura (identificati con la

sigla ROM – Read Only Memory = Memoria di sola lettura), registrabili (identificati

con la sigla R – Recordable = Registrabile) e riscrivibili (identificati con la sigla RW –

ReWritable = Riscrivibile).

I dischi ottici di sola lettura (ROM) vengono stampati in serie presso stabilimenti

opportunamente attrezzati, in un processo nel quale pit e land vengono creati

meccanicamente, in modo irreversibile.

Versione 1.0 (3/5/2004) Pagina 14 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

I dischi ottici registrabili (R), invece, vengono scritti da un dispositivo ottico con un

laser di potenza più elevata rispetto a quella del semplice lettore, chiamato

masterizzatore. Questi dischi possiedono uno strato di pigmenti organici che, quando

colpiti da una luce laser di opportuna potenza, diventano opachi, creando i pit. Le parti

della spirale non colpite dal laser, rimangono land.

I dischi ottici riscrivibili (RW) vengono anch’essi scritti da un masterizzatore, ma il

meccanismo è più complesso. Questi dischi possiedono uno strato di un composto

chimico in grado di cambiare fase quando colpito dalla luce del laser. Il composto è

inizialmente in uno stato policristallino, ad alta riflettività. Quando viene colpito dal

laser, tramite un riscaldamento e repentino raffreddamento, passa ad uno stato amorfo,

opaco, che realizza i pit. Per ritrasformare i pit in land, il masterizzatore deve applicare

una potenza bassa e costante per riportare il composto allo stato cristallino. La maggiore

complessità del processo spiega perché i tempi di masterizzazione dei supporti

riscrivibili sono maggiori di quelli dei supporti registrabili.

I dischi ottici esistono in due principali formati, che differiscono per la densità di pit e

land sulla spirale e, conseguentemente per la capacità: CD e DVD.

I CD (Compact Disk)

I CD (Compact Disk = Disco compatto) sono dischi a tecnologia ottica che utilizzano

un raggio laser di lunghezza d’onda di 780 nanometri (infrarosso) per la lettura e la

scrittura. La loro capacità è di 650 MB, che, con vari accorgimenti, può essere portata a

700 MB o anche oltre.

Ne esistono tre tipi: CD-ROM di sola lettura, CD-R registrabili e CD-RW riscrivibili.

Sono ancora diffusamente utilizzati per la distribuzione del software e per la

registrazione di musica, ma, data la loro relativa bassa capienza, tendono ad essere

sostituiti dai DVD come sistemi di archiviazione di massa.

I DVD (La sigla è ufficialmente priva di significato)

I DVD sono dischi a tecnologia ottica che utilizzano un raggio laser di lunghezza

d’onda di 650 nanometri (rosso) per la lettura e la scrittura. Ne esistono numerosi tipi,

che utilizzano standard differenti e capacità differenti.

DVD-ROM, di sola lettura; ne esistono 4 formati, a seconda che utilizzino una

sola o entrambe le facce e che ciascuna faccia contenga un singolo strato riflettente

o un doppio strato (leggibili entrambi cambiando la messa a fuoco del laser):

Formato Strato Faccia Capacità

DVD-5 Singolo Singola 4,7 GB

DVD-9 Doppio Singola 8,5 GB

DVD-10 Singolo Doppia 9,4 GB

DVD-18 Doppio Doppia 17 GB

Nota: i formati DVD-5 e soprattutto DVD-9 sono molto diffusi per la distribuzione

di film. I formati DVD-10 e DVD-18 sono praticamente inutilizzati.

Versione 1.0 (3/5/2004) Pagina 15 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

DVD registrabili e riscrivibili, esistono tre standard:

Formato Tipo Capacità Sponsor DVD Forum

DVD-R Registrabile 4,3 GB Pioneer Standard

DVD-RW Riscrivibile 4,3 GB Pioneer Standard

DVD+R Registrabile 4,3 GB Sony, Philips Respinto

DVD+RW Riscrivibile 4,3 GB Sony, Philips Respinto

DVD RAM Riscrivibile 4,7/9,4 GB Panasonic Standard

Nota: esiste una forte competizione tra gli standard –R e +R, nonostante

quest’ultimo non sia stato approvato dal DVD Forum. Il formato RAM è poco

utilizzato e relegato ad usi informatici, anche perché richiede che il disco sia

sigillato in una cartuccia.

Nota sulle capacità di memoria

L’unità di misura minima della memoria è il bit (binary digit = cifra binaria, ma bit

significa anche pezzettino), che può assumere valore 0 e 1 (si o no, acceso o spento,

etc…). I bit sono raggruppati in gruppi di 8, chiamati Byte, che costituiscono l’unità

base per la capacità di memoria, perché rappresentano il gruppo di bit ideale per

rappresentare un carattere (lettera, numero, etc...).

Poiché i computer basano la loro logica di funzionamento sulla numerazione binaria, i

multipli del Byte sono potenze di 2 e non di 10. Per motivi di praticità, si continuano ad

usare i multipli decimali classici delle altre branche dell’ingegneria (Kilo per mille,

Mega per un milione, Giga per un miliardo, etc…), associandoli alla potenza di due più

vicina al multiplo decimale.

Si ha pertanto la seguente situazione:

Unità Pari a Considerato comunemente

KB (KiloByte) 210 = 1.024 Byte Un migliaio di Byte

MB (MegaByte) 220 = 1.048.576 Byte Un milione di Byte

30

GB (GigaByte) 2 = 1.073.741.824 Byte Un miliardo di Byte

40

TB (TeraByte) 2 = 1.099.511.627.776 Byte Mille miliardi di Byte

Conseguentemente, 4,7 miliardi di Byte non corrispondono a 4,7 GB, ma a:

4.700.000.000 / 1.073.741.824 ≈= 4,38 GB

I produttori di DVD registrabili e riscrivibili, giocando su tale equivoco, vendono dischi

da 4,7 miliardi di Byte, illudendo gli utenti ingenui che si tratti di 4,7 GB, mentre in

realtà sono poco più di 4,3 GB.

Nota sul futuro dei dischi ottici

Nel corso del 2004 stanno per essere progressivamente introdotti DVD registrabili e

riscrivibili a doppio strato, sia nello standard +R che –R, con capacità finalmente eguale

a quella dei DVD-ROM (9,4 GB come i DVD-9).

Versione 1.0 (3/5/2004) Pagina 16 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

Entro il 2005 dovrebbero diffondersi i DVD ad alta definizione (HD DVD) che

utilizzano un laser di lunghezza d’onda di 480 nanometri (laser blu) e che dovrebbero

avere una capienza oscillante tra i 25 ed i 50 GB.

Le memorie USB (Universal Serial Bus)

Le memorie USB (Universal Serial Bus = Autobus seriale universale) sono memorie di

tipo elettronico e sono rimovibili come i Floppy Disk. Si tratta di piccoli oggetti, delle

dimensioni massime di un evidenziatore (da cui il nome volgare Pen Drive =

Dispositivo a penna), che si inseriscono nella porta USB del PC, tramite la quale

ricevono sia il collegamento che l’alimentazione. La tecnologia utilizzata consente la

persistenza dei dati, ma non il loro utilizzo, anche in assenza di alimentazione.

Sono dotate di capacità di memoria molto più elevate di un Floppy Disk (in genere da

32 MB a 2 GB), in continua ascesa ed a costi sempre inferiori, per cui stanno

definitivamente sostituendo il Floppy Disk per le esigenze di trasferimento e trasporto

di dati.

2.4 Le periferiche

La tastiera

La tastiera è una periferica di input che consente l’immissione di testo. Ne esistono

versioni personalizzate per i diversi paesi, che si adattano alle diverse frequenze di

utilizzo delle lettere e comprendono i caratteri speciali del paese (ad esempio, le lettere

accentate per l’Italia.).

Si diffondono sempre più le tastiere wireless, che si collegano all’unità centrale tramite

onde radio, senza l’utilizzo di un cavo.

Il mouse

Il mouse è una periferica di input che costituisce il dispositivo di puntamento del PC. Il

mouse permette di puntare un oggetto grafico mostrato a video e, “cliccando” il tasto

sinistro, di attivare la funzionalità ad esso associato. Il mouse è dotato anche di un tasto

destro, che attiva funzionalità accessorie, come un menu di pop-up (apparizione), e

spesso di un terzo tasto. E’ inoltre dotato di una rotellina, che consente lo scorrimento

verticale della finestra in uso.

I tradizionali mouse con sfera vengono sempre di più sostituiti da mouse ottici che

rilevano il movimento tramite una fotocellula. Si diffondono inoltre sempre più i mouse

wireless che si collegano all’unità centrale tramite onde radio, senza l’utilizzo di un

cavo.

Il lettore ottico

Il lettore ottico è una periferica di input che legge i codici a barre ed il testo. E’

utilizzato per l’acquisizione veloce di etichette con codice a barre o di testo a

stampatello, in quest’ultimo caso associato a software di riconoscimento che garantisce

Versione 1.0 (3/5/2004) Pagina 17 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

una percentuale di riconoscimento dipendente dai caratteri utilizzati e dalla chiarezza

del testo.

Figura 3 – Struttura di un codice a barre

Lo scanner

Lo scanner è una periferica di input che acquisisce immagini. E’ dotato di una finestra

in formato A4 o A3 che fotografa l’immagine e, attraverso il software associato, lo

trasforma in uno dei formati digitali utilizzati in informatica. E’ utilizzato anche per

acquisire documenti di testo cartacei che vengono riconosciuti con appositi software.

Il monitor

Il monitor è una periferica di output che mostra la grafica generata dalla scheda video,

alla quale viene collegato. I monitor tradizionali utilizzano una tecnologia analogica

CRT (Cathode Ray Tube = Tubo a raggi catodici) ed hanno dimensioni che vanno dai

17” ai 21” (pollici, equivalenti a 2,54 cm.)

Si vanno diffondendo, a costi superiori ma in continuo calo, i monitor digitali LCD

(Liquid Crystal Display = Schermo a cristalli liquidi) che hanno il vantaggio della

profondità estremamente ridotta, per la mancanza di tubo catodico, e del consumo

ridotto, ma possiedono ancora una qualità dell’immagine inferiore ai CRT, soprattutto

per l’incapacità di riprodurre i neri profondi e l’effetto scia nelle immagini in rapido

cambiamento. Un ulteriore vantaggio dei monitor LCD è la presenza di una connessione

DVI (Digital Video Interface = Interfaccia video digitale), che consente di evitare

(purché anche la scheda video ne sia dotata) la conversione digitale/analogica dei

monitor CRT.

La stampante

La stampante è una periferica di output che stampa documenti multimediali. Esistono

diverse tecnologie; le più diffuse sono:

Ad aghi, che utilizza una matrice di aghi per la stampa; monocromatica, lenta e

di bassa qualità, è oggi caduta in disuso e viene utilizzata solo per la stampa di

moduli continui;

Versione 1.0 (3/5/2004) Pagina 18 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

Laser, che forma l’immagine mediante un raggio laser e la fissa sulla carta

utilizzando un toner; esistono versioni A4 ed A3, monocromatiche (molto diffuse)

ed a colori (molto costose); è veloce e di alta qualità ed è molto diffusa per la

stampa di documenti;

A getto d’inchiostro, dotata di una testina che nebulizza goccioline d’inchiostro

sulla carta; è in genere a colori, con cartucce d’inchiostro per il nero ed i tre colori

principali (giallo, magenta e ciano); esistono anche versioni per stampa fotografica a

sei colori; produce stampe di alta qualità, ma è molto lenta e supporta solo il formato

A4; è in genere utilizzata per usi amatoriali, anche per il ridotto costo iniziale,

spesso vanificato però dall’alto costo delle cartucce (che a volte superano il costo

della stampante).

Le casse

Le casse sono periferiche di output che riproducono l’audio prodotto dalla scheda audio

alla quale si collegano. Sono in genere amplificate e riproducono un suono stereo.

Si vanno sempre più diffondendo sistemi di casse a più vie, in genere 5.1 per utilizzi

Home Theater, con due casse anteriori per la musica, un canale centrale per i dialoghi,

due casse posteriori per gli effetti ed un subwoofer per le basse frequenze.

Versione 1.0 (3/5/2004) Pagina 19 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

3 Il Software

Il software è l’insieme di tutte le componenti intangibili di un elaboratore, cioè i

programmi scritti per farlo funzionare e memorizzati nell’hardware. Senza il software

l’hardware non può svolgere alcuna funzione.

Classificazione del software

Il software si può distinguere in due grandi categorie:

Software di base o di sistema: permette al computer di avviarsi, gestisce le

risorse del sistema, gestisce il file system, effettua il monitoraggio del sistema,

costituisce l’interfaccia con gli utenti ed il software applicativo, svolge diverse

funzioni di utilità;

Software applicativo: svolge le funzionalità richieste dagli utenti; si distingue in

software standard e dedicato in base alla specializzazione;

Figura 4 – Classificazione del software

3.1 Il software di sistema

Il software di sistema comprende:

Sistema operativo;

Traduttori;

Programmi di utilità.

Versione 1.0 (3/5/2004) Pagina 20 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

Il Sistema Operativo

Il sistema operativo (d’ora in poi S.O.) permette al computer di avviarsi, gestisce le

risorse del sistema, gestisce il file system, effettua il monitoraggio del sistema,

costituisce l’interfaccia con gli utenti ed il software applicativo.

L’esigenza di un S.O. discende dalla complessità e ricchezza dell’hardware che un

computer mette a disposizione al software applicativo. I diversi programmi applicativi

che vengono eseguiti in un computer hanno il fine di offrire ai propri utenti le

funzionalità richieste, utilizzando le risorse hardware a disposizione. In assenza di un

intermediario che filtri le richieste, assegni le priorità e “regoli il traffico” dei dati,

ciascun programma applicativo tenderebbe ad appropriarsi e a detenere le risorse

hardware di cui ha bisogno; si genererebbe così una congestione che porterebbe

all’arresto dei processi (deadlock = punto morto).

Il S.O. è l’unico programma autorizzato ad accedere alle risorse hardware, mediando tra

le richieste dei programmi applicativi. In presenza di un conflitto di esigenze, il S.O.

ripartisce le risorse tra i programmi, assegnandole a ciascuno per finestre temporali

(time slicing = affettamento del tempo), secondo priorità che sono stabilite dagli

amministratori del sistema. In tal modo, tutti i processi applicativi percepiscono un

accesso continuo alle risorse hardware, come se ne avessero la disponibilità esclusiva.

In sintesi, i compiti di un S.O. sono:

Avviamento del computer, caricando in memoria centrale (RAM) tutte le

informazioni necessarie alla gestione e portando a regime tutti i processi necessari

alla gestione delle risorse del sistema;

Gestione delle risorse hardware del sistema; il S.O. suddivide il tempo in fette

sottili (time slicing), assegnando le risorse contese ad ogni processo per quella fetta

di tempo; in tal modo si realizza il multitasking (multicompito), ossia è come se più

processi venissero elaborati “contemporaneamente”;

Gestione di una risorsa molto importante: lo spazio su disco, tramite

un’organizzazione che si chiama file system (vedi sotto);

Monitoraggio della corretta esecuzione dei processi e dell’utilizzo delle risorse;

Interfaccia ai programmi applicativi ed agli utenti direttamente connessi

(Amministratori, operatori) per accedere alle risorse hardware ed al file system.

I S.O. sono composti da un blocco più “interno”, denominato kernel (nocciolo, gheriglio

della noce), che gestisce direttamente le risorse hardware e da una shell (guscio) che

costituisce l’interfaccia dei programmi e degli utenti con il kernel.

Il S.O. risiede normalmente sull’Hard Disk del computer.

Il BIOS (Basic Input/Output System) e il Bootstrap

All’accensione del computer si ha la seguente situazione di stallo:

la memoria centrale (RAM) non contiene alcun programma e alcun dato perché

è volatile;

Versione 1.0 (3/5/2004) Pagina 21 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

i programmi necessari ad avviare il computer (che sono parti del sistema

operativo) risiedono sull’Hard Disk;

il processore (CPU) non può eseguire i programmi sull’Hard Disk perché

quest’ultimo è troppo lento per lui; può dialogare solo con la RAM, ma questa è

vuota;

il sistema non può partire.

Per superare questa impasse, è stato ideato il BIOS (Basic Input/Output System =

Sistema di input/output di base). Il BIOS è un programma che risiede sulla ROM, al

quale il microprocessore cede il controllo all’accensione del computer. Il BIOS

dapprima effettua il test di tutti i componenti hardware, quindi carica in memoria

centrale le parti del S.O. indispensabili ad avviare il computer.

L’operazione di avviamento tramite BIOS si chiama Bootstrap (è un anello attaccato

alla parte superiore di uno stivale, utile per tirarlo verso l’alto e calzarlo), perché risolve

l’impasse descritta sopra, ricordando l’inverosimile capacità del mitico Barone di

Munchhausen di sollevarsi dalle acque del mare tirandosi per gli anelli degli stivali.

Il BIOS costituisce inoltre l’interfaccia di basso livello tra il S.O. e i singoli componneti

hardware. E’ il BIOS che si occupa dei dettagli del colloquio con i dispositivi hardware

e che si adatta ai cambiamenti di questi ultimi.

Il BIOS è una parte integrante del computer, come l’hardware, perchè risiede sulla

ROM ed è quindi preistallato sulla scheda madre. Per questo motivo il BIOS viene

chiamato firmware (roba salda, stabile).

Il File System

Lo spazio su disco è una delle più importanti risorse hardware che il S.O. deve gestire e

far condividere ai processi. Ciascuna applicazione ha necessità di memorizzare sul disco

i programmi che dovrà eseguire quando viene attivata ed i dati utilizzati. Inoltre, gli

utenti hanno la necessità di memorizzare i propri dati (ad esempio, documenti).

Il S.O. organizza lo spazio su disco secondo una struttura gerarchica ad albero composta

da una directory (Cartella) root (radice) e da directory che via via si ramificano da

questa, le quali contengono i singoli file corrispondenti ai singoli programmi esecutivi o

ai singoli documenti. Questa organizzazione si chiama File System (sistema di file).

E’ compito del S.O. gestire l’aggiornamento delle directory e dei file nel File System,

consentendo di creare, modificare e cancellare file ed intere directory secondo le

richieste dei programmi applicativi e degli utenti, facilitate tramite un’interfaccia.

Sistemi Operativi ed Architetture

I S.O. svolgono ruoli diversi in dipendenza delle diverse architetture dei sistemi

informatici.

Inizialmente, esisteva una sola architettura, detta Mainframe, la cui caratteristica

fondamentale è la monoliticità. In questa architettura, un grosso elaboratore centrale,

detto appunto Mainframe, effettua tutte le elaborazioni, mentre i terminali di accesso

periferici sono definiti “stupidi”, in quanto non sono in grado di effettuare elaborazioni

Versione 1.0 (3/5/2004) Pagina 22 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

in proprio, ma si limitano a dialogare con l’unità centrale, inviando gli input digitati da

tastiera e riversando gli output ricevuti su video o su stampante.

In questa architettura monolitica, il S.O. del Mainframe gestisce tutto, mentre i terminali

stupidi non hanno bisogno di un S.O. perché privi di risorse proprie.

Negli anni ’80 si è diffusa una nuova architettura, oggi dominante, denominata

Client/Server. In questa architettura sia l’elaboratore centrale (Server), che quelli

periferici (Client) sono dotati di proprie risorse e svolgono proprie elaborazioni. Ciò che

cambia è il ruolo. Il Server in genere detiene la basi-dati e le logiche applicative, che

sono comuni a tutto il sistema. Il Client effettua localmente le elaborazioni di interfaccia

e di logica locale, sgravando le linee di comunicazione da un traffico pesante e

ripetitivo.

In questa architettura, sia il Server che il Client hanno la necessità di un S.O., perché

entrambi detengono risorse e svolgono processi, ma il ruolo è diverso. I S.O. Server

sono più complessi, supportano hardware più potenti (multiprocessore) e gestiscono la

concorrenza di molti utenti. I S.O. Client sono più semplici ed orientati prevalentemente

al singolo utente.

Sistemi Operativi Client

Il S.O. Client di gran lunga più diffuso al mondo e Microsoft Windows, giunto alla

versione XP. Il suo vantaggio principale sta nella semplicità d’uso, dovuta anche

all’ottima interfaccia grafica. Il punto debole principale dei sistemi Windows è sempre

stata la stabilità, ossia la capacità di funzionare a lungo senza bloccarsi anche sotto un

utilizzo gravoso. L’attuale versione XP sembra comunque molto migliorata sotto questo

aspetto.

I sistemi Windows sono eredi del S.O. montato sul primo PC IBM, e cioè Microsoft

DOS (Disk Operating System = Sistema operativo a dischi). Questo sistema, che

utilizza un’interfaccia a caratteri, ha sempre posto problemi di difficoltà d’uso per i

neofiti.

Tra gli altri S.O. Client è opportuno citare il sistema Linux, di cui si parlerà più avanti,

anche se la sua diffusione nel settore dei Client è improbabile per la sua maggiore

complessità e la minore disponibilità di software rispetto a Windows.

Sistemi Operativi Server

Nel campo dei S.O. Server la situazione è più complessa. Microsoft Windows Server,

oggi giunto alla versione 2003, è uno tra i più diffusi, ma esistono numerosi competitor.

Una famiglia di S.O. Server che da sempre fa concorrenza a Windows è quella dei

sistemi UNIX. Lo UNIX originario nacque nei Bell Laboratories nel 1969, per offrire al

mercato, come suggerisce il nome, un S.O. unico e definitivo. In realtà, gli eventi

successivi hanno visto il disgregarsi di UNIX in numerosi S.O. proprietari, imparentati

ma incompatibili, che girano su hardware differenti, sponsorizzati dai relativi produttori

(Sun, IBM, HP, Digital, Sco/Intel, etc…).

Rispetto a Windows i sistemi UNIX sono più robusti, ma richiedono personale più

specializzato per l’utilizzo. Inoltre, l’alto costo dell’hardware necessario (almeno per

alcuni) e la frammentazione di versioni e standard ne limitano la diffusione.

Versione 1.0 (3/5/2004) Pagina 23 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

Un S.O. che invece sta vivendo da alcuni anni un vero e proprio boom di diffusione

nell’ambito Server, costituendo una seria minaccia allo strapotere di Microsoft, è Linux,

che, per la sua natura di fenomeno travolgente, che va al di là degli stessi confini

informatici, merita una trattazione a parte.

Linux e l’Open Source

Il 25/8/1991 uno studente universitario di Helsinki di nome Linus Torvalds pubblicò

uno storico messaggio su un forum dedicato agli utenti del S.O. Minix (un S.O. tipo

UNIX sviluppato per fini didattici per il processore Intel 8086, lo stesso su cui era

basato il primo PC IBM). Il messaggio diceva:

Hello everybody out there using minix -

I'm doing a (free) operating system

(just a hobby, won't be big and professional

like gnu) for 386(486) AT clones.

La dichiarazione dai toni in sordina (just a hobby, won’t be big and professional like

gnu = solo un hobby, non sarà grosso e professionale come gnu) era destinata in realtà a

cambiare la storia dell’informatica. I motivi fondamentali erano:

Torvalds si apprestava a realizzare un S.O. di tipo UNIX per un processore (Intel

80386) che era in quel momento il processore più avanzato per PC e quindi anche il

più diffuso;

Torvalds utilizzò per il suo S.O. componenti del progetto GNU e ne adottò la

filosofia.

GNU (Gnu is Not Unix) è un progetto, avviato nel 1983 da Richard Stallman, un

professore del MIT, per lo sviluppo di un S.O. di tipo UNIX il cui codice, a differenza

degli altri S.O., non era tenuto gelosamente segreto, ma reso pubblico, con libertà per

ciascuno di copiarlo, modificarlo e ridistribuirlo. Il S.O. viene infatti distribuito con

licenza GPL (General Public License = Licenza pubblica generale), che consente agli

utenti non solo di leggere in chiaro il codice del software, ma addirittura di modificarlo,

se questi ritengono di essere in grado di migliorarlo. L’unica condizione imposta dalla

licenza GPL è che le eventuali modifiche siano anch’esse distribuite con licenza GPL,

in modo che altri possano modificarle e ridistribuirle e così via in modo ricorsivo (anche

la sigla GNU è ricorsiva).

Torvalds adottò la filosofia del progetto GNU e, con l’aiuto di un numero sempre

crescente di appassionati connessi da Internet in un unico gruppo di sviluppo mondiale,

sviluppò il kernel del nuovo S.O. che chiamò, dalla sintesi del suo nome di battesimo e

di UNIX, Linux. Linux, oltre ad essere di dominio pubblico e modificabile è anche

gratuito (condizione non implicita nella licenza GPL), anche se le sue distribuzioni

(kernel + shell + accessori) da parte di aziende specializzate (come Red Hat) hanno un

costo, se pur molto limitato (giustificato da extra e utility aggiunte). Il kernel è

scaricabile gratuitamente da Internet.

Ben presto l’idea di un software gratuito e di dominio pubblico si estese oltre i confini

dei S.O., abbracciando praticamente tutti i tipi di software e prendendo la

denominazione di Open Source (letteralmente sorgente aperto).

Versione 1.0 (3/5/2004) Pagina 24 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

Il fenomeno dell’Open Source si è abbattuto come un maglio sullo “statu quo”

dell’industria informatica. Basti pensare a come Microsoft venda a caro prezzo le

proprie licenze software e conservi gelosamente in cassaforte i propri codici sorgente,

che ovviamente non sono modificabili, pena l’incorrere nelle sanzioni di legge. Inoltre,

la diffusione mondiale del software Open Source e l’entusiasmo degli sviluppatori che,

spesso solo per la soddisfazione personale di risolvere un “bug” o di migliorare una

funzionalità, si prestano gratuitamente ad intervenire sul software, ha creato una

situazione apparentemente paradossale. La risoluzione delle problematiche sui software

Open Source è più semplice e rapida di quella relativa ai software a pagamento, dove

spesso capita che il produttore non sia interessato a risolvere la problematica, perché gli

utenti coinvolti sono troppo pochi, perché riguarda una versione non più in commercio,

etc…

Di fronte a tale fenomeno, le grandi aziende informatiche hanno reagito con strategie

diverse. Microsoft è rimasta acerrima nemica dell’Open Source, considerandolo una

minaccia alla propria esistenza e sostenendo che comunque i suoi costi sono superiori a

quelli dei prodotti Microsoft, a causa della minore facilità d’uso che richiede maggiori

costi di formazione del personale. I concorrenti, come IBM, HP, etc… hanno invece,

dopo un periodo di incertezza, abbracciato il S.O. Linux, creandone distribuzioni

personalizzate per i propri Server ed usandolo come arma per limitare lo strapotere di

Microsoft. SCO, produttrice di un S.O. di tipo UNIX per processori Intel e quindi

fortemente danneggiata dal fenomeno Linux, ha invece avviato una causa contro lo

stesso concetto di GPL, che secondo questa azienda viola i diritti di copyright.

Oggi il S.O. Linux si diffonde sempre di più sui Server di tutte le aziende ed ha anche

ottenuto importanti riconoscimenti presso la Pubblica Amministrazione europea, che, in

un numero sempre maggiore di casi, lo ha adottato come standard di preferenza.

I traduttori

Il software di sistema comprende altre tipologie di programmi, che si affiancano e

completano i S.O. Tra questi vi sono i programmi traduttori.

Tutti i programmi che girano su un computer sono una lista di istruzioni che vengono

eseguite dal processore. Affinché il processore sia in grado di comprendere le istruzioni,

queste devono essere codificate nel linguaggio del processore, detto linguaggio

macchina. La lista di istruzioni scritte in linguaggio macchina si chiama codice

eseguibile, perché è immediatamente eseguibile dal processore.

Il linguaggio macchina consiste di una serie di istruzioni espresse come codici

esadecimali. E’ estremamente difficile per un essere umano programmare nell’astruso

linguaggio macchina e, se questa fosse l’unica possibilità, solo un ristretto numero di

tecnici altamente specializzati sarebbe in grado di scrivere programmi (come avveniva

agli albori dell’informatica).

Per facilitare il compito dei programmatori sono stati inventati linguaggi più vicini

all’uomo, che in genere fanno uso di parole inglesi e di costrutti logico-matematici

(come if-then-else). Tramite questi linguaggi, detti evoluti (ne esistono moltissimi, tra i

più diffusi possiamo citare Cobol, Basic, C, Java), i programmatori scrivono un codice,

detto sorgente, che non è direttamente comprensibile dal processore. Programmi

Versione 1.0 (3/5/2004) Pagina 25 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

specializzati, detti traduttori, convertono il codice sorgente scritto nel linguaggio

evoluto in linguaggio macchina, producendo il codice eseguibile.

Esistono due strategie di traduzione e due categorie di traduttori:

I compilatori: agiscono prima dell’esecuzione del programma, in una fase che si

chiama compilazione; essi traducono il codice sorgente di un intero programma in

codice eseguibile (detto compilato) e lo ottimizzano tenendo conto delle eventuali

ricorrenze di istruzioni, ridondanze, ingenuità del programmatore; il codice

eseguibile viene poi eseguito come se fosse stato scritto all’origine in linguaggio

macchina;

Gli interpreti: agiscono direttamente durante l’esecuzione del programma,

traducendo un’istruzione alla volta dal linguaggio evoluto al linguaggio macchina;

quindi l’istruzione tradotta viene passata al processore per l’esecuzione.

Ciascuna strategia ha vantaggi e svantaggi. I compilatori sono in grado di ottimizzare la

traduzione perché hanno la visibilità contemporanea di tutto il programma, ma

richiedono una fase aggiuntiva di compilazione ogni volta che il programma viene

modificato anche in una sola istruzione.

Gli interpreti non richiedono la fase di compilazione, ma non sono in grado di

ottimizzare il programma perché ne vedono un’istruzione alla volta.

I programmi di utilità

Il software di sistema comprende anche una serie (sempre più articolata e complessa

con l’evolversi dei S.O.) di programmi che svolgono funzioni accessorie, detti

programmi di utilità.

Ne esistono moltissimi, per gli scopi più vari. Tra i più importanti si citano:

Le utilità di back-up (appoggio, sostegno), che permettono di salvare il

contenuto dei dischi su supporti rimovibili (dischi ottici) o su altri computer addetti

allo scopo e di ripristinarli (restore = ripristino) in caso di necessità (ad esempio

guasto irreparabile del disco fisso);

Manutenzione del disco fisso: controllo dello stato di frammentazione,

deframmentazione, settori danneggiati, etc…

Impostazione delle caratteristiche di rete del computer: indirizzi, protocolli,

connessioni, etc…

Monitoraggio dei processi in corso e loro amministrazione;

Gestione delle periferiche, soprattutto stampanti;

Esecuzione di file multimediali;

Guida on-line del sistema operativo.

Versione 1.0 (3/5/2004) Pagina 26 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

3.2 Il software applicativo

Il software applicativo è deputato a realizzare le funzionalità richieste dagli utenti. E’ il

software che fa qualcosa di utile dal punto di vista dell’utente.

Può essere classificato in due grandi categorie:

Software applicativo standard;

Software applicativo dedicato.

Il software applicativo standard

Il software applicativo standard copre esigenze diffuse e comuni a vaste categorie di

utenti. Esso viene quindi realizzato sulla base di specifiche ricavate dalla conoscenza

generale della problematica, fornita da esperti del settore, o da indagini di mercato.

Viene in genere offerto in vendita in configurazioni standard, dette pacchetti applicativi,

che sono valide per la grande maggioranza degli utenti e che sono spesso

personalizzabili dall’utente stesso per coprire eventuali esigenze residue.

In base all’ampiezza della categoria di utenti a cui il software standard si rivolge, esso

può essere ulteriormente suddiviso in tre sottocategorie:

Il software standard generico si rivolge praticamente a tutti gli utenti, coprendo

esigenze di base di quasi tutte le categorie lavorative; comprende i cosiddetti

software di produttività individuale, che supportano il lavoro di ufficio del singolo

impiegato, (elaboratori di testo, fogli elettronici, etc…, come ad esempio la suite

Microsoft Office), i software di elaborazione grafica (come Adobe Photoshop), i

database (come Access, Oracle, etc…);

Il software standard specifico si rivolge a categorie di utenti specializzate, ma

comunque diffuse pressoché in tutte le aziende; comprende le applicazioni per la

gestione della contabilità, per il CAD (Computer Aided Design), per la

pianificazione della produzione, etc…;

Il software di settore si rivolge a categorie specializzate che si trovano solo in

specifici settori aziendali; comprende, ad esempio, i sistemi per la gestione dei

trasporti, quelli per la gestione ospedaliera, etc…

Il software applicativo dedicato

Il software applicativo dedicato copre esigenze specifiche di un particolare cliente. Esso

viene quindi sviluppato su misura, in base alle specifiche ricavate dalle interviste

effettuate con i futuri utenti. Conseguentemente il suo costo è molto superiore a quello

del software standard e viene prodotto solo quando non è possibile o non è accettato dal

cliente l’utilizzo di un software standard, magari personalizzato.

Esempi di software dedicato sono i grandi sistemi di automazione degli aeroporti, quelli

di Help Desk e Call Center, etc…

Versione 1.0 (3/5/2004) Pagina 27 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

4 Le reti

Le reti sono il complesso di apparecchiature informatiche e di telecomunicazione

(computer compresi) interconnesse tra loro tramite mezzi di comunicazione.

Generalmente, tuttavia, quando si parla di rete, si fa comunemente riferimento alla parte

della rete che garantisce il collegamento tra i computer (escludendo questi ultimi).

Le reti consentono ai computer di scambiarsi messaggi e dati.

4.1 Tipologie di reti

La principale classificazione delle reti è la differenziazione tra reti locali e reti

geografiche.

Reti locali – LAN (Local Area Network)

Le reti locali (LAN) collegano i computer all’interno di uno stesso edificio o tra edifici

vicini appartenenti alla stessa area, ma comunque senza mai attraversare il suolo

pubblico.

Le reti locali possono avere diverse topologie:

ad anello, nelle quali i computer sono collegati da un anello chiuso; i computer

adiacenti si scambiano messaggi direttamente, gli altri indirettamente tramite quelli

intermedi;

a bus, nelle quali i computer sono collegati ad un cavo principale detto bus; i

messaggi veicolati dal bus vengono raccolti e scaricati solo dai dispositivi interessati

a quei messaggi, mentre gli altri dispositivi li ignorano; il nome deriva dall’analogia

con il comportamento degli autobus, che caricano e scaricano ad ogni fermata solo i

passeggeri interessati a quella fermata;

a stella, nelle quali i tutti computer sono collegati ad un’apparecchiatura centrale

che comunica singolarmente con tutti, facendo da tramite tra i computer;

a maglia, nelle quali tutti i computer sono collegati a due a due tra di loro,

offrendo una grande ridondanza di collegamenti.

Ciascuna tipologia ha vantaggi e svantaggi: per esempio a maggiore ridondanza e quindi

affidabilità corrispondono maggiori costi e complessità. Inoltre, alcune reti sono più

adatte di altre a particolari edifici e collegamenti.

Versione 1.0 (3/5/2004) Pagina 28 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

Figura 5 – Topologie di reti locali (LAN)

Inoltre le reti locali possono utilizzare diversi standard tecnologici, sui quali si basa la

trasmissione fisica del segnale. I più importanti sono:

Token Ring (anello a gettone), utilizzato nelle reti ad anello; i computer che

vogliono trasmettere un messaggio lo inseriscono nell’anello insieme ad un

“gettone” (una stringa di bit); quando il computer destinatario preleva il messaggio,

rimuove il gettone comunicando così l’avvenuto recapito del messaggio;

Ethernet (da ether = etere, la sostanza che si riteneva pervadesse l’universo e

consentisse la trasmissione della luce prima che Einstein formulasse la relatività

ristretta; secondo gli inventori, la trasmissione dei segnali via cavo era analoga alla

trasmissione della luce nell’etere); la rete Ethernet trasmette i segnali a 10 Mbps

(Mega bit per secondo), utilizzando cavi coassiali o il doppino telefonico.

Oggi le reti locali più utilizzate sono a stella (con eventuali sotto stelle) basate su

standard Ethernet.

Versione 1.0 (3/5/2004) Pagina 29 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

Si vanno lentamente diffondendo le reti locali WLAN (Wireless LAN = LAN senza

fili), dove il mezzo di trasmissione sono le onde elettromagnetiche trasmesse secondo

uno standard della famiglia 802.11x, detto comunemente Wi-Fi (Wireless Fidelity =

Fedeltà senza fili). Queste reti permettono il collegamento dei computer all’interno di

un’area delle dimensioni di un edificio, senza bisogno di collegamenti fisici e

consentendo lo spostamento anche continuo dei computer.

Le reti Wi-Fi sono ideali per gli edifici a tutela storica ed artistica, dove non è

consentito praticare fori o lasciare canalette in vista. Sono inoltre ideali per utenti dotati

di PC portatili, che hanno la possibilità di connettersi semplicemente entrando nell’area

servita dal Wi-Fi. Tra gli svantaggi, si segnala la maggiore difficoltà di garantire la

sicurezza della rete, visto che i dati viaggiano per etere e l’inevitabile “inquinamento

elettromagnetico”, visto che è molto difficile adattare la portata della rete alla geometria

dell’edificio o del locale servito. Molti locali pubblici (aeroporti, hotel, fast food,

supermercati) soprattutto negli Stati Uniti offrono un servizio Wi-Fi per la connessione

ad Internet, gratuito o a pagamento, ai propri clienti. Questi siti sono noti come “Hot

Spot” (Punti Caldi).

Un’altra tipologia di rete wireless ad onde elettromagnetiche, è quella basata sulla

tecnologia Bluetooth. Questa tecnologia supporta piccole reti locali a corto raggio (max.

10 metri) ed è oggi utilizzata principalmente per la connessione wireless di dispositivi

diversi che si trovano nella stessa stanza o in stanze adiacenti, come PC, stampanti,

palmari, telefoni cellulari, etc…

Infine, esiste un’altra tecnologia wireless basata sui raggi infrarossi, la quale supporta

piccolissime reti locali tra dispositivi allineati a vista, come PC e stampante, PC e

palmare, etc…

Reti geografiche – WAN (Wide Area Network)

Le reti geografiche (WAN) connettono gli elaboratori su vaste aree geografiche e sono

in genere integrate con le reti di fonia, o comunque messe a disposizione dagli stessi

gestori (ad esempio Telecom).

Dal punto di vista dell’esclusività, si distinguono reti condivise, che utilizzano la stessa

rete telefonica dove transita il traffico di fonia e reti dedicate, che utilizzano linee

riservate all’utente che usufruisce del collegamento (oggi poco usate).

Dal punto di vista della tecnologia, si distinguono linee analogiche e digitali. Le più

diffuse sono:

la classica linea telefonica analogica presente comunemente nelle case, costituita

dal doppino telefonico intrecciato con presa telefonica (tripolare, in disuso, o

l’attuale RJ-11); queste linee vengono utilizzate con un MODEM (MODulatore

DEModulatore), un apparecchio che converte i segnali digitali del computer in

segnali analogici per la linea telefonica e viceversa; il MODEM fornisce velocità di

trasmissione basse, fino a 56 Kbps (Kilo bit per secondo);

la linea digitale ISDN (Integrated Services Digital Network = Rete digitale di

servizi integrati), utilizzata da aziende e uffici, che trasmette voce e dati in formato

digitale sul doppino telefonico tramite un ISDN Adapter (Adattatore, detto

volgarmente “modem” ISDN); affinché due utenti possano comunicare occorre che

Versione 1.0 (3/5/2004) Pagina 30 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

entrambi abbiano una linea ISDN; la velocità supportata sale ad un massimo di 128

Kbps; oggi la diffusione di linee ISDN è in calo a favore delle linee xDSL;

la famiglia di connessioni digitali xDSL (Digital Subscriber Line = Linea

Abbonato Digitale); questa tecnologia innovativa consente trasmissioni di voce e

dati ad alta velocità sul doppino telefonico, purché l’utente si trovi vicino alla

centrale telefonica (last mile = ultimo miglio); inoltre la connessione dei dati è

sempre attiva, indipendentemente dall’utilizzo della comunicazione vocale

(telefonata); il principio della tecnologia DSL è quello di superare il collo di

bottiglia della trasmissione analogica che, essendo stata ideata per trasmettere la

voce, utilizza solo una ristretta banda dello spettro di frequenze supportate dal

doppino telefonico; DSL invece trasmette le informazioni digitalmente sfruttando

tutta la banda del doppino telefonico e separandola tra parte dati (di gran lunga

prevalente) e la parte voce; DSL può raggiungere una velocità massima di 6,1 Mbps

(Mega bit per secondo); richiede che l’utente istalli un DSL Adapter (volgarmente

chiamato “modem” DSL); esistono numerosi standard della famiglia xDSL; tra i più

diffusi citiamo:

o ADSL (Asymmetric DSL) è una tecnologia asimmetrica, che riserva una

banda molto più ampia al downstream (flusso da centrale a utente) rispetto che

all’upstream (flusso da utente a centrale); è ideale per la navigazione casalinga

su Internet, dove la mole dei dati in ricezione è molto più alta di quella dei dati

inviati; ADSL consente una velocità massima di 6,1 Mbps in downstream e 640

Kbps in upstream;

o HDSL (High bit rate DSL = DSL ad alto tasso di bit) è una tecnologia

simmetrica, che garantisce velocità fino a 2,048 Mbps in entrambe le direzioni a

costi relativamente bassi ed è sempre più diffusa presso le aziende.

Esistono inoltre altre tecnologie di rete geografica, che utilizzano mezzi diversi dal cavo

elettrico/telefonico: collegamenti via fibra ottica (il mezzo è la luce); collegamenti via

satellite (il mezzo sono le onde elettromagnetiche); collegamenti via ponti radio (il

mezzo sono ancora le onde elettromagnetiche), etc…

4.2 Elementi costituenti una rete

Indipendentemente dalla tipologia, gli elementi che costituiscono una rete sono sempre:

I nodi della rete;

Il mezzo di trasmissione della rete;

Le apparecchiature di rete;

I protocolli di comunicazione.

I nodi della rete

I nodi della rete sono i punti di connessione tra le tratte. Un nodo può essere:

terminale, nel qual caso si tratta di uno dei computer collegati;

Versione 1.0 (3/5/2004) Pagina 31 di 93

Ing. Michele Ficicchia Sistemi Informativi Aziendali

intermedio o di ridistribuzione, la cui funzione è quella di ricevere un

messaggio, riconoscere il destinatario e reinstradarlo verso quest’ultimo; in genere, è

un’apparecchiatura di rete (vedi sotto).

Perché un computer possa collegarsi in rete, costituendo un nodo terminale, deve

possedere un dispositivo di collegamento ed il relativo software.

La tipologia del dispositivo di collegamento dipende dalla tipologia di rete. Per il

collegamento ad una LAN, il computer deve disporre di una scheda di rete; se la LAN è

Wi-Fi, il computer deve disporre di una scheda 802.11b.

Per il collegamento ad una WAN esistono molte più possibilità. Il collegamento

potrebbe avvenire tramite una LAN intermediaria (come avviene nelle aziende), per cui

serve la classica scheda di rete. In caso di collegamento diretto alla rete telefonica, serve

un MODEM tradizionale se si utilizza la fonia tradizionale, un adattatore ADSL se si

utilizza questa tecnologia, uno ISDN per questi tipo di connessioni, etc…

Il mezzo di trasmissione della rete

Esistono numerosi mezzi di trasmissione fisici per le reti. Si citano:

Il cavo coassiale (come quello dell’antenna TV), utilizzato per le LAN Ethernet,

oggi in disuso;

Il doppino telefonico, utilizzato per le LAN e per le WAN basate sulla rete di