Documenti di Didattica

Documenti di Professioni

Documenti di Cultura

1.3 Ensayo

Caricato da

Miguel Angel Rv0 valutazioniIl 0% ha trovato utile questo documento (0 voti)

12 visualizzazioni8 pagineEs un ensayo sobre la IA

Titolo originale

1.3_Ensayo

Copyright

© © All Rights Reserved

Formati disponibili

DOCX, PDF, TXT o leggi online da Scribd

Condividi questo documento

Condividi o incorpora il documento

Hai trovato utile questo documento?

Questo contenuto è inappropriato?

Segnala questo documentoEs un ensayo sobre la IA

Copyright:

© All Rights Reserved

Formati disponibili

Scarica in formato DOCX, PDF, TXT o leggi online su Scribd

0 valutazioniIl 0% ha trovato utile questo documento (0 voti)

12 visualizzazioni8 pagine1.3 Ensayo

Caricato da

Miguel Angel RvEs un ensayo sobre la IA

Copyright:

© All Rights Reserved

Formati disponibili

Scarica in formato DOCX, PDF, TXT o leggi online su Scribd

Sei sulla pagina 1di 8

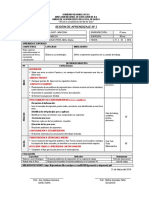

INSTITUTO TECNOLÓGICO SUPERIOR

DE ALVARADO - Campus Medellín

Materia:

Inteligencia Artificial

Semestre - Grupo - Sistema:

8° Semestre – “YM” – Escolarizado.

.

Producto Académico:

U1 – “Ensayo”.

Presenta:

Reyes Velázquez Miguel Ángel – 156Z0628.

Docente:

I.S.C. Francisco Fernando Mayorga Guittins

Fecha de Entrega:

13 – Febrero -2019

Medellín de Bravo, Ver. Feb. – Jun. 2018

Las grandes innovaciones para la inteligencia artificial en cuestión de educacion

son:

Meta-aprendizaje.

Modelos generativos aplicados a otros sectores.

Grandes avances en auto-aprendizaje en juegos.

Máquinas intuitivas resolviendo el reto de la semántica.

La imposible “explicabilidad”.

Incremento de estudios científicos en Deep Learning.

Nuevos entornos de aprendizaje profundo.

Cognición conversacional.

1.- Meta-aprendizaje

Aprender a aprender. Al dar capacidades de meta-aprendizaje, puede ser posible

que las máquinas mejoren continuamente sobre sí mismas, ya que podrán entender

el concepto de aprendizaje. Hasta ahora, el aprendizaje profundo se queda en el

entorno para el que se ha diseñado. Tenemos que crear la capacidad de que las

máquinas entiendan qué es aprender, para poder expandir sus fronteras más allá

de lo inicial.

Parece que el concepto del meta-aprendizaje va a ser una de las claves del año. El

problema es que estamos entrando en el farragoso mundo de comprender qué es

el lenguaje, qué es razonar, qué es aprender… lo cual puede que tampoco lo

tengamos muy claro los humanos. Y es que como ya os comentamos en otro

artículo, nuestros desarrollos en inteligencia artificial nos van a ayudar a

entendernos mejor a nosotros mismos.

2.- Modelos generativos aplicados a otros sectores

Los modelos generativos se van a aplicar en muchísimos nuevos campos.

Actualmente, la mayoría de las investigaciones se realizan en el campo de

generación de imágenes y voz. Sin embargo, veremos cómo estos métodos se

incorporan en herramientas que buscan modelizar sistemas complejos. Una de las

áreas donde se verá más actividad es en la aplicación del aprendizaje profundo a

modelos económicos.

3.- Grandes avances en auto-aprendizaje en juegos

Los juegos son un escenario perfecto para desarrollar la inteligencia. Tienen reglas

concretas, suponen competitividad para encontrar una estrategia ganadora y los

objetivos son claros, por lo que podemos medir la eficacia de las acciones.

La capacidad de AlphaGo Zero y AlfaZero para “aprender de cero” ha supuesto un

salto brutal en Inteligencia Artificial. Algunos opinan que está al mismo nivel de

impacto que el descubrimiento del propio aprendizaje profundo. La capacidad para

auto-aprender a jugar es el primer paso en el camino de desarrollar verdadera IA.

Es curioso, por cierto, que el equipo de DeepMind no tenga una palabra para esto,

pero otro grupo de investigación lo llama “ExIt“.

Como apuesta personal y que ya os avanzamos anteriormente, este año

probablemente veamos a la IA ganando a los humanos en el juego Starcraft, pero

también, no nos podemos olvidar, seguro que veremos la aplicación de esta

capacidad en otros recursos muy dispares, más allá de los videojuegos.

4. Máquinas intuitivas resolviendo el reto de la semántica

Digamos que hay dos tipos de caminos en IA: máquinas racionales y máquinas

intuitivas. Eran dos ramas de investigación diferentes, y desde luego se ha

avanzado mucho más en la primera. Ahora esperamos que los caminos de ambas

se encuentren.

La noción de la intuición artificial dejará de ser un concepto marginal y será una idea

más comúnmente aceptada en 2018. Entenderemos que la inteligencia no es sólo

razonar, si es que no nos habíamos dado cuenta aún, y experimentaremos en

profundidad con Procesos Duales mucho más complejos.

5.- La imposible “explicabilidad”

Las redes neuronales, así como todos los cada vez más complejos modelos que las

rodean, tienen un pequeño problema: son como una caja negra. Esto quiere decir

que cuando la máquina da una solución a un problema, es muy complicado conocer

cuáles son sus “razonamientos” para llegar a dicha solución. En parte porque no los

hay; pero sin ir a tecnicismos ni a cuestiones filosóficas, el problema es que no

podemos saber de la máquina su explicación para llegar a una respuesta. Puede

parecer que no importa, pero claro, cuando uno quiere aplicar IA a sus negocios,

necesita controlar muy bien por qué se están tomando unas decisiones y no otras.

Muchas investigaciones actuales buscan desarrollar métodos que permitan a las

máquinas explicar sus “razonamientos”, mostrar algún tipo de “informe” del proceso,

pero en esencia son trucos o engaños.

Muy probablemente, tengamos que vivir con esta incertidumbre, al menos por

muchos años. Las máquinas resolverán problemas cada vez más complejos pero,

en esencia, tendremos que vivir con la situación de no saber cómo.

6.- Incremento de estudios científicos en Deep Learning

El año pasado, sólo en la conferencia de Deep Learning ICLR, se presentaron unos

4000 papers. Se va a dar una paradoja en 2018 y es que para poder revisar todos

los artículos científicos sobre Deep Learning, vamos a necesitar aplicar Deep

Learning. No hay manera humana de revisar tanta información en tan poco tiempo.

Si queremos mantener el ritmo de investigación que demandan los científicos,

necesitamos a las máquinas para que nos ayuden.

Además, muchos de los papers son complejos, con matemática muy avanzada

detrás. Revisar y calificar estos estudios es muy difícil y requiere conocimientos

matemáticos que no todos los investigadores tienen.

Los estudios científicos en Deep Learning puede que se multipliquen por 3 o por 4

en el año 2018. ¿Podrá el Deep Learning entender y estudiar las investigaciones en

Deep Learning?

7.- Nuevos entornos de aprendizaje profundo

El camino hacia un desarrollo más previsible y controlado de los sistemas de

aprendizaje profundo pasa por el desarrollo de nuevos entornos de aprendizaje.

Los sistemas biológicos aprenden de la interacción con el medio ambiente; no

pueden aprender de forma aislada. Hemos estado desarrollando algoritmos de auto-

aprendizaje, como antes comentábamos, pero necesitamos entornos ricos de

experiencias, donde las máquinas puedan aprender de verdad por interacción.

El procedimiento de entrenamiento de aprendizaje profundo actual es uno de los

métodos de enseñanza más brutos que uno pueda imaginar. Se basa en la

presentación repetitiva y aleatoria de hechos sobre el mundo, con la esperanza de

que el estudiante (es decir, la red neuronal) sea capaz de desenredar y crear

suficientes abstracciones de ello. Ni los peores profesores nos han enseñado así.

8.- Cognición conversacional

Volvamos al objetivo de los desarrollos de alto nivel en inteligencia artificial:

buscamos una Inteligencia Artificial General. Este es un asunto que hemos tratamos

muchas veces en Puentes Digitales.

Para más inri, lo que nosotros entendemos por inteligencia es básicamente la

inteligencia humana, por lo que intentamos que las máquinas sean inteligentes, o

mejor dicho, humanamente inteligentes.

Sabemos que el lenguaje y la interacción conversacional es uno de nuestros pilares

de la inteligencia. De hecho, una discusión antropológica histórica es si el lenguaje

provocó nuestro aumento cognitivo o si nuestro aumento cognitivo derivó en

lenguaje.

Donde quiera que se encuentren los procesos y fenómenos socio-cognitivos del

desarrollo, el lugar para su descubrimiento es el contexto conversacional. Debemos

dar a las máquinas la capacidad de aprender por medio de la conversación. Hasta

ahora el Deep Learning aplicado a Chatbot se queda reducido, no hay un

aprendizaje cognitivo detrás y estamos perdiendo una oportunidad de oro. La

cantidad de información que pueden recopilar las máquinas por medio de la

conversación es enorme, sobretodo porque es una información muy rica. Nuestros

propios razonamientos, nuestra inteligencia, se plasma en palabras. Cuando

hablamos a Siri, Google o Alexa, podemos estar ayudándoles a aprender.

Algunos otros de los avances en cuestión de la Inteligencia Artificial va por parte de

IBM que ha mostrado su interés hacia ello.

Avances de la IA

1.- AI que realmente escucha lo que estás diciendo: IBM Research AI presentó

una nueva capacidad de máquina que comprende lo que escucha para contenido

argumentativo. Partiendo de nuestro trabajo en el Project Debater, esta

funcionalidad extiende las capacidades actuales de comprensión del habla de la IA

más allá de las simples tareas de respuesta a las preguntas, permitiendo a las

máquinas comprender mejor cuando las personas están haciendo argumentos.

2.- Si ha visto uno, los ha visto todos: los métodos de la IA de hoy en día a

menudo requieren miles o millones de imágenes etiquetadas para entrenar con

precisión un modelo de reconocimiento visual, IBM Research AI desarrolló un nuevo

método de aprendizaje de “pocos tiros” que puede reconocer con precisión nuevos

objetos desde un solo ejemplo, sin necesidad de datos adicionales. Esta capacidad

extiende la aplicabilidad de la IA a dominios restringidos por datos.

3.- El estudiante se convierte en maestro: dos cabezas son a menudo mejores

que una y lo mismo se puede decir de los agentes de inteligencia artificial. Este año,

los investigadores de IBM presentaron un marco y algoritmo de primera clase para

permitir que los agentes de inteligencia artificial aprendan a enseñarse unos a otros

y trabajen en equipo. Al intercambiar conocimientos, los agentes pueden aprender

significativamente más rápido que los métodos anteriores y, en algunos casos,

pueden aprender a coordinar dónde fallan los métodos existentes.

4.-Preguntas y respuestas: IBM Research AI ha detallado una mejora significativa

en los enfoques de respuesta a preguntas de dominio abierto (QA), con un nuevo

método que reordena y agrega evidencia a través de múltiples pasajes para producir

respuestas más precisas. El equipo ha logrado mejoras sustanciales con respecto

a los anteriores enfoques de vanguardia en conjuntos de datos de control de calidad

de dominio abierto públicos.

Confianza en la IA

1.- La batalla para eliminar el sesgo: dado que los sistemas de IA se utilizan cada

vez más para apoyar la toma de decisiones, es imperativo que los sistemas de IA

sean justos e imparciales. Sin embargo, eliminar el sesgo es un desafío, ya que los

datos utilizados para entrenar los sistemas de IA a menudo contienen correlaciones

institucionales y sociales intrínsecas que los métodos de aprendizaje estadístico

capturan y recapitulan. IBM Research AI construyó un nuevo enfoque para combatir

el sesgo, en el que los datos de entrenamiento se transforman para minimizarlo, de

manera que cualquier algoritmo de IA que luego se aprende, perpetuará la menor

inequidad posible. Al aplicar este método a dos grandes conjuntos de datos

públicos, nuestro equipo pudo reducir sustancialmente la discriminación, sin una

reducción significativa en la precisión del sistema.

2.- Desglosando la “caja negra”: las redes neuronales profundas son, en muchos

aspectos, cajas negras: incluso cuando una red llega a una decisión correcta, a

menudo es difícil entender por qué se tomó esa decisión. Esta falta de explicación

inherente presenta una barrera para la confianza del usuario en los sistemas de IA

y hace que sea difícil razonar acerca de los modos de falla potencial. Para abordar

estos problemas, los científicos de IBM Research AI desarrollaron una nueva

metodología de aprendizaje automático llamada ProfWeight, que investiga una red

profunda y construye un modelo más simple que puede alcanzar un rendimiento

similar al de la red original. En virtud de su complejidad reducida, estos modelos

más simples pueden proporcionar información sobre cómo funcionó la red original

y por qué tomó una decisión en lugar de otra. Al probar esta metodología en dos

conjuntos de datos masivos, el modelo ProfWeight fue capaz de producir decisiones

más explicables, al tiempo que mantenía un alto nivel de precisión.

3.- Anticipando ataques adversos: los modelos modernos de aprendizaje

automático pueden lograr una precisión de predicción sin precedentes, pero

también son sorprendentemente vulnerables a ser engañados por insumos

maliciosos cuidadosamente diseñados llamados “ejemplos adversos”. Por ejemplo,

un hacker puede alterar imperceptiblemente una imagen tal que un modelo de

aprendizaje profundo se engaña al clasificarlo en cualquier categoría que el

atacante desee. Cada día se desarrollan nuevos ataques de este tipo en una amplia

gama de tareas, desde el reconocimiento de voz hasta el procesamiento del

lenguaje natural. Como un paso clave para protegerse contra estos ataques, IBM

Research AI ha propuesto una nueva medida de robustez certificada y sin agresión

de ataques llamada CLEVER, que se puede utilizar para evaluar la robustez de una

red neuronal contra ataques. La puntuación de CLEVER calcula la “fuerza” mínima

de ataque necesaria para que un ataque pueda engañar a un determinado modelo

de red profunda, facilitando el razonamiento acerca de la seguridad de los modelos

de IA, y brindando instrucciones para detectar y defenderse contra ataques en

sistemas implementados.

Escalando la IA

1.- La precisión de 8 bits acelera el entrenamiento: los modelos de aprendizaje

profundo son extremadamente poderosos, pero entrenarlos requiere enormes

recursos computacionales. En 2015, IBM presentó un documento histórico que

describe cómo entrenar modelos de aprendizaje profundo con una precisión de 16

bits (la mitad de la precisión de 32 bits más utilizada normalmente) sin pérdida de

precisión. Los investigadores de IBM ahora han demostrado por primera vez la

capacidad de entrenar modelos de aprendizaje profundo con solo 8 bits de

precisión, al tiempo que conservan completamente la precisión del modelo en todas

las categorías principales de conjuntos de datos de IA, incluyendo imagen, voz y

texto. Estas técnicas aceleran el tiempo de entrenamiento para redes neuronales

profundas de 2 a 4 veces en los sistemas actuales de 16 bits. Aunque anteriormente

no se consideraba factible reducir aún más la precisión de la capacitación,

esperamos que nuestra plataforma de capacitación de 8 bits se convierta en un

estándar industrial ampliamente adoptado en los próximos años.

2.- El nuevo enfoque de la red neuronal en Bloque: BlockDrop, una nueva forma

de acelerar la inferencia en redes neuronales muy profundas, aprende a elegir qué

capas o “bloques” de la red profunda se deben omitir, reduciendo el cálculo total y

manteniendo la precisión. Usando BlockDrop, se obtiene un aumento de velocidad

de inferencia del 20% en promedio, llegando a un máximo de 36% para algunas

entradas, al tiempo que se mantiene la misma precisión de primer nivel en

ImageNet.

3.- Diseño al alcance: los investigadores de IBM desarrollaron una nueva técnica

de búsqueda de arquitectura neuronal que reduce el trabajo pesado requerido para

diseñar una red neuronal. El método define la repetición de patrones de arquitectura

neuronal denominados “neurocélulas”, que posteriormente se mejoran a través de

un proceso evolutivo. Esta evolución puede diseñar arquitecturas neuronales que

logran una precisión de predicción de vanguardia en las tareas de clasificación de

imágenes, sin intervención humana, en algunos casos alcanzando una aceleración

de hasta 50,000 veces en comparación con los métodos anteriores para la

búsqueda de arquitectura neuronal.

Por mucho que vimos avances importantes en 2018, sabemos que el próximo año

traerá aún más progreso para la industria de inteligencia artificial. Aquí hay tres

tendencias por las que estamos esperando:

1.- La causalidad reemplazará cada vez más las correlaciones: todo el mundo

sabe que el canto del gallo al amanecer no “causa” que salga el sol, y que a la

inversa, al encender un interruptor sí se enciende una luz. Si bien estas intuiciones

sobre la estructura causal del mundo son parte integral de nuestras acciones y

juicios cotidianos, la mayoría de nuestros métodos de inteligencia artificial actuales

se basan fundamentalmente en las correlaciones y carecen de una comprensión

profunda de la causalidad. Los métodos de inferencia causal emergentes nos

permiten inferir estructuras causales a partir de datos, seleccionar intervenciones

de manera eficiente para probar relaciones causales putativas y tomar mejores

decisiones aprovechando el conocimiento de la estructura causal. En 2019, se

espera que las técnicas de modelado causal emerjan como actores centrales en el

mundo de la IA.

2.- IA de confianza ocupará un lugar central: este año, varias organizaciones

respondieron a las violaciones de datos y las preocupaciones de privacidad del

consumidor mediante el establecimiento de juntas consultivas de ética y hemos visto

una mayor inversión en investigación en los “pilares de la confianza” (equidad

algorítmica, explicabilidad, solidez , transparencia), junto con mayores esfuerzos en

el despliegue de IA para el bien social. En 2019, comenzaremos a ver que estos

esfuerzos se vuelven fundamentales para la forma en que las compañías

construyen, entrenan y despliegan tecnologías de inteligencia artificial. Esperamos

ver un enfoque especial en la transferencia de avances de investigación en este

espacio a productos y plataformas reales, junto con un énfasis en fomentar la

diversidad y la inclusión en equipos técnicos, para garantizar que muchas voces y

perspectivas guíen el progreso tecnológico.

3.- Quantum podría brindar asistencia a la IA: en 2019 veremos una aceleración

de la tracción en la investigación y experimentación cuántica, y una nueva

investigación sobre cómo la computación cuántica puede potencialmente

desempeñar un papel en la capacitación y ejecución de modelos de IA. Un elemento

central de los algoritmos cuánticos es la explotación de espacios de estados

cuánticos exponencialmente grandes a través de enredos e interferencias

controlables. A medida que crece la complejidad de los problemas de la IA, la

computación cuántica, a la que miles de organizaciones ya están accediendo a

través de los servicios de computación cuántica en la nube de IBM, podría cambiar

la forma en que abordamos las tareas computacionales de la IA.

Potrebbero piacerti anche

- Características de Una Cámara de SeguridadDocumento12 pagineCaracterísticas de Una Cámara de SeguridadMiguel Angel Rv100% (1)

- Instituto Tecnologico Superior de Alvarado: Campus MedellínDocumento15 pagineInstituto Tecnologico Superior de Alvarado: Campus MedellínMiguel Angel RvNessuna valutazione finora

- BDU4Documento15 pagineBDU4Miguel Angel RvNessuna valutazione finora

- 1 - Temario - Conmutación y Enrutamiento en Redes de DatosDocumento15 pagine1 - Temario - Conmutación y Enrutamiento en Redes de DatosMiguel Angel RvNessuna valutazione finora

- 1 - Temario - Conmutación y Enrutamiento en Redes de DatosDocumento2 pagine1 - Temario - Conmutación y Enrutamiento en Redes de DatosMiguel Angel RvNessuna valutazione finora

- Investigacion Correlacional PDFDocumento1 paginaInvestigacion Correlacional PDFPaola PaniaguaNessuna valutazione finora

- PLAN de CLASE Razonamiento MatematicoDocumento3 paginePLAN de CLASE Razonamiento MatematicoCarlos Ramos LópezNessuna valutazione finora

- Ensayo, La Enseñanza Del Español.Documento10 pagineEnsayo, La Enseñanza Del Español.Esme HernándezNessuna valutazione finora

- MonografiaDocumento19 pagineMonografiaAlvaro QuispeNessuna valutazione finora

- Formación de Los Profesores Universitarios en Venezuela Rebeca CastellanoDocumento190 pagineFormación de Los Profesores Universitarios en Venezuela Rebeca CastellanoRo PardoNessuna valutazione finora

- Ceba PlanificacionDocumento6 pagineCeba PlanificacionHernán AndreaNessuna valutazione finora

- TP Asprea Aparato PsiquicoDocumento5 pagineTP Asprea Aparato PsiquicoNatalia PagliucaNessuna valutazione finora

- The Effect of Applying Humanoid Robots A.en - EsDocumento10 pagineThe Effect of Applying Humanoid Robots A.en - EsHugo HuaytaNessuna valutazione finora

- Aprender Con El "Método Del Caso" - JOHN S. HAMMONDDocumento7 pagineAprender Con El "Método Del Caso" - JOHN S. HAMMONDAngel Luis Ortega ArevaloNessuna valutazione finora

- Tema 3 Estilos de Aprendizaje y Enseñanza InstruccionDocumento13 pagineTema 3 Estilos de Aprendizaje y Enseñanza InstruccionguadaluperoderoNessuna valutazione finora

- Esquemas PlatonDocumento7 pagineEsquemas PlatonRobertoNessuna valutazione finora

- SESION 1 SegmentosDocumento6 pagineSESION 1 SegmentosKevin Peña OjedaNessuna valutazione finora

- Sesión de Aprendizaje 1ero 15 AbrilDocumento2 pagineSesión de Aprendizaje 1ero 15 AbrilEnrique Eduardo Yamunaque Rivas100% (1)

- Descripción Empírica de La Preocupación TemáticaDocumento11 pagineDescripción Empírica de La Preocupación TemáticaIrving Herrera Ortiz100% (1)

- El Método AxiomáticoDocumento2 pagineEl Método AxiomáticoRonny RosarioNessuna valutazione finora

- Formato de Clases Proyecto 2019-IiDocumento8 pagineFormato de Clases Proyecto 2019-IiCedeño Marco AntonioNessuna valutazione finora

- Las Teorías de La Pragmática y Como UtilizarlasDocumento9 pagineLas Teorías de La Pragmática y Como UtilizarlasceciliaNessuna valutazione finora

- La Filosofia ModernaDocumento5 pagineLa Filosofia ModernaAmemeNessuna valutazione finora

- Evolución de La LógicaDocumento29 pagineEvolución de La LógicaAdelmo Pérez62% (21)

- Creatividad ParcialDocumento5 pagineCreatividad Parcialandrea2412Nessuna valutazione finora

- Instrumentacion DidacticapanszaDocumento5 pagineInstrumentacion DidacticapanszaJorge Enrique Hernández AguilarNessuna valutazione finora

- Francisco Garcia Ayuso - El Estudio de La Filolofia en Su Relaciòn Con El SànscritoDocumento203 pagineFrancisco Garcia Ayuso - El Estudio de La Filolofia en Su Relaciòn Con El Sànscritoapi-3727317100% (1)

- Ensayo Filosofia de La PsicologiaDocumento7 pagineEnsayo Filosofia de La PsicologiaJulio Jin Ricaldi ArzapaloNessuna valutazione finora

- Ensayo Analisis Del DiscursoDocumento6 pagineEnsayo Analisis Del DiscursoMassy SerranoNessuna valutazione finora

- 5 - Salgado Andrade Los Estudios Del Discurso PDFDocumento40 pagine5 - Salgado Andrade Los Estudios Del Discurso PDFSoFia SalvadorNessuna valutazione finora

- Programas de Inteligencia 2Documento14 pagineProgramas de Inteligencia 2AlejandroNessuna valutazione finora

- Unidad 1 La Educación y Sus FundamentosDocumento56 pagineUnidad 1 La Educación y Sus FundamentosFelipe100% (3)

- Conceptos para Leer La Intervencion Rosa Maria Cifuentes (1) (3112)Documento25 pagineConceptos para Leer La Intervencion Rosa Maria Cifuentes (1) (3112)LauraNessuna valutazione finora

- Auto Diagnóstico ComunitarioDocumento135 pagineAuto Diagnóstico ComunitarioCandelarioManuelBriceñoNessuna valutazione finora

- Ruben Sierra Mejia - La Literatura y La FilosofíaDocumento17 pagineRuben Sierra Mejia - La Literatura y La FilosofíaJerzonFerchoNessuna valutazione finora