Documenti di Didattica

Documenti di Professioni

Documenti di Cultura

Cadena de Markov

Caricato da

Sergio OchoaCopyright

Formati disponibili

Condividi questo documento

Condividi o incorpora il documento

Hai trovato utile questo documento?

Questo contenuto è inappropriato?

Segnala questo documentoCopyright:

Formati disponibili

Cadena de Markov

Caricato da

Sergio OchoaCopyright:

Formati disponibili

Artculo Cientfico / Scientific Paper

CADENAS, MODELOS OCULTOS Y PROCESOS DE MARKOV

Chicaiza Julio Gustavo1, Ochoa Sergio Rafael2

Resumen

Abstract

En el presente trabajo analizamos la definicin

sobre las cadenas de Markov, y determinamos que

es un mtodo til para encontrar las probabilidades

de uno o varios eventos y dichos eventos son

dependientes de eventos anteriores, es decir un

evento futuro depender directamente del evento q

se suscit anteriormente, tambin conoceremos lo

que son modelos ocultos de Markov, esto nos puede

ayudar a alterar un evento, es decir por ejemplo en

un lanzamiento de un par de dados podemos cargar

dichos dados a nuestro favor ya que los estados de

este modelo oculto permanecen ocultos para el

observador, y por ultimo veremos los procesos de

Markov, que hace que la probabilidad de un evento

futuro se sepa o se defina si se sabe el estado actual.

Este trabajo nos ayudara a comprender la

importancia de dichos temas en estudio y tambin la

gran y amplia aplicacin que estos poseen.

In the present work we analyze the definition over

the Markov chains, and we determine that it is an

useful method to find the odds of one or several

events and said events depend upon previous

events, It is saying a future event the q will depend

directly on the event it took place previously, we

will also know what occult models of Markov, this

are it can help us to alter an event, that's to say for

instance in a throw of a couple of dice we can

charge the aforementioned dice on our behalf

since the states of this occult model stay in hiding

for the observer, and we will finally see Markov

processes, that it makes the probability of a future

event be known or define him if the present

condition is known. This work help us to

understand the importance of said themes under

consideration and also the great and ample

application that these have.

Palabras Clave: Cadenas de Markov, modelos, Keywords: Markov chains, models, processes,

event, future events, time.

procesos, evento, eventos futuros, tiempo.

1

2

Estudiante de Ingeniera Mecnica Automotriz- Universidad Politcnica Salesiana-sede Cuenca.

Estudiante de Ingeniera Mecnica Automotriz- Universidad Politcnica Salesiana-sede Cuenca.

1

Chicaiza et al /Cadenas, Modelos Ocultos y Procesos de Markov

modelos que existen; en el punto 5 definimos

los procesos de Markov; en el punto 6 tenemos

las conclusiones del trabajo realizado; punto 7

idea planteada relacionando los temas de

estudio con la propuesta de un trabajo futuro;

en el punto 8 encontramos las referencias

bibliogrficas de la informacin que se ha

citado en el presente trabajo.

1. Introduccin

En la actualidad la probabilidad y estadstica

abarca la gran mayora de aplicaciones, ya sea

a nivel acadmico, industrial, laboral, etc; esto

es por su funcionalidad, aplicacin lgica y

exacta, por dichas razones la probabilidad y

estadstica en nuestra carrera de ingeniera en

sistemas e ingeniera mecnica automotriz no

es la excepcin, es por eso que las cadenas,

modelos ocultos y procesos de Markov se

convierten en un mtodo de probabilidad para

determinar eventos futuros que dependen de

eventos actuales o anteriores, por ejemplo en la

aplicacin automotriz la probabilidad del

ndice de contaminacin del parque automotor

en los ltimos 5 aos dependern del

mantenimiento que se dio a dicho parque

automotor , tambin dependern del nmero

del parque automotor que se ha incrementado

en los ltimos 5 aos por lo que podemos

concluir que las cadenas de Markov estn

presentes en dicha aplicacin ya que el evento

de contaminacin es dependiente de los dos

eventos mencionados anteriormente. Por lo

que a continuacin analizaremos los conceptos

bsicos para comprender de qu se trata las

cadenas, modelos ocultos y procesos de

Markov.

2. Trabajos relacionados

La utilizacin de las cadenas de Markov abarca

varias aplicaciones ya sea en el rea industrial,

rea educativa, rea de ingeniera, etc; por lo

que a continuacin citamos algunas

aplicaciones de trabajos relacionados con

cadenas de Markov:

A continuacin presentamos los contenidos del

presente trabajo para que el lector tenga una

idea sobre los temas que este contiene y sea de

gran ayuda para que sintetice y pueda ubicar de

mejor manera los subtemas desarrollados en el

presente trabajo:

Cadenas de Markov aplicadas a la

evolucin de los usuarios potenciales

de energa fotovoltaica. [5]

Cadenas de Markov aplicadas al

diagnstico y tratamiento de conductas

y procesos de aprendizaje.[6]

Cadenas de Markov aplicada a la

composicin musical.[7]

Cadenas de Markov aplicadas a la

generacin de textos.[7]

Cadenas de Markov aplicadas a la

generacin de imgenes.[7]

3. Cadenas de Markov [1]

Para comprender de mejor manera lo que es

una cadena de Markov primero vamos a definir

lo que es un proceso estocstico.

Proceso Estocstico: Es un proceso que

evoluciona en el tiempo de una manera

probabilstica. Un proceso estocstico es una

coleccin indexada de variables aleatorias

parametrizadas por el tiempo.

En el punto 2 observamos que las cadenas de

Markov abarcan una gran aplicacin y

podemos cerciorarlo presentando trabajos

relacionados con los temas en estudio; en el

punto 3 definimos proceso estocstico,

definicion de cadenas de Markov y propiedad

de Markov; en el punto 4 definimos modelos

ocultos de Markov, 4.1 analizamos el modelo

oculto comparando con el modelo normal de

Markov, 4.2 anlisis de la arquitectura de los

modelos de Markov, 4.3 y 4.4 analizamos los

{} = {0, 1, 2, }

(1)

Donde Xt representa una caracterstica de

inters medible en el tiempo t. Por ejemplo

puede representar los niveles de inventario al

final de la semana t. Es una descripcin de la

2

Chicaiza et al /Cadenas, Modelos Ocultos y Procesos de Markov

relacin entre las variables aleatorias X0, X1,

X2,

4.1 Descripcin del modelo[2]

En un modelo de Markov normal, el estado es

visible directamente para el observador, por lo

que las probabilidades de transicin entre

estados son los nicos parmetros[3]

Una vez comprendido el concepto de proceso

estocstico podemos definir lo que es una

cadena de Markov:

Se llaman ocultos debido a que hay procesos

de probabilidad subyacente que no son

observables, directamente pero que afectan la

secuencia de eventos generados[2]

En la teora de la probabilidad, se conoce como

cadena de Markov a un tipo especial de

proceso estocstico en el que la probabilidad

de que ocurra un evento depende del evento

inmediatamente anterior.

Un HMM se caracteriza por un conjunto de

parmetros

En efecto, las cadenas de este tipo tienen

memoria, recuerdan el ltimo evento y esto

condiciona las posibilidades de los eventos

futuros. Esta dependencia del evento anterior

distingue a las cadenas de Markov de las series

de eventos independientes, como tirar una

moneda al aire o un dado. Estos modelos

muestran una estructura de dependencia

simple, pero muy til en muchas aplicaciones.

= (, , )

Propiedad de Markov: Conocido el estado

del proceso en un momento dado, su

comportamiento futuro no depende del pasado.

Dicho de otro modo, dado el presente, el

futuro es independiente del pasado

4. Modelos

Markov[2]

Ocultos

(2)

Matriz A. Matriz de transicin de

probabilidades.

Matriz B. Matriz de probabilidad de

salida.

Vector . Representa la distribucin

inicial de los estados.

4.2 Arquitectura de los HMM[2]

Esta arquitectura se da de acuerdo al nmero

de estados que lo componen y las transiciones

permitidas entre dichos estados. Los

principales modelos existentes son:

de

Un modelo oculto de Markov o HMM (por sus

siglas del ingls, Hidden Markov Model), es un

proceso por el cual se observa el

comportamiento del sistema de manera

indirecta pues los estados del mismo

permanecen ocultos para el observador.

Modelos de izquierda a derecha

Modelos ergdicos.

4.3 Modelos de izquierda a derecha[2]

Los elementos de la matriz de probabilidades

de transicin A deben cumplir la siguiente

condicin: aij = 0 j i , es decir , si en el

instante t, el modelo se encuentra en el estado

i-simo, en el siguiente instante de tiempo, t+1,

el modelo permanecer en el mismo estado con

probabilidad aii, o bien el modelo pasar al

estado j-simo (j>i) con probabilidad a ij. Esta

configuracin de la matriz de transiciones A da

lugar a modelos con arquitecturas que se

denominan de izquierda a derecha.

Figura 1. Modelo Oculto de Markov. [1]

Describen un proceso de probabilidad el cual

produce una secuencia de eventos simblicos

observables.

3

Chicaiza et al /Cadenas, Modelos Ocultos y Procesos de Markov

Por otra parte, si todas las posibles

realizaciones del proceso Markoviano son

funciones continuas del tiempo el proceso se

denomina proceso de difusin.

Para los procesos Markovianos se puede

definir una Probabilidad de transicin:

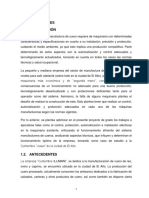

Figura 2. Modelo Oculto de Markov de izquierda a derecha.

[2]

(, ; , ) = ( = )|() =

Como se muestra en la figura, el estado 1

(estado inicial) y el 3 (estado final) se

denominan no emisores y las flechas en lneas

continuas indican las posibles transiciones

entre estados. Podemos notar la particularidad

de que las transiciones se dan solamente de

izquierda a derecha.

(5)

En el caso de cadenas de Markov, es posible

definir una matriz de probabilidades de

transicin:

. (, ) = () = |() =

(6)

6. Conclusiones

4.4 Modelos Ergdicos[2]

Concluimos que las cadenas de Markov se

puede definir como un mtodo o una manera

til y eficaz para encontrar las probabilidades

de un evento, tambin decimos que para

construir dichas cadenas debemos tomar en

cuenta que los procesos de Markov se

caracterizan por movimientos o transiciones

aleatorias.

Los modelos ocultos de Markov son muy tiles

y se puede sacar provecho de esto, ya que una

aplicacin de esto podemos encontrar en los

casinos, por ejemplo se pueden trucar o cargar

dados para alterar la probabilidad y beneficiar

al casino, esto se logra gracias a que los

procesos de probabilidad no son observables

para los jugadores.

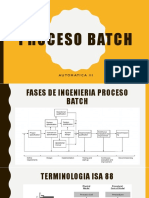

Figura 3. Modelo Oculto de Markov ergdico. [2]

Pueden evolucionar desde cualquier estado a

otro en un nmero finito de transiciones, todas

las transiciones son posibles.

5. Procesos de Marko[4]

7. Trabajo Futuro

Un proceso de Markov tiene la propiedad de

que la probabilidad de comportamiento futuro

est totalmente definida si se conoce el estado

actual. El conocimiento de estados previos al

actual no altera la probabilidad de

comportamiento futuro.

r () |(1) = 1, (2) = 2, . . . , () =

r () |(1) = ()

Las lneas de trabajos futuros siempre sern

dependientes con la probabilidad y estadstica

por sus mltiples aplicaciones, es por esta

razn que las cadenas de Markov podemos

aplicar para realizar un muestreo de los ndices

de contaminacin que emite el parque

automotor en la ciudad de Cuenca, se puede

realizar muestreos de contaminacin por

emisin de gases, y contaminacin por ruido

as podremos determinar el nivel de

contaminacin que existe en la ciudad de

Cuenca, para este trabajo futuro vamos a tener

(3)

(4)

Para cualesquiera t1, t2,.., tn

Si el conjunto de posibles estados del proceso

es numerable, el proceso recibe el nombre de

cadena de Markov.

Chicaiza et al /Cadenas, Modelos Ocultos y Procesos de Markov

O_CONVENCIONALES_CADENA_M

ARKOV.pdf?sequence=1

que aplicar los conocimientos adquiridos en el

presente trabajo sobre cadenas de Markov.

8. Referencias

[1] E. Guerrero, Cadenas de Markov

investigacin de operaciones [online].

Ingeniera,

2014.

Disponible

en:

http://es.slideshare.net/eddyguerrero05/ca

denas-de-markov-34726886

[2] M. Gmez, Modelos Ocultos de Markov

[online]. Educacin, Tecnologia, 2009.

Disponible

en:

http://es.slideshare.net/slidemarcela/model

os-ocultos-de-markov-1395263

[3] M. Cartuche, Modelos Oculto de Markov

Problemas de entrenamiento [online].

Julio,

2008.

Disponible

en:

http://es.slideshare.net/macartuche/model

os-oculto-de-markov-problemas-deentrenamiento

[4] Isa.cie.uva, Procesos de Markov [online].

Departamento de Ingeniera. Disponible

en:

http://www.isa.cie.uva.es/estudios/doctora

do/GA/Transpa_fab_avanzada_JGG.pdf

[5] A. Uranga, R. Luevanos, J. Gonzlez, F.

Cortes, C. vila, Ingeniera Industrial.

Actualidad y Nuevas Tendencias [online].

Artculo, Revista, 2011. Disponible en:

http://www.redalyc.org/pdf/2150/2150248

22003.pdf

[6] O. Senz, A. Gonzlez, Cadenas de

Markov aplicadas al diagnstico y

tratamiento de conductas y procesos de

aprendizaje

[online].

Educacin.

Disponible

en:

http://espacio.uned.es/fez/eserv/bibliuned:20379/

cadenas_markov.pdf

[7]

T.

Quiroz,

Aplicaciones

no

convencionales de cadena de Markov

[online]. Tesis, 2012. Disponible en:

http://tesis.pucp.edu.pe/repositorio/bitstrea

m/handle/123456789/1248/QUIROZ_MA

RTINEZ_TELMO_APLICACIONES_N

5

Potrebbero piacerti anche

- Metodo de Monte Carlo Con La Cadena de MarkovDocumento8 pagineMetodo de Monte Carlo Con La Cadena de MarkovSmith JamesNessuna valutazione finora

- Paper Cadenas de MarkovDocumento2 paginePaper Cadenas de MarkovPaul Cruz MermaNessuna valutazione finora

- Ta1 - Cadena-De-Markov-Lope-Belizario-Valdiviezo-U20181c870Documento21 pagineTa1 - Cadena-De-Markov-Lope-Belizario-Valdiviezo-U20181c870BelizarioValdiviezoRuizNessuna valutazione finora

- Taller 1 Oprimizacion Procesos MinerosDocumento9 pagineTaller 1 Oprimizacion Procesos MinerosJavierNessuna valutazione finora

- PID de Un Motor Eléctrico Realizado Por Henry Chamba ParraDocumento8 paginePID de Un Motor Eléctrico Realizado Por Henry Chamba ParraHenry Chamba ParraNessuna valutazione finora

- Simulación 1Documento6 pagineSimulación 1Lopex AndrexNessuna valutazione finora

- Función de PertenenciaDocumento10 pagineFunción de PertenenciaJohn River Macedo TolentinoNessuna valutazione finora

- Algoritmo de Conversión Mer-MrDocumento6 pagineAlgoritmo de Conversión Mer-MrAndres Jose Sachez DaleNessuna valutazione finora

- Investigación OperativaDocumento32 pagineInvestigación OperativaMarcos Bartra PerezNessuna valutazione finora

- InvestigaciónDocumento6 pagineInvestigaciónTefy PinoNessuna valutazione finora

- Columna de PlatosDocumento3 pagineColumna de PlatosDanielCarrascoNessuna valutazione finora

- Rojas Lazo OswaldoDocumento10 pagineRojas Lazo OswaldoDiegoCuestaNessuna valutazione finora

- Proyecto IA ChatBotDocumento14 pagineProyecto IA ChatBotAngel EdwinNessuna valutazione finora

- Fundamentos de Los Sistemas MecatrónicosDocumento34 pagineFundamentos de Los Sistemas MecatrónicosBenjamin ColemanNessuna valutazione finora

- Formato Ejemplo REQMDocumento16 pagineFormato Ejemplo REQMJose FarfanNessuna valutazione finora

- Informe Mallas y NodosDocumento6 pagineInforme Mallas y NodosCristian Lopez RivasNessuna valutazione finora

- Cadenas de MarkovDocumento20 pagineCadenas de Markovmaap73100% (1)

- Teoria Magnetostática y Conceptos de Circuitos MagnéticosDocumento15 pagineTeoria Magnetostática y Conceptos de Circuitos MagnéticosOmar RojasNessuna valutazione finora

- Syllabus FINAL OPTIMIZACIÓNDocumento5 pagineSyllabus FINAL OPTIMIZACIÓNManuel BaezNessuna valutazione finora

- Data Access ObjectDocumento6 pagineData Access Objectronald guerra olivaresNessuna valutazione finora

- Memoria de CalculoDocumento93 pagineMemoria de CalculoJavier RuedaNessuna valutazione finora

- 13 TK Gestion Analisis Riesgos Inspeccion TesisDocumento50 pagine13 TK Gestion Analisis Riesgos Inspeccion TesisENRIQUENessuna valutazione finora

- Definicion IO EtapasDocumento4 pagineDefinicion IO EtapasAna RiosNessuna valutazione finora

- Ejemplo Perfil Proyecto de GradoDocumento25 pagineEjemplo Perfil Proyecto de GradoRamiro Nina YujraNessuna valutazione finora

- Entregable 2 EVALDocumento11 pagineEntregable 2 EVALLibia NovoaNessuna valutazione finora

- Autodesk Inventor - Elemento FinitoDocumento1 paginaAutodesk Inventor - Elemento FinitoGustavo HernandezNessuna valutazione finora

- 4P Sistemas Electricos, Tren de Rodaje, ConfortDocumento16 pagine4P Sistemas Electricos, Tren de Rodaje, ConfortJose Luis Cantuña IzaNessuna valutazione finora

- Apuntes Modelos PDFDocumento42 pagineApuntes Modelos PDFGODINEZ RIOS ROBERTO JAIRNessuna valutazione finora

- Cap.5 AlcanceDocumento17 pagineCap.5 AlcancealejamarviNessuna valutazione finora

- Problema Programacion Secuenciacion PDFDocumento111 pagineProblema Programacion Secuenciacion PDFCarolina Carvajal HigueraNessuna valutazione finora

- Practica de Laboratorio 3Documento8 paginePractica de Laboratorio 3Federico Eduardo Rubio CarrascoNessuna valutazione finora

- Proyecto Sistemas de ControlDocumento31 pagineProyecto Sistemas de ControlLeonidas Isaac Mora PazánNessuna valutazione finora

- Todos Los CapitulosDocumento95 pagineTodos Los CapitulosennmanuelNessuna valutazione finora

- VOGUELDocumento4 pagineVOGUELCarlos Guillermo Quispe VeraNessuna valutazione finora

- Temario Curso JAVADocumento1 paginaTemario Curso JAVADaiNessuna valutazione finora

- Caso Therac 25Documento6 pagineCaso Therac 25Saúl PlazaNessuna valutazione finora

- Unidad III - CibernéticaDocumento105 pagineUnidad III - CibernéticaJose Rodriguez JaraNessuna valutazione finora

- Portafolio de Evidencias-Tema 1 - Grupo 4I1 - Tujeque AlexDocumento18 paginePortafolio de Evidencias-Tema 1 - Grupo 4I1 - Tujeque AlexLucas tejero100% (1)

- Trabajo de Laboratorio 3 Paradigmas de ProgramaciónDocumento2 pagineTrabajo de Laboratorio 3 Paradigmas de ProgramaciónLeonardo HerreraNessuna valutazione finora

- Taller de Proyecto de Software PMBOkDocumento33 pagineTaller de Proyecto de Software PMBOkIsmael AldereteNessuna valutazione finora

- Glosario Sobre Polimeros y CeramicosDocumento14 pagineGlosario Sobre Polimeros y CeramicosRomarioo ReyesNessuna valutazione finora

- Modelado de Operaciones 3Documento43 pagineModelado de Operaciones 3Delta BravoNessuna valutazione finora

- Diagrama de ClasesDocumento32 pagineDiagrama de ClasesLeiderNessuna valutazione finora

- Cadenas de MarkovDocumento10 pagineCadenas de MarkovFrancisco PerezNessuna valutazione finora

- Proceso BatchDocumento38 pagineProceso BatchSebastian PedrazaNessuna valutazione finora

- CE143 - S05 - Redes de Flujo - Algoritmo de Ford Fulkerson - 1Documento28 pagineCE143 - S05 - Redes de Flujo - Algoritmo de Ford Fulkerson - 1Kevin Carlos CastilloNessuna valutazione finora

- Metodo de Transporte. Investigacion de OperacionesDocumento41 pagineMetodo de Transporte. Investigacion de OperacionesAnonymous Tn6eOKbjsDNessuna valutazione finora

- AemsaDocumento38 pagineAemsaeloymaasturNessuna valutazione finora

- Libro Somerville 9Documento34 pagineLibro Somerville 9Said Pedraza100% (1)

- Propuesta de Investigación de Semillero Código PáginaDocumento4 paginePropuesta de Investigación de Semillero Código Páginamio normalNessuna valutazione finora

- Tesis de Tribologia PDFDocumento348 pagineTesis de Tribologia PDFJesusDiFabio100% (1)

- Simulacion (Eventos Discretos)Documento18 pagineSimulacion (Eventos Discretos)Edgar AmaroNessuna valutazione finora

- Semana 06 NGN GetDocumento60 pagineSemana 06 NGN Getdixiprica25Nessuna valutazione finora

- Conceptos Generales de Estructuras Mixtas FinalDocumento19 pagineConceptos Generales de Estructuras Mixtas FinalSony GonzalezNessuna valutazione finora

- Simulación Por Eventos Discretos PDFDocumento15 pagineSimulación Por Eventos Discretos PDFJoeAdamsArrietaNessuna valutazione finora

- CibernéticaDocumento30 pagineCibernéticaSnee Cg100% (1)

- Cadenas de MarkovDocumento9 pagineCadenas de MarkovMauricioNessuna valutazione finora

- Tarea 4.1 EnsayoDocumento12 pagineTarea 4.1 Ensayolupita sernaNessuna valutazione finora

- Introducción a las señales y sistemasDa EverandIntroducción a las señales y sistemasValutazione: 4.5 su 5 stelle4.5/5 (3)

- Splines (METODOS NUMERICOS)Documento3 pagineSplines (METODOS NUMERICOS)Sergio OchoaNessuna valutazione finora

- Los Tipos de Empresas Que Existen y Su ClasificaciónDocumento6 pagineLos Tipos de Empresas Que Existen y Su ClasificaciónSergio OchoaNessuna valutazione finora

- Informe MaquetaDocumento8 pagineInforme MaquetaSergio OchoaNessuna valutazione finora

- Biografía Breve de Don BoscoDocumento4 pagineBiografía Breve de Don BoscoSergio OchoaNessuna valutazione finora

- Azogueñita Linda GuambritaDocumento1 paginaAzogueñita Linda GuambritaSergio Ochoa50% (6)

- CINEMÀTICADocumento12 pagineCINEMÀTICASergio Ochoa0% (1)

- Azogueñita Linda GuambritaDocumento1 paginaAzogueñita Linda GuambritaSergio Ochoa50% (6)

- Azogueñita Linda GuambritaDocumento1 paginaAzogueñita Linda GuambritaSergio Ochoa50% (6)

- Ficha Tecnica Alarma Comunitaria GSM V6Documento6 pagineFicha Tecnica Alarma Comunitaria GSM V6Alejandro VélezNessuna valutazione finora

- Ejercicios Tema 5 MVDocumento3 pagineEjercicios Tema 5 MVSebastian BasantesNessuna valutazione finora

- Usos y Aplicaciones Del Spss 13Documento20 pagineUsos y Aplicaciones Del Spss 13Marco Arbulu0% (1)

- Ejemplos para Informatica II EPISDocumento46 pagineEjemplos para Informatica II EPISKever MallmaNessuna valutazione finora

- Exposición La EntrevistaDocumento12 pagineExposición La EntrevistaAndrea Camila Martinez HernandezNessuna valutazione finora

- Metodologia ScrumDocumento6 pagineMetodologia ScrumjorgeNessuna valutazione finora

- Guia Laboratorio Modelos y Requisitos RSADocumento67 pagineGuia Laboratorio Modelos y Requisitos RSApercytataje0% (1)

- Taller 1 Comercializacion de Productos TextilesDocumento14 pagineTaller 1 Comercializacion de Productos Textilesedna ramirezNessuna valutazione finora

- 2020 Ie 00000674Documento3 pagine2020 Ie 00000674diego carmonaNessuna valutazione finora

- Ejercicios Semana1Documento2 pagineEjercicios Semana1Ldr SayaNessuna valutazione finora

- Codeigniter PDFDocumento14 pagineCodeigniter PDFCarlos Bautista LaraNessuna valutazione finora

- 3-Sistemas de ArchivosDocumento14 pagine3-Sistemas de ArchivosjosebelandiaNessuna valutazione finora

- Instituto Tecnológico de Aguascalientes Proyecto SimulacionDocumento12 pagineInstituto Tecnológico de Aguascalientes Proyecto SimulacionKaren Pérez OlveraNessuna valutazione finora

- Deber Capa3 R1Documento3 pagineDeber Capa3 R1Danny A. PichuchoNessuna valutazione finora

- 01 Sistemas SCADA - Introducción Automatizacion IndustrialDocumento50 pagine01 Sistemas SCADA - Introducción Automatizacion IndustrialSantiago Duarte RiveraNessuna valutazione finora

- Guia 7 LabView 1 2018 1Documento3 pagineGuia 7 LabView 1 2018 1dhiuhfsdofNessuna valutazione finora

- Microsoft Word Practica 1Documento10 pagineMicrosoft Word Practica 1Pamela Astrid BarahonaNessuna valutazione finora

- Introducción A La DomoticaDocumento7 pagineIntroducción A La DomoticaAnthony A NavarroNessuna valutazione finora

- Analisis DesempeñoDocumento2 pagineAnalisis DesempeñoLuis CruzNessuna valutazione finora

- Emprendimiento PozoDocumento8 pagineEmprendimiento Pozomaritza lindaoNessuna valutazione finora

- Arreglos y Cadenas en CDocumento15 pagineArreglos y Cadenas en Cjohn kenneth vasquez vasquezNessuna valutazione finora

- Características de Un Actor de TeatroDocumento7 pagineCaracterísticas de Un Actor de TeatroRichard Matzar50% (2)

- DW5 GesDocumento329 pagineDW5 GesRichardQuilaleoDiazNessuna valutazione finora

- MCG 1600 Transmisor de Nivel Tipo RadarDocumento5 pagineMCG 1600 Transmisor de Nivel Tipo RadarDanny SánchezNessuna valutazione finora

- Laboratorio Nº2 de Control DigitalDocumento9 pagineLaboratorio Nº2 de Control DigitalBrayanCollazosSanchezNessuna valutazione finora

- Tabla de Procesos Criticos - SistemasDocumento4 pagineTabla de Procesos Criticos - SistemasFre CarvajalNessuna valutazione finora

- Ur10 User Manual Es PDFDocumento185 pagineUr10 User Manual Es PDFDaniel PérezNessuna valutazione finora

- CargadoresDocumento14 pagineCargadoresSuriel OlguinNessuna valutazione finora

- Matematicas Twist That BallonDocumento2 pagineMatematicas Twist That BallonDaniel PorrasNessuna valutazione finora

- Control de Lectura Sakanusoyin, Cazador de Tierra Del FuegoDocumento7 pagineControl de Lectura Sakanusoyin, Cazador de Tierra Del FuegoJazmin ToledoNessuna valutazione finora