Documenti di Didattica

Documenti di Professioni

Documenti di Cultura

Inf Bayesiana Binarios

Caricato da

hydra69Descrizione originale:

Copyright

Formati disponibili

Condividi questo documento

Condividi o incorpora il documento

Hai trovato utile questo documento?

Questo contenuto è inappropriato?

Segnala questo documentoCopyright:

Formati disponibili

Inf Bayesiana Binarios

Caricato da

hydra69Copyright:

Formati disponibili

Cap tulo 2

Inferencia bayesiana

Desarrollaremos a continuaci on las t ecnicas explicadas en el cap tulo anterior referentes a la estimaci on bayesiana para los modelos pr acticos m as habituales.

2.1.

An alisis bayesiano para datos binarios

En esta secci on desarrollaremos los rudimentos para el aprendizaje sobre proporciones. En nuestra pr actica diaria la utilizaci on de proporciones o porcentajes para clasicar en grupos una poblaci on cualquiera es muy habitual. B asicamente, una poblaci on es una colecci on de personas o unidades que son objeto de nuestra inferencia y supondremos que dicha poblaci on est a dividida en dos grupos que podemos referenciar como exitos y fallos. La proporci on de exitos, que denotaremos por , es nuestro par ametro de inter es, pero obviamente la proporci on de fracasos se deduce autom aticamente. Para aprender sobre el valor de esta proporci on, tomaremos datos. Se toma una muestra aleatoria de n individuos y supongamos que s exitos y f fallos aparecen en dicha muestra. Una manera inmediata (y que coincide con la estimaci on cl asica) de inferir s la tasa de exitos es considerar el cociente . Como veremos posteriormente, esn ta manera de proceder presenta serios inconvenientes en algunas situaciones. En el an alisis bayesiano, una vez observados los datos, toda la informaci on sobre la proporci on est a contenida en su distribuci on a posteriori. Esta distribuci on a posteriori puede resumirse de varias maneras. Uno puede estar interesado en un valor particular de que tenga una probabilidad alta bajo la distribuci on a posteriori, o su valor medio, o mediano o cualquier otra expresi on bajo alg un criterio de elecci on. Un segundo tipo de inferencia consiste en estimar mediante un intervalo que tenga una alta probabilidad de contenerlo y nalmente, tambi en podremos estar interesados en obtener las probabilidades a posteriori que ciertas conjeturas sobre el par ametro se hagan. Adicionalmente, uno tambi en puede estar interesa45

46

Inferencia bayesiana

do en aprender sobre futuras observaciones. Supongamos que tomamos una nueva muestra aleatoria, cu al ser a la probabilidad de que en esta nueva muestra hubiese t exitos y u fallos? Este planteamiento corresponde a un problema de predicci on t pico del an alisis bayesiano. Introducimos ahora un poco de formulaci on matem atica. En general, consideramos el caso en el que el par ametro de inter es es la probabilidad de un determinado suceso que se repite un n umero determinado de veces y cuyo resultado en cada prueba puede ser exito {1} o fracaso {0}. Las pruebas se consideran independientes unas de otras, teniendo todas la misma probabilidad de exito. Supongamos que existe un n umero n de pruebas, de esta forma tendremos una observaci on x que recoge el n umero de exitos. Matem aticamente se dice que la variable X que mide el n umero de exitos en n realizaciones del experimento se distribuye seg un una distribuci on Binomial de par ametros n y , que denotaremos por X B (n, ). La variable X por tanto puede tomar los valores 0, 1, ..., n. Por tanto, la expresi on que dene su verosimilitud (es decir, la informaci on de los datos observados) puede expresarse como: Pr(X = x|) = n x n! (1 )nx = x (1 )nx , x x!(n x)! x = 0, 1, . . . , n

(2.1) donde n! (se lee n factorial) vale n! = n (n 1) ... 3 2 1 y adoptaremos que 0! = 1. Esta distribuci on es muy usual en la pr actica actuarial y ya ha sido estudiada en profundidad en el cap tulo 6, secci on 6.4. Varias de sus medidas descriptivas de inter es son su valor medio y su varianza. En concreto, la media y la varianza de esta distribuci on son: E [X ] = n V [X ] = n(1 ) Adem as, tambi en puede probarse que su valor modal (es decir su valor m as frecuente) es: Moda[X ] = (n + 1) Observemos que en nuestro planteamiento el dato x ya habr a sido observado y por tanto nuestro inter es se centra en conocer la tasa de exitos. Es decir, de la expresi on anterior nos interesa s olo la parte que afecta al par ametro y por tanto podemos escribir la verosimilitud utilizando la notaci on de proporcionalidad como: L(x|) x (1 )nx Por abuso de la notaci on y puesto que la verosimilitud nos interesa como funci on del par ametro, en ocasiones escribiremos L() para referirnos a ella. En el desarrollo de los m etodos bayesianos para responder a los problemas de este tipo sobre proporciones, hay dos maneras b asicas de construir el conocimiento a priori

2.1. An alisis bayesiano para datos binarios

47

sobre el par ametro de inter es, . Los m etodos discretos en los que se considera que s olo puede tomar un posible valor de un conjunto nito de valores o los modelos continuos en los que se considera a valorada de manera continua en el intervalo (0, 1). En cualquiera de ellos, la informaci on a priori debe reejar la plausibilidad que cada uno de los valores del par ametro tiene para el experto.

2.1.1.

Datos binarios en el caso discreto

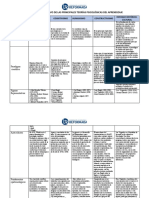

En esta secci on ilustraremos el aprendizaje sobre proporciones en el caso en que el par ametro venga expresado de forma discreta, es decir, tome un conjunto nito de valores. Mediante un ejemplo concreto entenderemos bien todo el proceso. Ejemplo 2.1 Una empresa aseguradora desea estimar el porcentaje de morosidad en una determinada cartera de gran dimensi on que tiene emitidas 10000 p olizas. El investigador encargado, teniendo en cuenta toda la informaci on disponible y su conocimiento sobre el funcionamiento interno de la empresa, considera que puede evaluar la morosidad mediante la siguiente distribuci on (a priori o inicial) de probabilidad asignada a cada porcentaje de morosidad susceptibles de ocurrir (b asicamente estos coinciden con los habidos hasta la fecha y cualquier otro que considere oportuno el investigador), tal y como se indica en la tabla 2.1: Tabla 2.1: Porcentajes de morosidad y probabilidades a priori Porcentajes de morosidad 0.01 0.02 0.03 0.04 0.05 0.06 0.10 Probabilidades (a priori) 0.12 0.30 0.28 0.15 0.12 0.02 0.01

El investigador se plantea si en el momento actual puede admitir la misma evaluaci on o modicarla, y decide obtener una muestra aleatoria de 5 p olizas entre los que encuentra m morosos. Estudiar c omo se proceder a para aprender sobre el porcentaje de morosidad de la entidad cuando se observaron m = 0 y m = 1, respectivamente. Soluci on: Veamos c omo debemos proceder para aprender sobre el porcentaje de morosidad. En primer lugar, la tabla anterior muestra la opini on actual del investigador sobre el sistema que est a inspeccionando. De ella se observa que para el lo

48 Tabla 2.2: C alculo de las verosimilitudes Porcentajes de morosidad 0.01 0.02 0.03 0.04 0.05 0.06 0.10 Probabilidades (a priori) 0.12 0.30 0.28 0.15 0.12 0.02 0.01

Inferencia bayesiana

Verosimilitud [m (1 )nm ] 0.951 0.904 0.859 0.815 0.774 0.734 0.590

m as frecuente es que el porcentaje de morosidad sea del 2 %(0,02) (corresponde con la mayor probabilidad a priori) y que en t ermino medio el porcentaje de morosidad es de 0,01 0,12 + ... + 0,10 0,01 = 0,0298, es decir, del 2,98 3 %. Habitualmente para asignar estas probabilidades (a priori) el experto puede tomar dos valores de referencia (m as y menos probable, por ejemplo) y a continuaci on asignar cada una de las probabilidades al resto de los valores mediante comparaci on con estos valores de referencia. Ahora necesitamos obtener la plausibilidad que cada uno de los datos observados tiene bajo cada uno de los posibles modelos considerados. Realizamos este ejercicio para el caso m = 0 y de forma an aloga se hace para cualquier otro resultado observado (de entre los seis posibles). En primer lugar, merece la pena observar que para cada valor de considerado tenemos un modelo de generaci on de los datos proveniente de la distribuci on Binomial con n = 5 y ese valor de , luego la verosimilitud (informaci on muestral) la podemos obtener sin m as que hacer: Verosimilitud m (1 )nm = 0,010 (1 0,01)5 = 0,995 = 0,951. An alogamente se procede con el resto de las cantidades, estos c alculos pueden hacerse de forma sistem atica y autom atica mediante una hoja de c alculo (tabla 2.2) El siguiente paso consiste en obtener los productos entre las a priori y las verosimilitudes (ver tabla 2.3). Observemos que esta nueva columna nos ha permitido obtener la predictiva asociada a la observaci on m = 0. Ahora basta con que dividamos cada elemento de esta u ltima columna por la predictiva para obtener las probabilidades a posteriori de cada tasa de morosidad posible (tabla 2.1.1). Como vemos nalmente, el investigador y una vez observada la muestra extra da tiene una nueva opini on sobre el sistema (que no necesariamente tiene que ser distinta a la inicial). En este caso, nuevamente el valor modal est a en el 2 %, con una media (a posteriori) del 2,48 2,5 % (vemos que la media ahora es ligera-

2.1. An alisis bayesiano para datos binarios Tabla 2.3: C alculo de los productos cruzados priori verosimilitud Porcentajes de morosidad 0.01 0.02 0.03 0.04 0.05 0.06 0.10 Probabilidades (a priori) 0.12 0.30 0.28 0.15 0.12 0.02 0.01 Verosimilitud [m (1 )nm ] 0.951 0.904 0.859 0.815 0.774 0.734 0.590 Predictiva =

49

Prob. Veros. 0.114 0.271 0.240 0.122 0.093 0.015 0.006 0.8615

Tabla 2.4: Obtenci on de las probabilidades a posteriori Porcentajes de morosidad 0.01 0.02 0.03 0.04 0.05 0.06 0.10 Probabilidades (a priori) 0.12 0.30 0.28 0.15 0.12 0.02 0.01 Verosimilitud [m (1 )nm ] 0.951 0.904 0.859 0.815 0.774 0.734 0.590

Prob. Veros. 0.114 0.271 0.240 0.122 0.093 0.015 0.006

Posteriori 0.132 0.315 0.279 0.142 0.108 0.017 0.007

mente inferior puesto que la no aparici on de morosos ha hecho que nuestra opini on sobre el ndice de morosidad ha sido modicada). De hecho, podemos armar que con una probabilidad del 96,6 % la tasa de morosidad es menor del 5 %. Es importante notar que con una muestra como esta en el an alisis cl asico la estimaci on de 0 la tasa de morosidad ser a de = 0 %. Obviamente la tasa de morosidad debe ser 5 baja, pero desde luego ning un actuario en ejercicio estar a dispuesto a asumir que dicha tasa es nula. Ejemplo 2.2 (Continuaci on ejemplo 2.1) Queda propuesto al lector realizar los c alculos para el caso m = 1 y comparar los resultados con los anteriores.

50

Inferencia bayesiana

2.1.2.

Datos binarios en el caso continuo: an alisis conjugado

Consideraremos ahora la situaci on m as realista en la que el par ametro (la proporci on en nuestro caso) puede tomar valores comprendidos entre 0 y 1 ( o 0 y 100 si hablamos en porcentajes directamente). Para comprender bien esta situaci on en comparaci on con la anterior debemos pensar que nos encontramos en un contexto en el que tendr amos innitos modelos, uno para cada valor de y tenemos que 0 1. Luego ahora lo u nico que nos diferencia del caso discreto son dos cosas fundamentales: la primera es que tendremos que sustituir la distribuci on de probabilidad a priori discreta por una continua, denominada funci on de densidad a priori, y la segunda, consecuencia de la anterior, es que sustituiremos los sumandos por integrales. Aunque como veremos a continuaci on los c alculos matem aticos necesarios en este caso son cerrados y los ejemplos posteriores utilizaremos el software FirstBayes para su realizaci on y visualizaci on gr aca. El an alisis bayesiano b asico recomienda utilizar densidades a priori que permitan c alculos exactos, es decir, que sean de f acil manejo matem atico y que puedan ser f acilmente asignables por el investigador. En el caso de proporciones, existe una familia particular de curvas, denominadas densidades Beta o tambi en Beta de primera especie, que como en el cap tulo 7dedicado a distribuciones continuas, notaremos como B e, que cumplen estas condiciones y que estudiaremos con detalle a continuaci on. Supongamos que es la proporci on de exitos y por tanto es un n umero entre 0 y 1 (corresponder a con el eje horizontal de la gr aca de una densidad). La expresi on de una densidad Be(, ) contiene potencias de (probabilidad de exito) multiplicada por potencias de 1 , de esta manera: 1 (1 ) 1 . Los valores de y deben ser n umeros positivos. Utilizando la notaci on del cap tulo 7 tendremos: () = ( + ) 1 (1 ) 1 , ()( ) 0 < < 1, , > 0. (2.2)

La distribuci on Beta es sucientemente exible como para recoger la mayor parte de las posibles creencias del experto. B asicamente, cualquier distribuci on unimodal acotada entre los valores [0, 1] ser a muy aproximada por una distribuci on Beta. Como vimos en las guras 7.2 y 7.3, las densidades Beta adoptan formas absolutamente distintas para diferentes valores de la par ametros. Un cat alogo completo de las formas y su relaci on con sus par ametros de las densidades beta puede obtenerse en Homberg (1991) y que resumidamente podemos ver en las siguientes gr acas. Ejemplo 2.3 (Interpretaci on de los diagramas de Homberg, 1991) En este ejemplo estamos interesados en estudiar c omo clasica de manera exhaustiva el procedimiento de Homberg (1991) recogido en las guras 2.1 y 2.2

2.1. An alisis bayesiano para datos binarios

51

Figura 2.1: Tipos de distribuciones Beta, Homberg (1991)

Figura 2.2: Clasicaci on de las distribuciones Beta en funci on de sus par ametros = x y = n x , Homberg (1991)

Soluci on: La interpretaci on de las guras extra das del trabajo de Homberg merece un poco de atenci on pues clasica de forma inmediata toda la clase de distribuciones Beta. En primer lugar, la gura 2.1 nos muestra y clasica (tipo A, B, C,...) las posibilidades gr acas de cada una de las densidades Beta en funci on de los valores de sus par ametros. En la gura 2.2, se relaciona dicha gr aca con los valores concretos de cada par ametro. En particular por ejemplo, j emosnos en la densidad Be(10, 1,5) que aparece en la gura ??. Pues bien, los valores de los par ametros para esta densidad son = x = 10 y = n x = 1,5 que observando

52

Inferencia bayesiana

en las guras 2.1 y 2.2 vemos que se corresponden con tipo F+ tal y como vemos en la gura 2.2 (se denota por A+ , B+ , etc. a las mismas representaciones gr acas tipo A, B, etc. pero asim etricas hacia la derecha). Es muy importante la interpretaci on que hacemos de las densidades a priori. B asicamente, una densidad a priori indica la plausibilidad que para el experto tienen cada uno de los valores del par ametro. De esta manera la densidad a priori sobre el par ametro recoge la opini on sobre dicho par ametro del experto, debiendo recoger de manera adecuada todos sus juicios. Un caso particular importante es Be(1, 1) tambi en denominada densidad uniforme, en la notaci on del cap tulo 7 la expresaremos por U (0, 1). Para este caso particular = 1 y = 1 y por tanto las potencias de la expresi on quedan: 0 (1 )0 = 1, es decir que la expresi on de la densidad Beta para el caso = = 1 es constantemente igual a 1 (y no depende del valor de ). Gr acamente se corresponde con una gr aca del tipo E en las guras anteriores. En nuestro lenguaje, esta densidad indica que el experto considera igualmente plausibles todos los valores del par ametro o equivalentemente se muestra indiferente ante cualquier valor de este, no tiene opini on sobre el. Este es un hecho muy importante, sobre el luego volveremos pues viene a decirnos que la no opini on tambi en puede modelizar como opini on. La densidad Beta por tanto est a relacionada con sus par ametros y en consecuencia es muy importante conocer varias de sus medidas descriptivas. En concreto, el conocimiento de la expresi on de la media, moda y varianza de la densidad Beta ser au til en el proceso de asignaci on de par ametros para la densidad a priori: , + 1 Moda = , + 2) Varianza = . ( + )2 ( + + 1) Media = La densidad a priori Beta viene denida por dos par ametros ( y ). Por lo tanto el experto deber a ofrecer informaci on acerca de dos momentos de la distribuci on a priori, por ejemplo mediamoda o mediavarianza, o cualquier otra combinaci on (tambi en pueden asignarse valores puntuales de la distribuci on). Actualizando nuestras opiniones C omo actualizamos ahora nuestro juicio sobre . Supongamos por tanto que hemos observado una muestra aleatoria de n individuos y que hemos obtenido s exitos y f = n s fallos o fracasos. La verosimilitud obtenida coincide con el caso discreto y esta es la informaci on de la muestra: Verosimilitud s (1 )f = s (1 )ns . (2.3)

2.1. An alisis bayesiano para datos binarios

53

Observemos que la verosimilitud es id entica en las concepciones cl asicas y bayesianas. El punto de vista bayesiano incorpora a la verosimilitud (informaci on de los datos) el juicio del experto. La concepci on cl asica no, basa toda su inferencia en la informaci on muestral y por tanto s olo utiliza para sus an alisis la funci on de verosimilitud. Pues bien, ya estamos en condiciones de actualizar nuestros juicios. El teorema de Bayes nos dice c omo debemos combinar ambas fuentes de informaci on. ametro de inter es sobre el que deseamos hacer Teorema 2.1 Sea (0, 1) un par inferencia. Supongamos que para asignamos una densidad a priori B e(, ) y que en una muestra de tama no n se han observado s exitos de acuerdo a una verosimilitud de tipo Binomial, B(n, ). Entonces, la densidad a posteriori de observados los datos x, (|x), es tambi en una densidad Beta, B e( + s, + n s). Adem as la distribuci on predictiva de una futura observaci on es una BetaBinomial. Demostraci on: De acuerdo al Teorema de Bayes, multiplicando la densidad a priori por la verosimilitud tenemos, 1 (1 ) 1 s (1 )ns = +s1 (1 ) +ns1 . (2.4)

y como vemos esta expresi on corresponde a otra densidad Beta, en la que el papel de le corresponde ahora a + s y el de le corresponde a + f. Es decir, la actualizaci on de una densidad a priori Beta, B e(, ), cuando se han observado s exitos y f fallos, corresponde a otra densidad Beta, B e( + s, + f ). Calculemos ahora la distribuci on predictiva de una futura observaci on z :

1

p(z|x) =

0

f (z|) (|x)d = =

n ( + + n) z ( + s)( + n s)

1 0

+s+z (1) +ns+nz d

( + s + z)( + 2n s z) n ( + + n) , ( + + 2n) z ( + s)( + n s)

expresi on que se corresponde con una distribuci on Beta-Binomial. En denitiva bajo un proceso de muestreo Binomial (o equivalentemente de tipo Bernoulli) la familia de distribuciones a priori Beta cumple la propiedad de que sus distribuciones a posteriori asociadas son tambi en de tipo Beta. A esta propiedad se le distingue diciendo que la familia Beta es conjugada para un muestreo Binomial. Vemos como en el proceso de aprendizaje sobre la informaci on muestral dada por s y f se ha incorporado de manera inmediata. Veamos este comentario sobre la media a posteriori. En efecto, de la expresi on anterior para la media de una densidad Beta tenemos ahora que la media (a posteriori) ser a: +s . +s++f (2.5)

54 Escribiremos esta expresi on de la siguiente manera:

Inferencia bayesiana

+s s s =w + (1 w) =w + (1 w) , +s++f + s+f + n + . Lo importante es ver que la media a posteriori (es decir ++n nuestro juicio actualizado sobre la media) se ha formado como una combinaci on ponderada de la media a priori (media proveniente de los juicios del experto) s (informaci on proveniente de los datos). De nuevo se pone y la media muestral n de maniesto que el paradigma bayesiano es un compromiso entre los datos y el juicio inicial. Adem as esta expresi on nos permite analizar dos situaciones l mite: con w = 1. Caso de no informaci on muestral: n = 0. En tal caso la expresi on w vale 1 y por tanto la media a posteriori coincide con la a priori. Obviamente, si no hay informaci on adicional de los datos, mis juicios sobre el par ametro coincidir an con mis actuales (a priori) juicios. Caso de innita informaci on muestral: n . En este hipot etico caso de disponer de toda la informaci on posible de la poblaci on, el factor de ponderaci on w tiende a 0 y por tanto 1 w vale 1, y por tanto la media a posteriori coincide con la media muestral. Es decir, en situaciones en las que el tama no muestra es muy grande las estimaciones cl asicas (media muestral) y bayesianas (media a posteriori) coinciden. En general, podemos decir que cuando el tama no muestral es muy grande las estimaciones bayesianas y cl asicas no dieren sustancialmente (aunque obviamente s en la interpretaci on).

2.

Volvamos ahora sobre el caso no informativo a priori. Es decir, supongamos que deseamos comportarnos de manera cl asica y por tanto, deseamos que todo nuestro aprendizaje est e basado u nicamente en la informaci on de los datos. En efecto, tal y como vimos anteriormente, podemos tambi en plantear un an alisis bayesiano desinformativo, es decir, asumiendo carencia de conocimiento a priori acerca del par ametro de inter es. El propio Reverendo Thomas Bayes (1763) propuso el uso de la distribuci on uniforme para representar esta desinformaci on inicial. La distribuci on uniforme asignar a el mismo peso a priori para todos los posibles valores de entre 0 y 1. Laplace (1774) tambi en utiliz o esta distribuci on a priori. La distribuci on uniforme puede expresarse como indicando que la probabilidad de cada valor de es igual y, por tanto, proporcional a la unidad. () 1 B e(1, 1) U (0, 1). En este caso particular, la distribuci on a posteriori se obtiene por tanto como: (|x) s (1 )ns ,

2.1. An alisis bayesiano para datos binarios

55

que comparando con la densidad Beta vemos que se corresponde con una Beta de par ametros s+1 y ns+1 siendo s el n umero de exitos en n pruebas. Lo importante de esta situaci on es ver que en un contexto de desinformaci on, las decisiones nales se derivan de la a posteriori que coincide con las decisiones obtenidas a trav es de la verosimilitud (que es como toman las decisiones los cl asicos). Es decir, si deseamos obtener respuestas parecidas a la que dar a el an alisis cl asico debemos optar por una a priori no informativa. Se comprueba en este caso c omo la moda de la distribuci on a posteriori coincide con la estimaci on frecuentista m aximo veros mil. s+11 s = s+1+1+ns2 n Existen otras elecciones de densidades no informativas como la densidad Beta de par ametros nulos, Be(0, 0) (introducida por Haldane en 1931, estrictamente hablando no corresponde a una densidad Beta). La media de la distribuci on a posteriori empleando esta distribuci on a priori coincide con el estimador frecuentista: Moda = 0+s s = 0+s+0+ns n Veamos el ejemplo anterior de morosidad ilustrado ahora como un caso continuo. Media = Ejemplo 2.4 Consideremos el caso del ejemplo 2.1 abordado ahora como un problema continuo. Consideremos el caso de n = 5 y que no hemos observado impago en ninguna de las p olizas muestreadas. Para la informaci on del experto consideremos la media y moda deducidas del mismo ejemplo que val an respectivamente, 3 % y 2 %. Soluci on: En efecto, en primer lugar tenemos que el par ametro de inter es, la tasa de morosidad de la compa n a, ser a un par ametro que var a entre 0 y 1. Pues bien, debemos construir una densidad a priori Beta que reeje correctamente el juicio del actuario sobre el valor medio y modal. Para la asignaci on de una densidad Beta concreta debemos dar unos valores espec cos de y . Utilizando la relaci on entre la media y la moda y los valores de los par ametros anteriores podemos obtenerlo. En efecto, conocemos que: Media = = 0,03(3 %) + 1 = 0,02(2 %) +2 Resolviendo este sistema obtendremos los valores de y que se corresponden con los juicios iniciales del experto: Moda = = 0,03 + 0,03 0,97 = 0,03 0,97 0,03 = 0

56

Inferencia bayesiana 1 = 0,02 + 0,02 0,04 0,98 0,02 = 0,96

La soluci on de este sistema es = 2,88 y = 93,12. Ahora la aplicaci on directa del teorema anterior 2.1 nos permite obtener anal ticamente la distribuci on a posteriori. Tenemos que de una muestra de n = 5 p olizas no ha aparecido ning un moroso, es decir s = 0. Verosimilitud 0 (1 )5 (1 )5 , luego la densidad a posteriori ser a: Posteriori 1,88 (1 )97,12 , es decir, una densidad Beta: Be(2,88; 98,12). Ejemplo 2.5 (Resoluci on del ejemplo 2.4 con FirstBayes) Resolver el ejemplo 2.4 con FirstBayes y obtener gr acas de las cantidades de inter es. Soluci on: Utilizaremos en este ejemplo el software FirstBayes que nos permitir a realizar los c alculos necesarios. Un breve manual del programa puede consultarse en el Ap endice A. Basta entrar en el programa (haciendo doble click) y activar la opci on APL data entry en Options. Puesto que se trata de datos binomiales (0 y 1) en el apartado de Analyses iremos a su men u de Binomial sample. Autom aticamente nos pedir a en el margen superior derecho que introduzcamos la densidad a priori donde introduciremos el valor 2,88 en parameter p (que es su equivalente a ) y 93,12 en parameter q equivalente a . En la gura 2.3 podemos ver los valores obtenidos una vez que se pulsa Next. Una gr aca de esta densidad puede obtenerse f acilmente sin m as que pinchar en la opci on Plot, como muestra la gura 2.4. Una inspecci on de la gr aca anterior nos conrma los valores de la media y moda que hab amos asignado anteriormente. Pero tambi en nos da m as informaci on adicional. Por ejemplo, el investigador piensa que es altamente improbable encontrarse con una tasa de morosidad mayor del 10 % (gr acamente vemos que la densidad se aproxima a cero a partir de 0,10). En denitiva, el investigador considera que toda la tasa de morosidad se encuentra concentrada en valores menores del 10 % (como mucho del 12 % como puede apreciarse gr acamente). Ahora debemos incorporar la informaci on muestral. Aprovecharemos este ejemplo, sin embargo, para realizar tambi en los c alculos mediante FirstBayes pues nos permite realizar muchas m as inspecciones de la densidad a posteriori. Para ello, en primer lugar introduciremos los datos para obtener la a posteriori. Para ello debemos ir a la opci on Data y pulsando en New podremos introducir nuestros datos (pondremos nombre al nuevo chero y conviene poner una descripci on de qu e contiene para futuros accesos a este chero). Dicho chero contendr a cinco ceros pues han sido

2.1. An alisis bayesiano para datos binarios

57

Figura 2.3: Introducci on de la densidad Be(2,88; 93,12)

Figura 2.4: Gr aca de la densidad Be(2,88; 93,12)

las observaciones obtenidas (conviene grabar el chero para futuros accesos, para ello pulsar Save). En la gura 2.5 puede apreciarse el proceso realizado. Ahora volvemos al men u inicial pulsando en Quit. Para obtener la densidad a posteriori s olo nos queda actualizar la densidad a priori. Para ello, si observamos

58

Inferencia bayesiana

Figura 2.5: Introducci on de datos para el ejemplo 2.4

justo debajo de la a priori que acabamos de denir hay una pesta na denominada Data que actualmente est a en Nul. Si desplegamos esa pesta na podremos ver los cheros que tenemos disponibles para cargar. Cargaremos el chero datos_morosidad (gura 2.5). Realizada esta operaci on autom aticamente en la parte superior izquierda aparece la densidad a posteriori que se obtiene, que es la misma que la obtenida anal ticamente. Adicionalmente nos aporta varias de sus medidas descriptivas que son importantes: la media (a posteriori) vale 0.028515 (es decir, del 2,85 %; a diferencia de lo que pensaba inicialmente que era del 3 %. Obviamente lo que ha ocurrido es que al no observar morosidad alguna en dicha muestra la opini on del investigador se ha escorado ligeramente hacia la izquierda tendiendo a ser m as pr oxima a cero, pero no vale cero desde luego que es la estimaci on que aportar a un cl asico). La moda vale 1,9 %, tambi en ligeramente m as peque na que en la situaci on inicial. Gr acamente podemos ver dicha densidad en la siguiente gura 2.6, en la que hemos insertado simult aneamente la gr aca y los valores obtenidos en la a posteriori. Inferencia bayesiana para proporciones La inferencia bayesiana para esta situaci on es inmediata. Los estimadores puntuales m as habituales ya sabemos que son la media, mediana y moda dependiendo del tipo de funci on de p erdidas que asumamos. Por ejemplo, los valores de la media

2.1. An alisis bayesiano para datos binarios

59

Figura 2.6: Densidad a posteriori para la tasa de morosidad

y la moda son respectivamente E (|x) = +s , ++n M oda(|x) = +s1 . ++n2

El c alculo de los intervalos de credibilidad bayesianos con probabilidad 1 de acuerdo a las deniciones 1.5 y 1.6, consiste en un intervalo [a, b] de tal forma que la probabilidad (a posteriori) de que dicho intervalo contenga al par ametro es (1 ) %, esto es

b

(|x)d = 1 ,

a

con (|x) B e( + s, + n s). Estas cantidades pueden obtenerse de cualquier software estad stico general y de manera muy sencilla (como veremos en ejemplos posteriores) en FirstBayes. Ejemplo 2.6 (Continuaci on ejemplo 2.4) Obtener los estimadores puntuales de y un intervalo bayesiano de credibilidad con probabilidad 0,95 para el caso del ejemplo 2.4 Soluci on: Calcular el intervalo bayesiano de credibilidad al 95 % por ejemplo, es inmediato con FirstBayes adem as de los estimadores puntuales media, mediana

60

Inferencia bayesiana

y moda que valen 0,028, 0,025 y 0,019, respectivamente (gura 2.7). Basta ir a la pesta na denominada HDI que aparece debajo de la densidad a posteriori e indicar el nivel de probabilidad deseado, 95 % en nuestro caso.

Figura 2.7: Intervalo bayesiano al 95 % para el ejemplo 2.4 Como vemos los l mites obtenidos son 0,0027 y 0,0608, respectivamente. C omo lo interpretamos? Pues muy sencillamente, una vez observados los datos, la tasa de morosidad est a comprendida entre el 0,2 % y el 6,1 %, con una probabilidad del 95 %. Es realmente sencillo interpretar los intervalos de credibilidad, pero hay nuevas medidas que tambi en tienen la misma sencillez para su c alculo e interpretaci on. Por ejemplo, cu al ser a la probabilidad de que la tasa de morosidad sea mayor del 10 %? Para ello, basta con indicar en la opci on Prob. el intervalo del que queremos obtener la probabilidad, en este caso ser a entre 0.10 y 1. El resultado obtenido (gura 2.8) es 0.001612, es decir, la probabilidad de que la tasa de morosidad sea mayor del 10 % es 0,001 (obviamente muy peque na, pues los datos nos han informado de que no hab a errores en la muestra). Gr acamente podemos observar cu al ha sido el proceso de aprendizaje del investigador respecto a la tasa de morosidad una vez observados los 5 contratos sin morosidad. Para ello basta pinchar en la opci on Triplot (gura 2.9).

2.1. An alisis bayesiano para datos binarios

61

Figura 2.8: Probabilidad a posteriori de que la tasa de morosidad sea mayor del 10 % en el ejemplo 2.4

Como vemos, los datos han variado muy poco la opini on inicial del investigador (de hecho priori y posteriori est an casi superpuestas, pero ligeramente m as hacia la izquierda la a posteriori y m as apuntada indicando por tanto menor variabilidad). Los test de hip otesis se realizan f acilmente acudiendo a las expresiones de los odds y factor Bayes deducidas en la secci on 10.7.3. Ejemplo 2.7 Supongamos que una compa n a aseguradora desea conocer el porcentaje de asegurados que de una determinada cartera presentar an alguna reclamaci on a lo largo del presente a no. Se han observado n = 100 clientes de los cuales 45 han presentado alguna reclamaci on. Se trata de realizar el contraste: 2 1 vs H1 : = , 2 3 para una situaci on a priori desinformativa. H0 : = Soluci on: Estamos en una situaci on de hip otesis nula simple frente alternativa simple y por tanto utilizaremos las expresiones de los odds y factor Bayes deducidas en (1.12) y (1.13). En general el problema se resuelve f acilmente teniendo

62

Inferencia bayesiana

Figura 2.9: Triplot para la tasa de morosidad

en cuenta que si hay s exitos en una muestra de tama no n tendremos que: L(s|) = Luego el odds a posteriori vale (1 0 )ns p0 0 s , = 0 s p1 1 1 (1 1 )ns y el factor Bayes valdr a B01 = 0 1

s

n s (1 )ns . s

(2.6)

1 0 1 1

ns

(2.7)

1 1 2 Para el caso que nos ocupa n = 100, s = 45, 0 = 1 = , 0 = y 1 = de 2 2 3 donde se obtiene que B01 = 3 4

45

3 2

55

1155,5

2.1. An alisis bayesiano para datos binarios

63

que nos indica que a la luz de los datos la hip otesis nula es 1155,5 veces m as cre ble 1 que la alternativa. Parece claro que admitiremos que = . Observemos que en 2 este caso factor Bayes y odds a posteriori coinciden. Veamos c omo ser a el caso de hip otesis nula simple con alternativa compuesta. Supongamos una experimentaci on binomial de par ametros n y , en la que deseamos investigar la hip otesis H0 : = 0 vs H1 : = 0 . La informaci on a priori es del tipo: 1. 2. Pr{H0 } = 0 , Pr{H1 } = 1 0 . La densidad a priori mixta tendr a la forma siguiente: () = con 1 () B e(, ). Siguiendo los pasos de (1.19), (1.20), (1.21) y de manera an aloga al ejemplo 1.10 sobre la paradoja de Lindley tendremos f (s|0 ) = p1 (s) =

{=0 }

0 (1 0 ) 1 ()

si = 0 , si = 0

n ns s , 0 (1 0 ) s

(2.8)

f (s|) 1 () d =

n ( + ) ( + s)( + n s) , (2.9) s ()( ) ( + + n)

luego el odds a posteriori vale p0 0 ()( )( + + n) ns = s , 0 (1 0 ) p1 1 0 ( + )( + s)( + n s) y el factor Bayes tiene la expresi on,

ns B01 = s 0 (1 0 )

(2.10)

()( )( + + n) , ( + )( + s)( + n s)

(2.11)

Ejemplo 2.8 (Continuaci on ejemplo 2.7) Para el caso del ejemplo 2.7 reali1 1 zar ahora el contraste H0 : = vs H1 : = 2 2 Soluci on: Atendiendo a las expresiones (2.8) y (2.9) y para el caso particular 1 de este ejemplo: n = 100, s = 45, 0 = y supongamos el caso desinformativo 2 = = 1 tendremos que el odds a posteriori y el factor Bayes tienen el mismo 100 1 (102) valor 4,9. Es decir, la hip otesis nula es casi 5 veces m as 2 (46)(56)

64

Inferencia bayesiana

cre ble a posteriori que la alternativa. Observemos que en el caso de hip otesis nula simple frente alternativa simple (ejemplo 2.7) este valor era marcadamente mayor. Es decir, si tenemos que decidir entre dos posibles valores los datos aportan evidencia muy clara hacia la hip otesis nula. Ahora bien, cuando s olo se trata de una hip otesis nula simple, los datos ofrecen evidencia en favor de H0 pero no en la magnitud en la que lo hac a en el otro caso. Para el caso de hip otesis nula y alternativa compuesta el procedimiento es an alogo, como ya hemos comentado. En los siguientes ejemplos veremos c omo podemos proceder en estos casos. on Ejemplo 2.9 (Continuaci on ejemplo 2.4) Volviendo al caso de la inspecci de p olizas sin pagar de una compa n a aseguradora del ejemplo 2.4, supongamos que el investigador est a interesado en contrastar la hip otesis de que la tasa de morosidad es menor del 4 % frente a la hip otesis de que es mayor. Soluci on: Debemos realizar el contraste: H0 : 0 0,04 vs H1 : > 0,04

El procedimiento bayesiano para estos contrastes de hip otesis es an alogo a todo el proceso realizado hasta el momento. Es decir, el experto posee informaci on inicial sobre las hip otesis y dichos juicios iniciales son actualizados con la observaci on muestral. Obtenidos estos juicios a posteriori, el decisor deber a tomar una decisi on sobre el contraste. Utilizaremos FirstBayes para realizar los c alculos. En efecto, cada una de las hip otesis tendr a unas probabilidades iniciales de ser cierta: 0 = Pr{H0 cierta } = Pr{0 0,04} = 0,76 (ver gura 2.10). En consecuencia la probabilidad a priori de que la tasa de morosidad sea mayor del 4 % ser a de 1 = 0,24. El odds a priori valdr a 0 0,76 = 3,17. 1 0,24 Este cociente nos dice que a priori la hip otesis nula (la tasa de morosidad es menor del 4 %) es 3,17 veces m as creible que la alternativa (es mayor del 4 %). Esta relaci on es una cantidad perfectamente entendible por el investigador quien a priori tiene una opini on sobre cada una de las hip otesis (en este caso, aproximadamente tres veces m as creible la primera hip otesis que la segunda). Ahora debemos calcular las probabilidades a posteriori de cada una de las hip otesis. Para ello, volviendo a la ventana correspondiente a la densidad a posteriori indicamos las mismas probabilidades que anteriormente y se obtiene:

2.1. An alisis bayesiano para datos binarios

65

Figura 2.10: Probabilidad a priori de H0 en el ejemplo 2.9

p0 = Pr{H0 cierta | datos } = Pr{0 0,04} = 0,788 (ver gura 2.11). La probabilidad a posteriori de H1 ser a por tanto de p1 = 0,21. Observemos ahora el odds a posteriori: p0 0,79 = 3,76. p1 0,21 Es decir, una vez incorporada la informaci on muestral, una tasa de morosidad menor del 4 % es casi 4 veces m as creible que una tasa mayor. En consecuencia, la decisi on del experto puede ser del siguiente tipo: A la luz de los datos, aceptamos que la tasa de morosidad es menor del 4 % con una probabilidad de ser cierta de 0,79 (o equivalentemente, del 79 %). Frente a la hip otesis de ser mayor, la hip otesis inicial de morosidad menor del 4 % es aproximadamente 4 veces m as cre ble. El factor Bayes de H0 frente a H1 vale B01 = 0,79/0,21 p0 /p1 = 1,19, 0 /1 0,76/0,24

66

Inferencia bayesiana

Figura 2.11: Probabilidad a posteriori de H0 en el ejemplo 2.9

dicho valor se interpreta diciendo que los datos (por s solos) dan aproximadamente 1,19 veces m as credibilidad a la hip otesis nula que a la alternativa. Realmente, en este caso los datos dan pr acticamente la misma credibilidad a una u otra hip otesis. De manera an aloga, sin m as que intercambiarse los ndices, puede denirse el factor Bayes de H1 frente a H0 , en notaci on B10 . En resumen, los test de hip otesis se realizan de una manera realmente natural y de forma intuitiva. Las hip otesis tendr an unas probabilidades de ser ciertas que se actualizan a la luz de los datos (mediante el teorema de Bayes). El factor Bayes adem as nos proporciona la evidencia que aportan los datos a nuestra decisi on. Finalmente otras de las cantidades de inter es en el an alisis bayesiano es la distribuci on predicitiva de futuros datos. Distribuci on que conocemos por el teorema 2.1 que es Beta-Binomial. En efecto, en muchas ocasiones el experto est a tambi en interesado en conocer qu e puede ocurrir en futuras observaciones una vez que tiene su nuevo conocimiento con los datos anteriores. Desde el punto de vista cl asico, lo u nico que se hace es considerar la misma verosimilitud pero no se incorpora nada de lo observado anteriormente. El an alisis secuencial por tanto es crucial para este desarrollo y el m etodo bayesiano es especialmente bien comportado para esta si-

2.1. An alisis bayesiano para datos binarios

67

tuaci on. Matem aticamente el problema se resuelve f acilmente mediante el c alculo de la denominada distribuci on predictiva de una nueva observaci on z:

1

p(z|x) =

0

L(|z) (|x)d.

Ejemplo 2.10 (Continuaci on ejemplo 2.4) Supongamos que nuestro investigador est a interesado en conocer qu e puede esperar de la observaci on de 4 nuevos contratos en cuanto a su morosidad

Figura 2.12: Introducci on de la distribuci on predictiva en el ejemplo 2.10

Soluci on: Mediante FirstBayes el c alculo se puede hacer a trav es de la pesta na que aparece como Predictive analysis en la opci on Show predictive (gura 2.12), indicando el n umero de nuevas observaciones que deseamos predecir (cuando son m as de una observaci on se obtiene la predictiva del total de las nuevas observaciones). Pues bien, bastar a con que en la opci on de Predict sum of se indiquen 4 observaciones y pulsemos en Show predictive La distribuci on predictiva obtenida es BetaBinomial con unos determinados par ametros, en este caso puede verse que es BB (4; 2,99, 98,12). M as all a de los c alculos necesarios para la obtenci on de esta distribuci on es interesante ver que la

68

Inferencia bayesiana

Figura 2.13: Obtenci on de la distribuci on predictiva e intervalo bayesiano de credibilidad al 95 % para dicha predictiva en el ejemplo 2.10

predicci on para futuras observaciones es una nueva distribuci on y por tanto tendr a todas las caracter sticas que las distribuciones tienen (media, moda, etc.). En concreto podemos observar que esta distribuci on tiene una moda de 0 (es decir, que lo m as frecuente es que en las futuras 4 observaciones no haya ning un contrato moroso). Del mismo modo, podemos calcular el intervalo bayesiano de credibilidad para la predictiva. En este caso, con una probabilidad de 0,95 dicho intervalo es [0, 1]. Es decir, con una probabilidad del 95 % las futuras 4 observaciones presentar an 0 o 1 contratos morosos (gura 2.13). De nuevo, la interpretaci on se hace de manera natural en t erminos de probabilidad.

Ejemplo 2.11 (Continuaci on ejemplo 2.10) Realizar el mismo an alisis anterior pero considerando que en la muestra de n = 5 contratos apareci o un moroso, y = 1.

2.1. An alisis bayesiano para datos binarios

69

2.1.3.

Comparaci on de dos proporciones

Como ya hemos visto, el an alisis bayesiano nos permite realizar un estudio detallado sobre proporciones sin m as que incorporar nuestros juicios sobre la tasa objeto de inter es y la informaci on muestral recogida en forma de exitos o fracasos. Hay algunas situaciones relativas a proporciones o tasas en las que tambi en el an alisis bayesiano puede aportar una buena forma de realizar el aprendizaje sobre dicha tasa. Pensemos, por ejemplo, en el caso en que una compa n a que posee dos liales desea comprobar si la tasa de exitos en una u otra liar puede considerarse esencialmente la misma o si hay evidencia de que en una u otra es mayor. Formalmente podemos enunciar el problema de la siguiente forma. Supongamos que observamos dos muestras binomiales de dos poblaciones: x B (nx , x ), y B(ny , y ). Y estamos interesados en la relaci on entre x y y . Bajo el supuesto de que ambos par ametros son independientes con densidades a priori de tipo Beta, Be(x , x ) y B e(y , y ) Conocemos ya que la densidad a posterior de cada par ametro ser a respectivamente Be(x + x, x + nx x) y B e(y + y, y + ny y ). Ahora estamos interesados en comparar las proporciones en cada una de las poblaciones. Habitualmente, esta x comparaci on puede hacer a trav es de la diferencia x y o bien el cociente . y Existen varias alternativas bayesianas para resolver este problema. Un primer procedimiento consiste en considerar la reparametrizaci on x = x y , y = , x = log x y y = log y . 1 x 1 y

Como puede verse en Lee (2003, p. 152) las siguientes cantidades 1 1 x + log 2 2 x + nx x x + x , 1 1 y + log 2 2 y + ny y y + y ,

se distribuyen a posteriori aproximadamente como una distribuci on Normal con x + x 1/2 1 1 par ametros log y + , para x (an alogax + nx x 1/2 x + x x + nx x mente para y sin m as que cambiar x por y ). x Ahora teniendo en cuenta que x y = log , tendremos que y x = y x = 1 x = y . y (2.12)

De esta u ltima identidad podremos obtener las relaciones entre las proporciones sin m as que considerar que las diferencias entre normales independientes es tambi en una distribuci on Normal, esto es N ((x, y ), 2 (x, y )) con

70

Inferencia bayesiana

(x, y ) = log 2 (x, y ) =

(x + x)(y + ny y ) (x + nx x)(y + y )

(2.13) (2.14)

1 1 1 1 + + + . x + x x + nx x y + y y + ny y

Un segundo procedimiento m as simple, y con resultados an alogos al anterior para tama nos muestrales adecuados consiste en lo siguiente. Bastar a con aproximar las distribuciones a posteriori de los par ametros de inter es por aquellas distribuciones normales que tienen la misma media y varianza que la original distribuci on Beta a posteriori. A continuaci on y puesto que son independientes, la diferencia entre estos dos par ametros volver a a ser tambi en Normal. Es decir, aproximamos 2 las densidades a posteriori de x y y mediante las distribuciones N (x , x ) y 2 N (y , y ), respectivamente, siendo x = y = x + x , x + x + nx y + y , y + y + ny

2 = x

(x + x)(x + nx x) , (x + x + nx )2 (x + x + nx + 1) (y + y )(y + ny y ) , (y + y + ny )2 (y + y + ny + 1)

(2.15) (2.16)

2 y =

2 2 y por tanto, x y N (x y , x + y ).

Ejemplo 2.12 El servicio de investigaci on de una entidad aseguradora desea conocer si existe o no evidencia sobre el efecto de una campa na publicitaria para la captaci on de nuevos clientes en determinadas zonas de la ciudad. Existen dos grupos de potenciales clientes a los que se dirige. Para el grupo A, se analizaron 720 individuos de forma aleatoria; de los que 380 aceptaron, y el resto no. En la zona B, fueron analizados 290, de los que 120 eran positivos. Desarrollar un procedimiento que permita comparar las proporciones de positivos, bajo el supuesto de inexistencia de informaci on a priori. Soluci on: La modelizaci on de esta situaci on podemos hacerla de la siguiente forma. Consideremos A la tasa de positivos o exitos de la zona A y B su an alogo para la zona B. Para cada una de estas zonas debemos utilizar de acuerdo al enunciado, una a priori desinformativa que conocemos que se corresponde con una densidad Beta, B e(1, 1), lo que equivale a: (A ) 1, (B ) 1.

La informaci on muestral en cada zona ser a:

340 Zona A: Verosimilitud 380 . A (1 A ) 170 Zona B: Verosimilitud 120 . B (1 B )

2.1. An alisis bayesiano para datos binarios

71

Luego la actualizaci on de cada una de los juicios sobre las tasas de exito en cada zona ser an:

340 (A | datos ) (A )L(A | datos ) 380 , A (1 A )

que como sabemos se corresponde con una densidad Beta, Be(381; 341). Esta densidad puede conocerse mejor con FirstBayes.

Figura 2.14: Tasa de exito en la zona A Como vemos (gura 2.14), la tasa de exito en la zona A podemos estimarla en torno al 52,77 %, estando toda la tasa de exito de la zona A concentrada entre el 46 % y 59 % con un intervalo bayesiano al 95 % de entre 49,1 % y 56,4 %, es decir, existe una probabilidad del 05 % de que la tasa de exito de la campa na en la zona A est e comprendida entre el 49,1 % y el 56,4 %. Observemos que ahora hemos utilzado FirstBayes directamente desde la opci on de Distributions sin pasar por el an alisis binomial. Obviamente lo podr amos haber realizado pero hubi esemos tenido que crear un chero de 720 registros con 380 unos y 340 ceros y dado que los c alculos para la a posteriori son inmediatos se ha preferido esta opci on. Es tambi en interesante observar que la varianza para el par ametro en la zona A puede estimarse por 0,000345.

72

Inferencia bayesiana

Para la zona B se procede de forma an aloga obteni endose una densidad a posteriori Beta, B e(121, 171).

Figura 2.15: Tasa de exito en la zona B Como vemos (gura 2.15), la tasa de exito en la zona B podemos estimarla en torno al 41,4 %, estando toda la tasa de exito de la zona B concentrada entre el 32 % y 51 % con un intervalo bayesiano al 95 % de entre 35,8 % y 47,1 %, es decir, existe una probabilidad del 5 % de que la tasa de exito de la campa na en la zona B est e comprendida entre el 35,8 % y el 47,1 %. Del mismo modo que anteriormente, observemos que hemos utilizado FirstBayes directamente desde la opci on de Distributions sin pasar por el an alisis binomial. La varianza para el par ametro en la zona B es 0,000828. Ya tenemos el comportamiento de la tasa de exito en cada zona, el problema que debemos ahora resolver es ver si hay evidencia de que la tasa de exito en la zona A es mayor que en la zona B, es decir, en t erminos de probabilidad estamos hablando de saber cu anto vale: Pr{A > B } = Pr{A B > 0}. Se trata por tanto de saber c omo se distribuye la diferencia entre ambos par ametros, sabiendo que cada uno de ellos es una Beta. Debemos decir que en principio

2.2. An alisis bayesiano para datos de Poisson

73

este no es un problema sencillo de resolver pues la diferencia de Betas no es, en general, otra distribuci on Beta. Sin embargo, existe una manera adecuada de soslayar este impedimento. En efecto, si observamos las densidades a posteriori de cada una de las zonas podemos ver que cada una de ellas se parece o aproxima de manera muy buena a una campana de Gauss, es decir, a una densidad Normal; de hecho aunque no es objeto de este m odulo, puede calcularse el grado de similitud entre ambas densidades y ver que sus distancias son realmente peque nas y por tanto, podemos concluir que la aproximaci on mediante una curva normal de las densidades Betas no supone ninguna p erdida de exactitud en los c alculos necesarios. Ahora bien, si deseamos aproximar estos juicios a posteriori mediante densidades de tipo Normal, por cu al debemos hacerlo? Parece claro que si queremos aproximar estas densidades, lo l ogico es aproximar la densidad Beta para la zona A por aquella densidad Normal que tenga la misma media y varianza (par ametros que determinan una densidad Normal) que la densidad Beta obtenida anteriormente. En este caso, aproximaremos la densidad a posteriori de A por una densidad Normal, N (0,5277; 0,000345). El mismo razonamiento es v alido para la zona B y por tanto, proponemos aproximar los juicios sobre la tasa de exito para la zona B mediante una densidad Normal, N (0,414; 0,000828). Ya estamos en condiciones de obtener c omo se distribuye la diferencia entre ambos par ametros, puesto que usamos la propiedad de que la suma (o diferencia) de densidades Normales independientes es tambi en una densidad Normal con media la suma (o diferencia, seg un proceda) de las medias y la suma de las varianzas correspondientes. Para el caso que nos ocupa tendremos que A B se comporta como una densidad Normal, N (0,1137; 0,001173). Y de esta densidad podemos obtener todas las cantidades de inter es que procedan, para ello basta con que introduzcamos desde la opci on Distributions la familia Normal, con los par ametros anteriores. Para el caso que nos ocupa se tiene que: Pr{A > B } = 0,999. Luego podemos asegurar con una probabilidad del 99,9 % (ver gura 2.16) que la tasa de exitos en la zona A es mayor que en la zona B.

2.2.

An alisis bayesiano para datos de Poisson

Como ya hemos comentado en el cap tulo 6, secci on 6.5, la distribuci on de Poisson aparece de manera natural en el estudio de datos que provienen de procesos de conteo, como es el caso del n umero de siniestros, n umero de llegadas a un sistema, llegadas a una ventanilla de una ocina bancaria, llegadas a una caja de supermercado, llegadas a un sem aforo que regula el tr aco, n umero de reclamaciones que presentan unos usuarios, n umero de partes de accidentes que recibe una compa n a de seguros, etc. Estudiaremos en esta secci on el procedimiento bayesiano de inferencia para este modelo muestral.

Potrebbero piacerti anche

- Funciones Del Marco TeóricoDocumento3 pagineFunciones Del Marco TeóricoLuis Fernando Ticona SocaNessuna valutazione finora

- Actividad Evaluativa 8 LauraDocumento6 pagineActividad Evaluativa 8 LauraLaura CharrisNessuna valutazione finora

- La Investigación CualitativaDocumento76 pagineLa Investigación CualitativaPedro Gutierrez100% (1)

- Demostracion en MatemáticasDocumento25 pagineDemostracion en Matemáticasmaestro_jarbNessuna valutazione finora

- La Experiencia de La Nada PDFDocumento121 pagineLa Experiencia de La Nada PDFMerche García SáezNessuna valutazione finora

- Logica Policial Clase 1Documento35 pagineLogica Policial Clase 1Javier Romero100% (1)

- Los 15 Tipos de Investigación (Y Características)Documento14 pagineLos 15 Tipos de Investigación (Y Características)natpabNessuna valutazione finora

- Lacan MatemáticaDocumento19 pagineLacan MatemáticaRosalia ZingalesNessuna valutazione finora

- Las Relaciones Morfosintacticas PDFDocumento16 pagineLas Relaciones Morfosintacticas PDFSuleika Mena BenavidesNessuna valutazione finora

- Álgebra de Boole. 1. - Postulados de HuntingtonDocumento18 pagineÁlgebra de Boole. 1. - Postulados de HuntingtonJose Tinoco ANessuna valutazione finora

- Luis Ramos - Fragmentos de SpinozaDocumento20 pagineLuis Ramos - Fragmentos de SpinozaBrayam White GarcíaNessuna valutazione finora

- Sintesis de La Filosofia Del Capital de Felipe Martinez MarzoaDocumento14 pagineSintesis de La Filosofia Del Capital de Felipe Martinez MarzoaPepeDíazNessuna valutazione finora

- Trabajo Final Colaborativo Fase 3Documento31 pagineTrabajo Final Colaborativo Fase 3LEIDY MARCELA RAMOS CUELLARNessuna valutazione finora

- Temario EM FilosofíaDocumento5 pagineTemario EM FilosofíaMaría Eugenia Benavente silvaNessuna valutazione finora

- Gedächtnis y AndenkenDocumento14 pagineGedächtnis y AndenkenOchopinochoNessuna valutazione finora

- Los Tres Paradigmas de La EducacionDocumento17 pagineLos Tres Paradigmas de La EducacionReynaldo Boris Colque CondoriNessuna valutazione finora

- La Pregunta de Investigación - ResumenDocumento8 pagineLa Pregunta de Investigación - ResumenAlexander Vargas TorresNessuna valutazione finora

- Libro Superior 1Documento181 pagineLibro Superior 1Alejandro Castillo de Gante67% (3)

- Rúbrica El Ensayo Cuarto MedioDocumento2 pagineRúbrica El Ensayo Cuarto MedioFernanda Elena Olivares100% (1)

- 2 Bachillerato. Anexo Tipologia Textual. La ArgumentacionDocumento5 pagine2 Bachillerato. Anexo Tipologia Textual. La ArgumentacionSori SinNessuna valutazione finora

- Diseño Metodologico-Trabajo PracticoDocumento2 pagineDiseño Metodologico-Trabajo PracticonisseNessuna valutazione finora

- Bruner y El Aprendizaje HeurísticoDocumento2 pagineBruner y El Aprendizaje HeurísticoKiara Zamora100% (1)

- Cuadro Comparativo Basico Sobre Socrates Platon y AristotelesDocumento2 pagineCuadro Comparativo Basico Sobre Socrates Platon y AristotelesMarco Martinez100% (8)

- Mapa Mental 1.1.1 Realidad y El ConocimientoDocumento1 paginaMapa Mental 1.1.1 Realidad y El ConocimientoJessi Velazquez100% (2)

- PierceDocumento4 paginePierceFederico PaladinoNessuna valutazione finora

- Argumentacion Jurídica 2Documento19 pagineArgumentacion Jurídica 2Silvia CoradoNessuna valutazione finora

- Diez Reglas para Una Argumentación Ideal - Somos InformívorosDocumento4 pagineDiez Reglas para Una Argumentación Ideal - Somos InformívorosClaudio VillegasNessuna valutazione finora

- Wellmer-Lineas de Fuga en La Modernidad - FilosofiaDocumento27 pagineWellmer-Lineas de Fuga en La Modernidad - FilosofiaMonica Peisajovich50% (2)

- Capítulo 7 Métodos EtnográficosDocumento31 pagineCapítulo 7 Métodos EtnográficosDebs AcNessuna valutazione finora

- Roma y El Periodo MedievalDocumento7 pagineRoma y El Periodo MedievalAnonymous vUoNT9wiXDNessuna valutazione finora