Documenti di Didattica

Documenti di Professioni

Documenti di Cultura

Tallyta Carolyne Martins Da Silva Pivic

Caricato da

Juarez Mazzuca JuniorDescrizione originale:

Copyright

Formati disponibili

Condividi questo documento

Condividi o incorpora il documento

Hai trovato utile questo documento?

Questo contenuto è inappropriato?

Segnala questo documentoCopyright:

Formati disponibili

Tallyta Carolyne Martins Da Silva Pivic

Caricato da

Juarez Mazzuca JuniorCopyright:

Formati disponibili

Tallyta Carolyne Martins da Silva

1

, Valdivino Vargas J unior

2

Universidade Federal de Goias, CEP 74001-970, Brasil.

tallytacarol@yahoo.com.br e vvjunior@mat.ufg.br

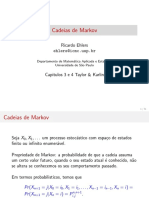

Cadeias de Markov: Conceitos e Aplica c oes em Modelos de

Difusao de Informac ao

Resumo

Cadeias de Markov s ao processos estocasticos com a chamada propriedade mar-

koviana. Estes processos tem aplicabilidade desde a biologia ate a economia. Neste

texto sera apresentado conceitos basicos de Cadeias de Markov, concentrando nas

cadeias a tempo discreto. Citaremos alguns dos processos estocasticos markovianos

mais comuns na literatura: passeios aleat orios e processos de ramicacao. Vamos

exibir uma aplicacao das Cadeias de Markov em modelo para a difus ao de vrus em

uma rede de computadores.

PALAVRAS-CHAVE: Cadeias de Markov, Passeio Aleatorio, Recorrencia.

1 INTRODUC

AO

Uma Cadeia de Markov e um tipo especial de processo estoc astico que possui a cha-

mada propriedade markoviana . Um processo estoc astico tem a propriedade markoviana

se os estados anteriores do processo sao irrelevantes para a predic ao dos pr oximos esta-

dos , desde que o estado atual seja conhecido. O matem atico Andrey Markov em 1906

conseguiu os primeiros resultados para estes processos. Atualmente, Cadeias de Markov

tem sido estudadas e utilizadas em diversas areas do conhecimento como, por exemplo,

ciencias biologicas, sociais e administrativas . Probabilidades ligadas a jogos, evolu c ao de

popula c oes e resultados sobre teoria de las sao algumas aplicac oes. Tambem encontra-se

aplicac oes de Cadeias de Markov em modelos epidemicos, processos de migrac ao, estudos

1

Orientanda Bolsista PIVIC

2

Orientador.

Revisado pelo Orientador

sobre o DNA, modelos de gerenciamento de recursos, modelos para processos de decis ao,

modelo para difusao de informac ao, dentre outros.

2 OBJETIVOS

Apresentar os conceitos basicos de Cadeias de Markov, focando nas cadeias a tempo

discreto. Analisar os seguintes conte udos no desenvolvimento do texto: Analise Combi-

nat oria, Probabilidade, Teoria basica de grafos e Processos Estoc asticos.

Examinar alguns dos processos estoc asticos markovianos mais citados na literatura:

passeio aleatorio, processo de ramica c ao e processo de nascimento e morte. Considerar

uma aplicac ao particular das Cadeias de Markov em modelos para a difusao de informac ao

por agentes m oveis.

3 CADEIAS DE MARKOV

Processo de Markov e um tipo especial de processo estoc astico onde as distribui c oes de

probabilidade para o passos futuros do processo dependem somente do estado presente,

desconsiderando como o processo chegou a tal estado. Se o espaco de estados e discreto

(enumeravel), ent ao o modelo de Markov e denominado Cadeia de Markov.

3.1 Conceito de Cadeia de markov

Um processo estoc astico e uma colec ao de variaveis rand omicas indexadas por elemen-

tos t pertencente a um determinado intervalo de tempo.

Deni cao 3.1. Seja o processo estocastico {X

n

, n = 0, 1, 2, } em tempo discreto. As

vari aveis X

n

possuem possveis valores num conjunto E nito ou innito enumer avel E

chama-se conjunto de estados ou espaco de estados. X

n

= i representa que o processo

est a no estado i no tempo n. X

n

e cadeia de Markov se

P(X

n+1

= j|X

n

= i, X

n1

= i

n1

, , X

1

= i

1

, X

0

, = i

0

) = P(X

n+1

= j|X

n

= i) = p

ij

.

Ou seja, a chance de estar no instante n+1 no estado j depende somente do estado no

instante n, mas independe de toda a hist oria do processo (estados X

0

, X

1

, , X

n1

). Esta

propriedade chama-se propriedade markoviana. As probabilidades podem ser representadas

atraves de matriz de transicao:

_

_

_

_

_

_

_

_

_

_

_

p

0,0

p

0,1

p

0,2

p

1,0

p

1,1

p

1,2

: : :

.

.

.

p

i,0

p

i,1

p

1,2

. . .

: : :

.

.

.

_

_

_

_

_

_

_

_

_

_

_

.

3.2 Equacoes de Kolmogorov

As equa c oes de Kolmogorov - Chapman fornecem o c alculo de probabilidades de transi c ao

em n passos. Estas equa c oes mostram que as probabilidades de transi c ao de n etapas po-

dem ser obtidas, recursivamente, a partir das probabilidades de transi c ao de uma etapa.

p

(n+m)

ij

=

k=0

P

(n)

i,k

P

(m)

k,j

para todos n,m 0, e todos i,j.

3.3 Classicacao dos estados de uma Cadeia de markov

Nesta sec ao vamos estudar os tipos de estados de uma cadeia de Markov.

Deni cao 3.2. (Estado acessvel)

Um estado j e acessvel do estado i, se existe n 0 tal que P

n

i,j

>0. Em outras

palavras, se for possvel chegar ao estado j saindo do estado i, ent ao j e acessvel a partir

de i. Mas

P

i,j

=

1, se i=j

0, caso contrario

Desse modo, qualquer estado i e acessvel dele mesmo.

Deni cao 3.3. (Estados comunic aveis)

Dizemos que dois estados se comunicam se cada um for acessvel a partir do outro.

A relacao de comunicacao no espaco de estados e uma relacao de equivalencia pois satis-

faz as seguintes condi coes:

i) (Reexiva) Todo estado i se comunica com ele mesmo: (i i), pois P

0

i,i

= 1.

ii) (Simetrica) Se o estado i se comunica com o estado j, o estado j se comunica com o

estado i: (i j) (j i) .

iii) (Transitiva) Se o estado i se comunica com o estado j, e o estado j comunica com o

estado k, ent ao o estado i comunica com o estado k: (i j) , (j k) (i k) .

Deni cao 3.4. (Estado n ao essencial)

Um estado i E e n ao essencial se existe um instante n N e j E tais que

P

n

i,j

>0 e P

m

j,i

=0 para todo m N. Caso contrario, temos um estado essencial.

Deni cao 3.5. (Estado recorrente)

Considerando como a probabilidade de que iniciando no estado i a cadeia de

Markov X

n

retorne a este estado: f

i

= P(existe n> 0 tal que X

n

= i | X

0

= i)

Se f

i

= 1 o estado e recorrente, ja se f

i

< 1 o estado e transiente.

Proposi cao 3.6. O estado i e recorrente se

n=1

p

(n)

i,i

= e e transiente se

n=1

p

(n)

i,i

< .

Deni cao 3.7. (Estado absorvente)

Um estado i e absorvente se uma vez adentrado, a cadeia jamais o deixa.

P

i,j

=

1, se j = i

0, caso contrario.

Proposi cao 3.8. Todo estado absorvente e recorrente.

Corolario 3.9. Todo estado absorvente pertence a uma classe exclusiva. C = {i}

i e absorvente.

Deni cao 3.10. Um conjunto de estados de uma cadeia de Markov forma uma classe

C, se quaisquer dois estados desse conjunto se comuniquem, e quaisquer dois estados

comunic aveis pertencem a mesma classe. Logo, se ha duas classes para uma Cadeia de

Markov, ent ao elas s ao disjuntas (C

1

C

2

= ) ou identicas (C

1

C

2

).

Deni cao 3.11. Cadeia de Markov X

n

irredutvel e uma cadeia em que todos os estados

formam apenas uma classe.

Exemplo 3.12. Sejam 0,1,2 estados de uma Cadeia de Markov com a matriz de

transicoes

P =

_

_

_

_

_

1

2

1

2

0

1

2

1

4

1

4

0

1

3

2

3

_

_

_

_

_

Analisando a matriz de transicao inferimos que 0 1 e 1 2. E por meio da

propriedade de estados comunic aveis obtemos que 0 2 tambem. Claramente temos uma

Cadeia de Markov irredutvel pois todos os estados s ao comunic aveis .

4 Probabilidades limite

Analisaremos agora a distribui c ao invariante:

Proposi cao 4.1. Para uma Cadeia de Markov satisfazendo as seguintes equa coes:

iE

(i)P

i,j

= (j), para todo j E.

Desse modo, s ao validas as armacoes: i) Para todo j E,

iE

(i)P

(2)

i,j

= (j).

Para n 1 temos que

iE

(i)P

(n)

i,j

= (j).

ii) Quando a cadeia tem distribuicao inicial logo para todo n 1 , temos que

P(X

n

= i) = (i).

Proposi cao 4.2. A distribuicao

ser a a distribuicao assintotica da cadeia {X

n

}

{n0}

se satisfazer

lim

n

P

n

i,j

=

para todo j E.

Proposi cao 4.3. Seja {X

n

}

n0

uma Cadeia de Markov com matriz de transi cao P e

com distribuicao assintotica

. Entao

e a unica distribuicao invariante da cadeia.

Teorema 4.4. (Teorema basico de converg^ encia) Se uma Cadeia de Markov {X

n

}

n0

com distribuicao invariante

inv

for irredutvel e aperiodica ent ao

inv

ser a a sua distri-

buicao assintotica.

Exemplo 4.5. Vamos considerar uma Cadeia de Markov com a seguinte matriz de

transicao:

P =

_

_

_

_

_

0

1

2

1

2

1 0 0

1 0 0

_

_

_

_

_

Nesse caso, a distribuicao invariante existe e corresponde a

inv

=

_

1

2

1

4

1

4

_

O limite de P

n

quando n n ao existe pois P

2n+1

= P e P

2n

= P

2

, dessa maneira

n ao existe distribuicao assintotica.

Exemplo 4.6. Considere uma cadeia de Markov {X

n

}

{n0}

com espaco de estados E =

{0,1} e matriz de transicao

P =

_

_

1 a a

b 1 b

_

_

onde 0 < a + b < 2.

No caso dessa matriz, a medida invariante e equivalente a distribuicao assintotica

porque temos uma cadeia irredutvel e aperiodica.

Deni cao 4.7. Um estado i tem o perodo d se p

(n)

ii

= 0 se e somente se n n ao se

divide em d. Um estado aperiodico tem d=1.

Exemplo 4.8. Passeio aleatorio simples e um exemplo em que todos os estados s ao

periodicos com d=2. Seja T

i

o tempo de volta no estado i:

T

i

= min{n > 0 : X

n

= i} , X

0

= i

Deni cao 4.9. Se o estado i e recorrente, ent ao ele chama-se recorrente positivo,se

E(T

i

)< . Um estado e dito ergodico se for aperodico e recorrente positivo.

Teorema 4.10. Para qualquer Cadeia de Markov ergodica (todos os estados dela s ao

ergodicos) o limite lim

n

p

(n)

ij

existe e n ao depende do i.

Seja

j

= lim

n

p

(n)

ij

, j 0

Entao o vetor = (

0

,

1

, ) e solucao unica do sistema seguinte

j

=

i=0

i

p

ij

, j 0

j=0

j

= 1.

5 Passeios aleat orios

Deni cao 5.1. Sejam X

1

, X

2

, vari aveis aleatorias independentes e identicamente

distribudas sendo que

P(X

i

= 1) = p e P(X

i

= 1) = 1 p = q.

Temos um passeio aleatorio simples. E se p = q temos um passeio aleatorio simples

simetrico.

Exemplo 5.2. (Passeio aleatorio n ao homogeneo) Dena (X

n

, n 1) como uma colecao

de vari aveis aleatorias independentes tais que P(X

n+1

= 1) =

n

e P(X

n+1

= -1) =

n

onde

n

+

n

= 1.

Desse modo, temos um passeio aleatorio n ao homogeneo no qual as probabilidades de

transicoes dependem de n.

Deni cao 5.3. Tempo de Primeira Passagem

O tempo da primeira passagem e o n umero de transicoes que o processo da para ir de

i para k. Considere um passeio aleatorio no qual S

0

= i. O tempo de primeira passagem

e dado por

T

i,k

= min{n > 0 : S

n

= k}.

Quando i = k, a vari avel aleatoria T

k,k

e chamada tempo de recorrencia de k.

O tempo de primeira passagem de passeios aleatorios simples possui uma propriedade

importante: os passos depois da primeira passagem em k e independente das passagens

anteriores. Assim,

T

0,2

= T

0,1

+ T

1,2

sendo que T

0,1

e T

1,2

s ao independentes e possuem a mesma distribuicao j a que as X

i

s ao

identicamente distribudas.

Deni cao 5.4. (Range)

O range R

n

do passeio e a quantidade de valores distintos em (S

0

, S

1

, , S

n

).

Deni cao 5.5. (Tempo de parada)

Sejam X

1

, X

2

, uma sequencia de vari aveis aleatorias independentes. Uma vari avel

aleatoria N e denida tempo de parada para esta sequencia se o evento {N=n} e indepen-

dente de X

n+1

, X

n+2

, para todo n=1,2,

Teorema 5.6. Equacao de Wald

Se X

i

i 1 s ao v.a.i.i.d. tal que E[X

i

]< e se N e um tempo de parada para

X

1

, X

2

, com E[N]< , ent ao

E

_

N

i=1

X

i

_

= E[N]E[X

1

]

Exemplo 5.7. Considere um passeio aleatorio simples assimetrico com p >

1

2

. O n umero

esperado de passos ate o passeio atingir a posicao k , k > 0 e

E[N] =

k

2p 1

Temos que E[X

1

] = 1 < . Alem disso

N

j=1

X

j

= k E

_

N

j=1

X

j

_

= k

Desse modo, E[X

1

]= 2p - 1.

Deni cao 5.8. (Recorrencia e transiencia) Seja (S

n

, n 0)um passeio aleatorio.

Um estado i e recorrente se

P(S

n

= i para innitos n) = 1.

Por outro lado, o estado i e transiente se

P(S

n

= i para innitos n)= 0.

Deni cao 5.9. (N umero de visitas V

i

ao estado i)

Temos V

i

=

n=0

1

{S

n

=i

}.

Assim o valor esperado do n umero de visitas e

E(V

i

) = E(

n=0

1

{S

n

=i}

) =

n=0

E(1

{S

n

=i}

) =

n=0

P(S

n

= i).

Proposi cao 5.10. Para qualquer passeio aleatorio, as pr oximas armacoes s ao simi-

lares:

i) f

0

= P(T

0

< ) = 1.

ii)P(S

n

= 0 innitas vezes) = 1.

iii)

n=0

P(S

n

= 0) = .

Teorema 5.11. P(S

n

= k) =

_

n

n+k

2

_

p

n+k

2

(1 p)

nk

2

Demonstracao. Examine uma realiza c ao do passeio aleatorio de (0,0) para (n, S

n

) formada

por r passos positivos e s passos negativos. Se S

n

= k ent ao r-s = k e r + s = n. Logo

r =

n+k

2

e s =

nk

2

. A quantidade de realiza c oes e

_

n

r

_

e cada uma tem a mesma

probabilidade: p

r

q

s

. Assim

P(S

n

= k) =

_

n

r

_

p

r

q

s

.

5.1 Dualidade em Passeios aleat orios e Princpio da reexao

Armacao 5.1. (X

1

, X

2

, , X

n

) tem a mesma distribuicao conjunta de (X

n

, X

n1

, , X

1

).Ou

seja,

P(X

1

= k

1

, X

2

= k

2

, , X

n

= k

n

) = P(X

n

= k

1

, X

n1

= k

2

, , X

1

= k

n

).

Proposi cao 5.12. (Princpio da reex ao)

Se x e y s ao positivos ent ao o n umero de passeios de (0,x) para (n,y) que tocam o

eixo x e igual ao n umero de passeios de (0,-x) para (n,y).

Teorema 5.13. Teorema do Primeiro acerto Seja b> 0. Entao num passeio

aleatorio simples

P(T

0,b

= n) =

b

n

P(S

n

= b).

Demonstracao. Dena N

n

(0,x) a quantidade de execuc oes possveis de (0,0) para (n,x) (

quantidade de

passeios de comprimento n partindo de 0 e chegando a x). Seja ainda N

b

n

(0,x) o n umero

de execuc oes possveis de (0,0) para (n,x) que visitam b pelo menos uma vez. Se T

0,b

=

n ent ao X

n

=1 e S

n1

=b-1. Logo, existem N

n1

(0,b-1) passeios de (0,0) para (n-1,b-1)

dos quais N

b

n=1

(0, b-1) passam em b no trajeto. Cada uma dessas realiza c oes possui

probabilidade p

n+b

2

q

nb

2

. Usando o prncipio da reexao:

P(T

0,b

= n) = p(N

n1

(0, b 1) N

n1

(0, b + 1))p

n+b

2

q

nb

2

= [

_

n 1

n+b

2

1

_

_

n 1

n+b

2

_

]p

n+b

2

q

nb

2

=

b

n

P(S

n

= b)

Proposi cao 5.14. Num passeio aleatorio simples simetrico

E[T

0,1

] =

Demonstracao.

E(T

0,1

) =

m=0

P(S

2m+1

= 1) =

m=0

_

2m+ 1

m+ 1

_

2

(2m+1)

=

Teorema 5.15. (Teorema de Ballot)

Considere S

n

um passeio aleatorio simples com S

0

= 0. Temos que

P(

2n1

i=1

S

i

= 0|S

2n

= 2r) =

r

n

.

Demonstracao. Conte o n umero N

2n1

0

(1,2r) de realiza c oes de (1,1) para (2n,2r) que

passam pela origem. Queremos reetir o passeio antes de seu primeiro 0 no eixo x, e dessa

maneira mostrar que N

0

2n1

(1,2r). Como todas as N

2n

(0,2r) realiza c oes sao igualmente

prov aveis, a probabilidade desejada e

N

2n1

(1, 2r) N

0

2n1

(1, 2r)

N

2n

(0, 2r)

=

N

2n1

(1, 2r) N

2n1

(1, 2r)

N

2n

(0, 2r)

=

r

n

.

Exemplo 5.16. Problema da runa do jogador

Um jogador comeca a jogar em um cassino com X reais em dinheiro. Suponhamos que

ele participe de um jogo que envolva apostas independentes. Em cada aposta ele ganha

um real se ocorrer vit oria e caso contrario perde um real. A probabilidade de vit oria em

cada aposta e p e de derrota 1-p = q. Vamos considerar que os recursos do cassino s ao

ilimitados e que ele jogue indenidamente, parando somente se car sem dinheiro. O

capital acumulado pelo jogador ao longo das apostas pode ser encarado como um passeio

aleatorio. No contexto da dinamica do jogador, a vari avel aleatoria X

i

representa o ganho

do jogador na i-esima jogada. Queremos mostrar que mesmo estando em umcassino

justo, com probabilidade 1, o jogador ca sem dinheiro em algum momento.

Demonstracao. Consideremos h

i

= P

i

(acertar 0). Ent ao h e a soluc ao minimal nao

negativa de

h

0

= 1

h

i

=

1

2

h

i+1

+

1

2

h

i1

para i=1,2,...

A soluc ao geral dessa relac ao de recorrencia e

h

i

= A + Bi.

Porem, a restric ao 0 h

i

1 indica que B = 0. Assim, h

i

= 0 para todo i. Desse

modo, em algum momento o capital do jogador e 0.

6 Simulac oes

Abordaremos agora um exemplo de simula c ao:

Exemplo 6.1. Consideremos a Cadeia de Markov com espaco de estados E = {1, 2, 3}

e seguinte matriz de transicao:

P =

_

_

_

_

_

P

1

,

1

P

1

,

2

P

1

,

3

P

2

,

1

P

2

,

2

P

2

,

3

P

3

,

1

P

3

,

2

P

3

,

3

_

_

_

_

_

=

_

_

_

_

_

1

2

1

2

0

0

3

4

1

4

1

8

3

8

1

2

_

_

_

_

_

Temos:

| I

1

1

|= P

1

,

1

=

1

2

| I

1

2

|= P

1

,

2

=

1

2

| I

1

3

|= P

1

,

3

= 0

| I

2

1

|= P

2

,

1

= 0 | I

2

2

|= P

2

,

2

=

3

4

| I

2

3

|= P

2

,

3

=

1

4

| I

3

1

|= P

3

,

1

=

1

8

| I

3

2

|= P

3

,

2

=

3

8

| I

3

3

|= P

3

,

3

=

1

2

Entao podemos fazer a seguinte constru cao:

I

1

1

= [0,

1

2

) I

1

2

= [

1

2

, 1] I

1

3

=

I

2

1

= I

2

2

= [0,

3

4

) I

2

3

= [

3

4

, 1]

I

3

1

= [0,

1

8

) I

3

2

= [

1

8

,

1

2

) I

3

3

= [

1

2

, 1]

A construc ao dada acima nao e a unica possvel. Podemos escolher os intervalos de

modo a satisfazerem os passos descritos. Uma composic ao possvel seria I

1

1

=[

1

8

,

1

2

)

[

5

8

,

3

4

)

e I

1

2

= [0,

1

8

)

[

1

2

,

5

8

)

[

3

4

,1].

Determinar qual intervalo car a aberto ou fechado tambem nao e relevante, pois a medida

de um unico ponto e zero.

Em seguida, apontamos um estado inicial ou geramos ele de modo aleatorio por meio,

por exemplo, da medida invariante do processo. Agora o algoritmo age iteradamente da

seguinte maneira: estando no estado i vai para a partic ao i e gerado o n umero aleatorio

uniforme no intervalo [0,1] realiza transi c ao para o estado

j = {j : a I

i

j

}.

7 Processos de ramicacao

Um tipo especial de Cadeia de Markov sao os processos de ramica c ao que inicial-

mente foram estudados por Galton e Watson em 1873 . O estudo envolvia investigar um

problema interessante: a extin c ao de sobrenomes. Os sobrenomes nesse perodo hist orico

eram passados de gera c ao para gera c ao sendo que o lho recebia o sobrenome do pai. Es-

tamos interessados em analisar a ocorrencia da extin c ao do nome da famlia. Atualmente,

podemos encontrar aplicac oes deste estudo em diversas areas tais como Fsica, Biologia,

Economia e Computac ao.

Considere o processo estoc astico {X

n

} onde X

n

e o tamanho da popula c ao de indivduos

do sexo masculino da n-esima gera c ao de uma famlia e cada organismo em seu tempo de

vida produz um n umero aleatorio Y

i

de descendentes do sexo masculino. As variaveis Y

i

sao independentes com distribui c ao de probabilidade

P(Y

i

= k) = p

k

, k=0,1,2 .

p

k

> 0 e

0

p

k

= 1.

Assumimos que todos os descendentes sao independentes.

P

i,k

= P(X

n+1

= k|X

n

= i) = P(

i

r=1

Y

r

= k)

onde Y

1

, , Y

i

sao as i famlias da n-esima gera c ao dado que X

n

= i. O espaco de

estados e o conjunto dos inteiros nao negativos Z

+

.

Propriedades:

Suponha que X

0

= 1

i) X

n

=

X

n1

i=1

Y

i

Y

i

representa o n umero de lhos do i-esimo indivduo da gera c ao n-1.

ii) E[X

n

] =

n

, onde e o n umero medio de descendentes por indivduo .

Demonstracao.

E[X

n

] = E[E[X

n

/X

n1

]] = E[X

n1

] = E[E[X

n1

/X

n2

]] = E[X

n2

] =

n

.

Vejamos a convergencia de E[X

n

]:

Se < 1 : E[X

n

] converge para zero.

Se = 1 : E[X

n

] constante, igual a 1.

Se > 1 : E[X

n

] diverge para innito.

iii) Seja a probabilidade de extin c ao, isto e,

= P(X

n

= 0 para algum n).

Teorema 7.1. Suponha que P(X

1

= 0) > 0 e P(X

1

= 0) + P(X

1

= 1) < 1. Entao

i) e o menor n umero positivo satisfazendo

x =

j=0

x

j

P(X

1

= j)

ou seja, o menor n umero inteiro positivo satisfazendo x = G

X

1

(x), onde G

X

1

e a fun cao ge-

radora de

probabilidade de X

1

.

ii) = 1 se e somente se 1.

8 Aplicac oes de Cadeias de Markov em modelos para

a difusao de informacao

A ttulo de exemplo da aplicac ao de Cadeias de Markov em modelos para a difusao

de informac ao consideramos um sistema simples de passeios aleatorios. O modelo em

estudo tem a seguinte din amica (veja [MZM]). No tempo zero em cada vertice dos inteiros

ha N partculas todas inativas, exceto as presentes na origem. Cada partcula ativa

escolhe de forma independente saltar para a direita com probabilidade p e para `a esquerda

com probabilidade 1 p, realizando um passeio aleatorio sobre os inteiros.Quando uma

partcula salta sobre um vertice com partculas inativas, estas sao ativadas e cada uma

inicia um passeio aleatorio independente sobre os inteiros. Uma partcula ativa morre

apos saltar L vezes sem acordar outras partculas. No contexto de sistemas de passeios

aleatorios este modelo e chamado de Processo Uniforme sobre os inteiros.

A motivac ao desse modelo reside no estudo da dissemina cao de vrus em redes de com-

putadores. Imagine uma sequencia innita de computadores ligados em rede de modo que

cada computador so se comunique com o vizinho `a esquerda ou `a direita. No tempo zero

um unico computador e infectado por um vrus o qual escolhe saltar para o computador

`a esquerda ou `a direita infectando-o. Quando um ou mais vrus chegam a um computa-

dor, este e infectado por um novo vrus que inicia a mesma din amica de saltos. Ao ser

infectado cada computador ativa um antivrus que ira matar qualquer vrus que ali saltar

futuramente. Neste modelo algumas perguntas surgem: Existe probabilidade de innitos

computadadores serem infectados? O que ocorre se criarmos um vrus forte capaz de

sobreviver a um grande n umero de computadores com antivrus?

Teorema 8.1. Considere o Processo Uniforme sobre os inteiros. Este processo morre

quase certamente, isto e, com probabilidade 1 existe um momento a partir do qual n ao

mais existem partculas ativas.

9 Conclusao

Cadeias de Markov, bem como outros processos estoc asticos, estao presentes em diver-

sos problemas onde existem quantidades aleatorias variando com o tempo. Em nosso es-

tudo consideramos um caso particular envolvendo dissemina c ao de vrus em redes de com-

putadores. Este tipo de processo e din amicas de agentes m oveis espalhando informac ao

sobre sistemas computacionais e biologicos tem sido explorado bastante nos ultimos anos.

Referencias

[1] ROBERT, C.; CASELLA, G., Monte Carlo Statistical Methods, Springer; 2

a

edi cao,

2005.

[2] R. Durret , Probability: theory and examples, (2nd edn.), Duxburry, Belmont. Calif.

[3] W. Feller, An Introduction to Probability Theory and its Applications, Wiley, New

York,1966.

[4] Ferrari, P.A. e Galves, Acoplamento em Processos Estoc asticos, Notas para um mini-

curs apresentado na XIII Escuela Venezolana de Matematicas, 2000.

[5] Hoel, P. G., Port, S. C. e Stone, C. J., Introduction to stochastic processes , Waveland

Press,1986.

[6] Norris, J.R., Markov Chains, Cambridge University Press,1998.

[7] Mello, M. P. ; dos Santos, J. P. O. e Murari, I. T.C., Introduc ao ` a an alise com-

binat oria, Editora Ciencia Moderna, 1a Edi cao - 2008.

[8] Martinez, M.Z.; Lebensztayn, E.; Machado, F.P., Random walks systems with kil-

ling on Z, Stochastics An International Journal of Probability and Stochastic Processes:

formerly Stochastics and Stochastics Reports, 2008, Paginas 451 a 457.

[9] RIPLEY, B.D, Stochastic Simulation , Wiley-Interscience,1

a

edicao, 2006.

[10] Ross, S. M. , A rst course in probability , Prentice Hall; 8a edicao , 2009.

[11] Ross, S. M. , Simulation, Academic Press, 4a edicao, 2006.

[12] S.H. Ross , Stochastic Processes, Wiley Series in Probability and Mathematical Statistics,

1996.

[13] D. Stirzaker , Elementary Probability , Cambridge University Press, 2003.

[14] D. Stirzaker , Stochastic Processes and Models, Editora Oxford, 1a edi cao, 2005.

Potrebbero piacerti anche

- Tallyta Carolyne Martins Da Silva Pivic PDFDocumento15 pagineTallyta Carolyne Martins Da Silva Pivic PDFGefté AlcantaraNessuna valutazione finora

- Modelos de Markov e AplicaçõesDocumento22 pagineModelos de Markov e AplicaçõesAntonio Fernando NavarroNessuna valutazione finora

- Cap Itulo 1 Cadeias de Markov: 1.1 Introdu C AoDocumento90 pagineCap Itulo 1 Cadeias de Markov: 1.1 Introdu C AoGiane HiginoNessuna valutazione finora

- Cadeias de Markov para Análise de TemperaturaDocumento26 pagineCadeias de Markov para Análise de TemperaturaBRSDIVECOMNessuna valutazione finora

- Processos Estocásticos e Cadeias de MarkovDocumento83 pagineProcessos Estocásticos e Cadeias de Markovrafa16codNessuna valutazione finora

- Cadeia de MarkovDocumento17 pagineCadeia de MarkovFabryna MeyreNessuna valutazione finora

- Markov PDFDocumento49 pagineMarkov PDFneripereiraNessuna valutazione finora

- Introdução aos Processos Estocásticos e Cadeias de MarkovDocumento18 pagineIntrodução aos Processos Estocásticos e Cadeias de MarkovDiego TrovoNessuna valutazione finora

- Aula # 2 Proceso de Markov (Portegues) OkDocumento60 pagineAula # 2 Proceso de Markov (Portegues) OkAldmiro MuquixeNessuna valutazione finora

- 05 Markov UfprDocumento55 pagine05 Markov UfprErick JandreyNessuna valutazione finora

- Cadeias de Markov e suas aplicaçõesDocumento5 pagineCadeias de Markov e suas aplicaçõesFisico StelioNessuna valutazione finora

- 4.4. Estados AbsorbentesDocumento3 pagine4.4. Estados AbsorbentesmayteNessuna valutazione finora

- Processos de Markov emDocumento34 pagineProcessos de Markov emCelso CiamponiNessuna valutazione finora

- Aula 4 - Cadeia de Markov A Tempo Discreto e Contínuo - RespostaDocumento112 pagineAula 4 - Cadeia de Markov A Tempo Discreto e Contínuo - RespostaEdinelson Sousa JuniorNessuna valutazione finora

- Proc Estocasticos - Cadeias de Markov Po III - Parte I PDFDocumento29 pagineProc Estocasticos - Cadeias de Markov Po III - Parte I PDFMaria AntôniaNessuna valutazione finora

- Processo MarkovianoDocumento71 pagineProcesso MarkovianoAnisio Celso slipcannibalborgirNessuna valutazione finora

- Cadeias de MarkovDocumento7 pagineCadeias de MarkovJULIANA DA SILVA NOGUEIRA CARVALHONessuna valutazione finora

- Cadeia de Markov em Tempo ContinuoDocumento19 pagineCadeia de Markov em Tempo ContinuoFelicio MugauaNessuna valutazione finora

- Cadeias e Processos de MarkovDocumento83 pagineCadeias e Processos de MarkovIan Rodrigues NunesNessuna valutazione finora

- Avaliação de Desempenho da Cadeia de Markov a Tempo DiscretoDocumento126 pagineAvaliação de Desempenho da Cadeia de Markov a Tempo DiscretoPablo SousaNessuna valutazione finora

- Processos Estocasticos e Cadeias de MarkovDocumento48 pagineProcessos Estocasticos e Cadeias de MarkovLuis MouraNessuna valutazione finora

- teste1Documento2 pagineteste1Beatriz DiasNessuna valutazione finora

- Sobre As Cadeias de MarkovDocumento12 pagineSobre As Cadeias de MarkovRosaG.Márquez100% (1)

- Exerci Cio SpeaDocumento19 pagineExerci Cio SpeaJosé MuiangaNessuna valutazione finora

- Cadeias de Markov: introdução e propriedadesDocumento28 pagineCadeias de Markov: introdução e propriedadesLuciano SilvaNessuna valutazione finora

- Cadeias de Markov - Bruno Rizzo Kasinof RA 094686Documento18 pagineCadeias de Markov - Bruno Rizzo Kasinof RA 094686Bruno R. KasinofNessuna valutazione finora

- 2023 01 23 NA MecEstDocumento39 pagine2023 01 23 NA MecEstEduardo EmanuelNessuna valutazione finora

- Cadeias de Markov e matrizes de transiçãoDocumento9 pagineCadeias de Markov e matrizes de transiçãoMarcelo AlmeidaNessuna valutazione finora

- Cadeias de Markov PDFDocumento13 pagineCadeias de Markov PDFFernanda AzevedoNessuna valutazione finora

- Trabalho de HaleDocumento21 pagineTrabalho de HaleReplay adellNessuna valutazione finora

- 3 - Formalismo LagrangianoDocumento11 pagine3 - Formalismo LagrangianoTharcísyo SáNessuna valutazione finora

- Capítulo 3Documento17 pagineCapítulo 3Abdul Jabar NdjandjeNessuna valutazione finora

- B2.a Avaliacaob PROCESSO ESTOCASTICO 14-07-23Documento2 pagineB2.a Avaliacaob PROCESSO ESTOCASTICO 14-07-23Arthur Henrique MartinsNessuna valutazione finora

- List A 2Documento2 pagineList A 2Luca PariseNessuna valutazione finora

- Decomposição Do Espaço de Estados - Cadeias de MarkovDocumento24 pagineDecomposição Do Espaço de Estados - Cadeias de MarkovJULIANA DA SILVA NOGUEIRA CARVALHONessuna valutazione finora

- Aula 7 ManutençãoDocumento16 pagineAula 7 ManutençãoAtaís BatistaNessuna valutazione finora

- Comentado Bloco3 01Documento5 pagineComentado Bloco3 01Marvin MartinsNessuna valutazione finora

- Cadei A Markov 3Documento41 pagineCadei A Markov 3Lázaro NogueiraNessuna valutazione finora

- Modelagem Sistemas DiscretosDocumento19 pagineModelagem Sistemas DiscretosAdryane MaraNessuna valutazione finora

- Análise Complexa IIIDocumento74 pagineAnálise Complexa IIIjoaofaroNessuna valutazione finora

- Exerciciospea PDFDocumento19 pagineExerciciospea PDFRicardo Lopes de AndradeNessuna valutazione finora

- MAT4154 33A Grupo5 T3 23 2Documento18 pagineMAT4154 33A Grupo5 T3 23 2ClóvisNessuna valutazione finora

- Monografia - Pedro - SchroedingerCatDocumento3 pagineMonografia - Pedro - SchroedingerCatRaiton KillerNessuna valutazione finora

- Notas de Aula sobre Regressão EstatísticaDocumento22 pagineNotas de Aula sobre Regressão EstatísticaJosias-aaaNessuna valutazione finora

- Processos Estocásticos e Cadeias de MarkovDocumento58 pagineProcessos Estocásticos e Cadeias de Markovgutoinfo2009Nessuna valutazione finora

- Aplicações de Processos EstocásticosDocumento1 paginaAplicações de Processos EstocásticosEric AlbertoNessuna valutazione finora

- Calculoiv PDFDocumento65 pagineCalculoiv PDFMatheus AnjosNessuna valutazione finora

- Prova de Processos EstocásticosDocumento6 pagineProva de Processos EstocásticosIoneide SoaresNessuna valutazione finora

- Redes Neurais Artificiais - Lista de ExercíciosDocumento4 pagineRedes Neurais Artificiais - Lista de ExercíciosRomeu BerthoNessuna valutazione finora

- Galoa Proceedings Sbai 2019 108395Documento6 pagineGaloa Proceedings Sbai 2019 108395Jadson SouzaNessuna valutazione finora

- Prova Est. Não ParamDocumento2 pagineProva Est. Não ParamAlvaroNessuna valutazione finora

- Miei Meio Cap1Documento49 pagineMiei Meio Cap1Leonardo Araujo FreitasNessuna valutazione finora

- Física Estatística: Bases e Conceitos FundamentaisDocumento19 pagineFísica Estatística: Bases e Conceitos FundamentaisLinoNessuna valutazione finora

- Lista MarkovDocumento5 pagineLista MarkovGuilhermeNessuna valutazione finora

- Lagrangiana de sistemas com vínculosDocumento4 pagineLagrangiana de sistemas com vínculosMarcos BenícioNessuna valutazione finora

- MEC EST ESTAT 2020-2Documento16 pagineMEC EST ESTAT 2020-2Jackson BackupNessuna valutazione finora

- SLIDES Selecção de Variáveis 2019-20Documento11 pagineSLIDES Selecção de Variáveis 2019-20Daniel EuzébioNessuna valutazione finora

- Cap Itulo 2 Infer Encia em Cadeias de Markov: 2.1 Estima C Ao Da Matriz de Transi C AoDocumento28 pagineCap Itulo 2 Infer Encia em Cadeias de Markov: 2.1 Estima C Ao Da Matriz de Transi C AoGiane HiginoNessuna valutazione finora

- Arquivo TextoparaanpuhDocumento8 pagineArquivo TextoparaanpuhJuarez Mazzuca JuniorNessuna valutazione finora

- Probabilidade, Estatística e Processos EstocásticosDocumento258 pagineProbabilidade, Estatística e Processos EstocásticospamcostaNessuna valutazione finora

- ARTIGO Sobre o INFINITO Prof. Juarez Mazzuca JúniorDocumento30 pagineARTIGO Sobre o INFINITO Prof. Juarez Mazzuca JúniorJuarez Mazzuca JuniorNessuna valutazione finora

- Obra de Pedro HispanoDocumento7 pagineObra de Pedro HispanoGabriel NascimentoNessuna valutazione finora

- Termos de Uso Saraiva ReaderDocumento10 pagineTermos de Uso Saraiva ReaderJuarez Mazzuca JuniorNessuna valutazione finora

- Psicogênese Do Infinito Crianças Entendem 000396266Documento1 paginaPsicogênese Do Infinito Crianças Entendem 000396266Juarez Mazzuca JuniorNessuna valutazione finora

- Dicionário de Filosofia de Ferrater MoraDocumento302 pagineDicionário de Filosofia de Ferrater MoraoliversantiniNessuna valutazione finora

- Magus Francis BarrettDocumento250 pagineMagus Francis BarrettCristiano Messias Winchester86% (14)

- TAUTOLOGIA ApostilaDocumento40 pagineTAUTOLOGIA ApostilaJuarez Mazzuca JuniorNessuna valutazione finora

- KANT Fundamentação Da Metafisica Dos CostumesDocumento50 pagineKANT Fundamentação Da Metafisica Dos CostumesFillipe Pereira100% (2)

- Termos de Uso Saraiva Digital Reader - 13.07.10Documento10 pagineTermos de Uso Saraiva Digital Reader - 13.07.10Christos Dimitrios ChristakouNessuna valutazione finora

- DicasiteacoesDocumento1 paginaDicasiteacoesJuarez Mazzuca JuniorNessuna valutazione finora

- A Razao e o TempoDocumento210 pagineA Razao e o TempojoaogorgeNessuna valutazione finora

- LIVRO Educacao1Documento293 pagineLIVRO Educacao1Roberto Muñoz SotoNessuna valutazione finora

- Plano Anual de Física 1 AnoDocumento4 paginePlano Anual de Física 1 AnoFrancisco Jaborandi100% (1)

- Questões - Geometria AnalíticaDocumento7 pagineQuestões - Geometria AnalíticaAna CarolinaNessuna valutazione finora

- Apostila Concurso Ibge 2011 PDFDocumento4 pagineApostila Concurso Ibge 2011 PDFglertNessuna valutazione finora

- Experimento tubo Venturi determina velocidade águaDocumento5 pagineExperimento tubo Venturi determina velocidade águaRodrigo MatheusNessuna valutazione finora

- Escola Municipal - 1o Trabalho de Matemática 6o AnoDocumento3 pagineEscola Municipal - 1o Trabalho de Matemática 6o AnoWhesley Campos SousaNessuna valutazione finora

- Fibonacci Ratios With Pattern Recognition - Larry PesaventoDocumento184 pagineFibonacci Ratios With Pattern Recognition - Larry Pesaventowillian alvesNessuna valutazione finora

- Cálculo de incertezas e distribuição de dados em histogramasDocumento18 pagineCálculo de incertezas e distribuição de dados em histogramasVictor MagalhãesNessuna valutazione finora

- Avaliação Unificada Matemática 1º Bimestre 3º Ano 2022Documento4 pagineAvaliação Unificada Matemática 1º Bimestre 3º Ano 2022Janaina Borba100% (1)

- Como Projetar Rampas - ArquitetônicoDocumento5 pagineComo Projetar Rampas - ArquitetônicoElaine MachadoNessuna valutazione finora

- Lista de Exercícios 01 - D2 - AlunoDocumento2 pagineLista de Exercícios 01 - D2 - Alunoriansalesbilly2100% (1)

- Avaliando o Impacto Da Olimpíada Brasileira de Matemática Das Escolas Públicas (OBMEP)Documento22 pagineAvaliando o Impacto Da Olimpíada Brasileira de Matemática Das Escolas Públicas (OBMEP)Luiz Rodrigues Da Silva FilhoNessuna valutazione finora

- Edital TJRJ TécnicoDocumento13 pagineEdital TJRJ TécnicoDiêgo MatosNessuna valutazione finora

- Configurações e dicas para o Primavera ExpressDocumento38 pagineConfigurações e dicas para o Primavera ExpressSandraCordeiroNessuna valutazione finora

- MANAD manual arquivos digitais SRPDocumento32 pagineMANAD manual arquivos digitais SRPnelson_sda1479Nessuna valutazione finora

- Avaliação 7º Ano - InicialDocumento6 pagineAvaliação 7º Ano - InicialLeonardo SilvaNessuna valutazione finora

- Hidraulica 11 08Documento20 pagineHidraulica 11 08Marcelo NettoNessuna valutazione finora

- TemaIII A Numeros ComplexosDocumento81 pagineTemaIII A Numeros ComplexosandrewsgalenoNessuna valutazione finora

- Ativade ExcelDocumento12 pagineAtivade ExcelSombeRNessuna valutazione finora

- Discalculia ManualDocumento61 pagineDiscalculia ManualDaniela Reis100% (2)

- Dinâmica Dos Fluídos - Perda de Carga (3 e 4)Documento12 pagineDinâmica Dos Fluídos - Perda de Carga (3 e 4)Thiago SilvaNessuna valutazione finora

- Microsoft Word - Tema 1 - Geração, Transmissão e Distribuição de Energia ElDocumento9 pagineMicrosoft Word - Tema 1 - Geração, Transmissão e Distribuição de Energia ElInes Félix FélixNessuna valutazione finora

- Calculo AtuarialDocumento3 pagineCalculo AtuarialCésar ArraisNessuna valutazione finora

- Componentes e identificação de correntesDocumento36 pagineComponentes e identificação de correntesAnselmo Macedo CerqueiraNessuna valutazione finora

- ADocumento90 pagineAvandermatNessuna valutazione finora

- Símbolos e identificação de instrumentação em diagrama P&IDocumento4 pagineSímbolos e identificação de instrumentação em diagrama P&INeli Dos Santos RobertoNessuna valutazione finora

- Dilatação térmica de sólidos e líquidosDocumento3 pagineDilatação térmica de sólidos e líquidosLucas Meiado SouzaNessuna valutazione finora

- Diagrama de Força Cortante e Momento FletorDocumento3 pagineDiagrama de Força Cortante e Momento FletordantelinoNessuna valutazione finora

- Medição indireta de distâncias e altimetriaDocumento44 pagineMedição indireta de distâncias e altimetriaThalita RamanaNessuna valutazione finora

- Teste Chi-Quadrado de Pearson - Wikipédia, A Enciclopédia LivreDocumento4 pagineTeste Chi-Quadrado de Pearson - Wikipédia, A Enciclopédia LivreRiolando dos SantosNessuna valutazione finora