Documenti di Didattica

Documenti di Professioni

Documenti di Cultura

IBM Quality Stage

Caricato da

Carlos TakanoCopyright

Formati disponibili

Condividi questo documento

Condividi o incorpora il documento

Hai trovato utile questo documento?

Questo contenuto è inappropriato?

Segnala questo documentoCopyright:

Formati disponibili

IBM Quality Stage

Caricato da

Carlos TakanoCopyright:

Formati disponibili

GESTIN DE CALIDAD DE DATOS E INFORMACIN MBA UQAM - Concentracin en informtica Trabajo individual Anlisis de una herramienta de software para

limpieza de datos: IBM InfoSphere QualityStage Carlos Takano ___________________ Resumen Este trabajo tiene como propsito ofrecer una perspectiva general de la problemtica de calidad de datos que enfrentan muchas organizaciones, cmo enfrentar el problema desde la perspectiva de la limpieza de datos y qu funcionalidad ofrecen las herramientas especializadas para este propsito, especficamente IBM InfoSphere QualityStage.

Justificacin Actualmente vivimos en un mundo cada vez ms interconectado y digitalizado. Disponemos de transpondedores y sensores de bajo costo, que se pueden implantar fcilmente en todo tipo de objetos: autos, mercaderas, medicinas, incluso animales. Por otro lado, la ubicuidad de las redes de comunicaciones permite interconectar estos objetos para que participen en procesos automatizados, dando lugar al Internet de las cosas, como lo llam Kevin Ashton. Tambin tenemos infraestructuras computacionales capaces de manejar y procesar, cada vez a mayor velocidad, grandes volmenes de datos, tanto estructurados como no estructurados, como imgenes, audio, video y documentos. Esta abundancia de datos, sin embargo, no siempre da como resultado que los ejecutivos y trabajadores del conocimiento tengan mejor informacin sobre lo que pasa en las organizaciones y su entorno, que necesitan para decidir qu acciones tomar, cuando buscan mejorar la posicin competitiva de sus empresas, atacar un problema o aprovechar una oportunidad. Esto ocurre porque, con frecuencia, los datos no cumplen los requisitos de calidad necesarios para producir buena informacin, ocasionando sobrecostos imputables a diversas categoras, como decisiones inadecuadas, oportunidades de negocio perdidas, 1

incumplimiento de regulaciones, errores al ejecutar procesos, trabajo para detectar y corregir defectos en los datos, acciones preventivas para evitar que los datos contengan errores, por ejemplo. La calidad de los datos es un problema amplio y complejo, que comprende varias dimensiones y se presenta por diversas causas. Si bien es cierto que, en general, lo ideal es eliminar las causas de los problemas, en el caso de la calidad de los datos, ello no siempre es viable. Por ejemplo, si los datos son generados por un tercero sobre el que no se tiene control y no existe una fuente ms adecuada para cubrir la necesidad, o cuando el costo de hacer las modificaciones necesarias a los sistemas preexistentes es prohibitivo, la nica opcin que resta es detectar los defectos y corregir los datos. A veces, las nicas acciones correctivas posibles implican realizar algn tipo de proceso manual, que suele ser lento, costoso y propenso a errores; sin embargo, cuando se cumplen ciertas condiciones, es posible utilizar aplicaciones de software especializadas, como IBM InfoSphere QualityStage, para automatizar en su totalidad o en su mayora el proceso de limpieza de datos; esto permite obtener mejores resultados sobre la calidad de los datos, implementar un proceso repetible, adaptable y fcil de gestionar, y reducir el costo y el riesgo.

Objetivo Evaluar las capacidades de IBM InfoSphere QualityStage en relacin con las necesidades empresariales de limpieza de datos.

Problemtica de calidad de los datos Como ya se mencion, la calidad de los datos es un problema amplio y complejo, que comprende varias dimensiones y se presenta por diversas causas. Las dimensiones antes mencionadas son los distintos aspectos por los que es conveniente evaluar la calidad de los datos, siendo los principales: exactitud, completitud, oportunidad y consistencia. La exactitud se define como la cercana entre un dato y la representacin correcta del fenmeno real que representa, y puede ser sintctica o semntica. La primera evala los datos respecto del dominio de definicin correspondiente, es decir, el conjunto de valores 2

considerados vlidos; la segunda lo hace tomando como referencia el valor real, lo que normalmente es ms complejo de evaluar que la anterior. Cuando se tiene la certeza de que la proporcin de errores es relativamente baja, y que en su mayora se originan en errores mecanogrficos, la exactitud sintctica tiende a coincidir con la exactitud semntica, y es aceptable reemplazar un dato considerado errado con el valor ms cercano que pertenezca al dominio de definicin (Batini & Scannapieca, 2006). Esto se puede automatizar utilizando funciones de comparacin, como la distancia de edicin, que se basa en la cantidad mnima de caracteres que se debe insertar, eliminar, reemplazar o transponer para convertir el dato bajo evaluacin en un valor que pertenece al dominio de definicin, o un algoritmo basado en una representacin fontica del dato bajo evaluacin. La completitud se puede evaluar desde tres perspectivas: el esquema, un atributo o la poblacin (Batini & Scannapieca, 2006). En la primera, interesa saber si todas las entidades y atributos de inters forman parte del modelo o estructura de datos; en la segunda, se mide los valores faltantes para un atributo en particular a travs de todas las instancias de una entidad, por ejemplo cuntos trabajadores de una empresa no tienen registrado en la base de datos correspondiente un nmero vlido de DNI; en la tercera, la evaluacin se concentra en instancias o individuos faltantes respecto de un universo o poblacin de referencia, por ejemplo, en la tabla donde se registra los datos de los empleados de una empresa debe existir exactamente una fila por cada empleado real. La completitud del esquema depende de la calidad el diseo, lo que est fuera del alcance de las herramientas de limpieza de datos, motivo por el cual no se abundar sobre el tema. Sobre la completitud de atributos, tenemos que, dentro del contexto de la calidad de los datos, no todos los valores faltantes tienen el mismo significado. Por ejemplo, si se trata de una tabla de personas en una base de datos relacional, donde un valor nulo representa un valor faltante, se puede registrar lcitamente un valor nulo para la direccin de correo electrnico bsicamente por una de tres razones: 1) la persona no tiene direccin de correo electrnico, en cuyo caso el dato no est incompleto, 2) la persona tiene direccin de correo electrnico, pero no se sabe cul es, y 3) no se sabe si la persona tiene o no direccin de correo electrnico (Batini & Scannapieca, 2006). Esta ambigedad hace difcil automatizar la limpieza de datos en esta situacin, ya que para saber cul es el valor real, 3

hace falta alguna fuente de referencia, que no siempre est disponible o no tiene la suficiente credibilidad. Esto ltimo aplica tambin para evaluar si las instancias o individuos de una entidad representan al universo o poblacin total. La oportunidad se refiere a que los datos deben reflejar con prontitud los cambios que ocurren en el mundo real, de manera que el valor actualizado est disponible en el momento que se requiere. Si los datos se actualizan despus del momento en que se requiere usarlos, entonces no son oportunos. Un concepto relacionado con la oportunidad es la volatilidad, que mide la frecuencia con que los datos varan: cuanto ms voltil es un dato, es ms complejo mantenerlo oportunamente actualizado, ya que su periodo de vigencia es ms corto (Batini & Scannapieca, 2006). La consistencia se refiere al cumplimiento de reglas de integridad lgica de los datos (Batini & Scannapieca, 2006). Por ejemplo, si el estado civil de una persona es Casado, su edad no puede ser menor que 14 aos, o la fecha en que termina una promocin no puede ser menor que su fecha de inicio. La verificacin de reglas de este tipo es apropiada para ser implementada en una herramienta de software; sin embargo, no debe pasarse por alto que definir el conjunto correcto, completo y autorizado de reglas que represente las verdaderas necesidades y caractersticas del negocio es una tarea difcil y compleja . Es comn encontrar mltiples bases de datos en una organizacin, donde los datos de cada una estn estructurados segn las reglas particulares de cada una (Reid & Catterall, 2005), que no necesariamente son compatibles entre s.

Herramientas para limpieza de datos Una de las posibles soluciones al problema de datos de baja calidad es implementar un proceso de limpieza de datos (en ingls, data cleansing, data cleaning o data scrubbing), cuya finalidad es brindar consistencia a los diferentes conjuntos de datos que pueden haber sido creados bajo reglas diferentes e incompatibles (Reid & Catterall, 2005). La limpieza de datos se ocupa de los problemas de datos una vez que ya han ocurrido, considerando que las estrategias de prevencin de errores pueden reducir muchos problemas, pero no eliminarlos (Van den Broeck, Cunningham, Eeckels, & Herbst, 2005). Si bien es

cierto que no todos los errores en los datos pueden ser corregidos automticamente, las herramientas de limpieza de datos ofrecen funcionalidad que permite: Analizar patrones en los datos existentes, para comprender la naturaleza, alcance y detalle de los problemas de calidad de datos. Estandarizar y corregir los datos, para asegurar que su formato y contenido cumple con las especificaciones aplicables a toda la organizacin. Detectar posibles duplicados (anlisis de coincidencias o data matching), para identificar registros duplicados entre fuentes de datos y dentro de ellas. Este es uno de los problemas ms frecuentes y que representan altos costos para las empresas (Eckerson, 2002). Consolidar registros duplicados, que consiste en crear la mejor versin posible del registro que sobrevivir y eliminar los dems, combinando de manera inteligente los datos disponibles. Esto brinda la oportunidad de completar algunos datos faltantes y corregir otros en base a la evaluacin y comparacin de los registros duplicados. Enriquecer los datos, complementando la informacin existente utilizando fuentes de referencia externas. Si se tiene acceso a una fuente de datos considerada confiable, por ejemplo la base de datos de identificacin del RENIEC, se puede aadir atributos adicionales a los datos que ya se tienen.

Estandarizacin de datos En muchas fuentes de datos existen elementos de datos que contienen informacin encubierta, difcil de encontrar e interpretar, como los campos de texto libre utilizados para almacenar direcciones postales, nombres de personas, nombres de empresas y descripciones de productos, entre otros. El texto libre permite que los operadores ingresen los datos sin respetar estndares. Por ejemplo, en el caso de una direccin, se puede utilizar diferentes abreviaturas para el mismo trmino, ingresar los elementos en diferente orden, omitir algunos de ellos, etc. Una direccin es un dato que puede descomponerse en varios elementos, como un tipo de va, un nombre de va, un nmero municipal, un nmero de interior, una urbanizacin, un distrito, una provincia y un departamento, por ejemplo.

La estandarizacin consiste transformar el contenido de estos campos, separndolo en elementos sencillos que tengan slo un tipo especfico de informacin (componentes lxicos o tokens), con el fin obtener como resultado una representacin que tenga un formato consistente. En este proceso, tambin se convierte trminos que tienen varias formas de escribirse, pero el mismo significado, a una forma estndar preferida. Por ejemplo, las abreviaturas Ca., CA, CL y Cl., que significan Calle, se pueden convertir a la forma preferida Ca.. Esta caracterstica permite tambin corregir algunos errores mecanogrficos, por ejemplo, convertir Carlso en Carlos, todo esto a travs de reglas configurables.

Anlisis de coincidencias (data matching, object identification o record linking) Cuando existen canales independientes e incompatibles para registrar datos sobre el mismo concepto de negocio, incrementa la probabilidad de que existan varios registros de datos que se refieren al mismo objeto o persona del mundo real. Por ejemplo, cuando se registra ms de una vez la misma persona creando diferentes cdigos de cliente. Esto lleva a tener una visin fragmentada de la informacin, que carece de integracin y consistencia, limitando su valor para la organizacin. La solucin ideal debera atacar esta causa raz; sin embargo, esto no siempre es viable, ya que para lograrlo, por lo general, se requiere realizar cambios costosos, riesgosos y complejos en los sistemas de informacin, por ejemplo, con una iniciativa para gestionar datos maestros (MDM, por las siglas de Master Data Management). Si no es posible resolver el problema de registros duplicados en su origen, una alternativa es realizar un anlisis de coincidencias o (en ingls, data matching, object identification o record linkage), que es probablemente la actividad de calidad de los datos ms importante y ampliamente estudiada (Batini & Scannapieca, 2006). Por ejemplo, si se tiene los datos mostrados en la siguiente tabla: N Nombre 1 2 GARCIA, FRANCISCO JAVIER WONG, MILAGROS ANA Direccin CALLE ALFA 528 JAVIER PRADO OESTE 2499 Zona postal LIMA 41 LIMA 27 6

3 4 5 6 7

GARZA, FRANCISCO X. GARCIAA, FRANCIS MENCHELLI, JUAN CARLOS WONG, M. GARCIA, SUSANA

CALLE ALFA 528 CL ALFA 528 AV. AREQUIPA 340 AV. JAVIER PRADO 2499 CL ALFA 528

LIMA 41 LIMA 41 LIMA 1 LIMA 27 LIMA 41

Es probable que los registros 1, 3 y 4 correspondan a la misma persona, lo mismo ocurre con los registros 2 y 6. El anlisis de coincidencias, entonces, no slo debe buscar coincidencias exactas, tambin aproximadas. A esto se debe aadir que no siempre se cuenta con un identificador confiable que permita discriminar con seguridad si se trata del mismo individuo o no, como en el ejemplo mostrado. En trminos generales, el proceso funciona de la siguiente manera (Batini & Scannapieca, 2006): Estandarizar los datos para corregir errores simples y facilitar la comparacin. Reducir el espacio de bsqueda, utilizando un criterio general para identificar grupos de posibles duplicados. En el ejemplo mostrado, si se utiliza el apellido para este propsito, se podra identificar tres grupos: registros 1, 3, 4 y 7; registros 2 y 6; registro 5. Esto se realiza con el fin de minimizar la cantidad de registros que pasan por un proceso ms fino de comparacin. Si no se realizara esta etapa, cada registro debera compararse contra todos los dems registros de todas las fuentes de entrada, lo que puede requerir recursos de procesamiento significativos si se tiene un alto volumen de registros, como es normalmente el caso. Aplicar funciones de comparacin al interior de cada grupo de posibles duplicados, comparando cada registro del grupo contra todos los dems. Estas funciones deben proporcionar como resultado un indicador que exprese la distancia entre los registros de cada grupo. Cuanto menor sea la distancia, mayor ser la probabilidad de que se trate de una coincidencia. Aplicar un modelo de decisin para determinar, dentro de cada grupo, qu registros definitivamente coinciden, qu registros definitivamente no coinciden y qu registros son probables coincidencias y deben pasar por un nuevo ciclo o ser revisados por una persona, que tomar la decisin correspondiente. 7

Revisar los resultados del proceso y, de ser necesario, iniciar un nuevo ciclo de procesamiento, tomando un criterio diferente para reducir el espacio de bsqueda.

Generalidades de IBM InfoSphere QualityStage IBM InfoSphere QualityStage forma parte de la plataforma de integracin de datos IBM InfoSphere Integration Server. Goza de integracin completa con otros productos de esta plataforma, incluyendo metadatos, reglas de transformacin y monitoreo compartidos La funcionalidad principal que ofrece, centrada en la automatizacin del proceso de limpieza de datos, es la siguiente: Investigar los datos fuente para comprender la naturaleza, alcance y detalle de los problemas de calidad de datos. Estandarizar los datos para asegurar que su formato y contenido cumple con las especificaciones aplicables a toda la organizacin, incluyendo estndares para nombres de personas y empresas y limpieza y verificacin de direcciones postales. Anlisis de coincidencias, para identificar registros duplicados entre conjuntos de datos y dentro de ellos. Supervivencia de registros, para eliminar los registros duplicados y crear la mejor versin a partir de los datos disponibles. Es una herramienta de nivel empresarial, que puede procesar datos sobre una plataforma de procesamiento en paralelo masivo, lo que brinda escalabilidad y desempeo ptimo.

Capacidades de IBM InfoSphere QualityStage Investigacin de datos La investigacin de datos en IBM InfoSphere QualityStage permite comprender las caractersticas de los datos fuente, ayuda a determinar qu problemas de calidad y posibles anomalas existen y qu reglas de estandarizacin se debe aplicar y brinda informacin til para hacer un estimado inicial del esfuerzo requerido en la implementacin de los procesos de limpieza de datos. 8

Esta capacidad se puede utilizar tambin para hacer seguimiento a la calidad de los datos una vez implementados los procesos automatizados de limpieza. IBM InfoSphere QualityStage ofrece dos tipos de investigacin: de caracteres y de palabras. En la investigacin de caracteres, si el diseo indica que un campo debe almacenar, por ejemplo, un nmero telefnico, la herramienta determina los patrones presentes en los datos y la frecuencia con que se presentan. En este ejemplo, podra encontrarse patrones formados por siete dgitos consecutivos (9999999), por un grupo de tres y un grupo de cuatro dgitos separados por un guin (999-9999) y algn patrn inesperado (por ejemplo, que incluya alguna letras en lugar de nmeros), lo que permite determinar cuntos registros que no cumplen el formato esperado existen. Tambin es posible determinar la frecuencia con que ocurre cada valor individual, permitiendo detectar que se utilizan valores diferentes para representar el mismo significado. Por ejemplo, un campo para almacenar el gnero de una persona podra tener los valores esperados M (masculino) y F (femenino), pero tambin H (hombre), valores nulos o en blanco o cualquier otro valor que no corresponde al dominio de definicin terico. La investigacin de palabras utiliza las tcnicas de estandarizacin que se describen en el siguiente acpite. Ofrece reportes que muestran los patrones de datos, realizando el anlisis por componentes lxicos o tokens, no por caracteres como en el caso anterior, as como la frecuencia de ocurrencia de cada valor individual. Esto facilita la personalizacin de las reglas de anlisis lxico o parsing que se debe usar para estandarizar los datos ms adelante, que implica un esfuerzo importante y significativo en un proyecto de limpieza de datos.

Estandarizacin de datos La estandarizacin de datos en IBM InfoSphere QualityStage permite acondicionar los datos y prepararlos para otros usos, como obtener informacin de soporte a la toma de decisiones y detectar posibles registros duplicados. Acondicionar los datos significa hacer que todas las instancias del mismo tipo de datos, por ejemplo, una direccin o la descripcin de un producto, tengan una representacin consistente, con la misma estructura y formato, respetando un estndar para las abreviaturas, entre otras caractersticas. 9

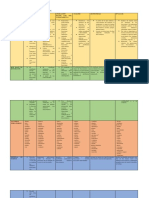

Para realizar la estandarizacin, IBM InfoSphere QualityStage se basa en archivos de reglas, que permiten definir: Clases de datos, miembros y versiones estandarizadas. Por ejemplo, para el tipo de va podemos tener: Clase Tipo de va Tipo de va Tipo de va Tipo de va Tipo de va Tipo de va Tipo de va Miembro AV AV. AVE AVE. CA CA. CL Forma estndar AV AV AV AV CL CL CL

Reglas de estandarizacin, que contienen la lgica que se debe ejecutar cuando los datos de entrada corresponden a un patrn. Estas reglas se escriben en un lenguaje propietario, de propsito especfico, denominado Pattern Action Language. Esto permite implementar reglas complejas para realizar el anlisis lxico o parsing.

IBM InfoSphere QualityStage incluye archivos de reglas de nombres, direcciones y organizacin poltico-administrativa para varios pases. Estas reglas son un punto de partida que se puede personalizar segn las necesidades especficas de cada proyecto. Al realizar la estandarizacin, es posible aadir atributos adicionales a cada registro para facilitar la creacin de bloques con posibles duplicados que es la etapa siguiente en el proceso de limpieza de datos. Por ejemplo, si se trata de nombres de personas, IBM InfoSphere QualityStage puede determinar si se trata de un hombre o una mujer y aadir el atributo correspondiente al resultado.

Anlisis de coincidencias Una vez que los datos han pasado por el proceso de estandarizacin, quedan listos para el anlisis de coincidencias o matching. Esto puede servir para identificar duplicados o para 10

otras aplicaciones que requieran agrupar individuos segn alguna caracterstica comn, por ejemplo, realizar un anlisis de las compras realizadas por un grupo de personas que pertenecen al mismo hogar. Una vez agrupados los datos, es posible enriquecerlos incluyendo atributos adicionales de fuentes de referencia externas. Para realizar el anlisis, IBM InfoSphere QualityStage utiliza mltiples criterios, como el contenido de informacin, la completitud, la confiabilidad, la frecuencia contextual y la representacin de los datos (IBM Corporation, 2011). El contenido de informacin se refiere a que no todos los atributos ni todos los valores tienen el mismo poder para establecer qu registros son similares y cules no. Por ejemplo, el poder discriminante de un apellido es menor que el de un nmero de DNI. Si identificamos dos personas que se apellidan Espinoza, la probabilidad de que se trate de la misma persona es mucho menor que si identificamos dos registros que tienen el DNI N 07728277. De la misma manera, si consideramos slo el dato del apellido, si dos personas se apellidan Jimnez (un apellido frecuente), es menos probable que se trate de la misma persona que si el apellido es Kucz ynski (menos comn). Para esto, IBM InfoSphere QualityStage ofrece herramientas que determinan la frecuencia con que ocurren los trminos a utilizar para el anlisis de coincidencias. IBM InfoSphere QualityStage ofrece ms de veinticinco funciones de comparacin, incluyendo comparaciones exactas, diversos algoritmos para calcular aproximaciones en datos textuales, numricos, fechas y espaciales y el uso de fuentes de referencia. Otro factor de suma importancia es elegir adecuadamente los criterios para establecer los grupos de posibles coincidencias. IBM InfoSphere QualityStage realiza la comparacin slo entre miembros del mismo grupo, para optimizar el uso de recursos computacionales. Si se usa un criterio que incluye individuos con baja probabilidad de coincidencia en el mismo grupo, el procesamiento demandar recursos en exceso. Si se usa un criterio demasiado restrictivo, se puede producir un exceso de falsos negativos, lo que ocurre cuando se identifica como nico un registro que en verdad est duplicado, porque su par pertenece a otro bloque. En este aspecto, IBM InfoSphere QualityStage brinda mucha flexibilidad para definir los criterios para crear bloques. Se puede hacer combinando varias columnas, incluyendo columnas especiales que genera el proceso de estandarizacin para 11

este propsito, como la representacin fontica de un dato utilizando algoritmos como NYSIIS y Soundex. Tambin es importante es asignar correctamente los puntos de corte para determinar qu registros calificar como coincidencias y qu registros considerar como no coincidencias. Entre esto dos extremos, hay zonas grises, en cuyo caso los registros deben ser revisados por una persona o pasar por un nuevo ciclo de anlisis utilizando un criterio diferente para crear bloques. Esto se ilustra en la siguiente figura:

Tomado de (IBM Corporation, 2011) En la figura, Low cutoff corresponde al valor de corte por debajo del cual se considera no coincidencia y High cutoff corresponde al valor de corte por encima del cual se considera coincidencia. La zona denominada Clericalcorresponde a los casos dudosos en los que se debe realizar procesos adicionales o tomar la decisin en forma manual. IBM InfoSphere QualityStage ofrece herramientas para disear procesos de anlisis de coincidencias con varias pasadas, para mejorar la confiabilidad al identificar coincidencias. Las pasadas pueden ser dependientes (los resultados de cada una se calculan teniendo en cuenta los anteriores) o independientes (los resultados de cada una se calculan sin tener en cuenta los anteriores). 12

Otra caracterstica de inters es que se puede definir procesos de anlisis de coincidencias utilizando fuentes de referencia externa, lo que permite enriquecer los datos poblando atributos con valores obtenidos de la fuente de referencia.

Consolidacin de registros duplicados Una vez realizado el anlisis de coincidencias, muchas veces es necesario procesar los grupos de registros duplicados para obtener una versin nica, el registro sobreviviente, combinando de manera inteligente los mejores datos disponibles, por ejemplo completando algunos datos faltantes y corregir otros en base a la evaluacin y comparacin de los registros duplicados. Para este propsito, IBM InfoSphere QualityStage ofrece diferentes tcnicas, por ejemplo: tomar el registro ms reciente o el ms antiguo, tomar el valor ms largo o el ms corto, el valor ms frecuente, comparar con un valor de referencia, segn la fuente de datos.

Conclusiones La calidad de los datos se debe estudiar y atacar desde diferentes perspectivas, como la exactitud, la completitud, la oportunidad y la consistencia. Dentro de los problemas de calidad de los datos, uno de los problemas ms frecuentes e importantes, que representan altos costos para las empresas, pero a la vez uno de los ms estudiados es la presencia de registros duplicados. La limpieza de datos se ocupa de los problemas de datos una vez que ya han ocurrido, pero es una solucin conveniente cuando no es viable tcnica o econmicamente atacar las causas raz. En general, las capacidades que ofrecen las herramientas especializadas en limpieza de datos son: o Analizar patrones en los datos existentes, para comprender la naturaleza, alcance y detalle de los problemas de calidad de datos.

13

o Estandarizar y corregir los datos, para asegurar que su formato y contenido cumple con las especificaciones aplicables a toda la organizacin. o Detectar posibles duplicados entre fuentes de datos y dentro de ellas. o Consolidar registros duplicados, creando la mejor versin posible del registro que sobrevivir y eliminar los dems, combinando de manera inteligente los datos disponibles. o Enriquecer los datos, complementando la informacin existente utilizando fuentes de referencia externas. IBM InfoSphere QualityStage es una herramienta til para resolver problemas comunes de calidad de datos, ya que permite automatizar en su totalidad o en su mayora el proceso de limpieza de datos; esto permite obtener mejores resultados sobre la calidad de los datos, implementar un proceso repetible, adaptable y fcil de gestionar, y reducir el costo y el riesgo. Bibliografa Alur, N., Jha, A., Rosen, B., & Skov, T. (2008). IBM WebSphere QualityStage Methodologies, Standardization, and Matching. IBM Corporation. Ashton, K. (2009). RFID Journal. Obtenido de That 'Internet of Things' Thing: http://www.rfidjournal.com/articles/view?4986 Batini, C., & Scannapieca, M. (2006). Data Quality: Concepts, Methodologies and Techniques. Springer Verlag. Eckerson, W. (2002). Data Quality and the bottom line: Achieving business success through a commitment to high quality data. The Data Warehouse Insttute. IBM Corporation. (2011). IBM InfoSphere QualityStage Version 8 Release 7 User's Guide. Reid, A., & Catterall, M. (2005). Invisible data quality issues in a CRM implementation. Journal of Database Marketing & Customer Strategy Management, 12(4), 305314. Van den Broeck, J., Cunningham, S., Eeckels, R., & Herbst, K. (2005). Data cleaning: Detecting, diagnosing, and editing data abnormalities. PLoS Medicine, 2(10), e267. 14

Potrebbero piacerti anche

- Ciencia de datos: La serie de conocimientos esenciales de MIT PressDa EverandCiencia de datos: La serie de conocimientos esenciales de MIT PressValutazione: 5 su 5 stelle5/5 (1)

- I7725 - 2022B UN 1 AC 2 EL Proceso de DescubrimientoDocumento11 pagineI7725 - 2022B UN 1 AC 2 EL Proceso de DescubrimientoJaasiel Alejandro Castellanos GomezNessuna valutazione finora

- Actividad de Aprendizaje 1Documento5 pagineActividad de Aprendizaje 1Jhair YepesNessuna valutazione finora

- Imputación de Datos Faltantes Mediante Técnica de Agrupamiento K-Means y Cálculo de La Media AritméticaDocumento16 pagineImputación de Datos Faltantes Mediante Técnica de Agrupamiento K-Means y Cálculo de La Media AritméticaJosé D'AgostinoNessuna valutazione finora

- Actividad Sumativa 4 - Yosselin Galindez - Seccion 1Documento13 pagineActividad Sumativa 4 - Yosselin Galindez - Seccion 1Yosselin GalindezNessuna valutazione finora

- Tarea 2Documento6 pagineTarea 2Franco QuintanaNessuna valutazione finora

- GUIA N4 - Sistemas y Tecnologias de InformacionDocumento15 pagineGUIA N4 - Sistemas y Tecnologias de InformacionCarl CNessuna valutazione finora

- Actividad Aplicada ContextualizaciónDocumento11 pagineActividad Aplicada ContextualizaciónJhonatan AndrésNessuna valutazione finora

- Normalizacion de Base de DatosDocumento2 pagineNormalizacion de Base de DatosKEVIN EDUARDO TOJ FARFANNessuna valutazione finora

- Informatica Con La OperacionalDocumento4 pagineInformatica Con La OperacionalhillarypmNessuna valutazione finora

- Captura y AlmacenamientoDocumento27 pagineCaptura y AlmacenamientoDanny Valencia G.Nessuna valutazione finora

- LecturasDocumento6 pagineLecturasQuito Pacheco SalgadoNessuna valutazione finora

- B2 Resumen ClaudiaPamelaAmadorGarcesDocumento5 pagineB2 Resumen ClaudiaPamelaAmadorGarcesPamela GarcesNessuna valutazione finora

- Dato Unidad Mínima de Información, Sin SentidoDocumento5 pagineDato Unidad Mínima de Información, Sin SentidoanniuxiNessuna valutazione finora

- Calidad de Datos. Cómo Impulsar Tu Negocio Con Los DatosDocumento13 pagineCalidad de Datos. Cómo Impulsar Tu Negocio Con Los Datosletras.dl.corazonNessuna valutazione finora

- Analisis de Riesgos.Documento24 pagineAnalisis de Riesgos.Manuel MurilloNessuna valutazione finora

- Capitulo IIDocumento9 pagineCapitulo IIESVIN ADAN MONRROY MARTINEZNessuna valutazione finora

- Big DataDocumento6 pagineBig DataDaniel GuevaraNessuna valutazione finora

- Resume NDocumento6 pagineResume Nalondradelosangeles2323Nessuna valutazione finora

- Luis Miguel Barragan MerchanDocumento5 pagineLuis Miguel Barragan MerchanHUGO ALBERTO ARDILA MOLINANessuna valutazione finora

- Acin217 s1 Encina3Documento10 pagineAcin217 s1 Encina3melissa rivera godoyNessuna valutazione finora

- Calidad de DatosDocumento17 pagineCalidad de DatosProfesora Valeria Ortiz100% (2)

- m1l2 Base de Datos2 m1 CifDocumento27 paginem1l2 Base de Datos2 m1 CifsgfdNessuna valutazione finora

- Calidad de Datos Guía Detallada Sobre Data QualityDocumento8 pagineCalidad de Datos Guía Detallada Sobre Data Qualitywalnutkitten0622Nessuna valutazione finora

- Integridad de Una Base de DatosDocumento9 pagineIntegridad de Una Base de Datosescol1986Nessuna valutazione finora

- Hojas de Respuestas - Miniproyecto 3 ABDocumento3 pagineHojas de Respuestas - Miniproyecto 3 ABAna BignamiNessuna valutazione finora

- Tarea Informatica Aplicada 1Documento5 pagineTarea Informatica Aplicada 1Gloria VargasNessuna valutazione finora

- Calidad de DatosDocumento22 pagineCalidad de DatosCarlos Joaquín Duarte100% (2)

- Actividad de Aprendizaje 1Documento8 pagineActividad de Aprendizaje 1Image ColombiaNessuna valutazione finora

- Tecnologias de La Informacion - Resumen 1ºDocumento54 pagineTecnologias de La Informacion - Resumen 1ºAgustín MurgaNessuna valutazione finora

- Jennifer - Mansilla Control 3Documento7 pagineJennifer - Mansilla Control 3Jennifer MansillaNessuna valutazione finora

- T5 Minería de DatosDocumento12 pagineT5 Minería de DatosGabriela RosasNessuna valutazione finora

- Procesamiento de DatosDocumento7 pagineProcesamiento de Datosyorgeni moronNessuna valutazione finora

- Visión General de Bases de DatosDocumento8 pagineVisión General de Bases de DatosRaulBertolGarciaNessuna valutazione finora

- Módulo 1 - Lectura 2Documento16 pagineMódulo 1 - Lectura 2Nicolas SammarcoNessuna valutazione finora

- Gestion Calidad Infromacion Unidad 3Documento10 pagineGestion Calidad Infromacion Unidad 3Carlos BeltranNessuna valutazione finora

- Reconocer La Importancia Del Concepto de Normalización en Una Base de Datos1.Documento5 pagineReconocer La Importancia Del Concepto de Normalización en Una Base de Datos1.jhonny marinNessuna valutazione finora

- III UnidadDocumento57 pagineIII UnidadSaralouFernandezNessuna valutazione finora

- U2 Sistemas de Informacion Tic Clase3Documento15 pagineU2 Sistemas de Informacion Tic Clase3Daniel ValenciaNessuna valutazione finora

- Ensayo Importancia de Los Datos - AtiDocumento10 pagineEnsayo Importancia de Los Datos - AtiOdalys Rivas100% (1)

- Limpieza de DatosDocumento5 pagineLimpieza de DatosJavier CortesNessuna valutazione finora

- Foro Eje4Documento8 pagineForo Eje4jhissetNessuna valutazione finora

- Modulo 2 Ciencia de DatosDocumento5 pagineModulo 2 Ciencia de Datosstevenespinoza902Nessuna valutazione finora

- Mineria de DatosDocumento5 pagineMineria de Datosandrea.jimenez1946Nessuna valutazione finora

- Ejemplo Tabla Completa 22Documento81 pagineEjemplo Tabla Completa 22pepe pompinNessuna valutazione finora

- Resumen Libro Sistema de Informacion Pag 5 A 31Documento15 pagineResumen Libro Sistema de Informacion Pag 5 A 31Esmerlin AquinoNessuna valutazione finora

- Javier Serrano Control 2Documento5 pagineJavier Serrano Control 2Javier Andres Serrano LeivaNessuna valutazione finora

- Mineria de DatosDocumento11 pagineMineria de DatosNando PinargoNessuna valutazione finora

- Entrega - Final - Fase1 301308 36Documento7 pagineEntrega - Final - Fase1 301308 36fabios325100% (1)

- Teoria Bases de DatosDocumento181 pagineTeoria Bases de DatosNoly ChNessuna valutazione finora

- Valores FaltantesDocumento2 pagineValores FaltantesEmilio Badillo RodríguezNessuna valutazione finora

- Apunte Academico Clase 7Documento9 pagineApunte Academico Clase 7Victor Mascareño AlbornozNessuna valutazione finora

- Ant Tecnologiasdeinformacionenlaempresa B4Documento9 pagineAnt Tecnologiasdeinformacionenlaempresa B4ds0935153Nessuna valutazione finora

- Ensayo Contabilidad DataDocumento10 pagineEnsayo Contabilidad DataOscar ZambranoNessuna valutazione finora

- Acercamiento Al Big DataDocumento6 pagineAcercamiento Al Big DataNini Johanna Ocampo GNessuna valutazione finora

- Cid 2019B Inni T2 2a Lvis.Documento5 pagineCid 2019B Inni T2 2a Lvis.pepenarNessuna valutazione finora

- Base de Datos Multidimensional Investigacion Diego ReconcoDocumento5 pagineBase de Datos Multidimensional Investigacion Diego ReconcoDiego ReconcoNessuna valutazione finora

- Tarea 1 (Ensayo Ciencia de Datos)Documento9 pagineTarea 1 (Ensayo Ciencia de Datos)Kevin Joel Zambrano LucasNessuna valutazione finora

- Qué Es Big DataDocumento7 pagineQué Es Big Datayami feansNessuna valutazione finora

- Tarea 2.1Documento5 pagineTarea 2.1Hoy Con MemyNessuna valutazione finora

- EVALUACIÓN DE ESTADISTICA POR CONTINGENCIA (Autoguardado)Documento2 pagineEVALUACIÓN DE ESTADISTICA POR CONTINGENCIA (Autoguardado)Antonio BernalNessuna valutazione finora

- Figuras GeometricasDocumento18 pagineFiguras GeometricascarmitavillaanNessuna valutazione finora

- Ejercicio #16Documento6 pagineEjercicio #16frank_luna_43Nessuna valutazione finora

- Cromo VI ReporteDocumento3 pagineCromo VI ReporteDanna PalominoNessuna valutazione finora

- Relaciones de Maxwell y DiagramasDocumento8 pagineRelaciones de Maxwell y DiagramasHeriibertooNessuna valutazione finora

- FACTORIZACIÓNDocumento4 pagineFACTORIZACIÓNRoxana RyfNessuna valutazione finora

- Interes CompuestoDocumento40 pagineInteres CompuestoDaniela Benavente100% (3)

- Manual GoDocumento96 pagineManual GoJulio RangelNessuna valutazione finora

- Quinta Practica CalificadaDocumento70 pagineQuinta Practica CalificadaRuben GarciaNessuna valutazione finora

- Razón (Matemáticas) - Wikipedia, La Enciclopedia LibreDocumento5 pagineRazón (Matemáticas) - Wikipedia, La Enciclopedia Libretimhan gracia y verdad100% (1)

- Tarea 3 Calculo Diferencial - Estudiante 1Documento8 pagineTarea 3 Calculo Diferencial - Estudiante 1ELVIA MELONessuna valutazione finora

- VoleibolDocumento5 pagineVoleibolRosaura HernandezNessuna valutazione finora

- Combinaciones de CargaDocumento2 pagineCombinaciones de CargaJessi NarvaezNessuna valutazione finora

- Modulo. Administracion IiDocumento131 pagineModulo. Administracion IiMaria Lucia RiosNessuna valutazione finora

- TFG Ignacio Erik Kleinman RuizDocumento75 pagineTFG Ignacio Erik Kleinman RuizIsaias M. GonzálezNessuna valutazione finora

- Ensayo de Placa Con Carga EstaticaDocumento9 pagineEnsayo de Placa Con Carga EstaticaGrebelAndrésAmarantoMercadoNessuna valutazione finora

- Taller Estadistica Descriptiva Medidas de DispersionDocumento6 pagineTaller Estadistica Descriptiva Medidas de DispersionDuvan BastidasNessuna valutazione finora

- Guía 3 Electivo IV Medio Derivadas y Sus GráficasDocumento2 pagineGuía 3 Electivo IV Medio Derivadas y Sus GráficasMARCELA GUERRANessuna valutazione finora

- Taxonomía de Bloom de Números Fraccionarios-1Documento3 pagineTaxonomía de Bloom de Números Fraccionarios-1Oskr Krvajal100% (1)

- Programación Lineal (Segundo)Documento45 pagineProgramación Lineal (Segundo)ANTONY EUGENIO DONIS ALVAREZNessuna valutazione finora

- ANALISIS ESTRUCTURAL II Discretización de ElementosDocumento8 pagineANALISIS ESTRUCTURAL II Discretización de ElementosAlexandra QvNessuna valutazione finora

- Variables ProposicionalesDocumento2 pagineVariables ProposicionalesMarcia CNessuna valutazione finora

- Constant - El Principio de La DesorientacionDocumento1 paginaConstant - El Principio de La DesorientacionpatodptNessuna valutazione finora

- MA420 Plantilla - Desarrollo RC - EU3 2023BDocumento4 pagineMA420 Plantilla - Desarrollo RC - EU3 2023BHeidy CarhuanchoNessuna valutazione finora

- Rectificación A Reflujo TotalDocumento25 pagineRectificación A Reflujo TotalSandra PatriciaNessuna valutazione finora

- Clase 02 - Cartaboneo de Pasos, AlineamientosDocumento26 pagineClase 02 - Cartaboneo de Pasos, AlineamientosYherson Arnol Perez SalazarNessuna valutazione finora

- Guía 1 Suma FraccionesDocumento4 pagineGuía 1 Suma FraccionesGalvlov OjnajNessuna valutazione finora

- Detectores Con HisteresisDocumento9 pagineDetectores Con Histeresisjose pcNessuna valutazione finora

- Sesion #2 Discriminante en Ecuaciones de Segundo Grado PDFDocumento2 pagineSesion #2 Discriminante en Ecuaciones de Segundo Grado PDFAndres CsLzNessuna valutazione finora

- 11111111111Documento18 pagine11111111111Kriz MolinaNessuna valutazione finora