Documenti di Didattica

Documenti di Professioni

Documenti di Cultura

7264 41562 1 PB

Caricato da

Wagner RodriguesTitolo originale

Copyright

Formati disponibili

Condividi questo documento

Condividi o incorpora il documento

Hai trovato utile questo documento?

Questo contenuto è inappropriato?

Segnala questo documentoCopyright:

Formati disponibili

7264 41562 1 PB

Caricato da

Wagner RodriguesCopyright:

Formati disponibili

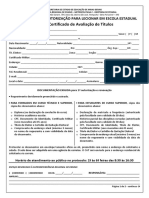

1

DESENVOLVIMENTO DE MTODOS PARA REDUO DE DIMENSIONALIDADE DO ESPAO DE CARACTERSTICAS PARA RECONHECIMENTO DE PADRES MARCOS FUZARO JNIOR1, DENISE GULIATO2

RESUMO Nas ltimas duas dcadas as imagens mdicas tm sido fundamentais para deteco, diagnstico e tratamento dos mais diversos tipos de patologias. A tarefa de reconhecimento de padres requer a converso de padres presentes nas imagens em caractersticas que descrevem as regies de interesse de forma concisa. No entanto, em aplicaes mdicas, o nmero de caractersticas pode se tornar muito grande, sendo que muitas delas podem no ser essenciais para a soluo do problema. Sendo assim, a reduo de dimensionalidade tem papel importante no desempenho de mtodos de classificao. Este trabalho apresenta dois mtodos de reduo do espao de caractersticas, um baseado em seleo de caractersticas (Rough Sets) e outro baseado em transformao de caractersticas (PCA). PALAVRAS CHAVE: reduo de caractersticas, seleo de caractersticas, transformao de caractersticas. ABSTRACT In the last two decades, medical imaging have been an important tool in detection, diagnosis and treatment of several types of pathologies. The task of pattern recognition requires the conversion of patterns in characteristics that describe images in a concise manner. However, in medical applications, the number of features can become very large, many of which may not be essential for the solution of the problem. Therefore, dimensionality reduction plays an important role in the performance of classification methods. This paper presents two methods to reduce the space of characteristics, the first based on selection of features using Rough Sets and the second is based on Principal Component Analysis (PCA).

Faculdade de Computao, Universidade Federal de Uberlndia, Avenida Joo Naves de vila 2121, Uberlndia-MG, CEP: 38400-902, marcosjunior@comp.ufu.br 2 Faculdade de Computao, Universidade Federal de Uberlndia, Avenida Joo Naves de vila 2121, Uberlndia-MG, CEP: 38400-902, guliato@ufu.br

KEYWORDS: reduction of features, feature selection, processing characteristics.

1. INTRODUO O crescimento no nmero de modalidades de exames por imagens, e suas aplicaes prticas, tem sido acompanhada por um aumento natural no escopo e na complexidade dos problemas associados aos mtodos de aquisio, requerendo tcnicas computacionais cada vez mais avanadas para sua soluo. O grande potencial no uso de sistemas computacionais aplicados a imagens mdicas est associado ao uso de tcnicas de processamento digital de imagens e de viso computacional para anlise quantitativa e objetiva das imagens, no uso de Sistemas de Gerenciamento de Banco de Dados (SGBD) para armazenar grandes volumes de dados de natureza complexa e para recuperar tais informaes de maneira eficiente, e no desenvolvimento de mtodos de reconhecimento de padres. A tarefa de reconhecimento de padro requer a converso de padres presentes nas imagens em caractersticas que descrevem as regies de interesse de forma concisa. No entanto, em aplicaes mdicas, o nmero de caractersticas pode se tornar muito grande, com caractersticas no relevantes ou redundantes que podem no ser essenciais para a soluo do problema. Sendo assim, a reduo de dimensionalidade tem papel importante no desempenho de mtodos de classificao, pois influencia diretamente no custo e na preciso do classificador. Neste trabalho so apresentados dois mtodos de reduo da dimensionalidade do espao de caractersticas [1]: um baseado em seleo de caractersticas utilizando Rough Sets [2], [3], [4] e outro baseado em transformao de caractersticas usando anlise das componentes principais (PCA) [7], [8]. O trabalho est estruturado da seguinte forma: a Seo 2 apresenta o mtodo baseado em seleo de caractersticas (Rough Sets); a Seo 3 apresenta o mtodo baseado em transformao de caractersticas (PCA); a Seo 4 apresenta materiais e mtodos; a Seo 5 apresenta uma comparao entre os dois mtodos e a Seo 6 apresenta a concluso do trabalho.

2. CONCEITOS BSICOS SOBRE A TEORIA DOS ROUGH SETS A tcnica de reduo de dimensionalidade do espao de caractersticas baseada em seleo de caractersticas um processo que consiste em obter um subconjunto de caractersticas a partir de um conjunto de caractersticas originais baseado em determinado critrio, de maneira que o subconjunto expresse as propriedades do conjunto original. A teoria dos Rough Sets, introduzida por Zdzisaw Pawlak em 1982, um mtodo baseado em seleo de caractersticas que permite eliminar caractersticas irrelevantes pela formao de redutos, que so subconjuntos que mantm as propriedades da representao do conjunto original. Neste trabalho, sero apresentados conceitos e definies seguidos de exemplos para facilitar o entendimento. As subsees 2.1, 2.2, 2.3 e 2.4 mostram conceitos e definies utilizados na teoria dos Rough Sets. A subseo 2.5 apresenta os passos necessrios para obter os redutos.

2.1 Sistema de Informao Os dados so representados por um sistema de informao composto por um conjunto de objetos e um conjunto de atributos. Todos os objetos possuem os mesmos atributos, diferindo somente em seus valores nominais. Portanto, esse sistema de informao pode ser definido como A = (U, C), sendo U o conjunto de objetos e C o conjunto de atributos. A Tabela 1 [3] representa um exemplo de um sistema de informao, em que os dados so referentes a crianas e algumas caractersticas de brinquedos. Tabela 1- Sistema de Informao [3] U Criana 1 2 3 4 5 6 7 8 9 10

Cor Azul Vermelho Amarelo Azul Amarelo Verde Amarelo Amarelo Verde Verde

Atributos Condicionais Tamanho Tato Textura Grande Duro Indefinido Mdio Moderado Liso Pequeno Macio spero Mdio Moderado spero Pequeno Macio Indefinido Grande Duro Liso Pequeno Duro Indefinido Pequeno Duro Indefinido Grande Duro Liso Mdio Moderado Liso

Material Plstico Madeira Pelcia Plstico Plstico Madeira Metal Plstico Madeira Plstico

Uma outra maneira de representar os dados em um sistema de informao incluir um atributo de deciso que informa a deciso a ser tomada. Pode ser representado por R = (U, C U D), onde D o atributo de deciso. A Tabela 2 representa um exemplo de um sistema de informao com um atributo de deciso, em que esse atributo referente ao comportamento das crianas. Tabela 2 Sistema de informao munido de atributo de deciso [3] U Criana 1 2 3 4 5 6 7 8 9 10 Cor Azul Vermelho Amarelo Azul Amarelo Verde Amarelo Amarelo Verde Verde Atributo de Deciso Tamanho Tato Textura Material Atitude Grande Duro Indefinido Plstico Negativa Mdio Moderado Liso Madeira Neutra Pequeno Macio spero Pelcia Positiva Mdio Moderado spero Plstico Negativa Pequeno Macio Indefinido Plstico Neutra Grande Duro Liso Madeira Positiva Pequeno Duro Indefinido Metal Positiva Pequeno Duro Indefinido Plstico Positiva Grande Duro Liso Madeira Neutra Mdio Moderado Liso Plstico Neutra Atributos Condicionais

Para o sistema de informao ilustrado pela tabela 2, temos: conjunto de objetos: U = {1, 2, 3, 4, 5, 6, 7, 8, 9, 10} conjunto de atributos condicionais: C = {Cor, Tamanho, Tato, Textura, Material} atributo de deciso: D = {Atitude} classes: X1 = {Negativa} X2 = {Neutra} X3 = {Positiva}

2.2 Indiscernibilidade Considerando o sistema de informao R, para todo subconjunto de atributos como: ,

uma relao de equivalncia, chamada relao de indiscernibilidade (IND), pode ser definida

INDR

(1)

Os objetos x e y so indiscernveis entre si, ou seja, todos os valores de seus atributos so iguais com respeito ao subconjunto B. O conjunto de todas as classes de equivalncia determinadas por INDR(B) representado por U/ INDR(B). Para a base de dados da Tabela 2, temos como exemplos: INDR({Tamanho, Tato, Textura}) = {6, 9} U/ INDR({Tamanho, Tato}) = {{1, 6, 9}, {2, 4, 10}, {3, 5}, {7, 8}}

2.3 Aproximao de Conjuntos Analisando a Tabela 2, pode-se dizer que qualquer criana com as caractersticas iguais as das crianas 1 e 4 tero atitude Negativa, assim como crianas com caractersticas iguais as crianas 2, 5 ou 10 tero atitude Neutra e qualquer criana com caractersticas iguais as das crianas 3, 7 ou 8 tero atitude Positiva. A respeito das crianas 6 e 9, nada se pode afirmar, pois possuem os mesmos atributos condicionais e atributos de deciso diferentes. Seja o sistema de informao A = (U, C), e , onde X o conjunto de

elementos de uma classe. Defini-se Aproximao Superior (Upper) de Xi em relao a B, denotado por , como:

e Aproximao Inferior (Lower) de X em relao a B, denotado por

, como:

Utilizando o conjunto de atributos B, os objetos pertencentes a Aproximao Superior de Xi so classificados como possveis membros de Xi, e os objetos da Aproximao Inferior de Xi so objetos que com certeza pertencem a Xi. A partir disso, obtm-se uma Regio de Fronteira RF(Xi), denotada por:

e ainda define-se Fora da Regio de Xi o conjunto

U-

, que consiste de objetos que

no pertencem a Xi, considerando o mesmo conjunto B. A Figura 1 [2] ilustra esses conceitos.

Grnulos de Conhecimento

Universo de objetos

Conjunto

Aproximao Superior

Aproximao Inferior

Figura 1 Aproximao de conjuntos [2] Um conjunto Xi definido como rough (impreciso) se sua Regio de Fronteira diferente do conjunto vazio, e definido como crisp (preciso) se sua Regio de Fronteira for vazia. Vamos tomar um exemplo para ilustrar os conceitos acima descritos [3]. Seja B = {Cor, Tamanho, Tato, Textura, Material}, U/ INDA (B) = {{1}, {2}, {3}, {4}, {5}, {6, 9}, {7}, {8}, {10}} e X1 = {3, 6, 7, 8}, X1 o conjunto formado por crianas que possuem atitude Positiva. Tem-se os seguintes conjuntos, ilustrados na Figura 2: Aproximao Superior: Aproximao Inferior: = {{3}, {6, 9}, {7}, {8}} = {{3}, {7}, {8}}

Regio de Fronteira: RF(X1) = {{6, 9}} Fora da Regio U = {{1}, {2}, {4}, {5}, {10}}

Figura 2 Representao em conjuntos (exemplo) [3]

Fora da Regio Regio de Fronteira Aproximao Inferior Aproximao Superior

2.4 Qualidade das Aproximaes As qualidades das aproximaes definidas anteriormente podem ser caracterizadas por valores numricos. Seja B(X) o coeficiente para medir essas qualidades, sendo X o conjunto de objetos com respeito a B. Esse coeficiente pode ser calculado de trs maneiras: a) Coeficiente de Impreciso B(X), que dado pelo quociente entre a cardinalidade das aproximaes Inferior e Superior. Denota-se por:

Se B(X) = 1, X preciso em relao ao conjunto de atributos B, e se B(X) < 1, X impreciso em relao ao conjunto de atributos B. b) Coeficiente da Qualidade da Aproximao Superior , que pode ser

interpretado como a porcentagem de objetos que possivelmente pertencem a X, dado por:

Sendo |U| a cardinalidade do conjunto de objetos do Sistema de Informao e U { }. c) Coeficiente da Qualidade da Aproximao Inferior , que pode ser interpretado

como a porcentagem de objetos que com certeza pertencem a X, dado por:

Como exemplo vamos tomar X1 = {3, 6, 7, 8}, tem-se:

, ou seja, 60% de X1 preciso em relao a B.

possivelmente pertence a X1.

ou

seja,

50%

de

pertence a X1.

, ou seja, 30% de U certamente

2.5 Reduo do Sistema de Informao Um sistema de informao no deve possuir caractersticas irrelevantes, pois isso aumenta a complexidade computacional da extrao de regras para classificao. Por isso, quando possvel, deve-se reduzir o sistema de informao. Na teoria dos Rough Sets, essa reduo realizada pela funo de discernibilidade a partir da matriz de discernibilidade.

2.5.1

Matriz de Discernibilidade A Matriz de Discernibilidade de um sistema de informao A, denotada por MD(B),

uma matriz simtrica n x n com: mD(i, j) = {b B | b(Cl(i)) b(Cl(j))}

para i, j = 1, 2, 3,..., n, sendo 1 i, j n n = |U/ INDA(B)| e Cl(n) a classe de equivalncia n Considere o sistema de informao A da Tabela 1 e seja B = {Cor, Tamanho, Tato, Textura, Material}. Tem-se U/ INDA (B) = {{1}, {2}, {3}, {4}, {5}, {6, 9}, {7}, {8}, {10}}. Portanto, cada elemento dessa matriz o conjunto de atributos condicionais de B que diferenciam as classes de equivalncia. Considerando Cor = Co, Tamanho = Ta, Tato = To, Textura = Te e Material = Ma, tem-se na Tabela 3 sua representao. Tabela 3 Matriz de Discernibilidade [3]

2.5.2

Funo de Discernibilidade A Funo de discernibilidade FA(B) determina o nmero mnimo de atributos para

diferenciar qualquer classe de equivalncia das demais. obtida da seguinte maneira: para os atributos contidos dentro de cada clula da matriz de discernibilidade, aplica-se o operador or ou \/, e entre as clulas dessa matriz, aplica-se o operador and ou /\, o que resulta

10

em uma expresso booleana. Em seguida, aplicando teoremas e propriedades da lgebra booleana, simplifica-se a expresso. Vamos ilustrar esse processo atravs de um exemplo. A FA(B) da Tabela 3 dada por:

Simplificando essa expresso, tem-se:

que pode ser escrita na forma:

2.5.3

Reduto Reduto um conjunto de atributos mnimos que mantm as propriedades de um

sistema de informao. Um reduto de B sobre um sistema de informao A um conjunto de atributos B*, , sendo todos os atributos c (B - B*) dispensveis. Com isso, U/

INDA(B) = U/ INDA(B*). Considerando B = {Cor, Tamanho, Tato, Textura, Material} e a funo de discernibilidade obtida anteriormente, o conjunto de redutos dessa funo : REDA(B) = {{Cor, Tato, Material}, {Tamanho, Tato, Textura, Material}}

11

O sistema de informao original, ilustrado na Tabela 1, pode ser representado por um dos redutos. Utilizando o reduto B* = {Cor, Tato, Material}, temos a reduo do sistema de informao, indicado na tabela 4, pois ao invs de termos a tabela original com 5 atributos temos uma representao equivalente com 3 atributos. Tabela 4 Reduo do sistema de informao [3] U Criana 1 2 3 4 5 6 7 8 9 10 Atributos Condicionais Cor Tato Material Azul Duro Plstico Vermelho Moderado Madeira Amarelo Macio Pelcia Azul Moderado Plstico Amarelo Macio Plstico Verde Duro Madeira Amarelo Duro Metal Amarelo Duro Plstico Verde Duro Madeira Verde Moderado Plstico

3. PRINCIPAL COMPONENT ANALYSIS (PCA) O mtodo baseado em transformao de caractersticas (PCA) [7], [8], descrito pela primeira vez por Karl Pearson em 1901, um processo que representa em uma nova projeo para os dados, reduzindo a dimensionalidade do espao. A partir de caractersticas originais, que esto correlacionadas, obtm-se um novo conjunto de caractersticas descorrelacionadas. Antes de descrever o mtodo PCA so expostos conceitos matemticos que so utilizados em seus passos. Esse conhecimento apriori fundamental para um bom entendimento do PCA. A subseo 3.1 apresenta os conceitos matemticos. Na subseo 3.2 so apresentados os passos realizados pelo PCA para a reduo de dimensionalidade.

3.1 Conceitos Matemticos O objetivo ao citar esses conceitos no fornecer um entendimento completo do mecanismo matemtico de cada tcnica, mas dizer o motivo da tcnica ser utilizada e quais os resultados gerados e sua influncia nos dados.

12

3.1.1

D Desvio Pad dro O desvio pa adro a mdia m das distncias d en ntre cada po onto e a m dia central l. uma

medida estatstica que q indica a disperso dos dados, calculado pela p seguinte e frmula:

onde: Xi = va alor i da amo ostra n = nm mero de valores da amo ostra = mdia m dos va alores

3.1.2

V Varincia uma outra a medida de e disperso obtida pelo quadrado do d desvio pa adro:

3.1.3

C Covarinci ia A medidas As s citadas ant teriormente e, varincia e desvio pa adro, so u utilizadas qu uando os

dados possuem p 1 dimenso. d A se tratar de Ao d mais dim menses, a medida m que deve ser ut tilizada a covarincia, pois s ela fornec ce o compo ortamento de d uma dimenso em r relao a ou utra. Por o, em situa aes de 3 dimenses (x, y, z) ), pode-se medir a co ovarincia entre as exemplo dimens es x e y, as a dimense es x e z, e as dimens es y e z. Assim, A a co ovarincia sempre s calculad da entre dua as dimense es. A frmula da d covarincia simila ar a da vari ncia:

A calcular Ao r a covarin ncia, o mais s importante e no exat tamente seu u valor, e si im o seu sinal (p positiva ou u negativa). Se a cov varincia positiva, indica i que ambas dim menses aumenta am juntas. Se S a covari ncia nega ativa, indica a que enqua anto uma di imenso aum menta, a

13

outra diminui. E se a covarincia vale zero, ento as dimenses no esto relacionadas entre si. Propriedades da covarincia: (i) (ii) 3.1.4 cov(x,y) = cov(y,x) cov(x,x) = var(x). Matriz de Covarincia Ao se tratar de n dimenses, uma maneira til de obter todos os valores de covarincia entre todas as diferentes dimenses calcul-los e coloc-los em uma matriz. A definio para matriz de covarincia para um conjunto de dados de n dimenses :

Cn x n = (ci j | ci j = cov(Dimi, Dimj))

onde: Cn x n a matriz com n linhas e n colunas, e Dimx a x-sima dimenso. Como exemplo, temos uma matriz de covarincia para um conjunto de dados de 3 dimenses (x, y e z). Ento, a matriz possui 3 linhas e 3 colunas, e seus valores so:

3.1.5

Autovetores Autovetores so vetores que sob a ao de um operador linear resultam num vetor de

mesma direo, ou seja, representam uma direo que preservada por uma transformao linear. Os autovetores so encontrados somente em matrizes quadradas, e se uma matriz n x n tem autovetores, ento ela tem n autovetores. Por exemplo, uma matriz 4 x 4 tem 4 autovetores. Uma propriedade que deve ser destacada que todos os autovetores de uma matriz so perpendiculares entre si.

Figura 3 Exemplo de um autovetor [7]

14

Na Figura 3 o vetor (3 2) um autovetor, pois o resultado da multiplicao um vetor mltiplo de (3 2), que possui a mesma direo.

3.1.6

Autovalores Autovalores e autovetores esto associados entre si e sempre aparecem em pares. Na

Figura 3, o 4 o autovalor associado ao autovetor (3 2).

3.2 Principal Component Analysis (PCA) O mtodo PCA permite encontrar padres em uma base de dados, principalmente quando os dados possuem grandes dimenses e no possvel represent-los graficamente. Depois de encontrados esses padres, possvel reduzir o nmero de dimenses sem perder muita informao. So encontrados autovetores e autovalores que norteiam o comportamento dos dados. A partir disso so selecionadas as componentes principais, que so os autovetores associados aos maiores autovalores. Os passos que descrevem o mtodo vo ser descritos e ilustrados com exemplos, facilitando o entendimento.

3.2.1

Passo 1: Obter os dados Para descrever o processo realizado pelo PCA ser utilizado uma base de dados

bidimensional (x, y), representada na Figura 4 [7]. x y classe 1 2 1 1 1 1 1 2 2 2

2.5 2.4 0.5 0.7 2.2 2.9 1.9 2.2 3.1 3.0 2.3 2.7 2.0 1.6 1.0 1.1 1.5 1.6 1.1 0.9

Figura 4 Dados originais [7]

15

3.2.2

Passo 2: Subtrair a mdia Depois de obter a base de dados necessrio ajust-la subtraindo a mdia respectiva a

cada dimenso. No exemplo, deve-se obter a mdia da dimenso x e subtra-la de todos os valores dessa dimenso, e fazer o mesmo para a dimenso y. O resultado ir produzir uma nova base cuja mdia vale zero. A Figura 5 ilustra os dados ajustados. x 0.69 -1.31 0.39 0.09 1.29 0.49 0.19 -0.81 -0.31 -0.71 y 0.49 -1.21 0.99 0.29 1.09 0.79 -0.31 -0.81 -0.31 -1.01 classe 1 2 1 1 1 1 1 2 2 2

Figura 5 Dados com a mdia subtrada [7]

3.2.3

Passo 3: Calcular a matriz de covarincia Tem-se uma base bidimensional, ento a matriz de covarincia ser 2 x 2. Seguindo os

conceitos citados sobre matriz de covarincia, tem-se o resultado abaixo:

Note que como os valores que no fazem parte da diagonal principal so positivos, indicando que ambas dimenses crescem juntas.

3.2.4

Passo 4: Calcular os autovetores e autovalores Essa etapa muito importante, pois ir fornecer detalhes sobre o comportamento dos

dados. Calculando os autovetores e autovalores, segundo os conceitos apresentados, tem-se:

16

Observando a Figura 6, tem-se que as dimenses crescem juntas, como foi mencionado anteriormente. Os autovetores esto representados pelas diagonais pontilhadas, e so perpendiculares entre si. Veja como os autovetores passam pelos pontos mostrando como os dados esto relacionados entre si. Tomando como base o autovetor 1 e a projeo dos pontos neste vetor, vemos que os dados transformados tem uma boa representao. Utilizando o autovetor 2, ao projetar os dados sobre esse autovetor ir ocorrer sobreposio dos dados, causando problemas na representao. Portanto, o mtodo de anlise de componentes principais depende fortemente da distribuio dos dados.

Figura 6 Grfico de dados normalizados (mdia subtrada), e com os autovetores [7]

17

3.2.5

Passo 5: Escolher as componentes e formar o vetor de caractersticas nessa etapa que emerge o conceito de componentes principais. O autovetor

associado ao maior autovalor a componente principal mais relevante. Quanto maior o autovalor associado, maior a importncia do autovetor (componente). Assim, a reduo de dimensionalidade ocorre ao retirar as componentes menos significantes. No exemplo, o autovetor mais importante o que passa no meio dos pontos.

Ao escolher as componentes, deve-se construir o vetor de caractersticas (FeatureVector), que um vetor de vetores. FeatureVector = (av1 av2 av3 ...... avn) onde avi o autovetor i No nosso exemplo, o vetor de caractersticas fica da seguinte maneira: FeatureVector =

3.2.6

Formando o novo conjunto de dados O novo conjunto de dados dado multiplicando a transposta do vetor de

caractersticas pela transposta dos dados ajustados (com a mdia subtrada). FinalData = FeatureVectorT x DataAdjustT No exemplo, a base original tem duas dimenses. Escolhendo um autovetor, o de maior autovalor, obtemos um novo conjunto de dados com 1 dimenso.

18

x -0.827970186 1.77758033 -0.992197494 -0.274210416 -1.67580142 -0.912949103 0.0991094375 1.14457216 0.438046137 1.22382056

classe 1 2 1 1 1 1 1 2 2 2

4. MATERIAIS E MTODOS Atravs do software RSES (Rough Set Exploration System) [9], utilizando o mtodo de seleo de caractersticas (rough sets) [2], [3], [4], e o software R-Project [10], utilizando o mtodo de transformao de caractersticas denominado PCA [7], [8], foram utilizados para executar testes nas seguintes bases de dados pblicas: Iris database com 4 caractersticas, Wine database com 13 caractersticas, Wisconsin Diagnostic Breast Cancer database com 10 caractersticas, Wisconsin Diagnostic Breast Cancer database com 30 caractersticas e Wisconsin Prognostic Breast Cancer com 9 caractersticas. Em seguida, as bases de dados pr-processadas foram submetidas ao Classificador JADE baseado em regras fuzzy desenvolvido no nosso laboratrio [5], [6] e aos classificadores: BayesNet, Decision Table, J48, LibSVM e Multilayer Perceptron, disponveis no ambiente Weka [11]. Ao final, foram montadas tabelas que permitem avaliar, de maneira clara, a eficincia entre os mtodos.

5. DISCUSSO DE RESULTADOS Fazendo uma anlise nos resultados obtidos nos testes, o mtodo baseado em seleo de caractersticas utilizando rough sets [2], [3], [4] apresentou reduo de dimensionalidade do espao de caractersticas em algumas bases de dados utilizadas. A Wine database com 13

19

caractersticas foi reduzida para 7 caractersticas e a Wisconsin Diagnostic Breast Cancer database de 30 caractersticas foi reduzida para 16 caractersticas. As demais bases no sofreram reduo de dimensionalidade. O mtodo baseado em transformao de caractersticas (PCA) [7], [8] foi aplicado a todas as bases, gerando novas caractersticas. Foram escolhidas metade das componentes principais, as mais relevantes, para a realizao dos testes. Em seguida, as bases de dados pr-processadas foram submetidas aos seguintes classificadores: Classificador JADE baseado [5], [6], BayesNet, Decision Table, J48, LibSVM e Multilayer Perceptron. Os resultados obtidos se encontram nas tabelas abaixo. Tabela 5 Iris database

IRIS JADE BayesNet Decision Table J48 LibSVM Multilayer Perceptron base original (4 caract) base PCA (2 comp) base Redutos (4 caract) 100% 100% 100% 92,66% 90,66% 92,66% 92,66% 91,36% 92,66% 96,03% 94,16% 96,03% 96,03% 91,56% 96,03% 97,33% 96,80% 97,33%

Tabela 6 Wine database

WINE JADE BayesNet Decision Table J48 LibSVM Multilayer Perceptron base original (13 caract) base PCA (7 comp) base Redutos (7 caract) 99,04% 89,82% 76,16% 98,76% 91,00% 93,50% 92,90% 86,06% 87,80% 94,33% 86,60% 89,73% 97,76% 94,60% 97,60% 97,03% 95,36% 96,00%

Tabela 7 - Wisconsin Prognostic Breast Cancer Database

WPBC JADE BayesNet Decision Table J48 LibSVM Multilayer Perceptron base original (9 caract) base PCA (5 comp) base Redutos (9 caract) 93,09% 95,90% 93,09% 96,30% 95,85% 96,30% 92,65% 95,80% 92,65% 93,85% 96,25% 93,85% 96,05% 96,40% 96,05% 95,80% 95,80% 95,80%

20

Tabela 8 - Wisconsin Diagnostic Breast Cancer Database

WDBC JADE BayesNet Decision Table J48 LibSVM Multilayer Perceptron base original (10 caract) base PCA (5 comp) base Redutos (10 caract) 97,45% 19,43% 97,45% 92,40% 91,80% 92,40% 93,15% 90,65% 93,15% 92,65% 88,90% 92,65% 93,80% 91,90% 93,80% 93,70% 94,25% 93,70%

Tabela 9 - Wisconsin Diagnostic Breast Cancer Database

WDBC JADE BayesNet Decision Table J48 LibSVM Multilayer Perceptron base original (30 caract) base PCA (15 comp) base Redutos (16 caract) 93,94% 92,11% 92,99% 94,20% 90,80% 92,30% 94,20% 93,25% 95,65% 92,95% 93,35% 94,55% 96,25% 88,95% 96,45% 96,65% 95,40% 95,45%

Analisando nas tabelas os dados obtidos, vemos que o mtodo baseado em seleo de caractersticas utilizado, rough sets [2], [3], [4], apresentou uma melhoria nos resultados de alguns classificadores (Tabela 9). Por outro lado, nem sempre reduz a dimensionalidade do espao de caractersticas. O mtodo de reduo de caractersticas baseado em PCA [7], [8], tambm apresentou melhoria no resultado de alguns classificadores (Tabela 7, Tabela 8 e Tabela 9), mas os resultados so fortemente dependentes da distribuio dos dados.

6. CONCLUSO Este documento apresentou o projeto intitulado Desenvolvimento de Mtodos para Reduo de Dimensionalidade do Espao de Caractersticas para Reconhecimento de Padres. Depois de um estudo geral sobre os mtodos para reduo de dimensionalidade do espao de caractersticas [1], foram feitos estudos especficos sobre o uso do PCA [7], [8] e o uso do Rough Sets [2], [3], [4]. Aps estes estudos, utilizando o mtodo baseado em seleo de caractersticas (Rough Sets) e o mtodo baseado em transformao de caractersticas (PCA), foram feitos testes em bases de dados pblicas. Verificou-se que o mtodo baseado em Rough Sets nem sempre apresenta reduo de dimensionalidade, e que o mtodo de transformao de caractersticas (PCA) depende da distribuio dos dados.

21

Os estudos realizados at o momento no so conclusivos com relao a indicar qual mtodo melhor indicado para cada base de dados.

7. AGRADECIMENTOS Agradecemos FAPEMIG (Fundao de Amparo Pesquisa do Estado de Minas Gerais) e a PROPP-UFU (Pr-Reitoria de Pesquisa e Ps-Graduao da Universidade Federal de Uberlndia) pelo apoio financeiro.

8. REFERNCIAS BIBLIOGRFICAS [1] L.J.P. VAN DER MAATEN. Dimensionality Reduction: A Comparative Review. Maastricht University, February 2008. [2] PAWLAK, Z.; SKOWRON, A.. Rudiments of rough sets. Institute of Mathematics, Warsaw University, 177: 327, 2007. [3] MARA, C.; CORREIA, C. S.. Rough Sets Tcnica de Reduo de Atributos e Gerao de Regras para Classificao de Dados. Campo Grande, 2005. [4] SHEN, Q.; JENSEN, R. Rough Sets, Their Extensions and Applications. Department of Computer Science, The University of Wales, Aberystwyth, Ceredigion SY23 3DB, UK, July 2007. [5] GULIATO, D.; SANTOS, J. C. S.. Granular Computing and Rough Sets to Generate Fuzzy Rules. Lecture Notes in Computer Science (LNCS), v. 5627, p. 317-326, July 2009. [6] SANTOS, J. C. S.; GULIATO, D.. Proposta de um mtodo para gerao automtica de regras fuzzy baseada na teoria dos rough sets. In: Latin American Informatics Conference, September 2009, Pelotas - RS. [7] LINDSAY I SMITH. A tutorial on Principal Components Analysis. February 2002.

22

[8] CHRISTOPHER J.C. B. Geometric Methods for Feature Extraction and Dimensional Reduction. Redmond, November 2004. [9] Rough Set Exploration System (RSES). Disponvel: http://alfa.mimuw.edu.pl/~rses/: Acesso em: 08/06/2009. [10] R-project. Disponvel: http://www.r-project.org/: Acesso em: 07/10/2009. [11] Weka. Disponvel: http://www.cs.waikato.ac.nz/ml/weka/: Acesso em: 05/11/2009.

Potrebbero piacerti anche

- Ebook Lean Digital Transformation - Versão DigitalDocumento62 pagineEbook Lean Digital Transformation - Versão DigitalFlaviano LeiteNessuna valutazione finora

- Treinamento de PaisDocumento7 pagineTreinamento de PaisEleandra GaitkoskiNessuna valutazione finora

- RogersDocumento34 pagineRogersLarissa Moreira100% (2)

- Escola Como Cruzamento de Culturas 2Documento8 pagineEscola Como Cruzamento de Culturas 2Kath SouzaNessuna valutazione finora

- Cotação FiguraHumanaInfDocumento2 pagineCotação FiguraHumanaInfÁureaCanas100% (3)

- Algumas Considerações Sobre o Pagamento Simbólico No Atendimento Psicanalítico de Crianças para Françoise DoltoDocumento9 pagineAlgumas Considerações Sobre o Pagamento Simbólico No Atendimento Psicanalítico de Crianças para Françoise DoltoHarrison RivelloNessuna valutazione finora

- Antonio Augusto - Por Que Os Físicos Acreditam Que As Coisas Existem?Documento28 pagineAntonio Augusto - Por Que Os Físicos Acreditam Que As Coisas Existem?Natan Oliveira0% (1)

- Avaliacao DesempenhoDocumento37 pagineAvaliacao DesempenhoSandra ReginaNessuna valutazione finora

- Antropologia Da AlimentaçãoDocumento27 pagineAntropologia Da AlimentaçãoSandro SilvaNessuna valutazione finora

- A Escrita Academica Do Excessivo Ao Razoavel PDFDocumento19 pagineA Escrita Academica Do Excessivo Ao Razoavel PDFYuri De Nóbrega SalesNessuna valutazione finora

- Como Fazer Referências BibliográficasDocumento2 pagineComo Fazer Referências Bibliográficasmccorreia0% (1)

- DarwinismoDocumento26 pagineDarwinismoMarcelo HenklainNessuna valutazione finora

- Requerimento CAT 2017Documento2 pagineRequerimento CAT 2017Michel Breno Jose Da Silva SilvaNessuna valutazione finora

- Comunicação e Mídia Interfaces Com A Cidadania e Com A CulturaDocumento213 pagineComunicação e Mídia Interfaces Com A Cidadania e Com A CulturaEvaldo Gonçalves0% (1)

- Cunha 2000Documento20 pagineCunha 2000flagonsNessuna valutazione finora

- Estante Da VidaDocumento32 pagineEstante Da VidavaldfoNessuna valutazione finora

- Ensino de Cienciasv PDFDocumento337 pagineEnsino de Cienciasv PDFCelso MattosNessuna valutazione finora

- Umberto Eco - Da "Obra Aberta" para "Os Limites Da InterpretaçãoDocumento17 pagineUmberto Eco - Da "Obra Aberta" para "Os Limites Da Interpretaçãodudu françaNessuna valutazione finora

- Conclusão Entrevista PCC IIDocumento2 pagineConclusão Entrevista PCC IItalittaNessuna valutazione finora

- Posições Sexuais SÓ "PAPAI E MAMÃE" E DE LUZ APAGADA - Portal Da Teologia PDFDocumento10 paginePosições Sexuais SÓ "PAPAI E MAMÃE" E DE LUZ APAGADA - Portal Da Teologia PDFInstituto Teológico GamalielNessuna valutazione finora

- A Memória e A Existência Colateral Pierceana - AndreDocumento6 pagineA Memória e A Existência Colateral Pierceana - AndreAndré SilvaNessuna valutazione finora

- Projeto Integrado Multidisciplinar: Ambiente EstratégicoDocumento24 pagineProjeto Integrado Multidisciplinar: Ambiente EstratégicoKatia Grillo100% (1)

- A Transferência de Freud A LacanDocumento6 pagineA Transferência de Freud A LacanRafaela Coelho100% (1)

- Saindo Da "Massa" - Considerações Sobre Provas Do Cespe - Fernando MesquitaDocumento51 pagineSaindo Da "Massa" - Considerações Sobre Provas Do Cespe - Fernando MesquitabordonalNessuna valutazione finora

- O Menino, A Toupeira, A Raposa e o CavaloDocumento1 paginaO Menino, A Toupeira, A Raposa e o CavaloluizhgqNessuna valutazione finora

- Desafios para A Docência No Ensino Superior Na ContemporaneidadeDocumento17 pagineDesafios para A Docência No Ensino Superior Na ContemporaneidadeGisele AbrahimNessuna valutazione finora

- Manifesto Das Regras de NegócioDocumento38 pagineManifesto Das Regras de NegócioAnderson Mota DematteNessuna valutazione finora

- Edital de Seleção GETA 2018.2 PDFDocumento3 pagineEdital de Seleção GETA 2018.2 PDFFafa de belemNessuna valutazione finora

- Resumo Do Livro SuperdicasDocumento3 pagineResumo Do Livro SuperdicasJacky Imamura SantosNessuna valutazione finora

- Sobre Discurso e Tipos de Discursos Marque A Única AlternativaDocumento4 pagineSobre Discurso e Tipos de Discursos Marque A Única AlternativaBarros Amélia50% (2)